-

K-临近算法

3.1 sklearn转换器和估计器

转换器 估计器(estimator)

3.1.1 转换器 —— 特征工程的父类

1 实例化(实例化的是一个转换器(Transformer))

2 调用fit-transform(对于文档建立分类词频矩阵,不能同时调用)

标准化:

(x - mean)/ std

fit_transform()

fit() 计算 每一列的平均值、标准差

transform() (x-mean)/ std 进行最终的转换

3.1.2 估计器(sklearn机器学习算法实现)

估计器(estimator)

1 实例化一个estimator

2 estimator,fit(x_train,y_train)计算

—— 调用完毕 模型生成

3 模型评估

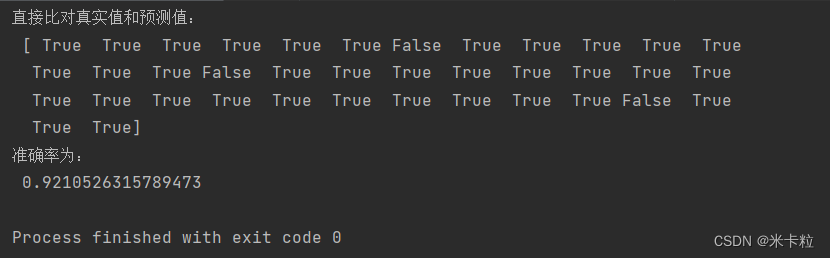

1)直接比对真实值和预测值

y_predict = estimator.predict(x_test)

y_test == y_predict

2)计算准确率

accuracy = estimator.score(x_test,y_test)

什么是K-近邻算法,核心思想:你的临近来推断你的类别

如何确定近邻:距离公式

曼哈顿距离 绝对值距离

明可夫斯基距离

如果k值取的不一样,有什么样的影响

k 值过小 容易受到异常点影响

k 值过大 样本不均衡的影响

使用k-近邻算法需要进行无量纲化处理和标准化处理

优点:简单,易于理解,易于实现,无需训练

缺点:必须指定k值,k值选择不恰当则分类精度不能保证

懒惰算法,对测试样本分类时的计算量大,内存开销大

- from sklearn.datasets import load_iris

- from sklearn.model_selection import train_test_split

- from sklearn.preprocessing import StandardScaler

- from sklearn.neighbors import KNeighborsClassifier

- def knn_iris():

- """

- 用KNN算法对鸢尾花进行分类

- :return:

- """

- # 1)获取数据

- iris = load_iris()

- # 2)划分数据集

- x_train, x_test, y_train, y_test = train_test_split(iris.data, iris.target, random_state=6)

- # 3)特征工程 标准化

- transfer = StandardScaler()

- x_train = transfer.fit_transform(x_train)

- x_test = transfer.transform(x_test)

- # 4)KNN算法预估器 n_neighbors=3就是值k值

- estimator = KNeighborsClassifier(n_neighbors=3)

- estimator.fit(x_train, y_train)

- # 5)模型评估

- # 方法1 直接比对真实值和预测值

- y_predict = estimator.predict(x_test)

- print("y_predict:\n", y_predict)

- print("直接比对真实值和预测值:\n", y_test == y_predict)

- # 方法2 计算准确率

- score = estimator.score(x_test, y_test)

- print("准确率为:\n", score)

- return None

- if __name__ == "__main__":

- # 代码1 用KNN算法对鸢尾花进行分类

- knn_iris()

模型选择与调优

- sklearn.model_selection.GridSearchCV(estimator,param_grid=None,cv=None)

- 对估计器的指定参数值进行详尽搜索

- estimator:估计器对象

- param-grid:估计器参数(dict){"n_neighbors":[1,3,5]}

- cv:指定几折交叉验证

- fit():输入训练数据

- score():准确率

- 结果分析:

- 最佳参数:best_params

- 最佳结果:best_score

- 最佳估计器: best_estimator

- 交叉验证结果:cv_results

- def knn_iris_gscv():

- """

- 用knn算法对鸢尾花进行分类,添加网络搜索和交叉验证

- :return:

- """

- # 1)获取数据

- iris = load_iris()

- # 2)划分数据集

- x_train, x_test, y_train, y_test = train_test_split(iris.data, iris.target, random_state=6)

- # 3)特征工程 标准化

- transfer = StandardScaler()

- x_train = transfer.fit_transform(x_train)

- x_test = transfer.transform(x_test)

- # 4)KNN算法预估器

- estimator = KNeighborsClassifier()

- # 加入网络搜索和交叉验证

- # 参数准备

- param_dict = {"n_neighbors": [3, 5, 7, 9]}

- estimator = GridSearchCV(estimator, param_grid=param_dict, cv=10)

- estimator.fit(x_train, y_train)

- # 5)模型评估

- # 方法1 直接比对真实值和预测值

- y_predict = estimator.predict(x_test)

- print("y_predict:\n", y_predict)

- print("直接比对真实值和预测值:\n", y_test == y_predict)

- # 方法2 计算准确率

- score = estimator.score(x_test, y_test)

- print("准确率为:\n", score)

- # 最佳参数:best_params_

- print("最佳参数\n", estimator.best_params_)

- # 最佳结果:best_score_

- print("最佳结果\n", estimator.best_estimator_)

- # 最佳估计器: best_estimator_

- print("最佳估计器\n", estimator.best_estimator_)

- # 交叉验证结果:cv_results_

- print("交叉验证结果\n", estimator.cv_results_)

- return None

-

相关阅读:

攻破《数组与指针》相关笔试题(二)

强化学习算法成功控制核聚变装置;元宇宙里的AI玩出新花样

第18章 用于大型程序的工具【C++】

首个保险“远程双录”管理办法出台!菊风持续推进金融业布局双录智能化升级

【iOS】知乎日报第三周总结

如何快速走出网站沙盒期(关于优化百度SEO提升排名)

一幅长文细学GaussDB(一)——一幅长文系列

VS2010 Windows API 串口编程 (二)

QT textedit宽度自适应内容

人大加拿大女王大学金融硕士项目——不一定有逆风翻盘,但一定要向阳而生

- 原文地址:https://blog.csdn.net/m0_62329504/article/details/126240196