-

深度神经网络

4. 深度神经网络

4.1 深度学习简介

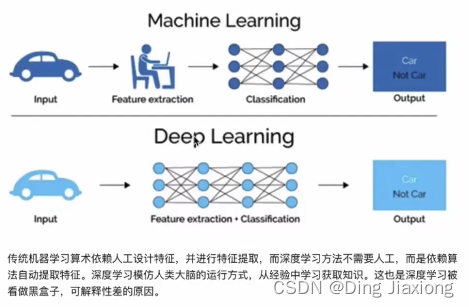

4.1.1 深度学习与机器学习的主要区别

4.2 常用的神经网络

-

卷积神经网络 CNN

-

循环神经网络 RNN

-

生成对抗网络 GAN

-

深度强化学习等

4.3 神经网络

4.3.1 人工神经网络 ANN

- 简称神经网络NN

- 一种模仿生物神经网络结构和功能的计算模型

神经网络中信息只向一个方向移动,从输入节点向前移动,通过隐藏节点,向输出节点移动

- 网络中没有循环、环

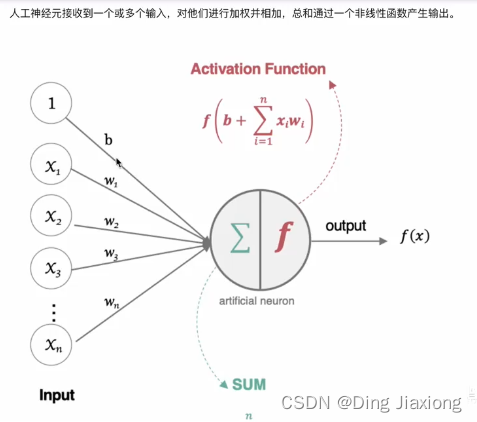

4.3.2 基本构件

- 输入层

- 输出层

- 隐藏层

4.3.3 特点

-

同一层的神经元之间没有连接

-

第N层的每个神经元和第N-1层的所有神经元相连 → full connected

- 第N-1层神经元的输出就是第N层神经元的输入

-

每个连接都有一个权值

4.3.4 工作原理

4.4 激活函数

本质是向神经网络中引入非线性因素,通过激活函数,神经网络可以拟合各种曲线。

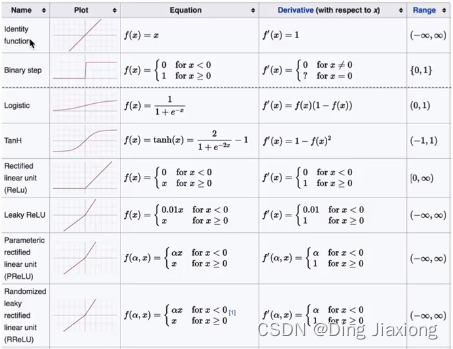

4.4.1 常用的激活函数

-

Sigmoid/logistics函数

-

-

sigmoid函数一般只用于二分类的输出层

-

-

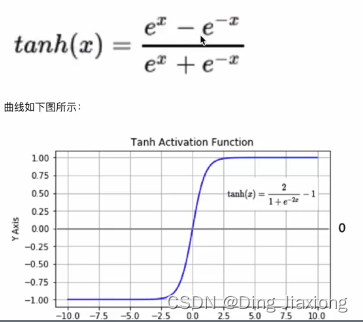

tanh 双曲正切曲线

-

-

隐藏层使用

-

-

RELU

-

-

目前最常用

-

-

LeakReLu

- 对RELU的改进

-

softmax

-

-

“映射为概率值”

-

用于多分类,目的是将分类的结果以概率的形式展现出来

-

-

其他激活函数

-

4.4.2 如何选择激活函数

-

隐藏层

-

优先选择RELU激活函数

- 注意神经元死亡问题

-

如果RELU效果不好,尝试其他

-

不使用sigmoid

-

-

输出层

- 二分类 → sigmoid

- 多分类 → softmax

- 回归问题 → identity

4.5 参数初始化

4.5.1 权重W

-

随机初始化

- 随机初始化从均值为0,标准差是1的高斯分布中取样,使用一些很小的值对参数W进行初始化。

-

标准初始化

- 从区间均匀随机取值

-

Xavier初始化

-

基本思想:各层的激活值和梯度的方差在传播过程中保持一致

-

tf.keras实现方法

- 正态化Xavier初始化

- 标准化Xavier初始化

-

-

He初始化

-

Kaiming初始化

-

基本思想:正向传播时,激活值的方差保持不变; 反向传播时,关于状态值的梯度的方差保持不变

-

tf.keras实现方法

- 正态化He初始化

- 标准化He初始化

-

4.5.2 偏置b

- 直接初始化为0

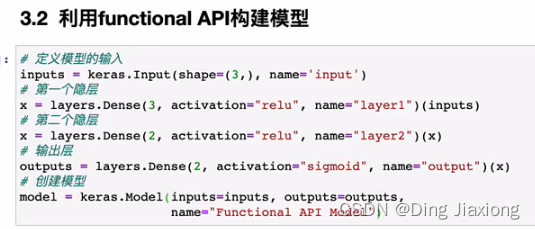

4.6 神经网络的搭建

4.6.1 tf.keras

-

利用Sequential构建

- 按一定的顺序对层进行堆叠

-

利用function API构建

-

Model类构建

- 可构建复杂的网络模型

- 通过model的子类进行构建

4.7 神经网络的优缺点

4.7.1 优点

- 精度高、性能优于其他的机器学习方法,甚至在某些领域超过人类

- 可以近似任意的非线性函数

- 有大量的框架和库可供调用

4.7.2 缺点

- 黑箱,很难解释模型是怎么工作的

- 训练时间长,需要大量的计算力

- 网络结构复杂,需要调整超参数

- 小数据集上表现不佳,容易发生过拟合

-

相关阅读:

rpm安装gitlab

力扣108 补9.17

Java18知多少

【Redis】链表和字典

游戏设计模式专栏(十):在Cocos游戏开发中运用外观模式

springboot 拦截器 导致fastjson 大小写失效

Swift 5.9 有哪些新特性(二)

环境部署搭建

Ubuntu 环境下安装 Docker

Git使用教程

- 原文地址:https://blog.csdn.net/weixin_44226181/article/details/126189056