-

猿创征文|机器学习实战(9)——降维

目录

数据降维会丢失一些信息(好比压缩图像带来的效果一样),所以,它虽然能够加速训练,但是也会轻微降低系统性能。

我们简要说一下降维的两种主要方法:投影和流形学习。投影:高维空间的所有训练实例实际上受一个低得多的低维子空间所影响,将训练实例投影到该子空间就是投影。但许多情况下,子空间可能是弯曲的或转动的,就引入了流形学习。流形假设(流形假说)认为大多数现实世界的高维度数据集存在一个低维度的流形来重新表示。我们可以把瑞士卷看做一个二维流形的例子。更概括的说,d维流形就是n维空间的一部分(d

主成分分析(PCA)是迄今最流行的降维算法。它能识别出最接近数据的超平面,然后将数据投影该平面。同时该超平面也保留了数据最大差异性。

常规模块的导入以及图像可视化的设置:

- # Common imports

- import numpy as np

- import os

- # to make this notebook's output stable across runs

- np.random.seed(42)

- # To plot pretty figures

- %matplotlib inline

- import matplotlib as mpl

- import matplotlib.pyplot as plt

- mpl.rc('axes', labelsize=14)

- mpl.rc('xtick', labelsize=12)

- mpl.rc('ytick', labelsize=12)

1 主成分

主成分分析(PCA)可以在训练集中识别出哪条轴(一维超平面)对差异性的贡献度最高。即下图中由实线表示的轴。同时它也找出了第二条轴,它对剩余差异性的贡献度最高,与第一条轴垂直。

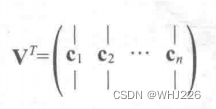

选择投影的子空间 定义第i条轴的单位向量就叫作第i个主成分。上图中,第一个主成分是c1,第二个主成分是c2。前两个主成分是平面里正交的箭头所示,第三个主成分则垂直于平面。

那么我们该怎么找到训练集的主成分呢?我们有一种标准矩阵分解技术,叫作奇异值分解(SVD)。它可以将训练集矩阵X分解成三个矩阵的点积

,其中

,其中  正包含我们想要的所有主成分,公式如下:

正包含我们想要的所有主成分,公式如下:

主成分矩阵 下面的代码使用NumPy的svd()函数来获取训练集中所有主成分,并提取前两个:

- #3D数据集

- np.random.seed(4)

- m = 60

- w1, w2 = 0.1, 0.3

- noise = 0.1

- angles = np.random.rand(m) * 3 * np.pi / 2 - 0.5

- X = np.empty((m, 3))

- X[:, 0] = np.cos(angles) + np.sin(angles)/2 + noise * np.random.randn(m) / 2

- X[:, 1] = np.sin(angles) * 0.7 + noise * np.random.randn(m) / 2

- X[:, 2] = X[:, 0] * w1 + X[:, 1] * w2 + noise * np.random.randn(m)

- #获取主成分

- X_centered = X - X.mean(axis=0)

- U, s, Vt = np.linalg.svd(X_centered)

- c1 = Vt.T

-

相关阅读:

一文快速回顾 Servlet、Filter、Listener

通过redis在控制台模拟手机验证码功能(java)

亚马逊测评关于IP和DNS的问题

百度智能云千帆大模型平台 2.0 产品技术解析

S0003-Mac下iTerm2+zsh+ohmyzsh打造优雅美观终端

100V-240V输入5V/2A输出恒压恒流隔离控制芯片AH1010

Spark基础【KV类型转换算子】

队列:循环队列和双端队列/受限双端队列

rabbitMQ 消息顺序性、消息幂等性、消息不丢失、最终一致性、补偿机制、消息队列设计

python文件操作、文件操作、读写文件、写模式

- 原文地址:https://blog.csdn.net/WHJ226/article/details/126651882