-

风格迁移篇---重用鉴别器进行编码:朝向无监督的图像到图像转换

Abstract

无监督图像到图像的翻译是计算机视觉的中心任务。一旦训练过程完成,现有的翻译框架将放弃鉴别器。本文通过重用鉴别器对目标域的图像进行编码,提出了鉴别器的一种新作用。所提出的架构称为NICEGAN,与以前的方法相比,它展示了两种优势模式:第一,由于不需要独立的编码组件,因此更紧凑;其次,这种插入式编码器直接由敌方损失进行训练,如果应用多尺度鉴别器,它的信息量更大,训练更有效。NICEGAN中的主要问题是沿编码器的平移与辨别的耦合,当我们通过GAN玩最小-最大博弈时,这可能导致训练不一致。为了解决这个问题,我们开发了一种解耦训练策略,通过该策略,编码器仅在最大化对手损失的情况下进行训练,否则将保持冻结状态。在四个流行基准上进行的大量实验表明,NICE-GAN在FID、KID和人类偏好方面的性能优于最先进的方法。还进行了全面的消融研究,以隔离每个拟议组件的有效性。我们的代码可在https://github.com/alpc91/NICE-GAN-pytorch.上获得。

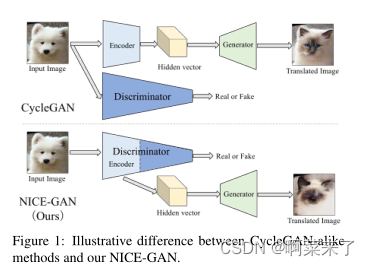

【图1:CycleGAN-like方法和我们的NICE-GAN方法之间的说明性差异。】

1. Introduction

图像到图像的转换将图像从一个域转换到另一个域促进了视觉任务中的各种应用,从彩色化[39]、图像编辑[6]、超分辨率[20]到视频生成[35]。考虑到在do之间收集成对图像的大量工作∗通讯作者:孙富春。在域中,一条更实用的研究路线[40、25、12、21、16]将目标指向无监督场景,其中没有成对信息的特征。由于无监督翻译中的不可识别性问题[25],已经提出了各种方法,通过使用额外的规则来解决这个问题,包括权重耦合[25]、循环阻力[40、17、38],迫使生成器使用识别函数[34],或者更常见的是,将它们结合起来。

当我们回顾当前成功的翻译框架(如CycleGAN[40]提出的框架)时,大多数框架由每个域的三个组件组成:将输入图像嵌入低维隐藏空间的编码器、将隐藏向量翻译为其他域图像的生成器,以及使用GAN训练进行域对齐的鉴别器[9]。虽然这种堆积如山的方式是标准的,但我们仍然有兴趣问:是否有可能重新思考当前翻译框架中每个组件的作用?更重要的是,我们能否在重新思考的基础上改变当前的表述(例如,更紧凑的体系结构)?

如果我们检查编码器和鉴别器之间的关系,答案是肯定的。基本上,鉴别器用于区分源域的翻译图像和目标域的真实图像。为此,鉴别器应该先对输入图像进行某种语义编码,然后才能判断哪些图像是真的,哪些是假的。换言之,这与鉴别器的两个角色相冲突:编码和分类。事实上,DCGAN论文[30]揭示了鉴别器的编码能力:在鉴别器中最后一个卷积层的前6个学习卷积特征中观察到对输入图像的强烈响应。

基于上述动机,本文提出重用鉴别器进行编码。特别是,我们将鉴别器中某些数量的早期层重用为目标域的编码器,如图1所示。这种重用具有双重优势:即实现了更紧凑的体系结构。由于编码器现在成为鉴别器的一部分,我们不再需要独立的组件进行编码。此外,与现有方法不同,现有方法在训练后放弃了鉴别器,其编码部分在我们的框架中仍然保留用于推理。二、编码器被更有效地训练。编码器的传统训练是通过从生成器反向传播梯度来进行的,这是间接的。这里,通过将其插入鉴别器,编码器直接通过鉴别损失进行训练。此外,现代鉴别器已经求助于多尺度方案以获得更大的表达能力[8、13、7、36];如果应用多尺度鉴别器,我们的编码器将自然继承表达能力。

我们方法的一个剩余问题是如何进行对手训练。对于传统方法[40、25、12、21、16],编码器与生成器一起训练以最小化GAN损耗,而鉴别器单独训练以最大化目标。在我们的框架中,编码器和鉴别器重叠,如果我们应用传统的训练设置,则会带来不稳定性-作为翻译的一部分的编码器被训练为最小化,同时它属于鉴别器,也被训练为最大化。为了消除不一致性,我们开发了一种解耦的训练范式。具体而言,编码器的训练仅与鉴别器相关,与生成器无关。我们在几个基准测试上的实验表明,这种简单的解耦显著促进了训练(详见第4.7节)。背后的另一个直觉是,将编码器与翻译训练分离将使其朝着更通用的编码目的而非翻译方向发展,从而实现更大的通用性。

我们将我们的贡献总结如下

据我们所知,我们是第一个重用鉴别器进行编码的公司,专门用于无监督的图像到图像翻译。通过这种重用,可以得到一种更紧凑、更有效的体系结构,称为无独立组件编码GAN(NICE-GAN)。

鉴于鉴别器的重用将导致典型训练过程的不稳定性,本文开发了一种简单有效的解耦训练范式

对几个流行基准的广泛实验评估表明,所提出的方法优于各种最先进的方法。还进行了全面的消融研究,以验证每个拟议组件的有效性。

2. Related Work

图像到图像的翻译。Isola等人[14]提出的基于条件GAN的标准框架促进了图像到图像翻译的研究。有几项工作将其扩展到处理超分辨率[36]或视频生成[35]。尽管取得了令人鼓舞的结果,但所有这些方法都需要成对数据进行训练,这限制了它们的实际使用。

无监督图像到图像的翻译。在使用未配对训练数据的无监督图像到图像翻译方面,CycleGAN[40]、DiscoGAN[17]、DualGAN[38]通过使用循环一致性损失来保留输入和翻译图像之间的关键属性。已经提出了各种关于扩展CycleGAN的研究。第一种开发是实现多模式生成:MUNIT[12]和DRIT[21]将图像的潜在空间分解为域不变的内容空间和域特定的风格空间,以获得不同的输出。CycleGAN的另一个增强是同时跨多个(两个以上)域执行翻译,如StarGAN[5]。更具功能性的研究重点是差异较大的域之间的转换。例如,使用域共享潜在空间的CoupledGAN[26]、UNIT[25]、ComboGAN[2]和XGAN[31]以及U-GAT-IT[16]求助于注意力模块进行特征选择。最近,TransGAGA[37]和TravelGAN[1]分别提出使用几何的笛卡尔积和保持向量算法来表征潜在表示。

内省网络。内省神经网络(INN)[15、19、23]和内省对抗网络(IAN)[4、33]已经对鉴别器的双重作用进行了探索。虽然INN确实具有重用鉴别器生成的相同目的,但与我们的NICE-GAN相比,它表现出几个显著的差异。首先,INN和NICE-GAN处理不同的任务。INN用于纯生成,鉴别器用于从隐藏向量生成图像(作为解码);我们的NICE-GAN用于翻译,discrim8169 inator用于将图像嵌入到隐藏向量(作为编码)。此外,即使在进行推理时,INN也需要顺序训练,而NICE-GAN只需要一次前向传递就可以生成新图像,从而提高效率。关于伊恩,它也是纯生成的,并重用一个鉴别器生成自假样本,这是一种内省机制;我们的NICE-GAN重用一个域的鉴别器来生成另一个域中的假样本,这确实是一种相互反省的机制。

【图2:NICE-GAN的流程图说明。这里我们只显示一个从X到Y(从狗到猫)的翻译流。请注意,我们采用了一种解耦训练方式:编码器Ey在最小化对抗损失、重建损失和周期损失时是固定的,在最大化对抗损失时进行训练。】3. Our NICE-GAN

本节介绍了我们方法的详细公式。我们首先介绍总体思路,然后通过提供NICE-GAN中每个组件的详细信息来跟进。还规定了解耦训练机制。

3.1. General Formulation

这是一个定义问题。设X,Y是两个图像域。虽然监督图像到图像的转换需要学习条件映射fx→y=p(y|X)和fy→x=p(x|Y)给定联合分布p(x,Y),无监督翻译→y和fy→仅提供边缘p(x)和p(Y)。无监督翻译是病态的,因为有无穷多个条件概率对应于相同的边缘分布。为了解决这个问题,当前的方法求助于添加额外的规则,如权重耦合[26,25,21]、循环一致性[40,17,38]和身份映射[34,40],本文采用了后两种方法。

在大多数现有框架中,翻译是fx→y(分别为财政年度)→x) 由编码器Ex(resp.Ey)和发生器Gx组成→y(分别为Gy→x) 。通过将它们组合在一起,得到y′=fx→y(x)=Gx→y(Ex(x))(分别为x′=fy→x(y)=Gy→x(Ey(y)))。通常采用GAN[9]训练方式,以使转换后的输出符合目标域的分布。即,我们使用鉴别器Dy(resp.Dx)在真实图像y和翻译图像y′(resp.x和x′)之间进行分类。

没有用于编码的独立组件(NICE)。如引言中所述,我们的NICE-GAN重用鉴别器进行编码,为训练提供了效率和有效性的优势。形式上,我们将鉴别器Dy分为编码部分EDy和分类部分Cy。编码部分EDy将替换fy中的原始编码器→x、 从而产生新的翻译fy→x(y)=Gy→x(EDy(y))。类似地,对于鉴别器Dx,我们定义了EDx和Cx,并将转换函数重新表示为fx→y(x)=Gx→y(EDx(x))。对于分类成分Cx和Cy,我们进一步采用多尺度结构来提高表达能力。此外,新制定的编码器EDx和EDy存在于平移和辨别的训练循环中,使其难以训练。因此,我们在NICE-GAN中提出了一种解耦的训练流程图。第3.2节和第3.3节分别介绍了体系结构构建和培训的细节。图2说明了我们的框架。除非另有说明,为了简单起见,我们将从EDx和EDy中删除上标D。

3.2. Architecture

多尺度鉴别器Dx和Dy。由于Dy的公式相似,我们在此仅讨论Dx。补充材料(SP)中提供了全部细节。我们使用多尺度鉴别器的灵感来自以前的工作[8、13、7、36]。在这些方法中,对不同大小的图像应用不同尺度的鉴别器(通过下采样从原始图像获得小尺寸图像)。在本文中,我们考虑了一种更有效的方法,将单个输入的不同层中的特征映射视为不同尺度的图像,然后将每个特征映射以相应的输入大小提供给分类器进行识别,这类似于特征金字塔表示在目标检测中的应用(例如,SSD[27]和FPN[24])。

我们现在以正式的方式介绍我们的想法。如上所述,鉴别器Dx包含两部分:编码器Ex和分类器Cx。为了实现多尺度处理,分类器Cx进一步分为三个子分类器:C0x用于局部尺度(10 x 10感受野),C1x用于中等尺度(70 x 70感受野),C2x用于全局尺度(286 x 286感受野)。C0x直接连接到Ex的输出。然后,在Ex上进行下采样卷积层,以提供较小比例的特征图,这些特征图连接到两个分支:一个链接到C1x,另一个通过卷积层进一步下采样,然后是C2x。对于单个输入图像,C0x、C1x和C2x都经过训练以预测图像是真是假。图2中还显示了多尺度鉴别器。

除了多尺度设计之外,我们还开发了一种剩余注意机制,以进一步促进鉴别器中的特征传播。在鉴别器中使用注意最初是由U-GA T-IT[16]提出的。假设编码器包含数量为K的特征映射(即Ex={Ekx}Kk=1)。U-GA T-IT的思想是首先学习注意向量w,其中的每个元素计算每个特征图的重要性。然后,利用由a(x)=w×Ex(x)={wk×Ekx(x)}Kk=1计算的参与特征进行后续分类。在U-GAT-IT之后,本文进一步考虑了剩余连接,即,我们使用a(x)=γ×w×Ex(x)+Ex(x),其中可训练参数γ决定了参与特征和原始特征之间的权衡。当γ=0时,返回到Ex(x),表示未使用注意,否则,将激活注意。通过这种修改,我们的方法在调整不同特征图的重要性方面变得更灵活,从而在训练中获得更有效的效果,这将通过我们的实验得到澄清。

生成器Gx→y和Gy→x、 Gx和Gx→y和Gy→x由六个残差块[10]和两个用于上采样的亚像素卷积层[32]组成。并且,我们使用类似于论文[16]的AdaLIN light版本。此外,还进行了用于鉴别器和循环一致性损失的频谱归一化[29],以防止发电机模式崩溃。详细信息见SP。

3.3. Decoupled Training

训练过程按照三种损失进行:对抗性损失、身份重建损失和周期一致性损失。如前所述,对抗性损失是为了进行域转移,而重建损失和循环一致性损失都是为了解决不可识别性问题。

由于编码器Ex不仅是鉴别器Dx的一部分,而且还作为发生器Gx的输入→y、 如果我们采用传统的对抗性训练,就会产生不一致性。为了克服这一缺陷,我们将Ex的训练与生成器Gx的训练解耦→y、 每项损失的计算详情如下。

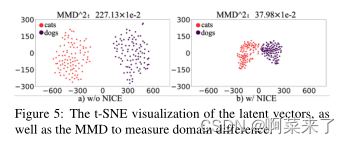

对抗性的损失。首先,我们利用[28]中的最小二乘对抗损失,以获得更稳定的训练和更高的生成质量。最小-最大游戏由以下人员进行:

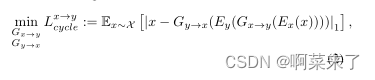

其中,Ex是固定的,Ey是在最大化Lx时训练的→当最小化Lx时,它们都是固定的→这是一个一致性丧失的循环。CycleGAN[40]和DiscoGAN[17]首先引入了循环一致性损失,这将迫使发电机彼此反转。

其中|·1计算ℓ1标准,并且Ex和Ey也被冻结。重建损失。强迫发电机接近单位函数是CycleGAN[40]中的另一项关键调节技术。与CycleGAN不同,Cyclegen的身份丢失基于域相似性假设,我们的重建基于共享潜在空间假设。重建损失是当源域的真实样本的隐藏向量被提供作为源域生成器的输入时,将平移正则化为接近单位映射。即

其中Ex仍然保持不变。

类似地,我们可以定义从域Y到X:Ly的损失→xgan,Ly→x循环和Ly循环→X侦察机。

【图3:生成输出的示例。自上而下:狗↔猫,冬天↔夏天,照片↔万戈和斑马↔马】这是一个完整的目标。鉴别器的最终目标是:

而发电机的最终损耗目标是:

λ1、λ2和λ3是权衡权重(在整个实验中,它们固定为λ1=1、λ2=10和λ3=10)。

再次注意,编码器Ex和Ey在鉴别器的目标下进行训练,但与生成器的训练解耦。我们的实验将分析所提出的解耦训练范式的益处。

4. Experiments

4.1. Baselines

我们将NICE-GAN的性能与包括CycleGAN[40]、UNIT[25]、MUNIT[12]、DRIT[21]和U-GA T-IT[16]在内的最先进方法进行了比较,考虑到它们在无监督图像到图像翻译方面的竞争性能。所有比较方法均采用公共规范进行。特别是对于U-GAT-IT,由于我们GPU机器的内存限制,我们使用它的轻版本。SP中介绍了所有基线的详细信息。

【表1:不同算法的FID和KID×100。越低越好。所有方法都训练到第100K次迭代。NICE-GAN*是发电机网络仅由四个剩余块组成的版本。 】

【表2:网络模块的参数和触发器总数。NICE-GAN*是发电机网络仅由四个剩余块组成的版本。】

4.2. Dataset

实验是在四个流行的未配对图像基准上进行的:马↔斑马,夏天↔温特约塞米蒂,万戈↔照片和猫↔狗前三个数据集用于CycleGAN,其列车测试分段分别为:1067/120(马)、1334/140(斑马);1231/309(夏季),962/238(冬季);400/400(vangogh),6287/751(照片)。最后一个数据集在DRIT[21][22]中进行了研究,其训练测试分割为:771/100(cat),1264/100(dog)。对所有数据集的所有图像进行裁剪,并将其大小调整为256×256,以进行训练和测试。

4.3.评价指标

这是人类的偏好。为了比较不同方法产生的翻译输出的准确性,我们进行了人类感知研究。与Wang等人[36]类似,志愿者被展示了一幅输入图像和来自不同方法的三个翻译输出,并在无限时间内选择哪个翻译输出看起来更好。

Heusel等人(2017)[11]提出的Fréchet初始距离(FID)将生成样本的统计数据与真实样本进行对比。FID将高斯分布拟合到每个比较图像集的InceptionNet的隐藏激活,然后计算这些高斯分布之间的Fréchet距离(也称为Wasserstein-2距离)。FID越低越好,对应于生成的图像更接近真实图像。

开发的核起始距离(KID)是一种类似于FID的度量,但使用多项式核的起始表示之间的平方最大均值差异(MMD),k(x,y)=?1 dxTy+1?其中d是表示维度。它也可以被视为核K(x,y)=K(θ(x),θ(y))的直接输入图像上的MMD,其中θ是将图像映射到初始表示的函数。与FID不同,KID有一个简单的无偏估计器,使其更可靠,尤其是当初始特征通道比图像编号多得多时。KID越低表示真实图像和生成图像之间的视觉相似性越高。我们的KID实现基于https://github。com/mbinkowski/MMD-GAN,其中隐藏的表示来自Inception-v3 pool3层。

4.4. Setup

我们在生成器中使用ReLU作为动作函数,在鉴别器中使用斜率为0.2的泄漏ReLU。我们使用Adam[18]优化器在NVIDIA RTX 2080Ti GPU上训练所有模型,学习率为0.0001,(β1,β2)=(0.5,0.999)。为了增加数据,我们以0.5的概率水平翻转图像,将其大小调整为286×286,并将其随机剪切为256×256。所有实验的批量大小都设置为1。我们还以0.0001的速率使用权重衰减。所有模型都经过100K次迭代训练。SP中提供了有关培训过程和网络架构的更多详细信息

4.5. Comparisons with state of the arts

表1显示,我们的方法在除zebra外的所有情况下通常达到最低的FID或KID分数→horse,这表明我们的NICE框架在各种任务上具有很好的翻译能力。这两个指标在相对分数上保持了良好的一致性,这充分证明了我们的NICE-GAN无论使用何种测量方法都表现良好。相比之下,其他方法仅在某些数据集上表现良好;例如,U-GA TIT light、UNIT和MUNIT成功地转换了对象的语义(如动物脸),而CycleGAN擅长修改低级特征(如颜色和纹理)。U-GA T-IT-light与NICEGAN大致共享相同的结构(多尺度鉴别器和生成器),与NICE-GAN的区别主要在于其编码器的独立公式。表2报告了U-GA、T-IT-light和NICEGAN的参数和触发器总数,并指出,通过重用鉴别器进行编码,我们的架构更加紧凑。为了进一步观察视觉差异,图3描述了测试集上不同方法的翻译图像。NICE-GAN生成的图像几乎比其他图像更有意义,伪影更少(参见cat)↔例如狗任务)。

【表3:消融研究。方法的结果都在鉴别器的100K迭代中。NICE:没有用于编码的独立组件;RA:在CAM注意模块中添加剩余连接;C0x表示局部尺度(10 x 10感受野),C1x表示中间尺度(70 x 70感受野),C2x表示全局尺度(286 x 286感受野);−: 将共享层的数量减少1;+:增加1。】除了我们的方法外,我们还选择了两条基线,在每个数据集中获得最低的儿童分数,以进行人类感知研究。首先,向志愿者展示了一个由源域图像和目标域图像组成的示例对,作为参考,以更好地理解翻译的风格。其次,给它们一个输入图像和三个翻译输出,其中一个来自NICE-GAN,另两个来自选定基线。基于感性现实主义,他们有无限的时间选择哪一个看起来最真实。合成图像以随机顺序显示,以确保公平比较。此外,设置检查点问题并分发给每个志愿者,以验证人类的努力。共收集了123份问卷,其中120份有效。图4显示,除了zebra,NICE-GAN在所有情况下都赢得了多数票→马。

这些结果也与表1中的定量指标一致。SP中包含了更多来自我们模型的结果示例。

4.6.消融研究

我们对猫进行消融研究↔表3中的dog数据集用于分离我们方法的关键组件的有效性:NICE策略、多尺度公式和鉴别器中的剩余注意(RA)机制。我们进行了四组实验。

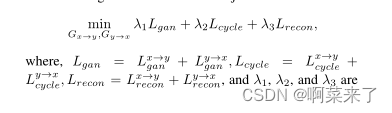

尼斯和拉。第一组继续采用多尺度公式,但去除NICE和RA中的一个或两个,以得出性能差异。结果如表3所示。它验证了NICE和RA中的每一个都有助于性能改进,而NICE的重要性更为显著。总的来说,通过组合所有组件,NICE-GAN显著优于所有其他变体。图5显示了cat上每个域w/和w/o NICE的潜在向量↔通过t-SNE以及MMD来计算域差。有趣的是,通过良好的训练,两个域的潜在分布变得更加聚集和接近,但彼此是可分离的。这种现象解释了为什么我们的NICEGAN表现出色。通过缩短潜在空间中域之间的过渡路径,基于共享潜在空间假设的NICE-GAN可能有助于图像空间中的域转换。

【图5:潜在向量的t-SNE可视化,以及用于测量域差异的MMD。】

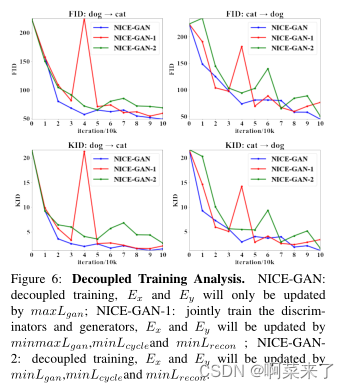

【图6:解耦训练分析。NICE-GAN:解耦训练,Ex和Ey仅由maxLgan更新;NICE-GAN-1:联合训练鉴别器和发生器,Ex和Ey将由minmaxLgan、Minlcyclean和minLrecon更新;NICE-GAN2:解耦训练、Ex和Ey将由minLgan、Minlcyclean和minLrecon更新。】共享层的数量。为了一致比较,我们使用[40]中常用的ResNet主干作为生成器,并自然共享其中的整个编码器。我们还评估了改变鉴别器和编码器共享的层数的效果。表3显示,减少或增加层数通常会阻碍性能。因此,这里的最佳选择是共享整个默认编码器。

多尺度。第三组实验是评估多尺度公式(C0x、C1x、C2x)对鉴别器的影响。结果总结在表3中。我们发现去除C2x将造成严重损害;C0x和C1x的重要性取决于任务,在C0x上添加C1x不会明显增强此任务。实际上,这三种尺度通常都是必要的,多尺度更为稳健,在SP中进行了更多讨论。

重量耦合。此外,还有现有的模型压缩方法,如权重耦合[25,21]。在两个生成器之间共享几层可以实现模型压缩,但会损害转换性能。例如在cat上↔如果共享第一层解码器,FID从48.79/44.67增加到49.67/56.32,如果共享最后一层编码器,则从48.7944.67提高到55.00/55.60。如果我们重用第一层分类器,可以观察到类似的结果,FID从48.79/44.67增加到61.73/46.65。这意味着权重耦合可能会削弱每个域的翻译能力。

4.7. Decoupled Training Analysis

在我们的NICE框架中,我们将Ex的训练与生成器Gx的训练解耦→y、 为了证明这种策略的有效性,我们开发了两种附加的变体:NICE-GAN-1和NICE-氮化镓-2。具体而言,NICE-GAN-1采用传统的训练方法,其中编码器与鉴别器和生成器联合训练。对于NICE-GAN-2,它也以解耦的方式执行,但与我们的方法相反,即编码器与生成器一起训练,独立于鉴别器中的分类器。从更本质的意义上讲,鉴别器确实退化为NICE-GAN-2中的分类器。

图6显示了NICE-GAN、NICE-GAN-1和NICE-氮化镓-2的训练曲线。很明显,NICE-GAN-1的训练是不稳定的,这与我们的分析一致。NICE-GAN-2比NICE-氮化镓-1性能更稳定,但仍低于我们的NICE-GAN。我们推测在NICE-GAN-2中鉴别实际上是对齐隐藏向量的分布。然而,NICE-GAN利用编码器和分类器进行识别,其基础是匹配图像空间的分布,从而捕获更精确的信息。

对不同组件的责任进行清晰的划分,使NICE-GAN变得简单有效。此外,它还支持[4]的观点,即通过差别训练网络学习的特征往往比通过最大似然训练的编码器网络学习的更具表达性,因此更适合于推理。

5. Conclusion

在本文中,我们提出了一种新的无监督图像到图像翻译框架NICE-GAN。它重用鉴别器进行编码,并开发了一种用于有效训练的解耦范例。在几个流行的基准上进行的对比实验评估表明,NICE-GAN通常比最先进的方法具有更高的性能。我们的研究有望引发对鉴别器实际功能的重新思考,并且可能适用于在其他情况下刷新基于GAN的模型。

确认本研究由中国国家自然科学基金会(NSFC)和德国跨模式学习研究基金会(DFG)、国家科学基金会61621136008/DFG TRR169和中国国家自然基金会(91848206)联合资助。我们感谢钟成亮、景明轩和陶空博士的富有洞察力的建议。

References

[1] Matthew Amodio and Smita Krishnaswamy. Travelgan:

Image-to-image translation by transformation vector learn-

ing. In Proceedings of the IEEE Conference on Computer

Vision and Pattern Recognition, pages 8983–8992, 2019.

[2] Asha Anoosheh, Eirikur Agustsson, Radu Timofte, and Luc

V an Gool. Combogan: Unrestrained scalability for image

domain translation. In Proceedings of the IEEE Conference

on Computer Vision and Pattern Recognition Workshops,

pages 783–790, 2018.

[3] M Bi´nkowski, DJ Sutherland, M Arbel, and A Gretton.

Demystifying mmd gans. In International Conference on

Learning Representations, 2018.

[4] Andrew Brock, Theodore Lim, James Millar Ritchie, and

Nicholas J Weston. Neural photo editing with introspec-

tive adversarial networks. In 5th International Conference

on Learning Representations, 2017.

[5] Y unjey Choi, Minje Choi, Munyoung Kim, Jung-Woo Ha,

Sunghun Kim, and Jaegul Choo. Stargan: Unified genera-

tive adversarial networks for multi-domain image-to-image

translation. In Proceedings of the IEEE Conference on Com-

puter Vision and Pattern Recognition, pages 8789–8797,

2018.

[6] Tali Dekel, Chuang Gan, Dilip Krishnan, Ce Liu, and

William T Freeman. Sparse, smart contours to represent

and edit images. In Proceedings of the IEEE Conference

on Computer Vision and Pattern Recognition, pages 3511–

3520, 2018.

[7] Ugur Demir and Gozde Unal. Patch-based image inpaint-

ing with generative adversarial networks. arXiv preprint

arXiv:1803.07422, 2018.

[8] Ishan Durugkar, Ian Gemp, and Sridhar Mahadevan. Genera-

tive multi-adversarial networks. In International Conference

on Learning Representations, 2017.

[9] Ian Goodfellow, Jean Pouget-Abadie, Mehdi Mirza, Bing

Xu, David Warde-Farley, Sherjil Ozair, Aaron Courville, and

Y oshua Bengio. Generative adversarial nets. In Advances

in neural information processing systems, pages 2672–2680,

2014.

[10] Kaiming He, Xiangyu Zhang, Shaoqing Ren, and Jian Sun.

Deep residual learning for image recognition. In Proceed-

ings of the IEEE conference on computer vision and pattern

recognition, pages 770–778, 2016.

[11] Martin Heusel, Hubert Ramsauer, Thomas Unterthiner,

Bernhard Nessler, and Sepp Hochreiter. Gans trained by a

two time-scale update rule converge to a local nash equilib-

rium. In Advances in Neural Information Processing Sys-

tems, pages 6626–6637, 2017.

[12] Xun Huang, Ming-Y u Liu, Serge Belongie, and Jan Kautz.

Multimodal unsupervised image-to-image translation. In

ECCV, 2018.

[13] Satoshi Iizuka, Edgar Simo-Serra, and Hiroshi Ishikawa.

Globally and locally consistent image completion. ACM

Transactions on Graphics (ToG), 36(4):107, 2017.

[14] Phillip Isola, Jun-Y an Zhu, Tinghui Zhou, and Alexei A

Efros. Image-to-image translation with conditional adver-

sarial networks. In Computer Vision and Pattern Recognition

(CVPR), 2017 IEEE Conference on, 2017.

[15] Long Jin, Justin Lazarow, and Zhuowen Tu. Introspective

classification with convolutional nets. In Advances in Neural

Information Processing Systems, pages 823–833, 2017.

[16] Junho Kim, Minjae Kim, Hyeonwoo Kang, and Kwang Hee

Lee. U-gat-it: Unsupervised generative attentional net-

works with adaptive layer-instance normalization for image-

to-image translation. In International Conference on Learn-

ing Representations, 2020.

[17] Taeksoo Kim, Moonsu Cha, Hyunsoo Kim, Jung Kwon Lee,

and Jiwon Kim. Learning to discover cross-domain relations

with generative adversarial networks. In Proceedings of the

34th International Conference on Machine Learning-V olume

70, pages 1857–1865. JMLR. org, 2017.

[18] Diederik P Kingma and Jimmy Ba. Adam: A method for

stochastic optimization. arXiv preprint arXiv:1412.6980,

2014.

[19] Justin Lazarow, Long Jin, and Zhuowen Tu. Introspective

neural networks for generative modeling. In Proceedings

of the IEEE International Conference on Computer Vision,

pages 2774–2783, 2017.

[20] Christian Ledig, Lucas Theis, Ferenc Huszár, Jose Caballero,

Andrew Cunningham, Alejandro Acosta, Andrew Aitken,

Alykhan Tejani, Johannes Totz, Zehan Wang, et al. Photo-

realistic single image super-resolution using a generative ad-

versarial network. In Proceedings of the IEEE conference on

computer vision and pattern recognition, pages 4681–4690,

2017.

[21] Hsin-Ying Lee, Hung-Y u Tseng, Jia-Bin Huang, Ma-

neesh Kumar Singh, and Ming-Hsuan Y ang. Diverse image-

to-image translation via disentangled representations. In Eu-

ropean Conference on Computer Vision, 2018.

[22] Hsin-Ying Lee, Hung-Y u Tseng, Qi Mao, Jia-Bin Huang,

Y u-Ding Lu, Maneesh Kumar Singh, and Ming-Hsuan Y ang.

Drit++: Diverse image-to-image translation viadisentangled

representations. arXiv preprint arXiv:1905.01270, 2019.

[23] Kwonjoon Lee, Weijian Xu, Fan Fan, and Zhuowen Tu.

Wasserstein introspective neural networks. In Proceedings

of the IEEE Conference on Computer Vision and Pattern

Recognition, pages 3702–3711, 2018.

[24] Tsung-Yi Lin, Piotr Dollár, Ross Girshick, Kaiming He,

Bharath Hariharan, and Serge Belongie. Feature pyra-

mid networks for object detection. In Proceedings of the

IEEE conference on computer vision and pattern recogni-

tion, pages 2117–2125, 2017.

[25] Ming-Y u Liu, Thomas Breuel, and Jan Kautz. Unsupervised

image-to-image translation networks. In Advances in neural

information processing systems, pages 700–708, 2017.

[26] Ming-Y u Liu and Oncel Tuzel. Coupled generative adversar-

ial networks. In Advances in neural information processing

systems, pages 469–477, 2016.

[27] Wei Liu, Dragomir Anguelov, Dumitru Erhan, Christian

Szegedy, Scott Reed, Cheng-Yang Fu, and Alexander C

Berg. Ssd: Single shot multibox detector. In European con-

ference on computer vision, pages 21–37. Springer, 2016.

[28] Xudong Mao, Qing Li, Haoran Xie, Raymond YK Lau, Zhen

Wang, and Stephen Paul Smolley. Least squares generative

8176

adversarial networks. In Proceedings of the IEEE Interna-

tional Conference on Computer Vision, pages 2794–2802,

2017.

[29] Takeru Miyato, Toshiki Kataoka, Masanori Koyama, and

Y uichi Y oshida. Spectral normalization for generative ad-

versarial networks. In International Conference on Learning

Representations, 2018.

[30] Alec Radford, Luke Metz, and Soumith Chintala. Un-

supervised representation learning with deep convolu-

tional generative adversarial networks. arXiv preprint

arXiv:1511.06434, 2015.

[31] Amélie Royer, Konstantinos Bousmalis, Stephan Gouws,

Fred Bertsch, Inbar Mosseri, Forrester Cole, and Kevin Mur-

phy. Xgan: Unsupervised image-to-image translation for

many-to-many mappings. arXiv preprint arXiv:1711.05139,

2017.

[32] Wenzhe Shi, Jose Caballero, Ferenc Huszár, Johannes Totz,

Andrew P Aitken, Rob Bishop, Daniel Rueckert, and Zehan

Wang. Real-time single image and video super-resolution

using an efficient sub-pixel convolutional neural network. In

Proceedings of the IEEE conference on computer vision and

pattern recognition, pages 1874–1883, 2016.

[33] Jianlin Su. O-gan: Extremely concise approach for auto-

encoding generative adversarial networks, 2019.

[34] Y aniv Taigman, Adam Polyak, and Lior Wolf. Unsupervised

cross-domain image generation. In International Conference

on Learning Representations, 2016.

[35] Ting-Chun Wang, Ming-Y u Liu, Jun-Y an Zhu, Guilin Liu,

Andrew Tao, Jan Kautz, and Bryan Catanzaro. Video-to-

video synthesis. In Advances in Neural Information Pro-

cessing Systems, pages 1144–1156, 2018.

[36] Ting-Chun Wang, Ming-Y u Liu, Jun-Y an Zhu, Andrew Tao,

Jan Kautz, and Bryan Catanzaro. High-resolution image syn-

thesis and semantic manipulation with conditional gans. In

Proceedings of the IEEE conference on computer vision and

pattern recognition, pages 8798–8807, 2018.

[37] Wayne Wu, Kaidi Cao, Cheng Li, Chen Qian, and

Chen Change Loy. Transgaga: Geometry-aware unsuper-

vised image-to-image translation. In Proceedings of the

IEEE Conference on Computer Vision and Pattern Recog-

nition, pages 8012–8021, 2019.

[38] Zili Yi, Hao Zhang, Ping Tan, and Minglun Gong. Dual-

gan: Unsupervised dual learning for image-to-image trans-

lation. In Proceedings of the IEEE international conference

on computer vision, pages 2849–2857, 2017.

[39] Richard Zhang, Phillip Isola, and Alexei A Efros. Colorful

image colorization. In European conference on computer

vision, pages 649–666. Springer, 2016.

[40] Jun-Y an Zhu, Taesung Park, Phillip Isola, and Alexei A

Efros. Unpaired image-to-image translation using cycle-

consistent adversarial networkss. In Computer Vision

(ICCV), 2017 IEEE International Conference on, 2017. -

相关阅读:

5.5V-65V Vin同步降压控制器,具有线路前馈SCT82630DHKR

异步请求与中断 ( XHR,Axios,Fetch对比 )

Angular 由一个bug说起之二:trackBy的一点注意事项

机器人力控制构架

Mysql 45讲学习笔记(二十五)MYSQL保证高可用

常用的Linux命令及其用法

Lottie动画多动图切换遇到的坑

有必要好好学习一下dc_shell了

Python 设计模式之工厂函数模式

目标检测算法改进系列之Backbone替换为EfficientViT

- 原文地址:https://blog.csdn.net/m0_61985580/article/details/126175917