-

【Python】Pandas处理数据太慢,来试试Polars吧!

很多人在学习数据分析的时候,肯定都会用到Pandas这个库,非常的实用!

从创建数据到读取各种格式的文件(text、csv、json),或者对数据进行切片和分割组合多个数据源,Pandas都能够很好的满足。

Pandas最初发布于2008年,使用Python、Cython和C编写的。是一个超级强大、快速和易于使用的Python库,用于数据分析和处理。

当然Pandas也是有不足之处的,比如不具备多处理器,处理较大的数据集速度很慢。

今天给大家介绍一个新兴的Python库——Polars。

使用语法和Pandas差不多,处理数据的速度却比Pandas快了不少。

一个是大熊猫,一个是北极熊~

GitHub地址:https://github.com/ritchie46/polars

使用文档:https://ritchie46.github.io/polars-book/

Polars是通过Rust编写的一个库,Polars的内存模型是基于Apache Arrow。

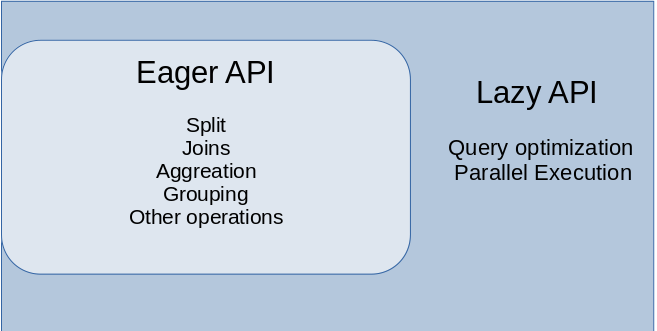

Polars存在两种API,一种是Eager API,另一种则是Lazy API。

其中Eager API和Pandas的使用类似,语法差不太多,立即执行就能产生结果。

而Lazy API就像Spark,首先将查询转换为逻辑计划,然后对计划进行重组优化,以减少执行时间和内存使用。

安装Polars,使用百度pip源。

# 安装polars pip install polars -i https://mirror.baidu.com/pypi/simple/- 1

- 2

安装成功后,开始测试,比较Pandas和Polars处理数据的情况。

使用某网站注册用户的用户名数据进行分析,包含约2600万个用户名的CSV文件。

文件已上传公众号,获取方式见文末。

import pandas as pd df = pd.read_csv('users.csv') print(df)- 1

- 2

- 3

- 4

- 5

数据情况如下。

此外还使用了一个自己创建的CSV文件,用以数据整合测试。

import pandas as pd df = pd.read_csv('fake_user.csv') print(df)- 1

- 2

- 3

- 4

得到结果如下。

首先比较一下两个库的排序算法耗时。

import timeit import pandas as pd start = timeit.default_timer() df = pd.read_csv('users.csv') df.sort_values('n', ascending=False) stop = timeit.default_timer() print('Time: ', stop - start) ------------------------- Time: 27.555776743218303- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

可以看到使用Pandas对数据进行排序,花费了大约28s。

import timeit import polars as pl start = timeit.default_timer() df = pl.read_csv('users.csv') df.sort(by_column='n', reverse=True) stop = timeit.default_timer() print('Time: ', stop - start) ----------------------- Time: 9.924110282212496- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

Polars只花费了约10s,这意味着Polars比Pandas快了2.7倍。

下面,我们来试试数据整合的效果,纵向连接。

import timeit import pandas as pd start = timeit.default_timer() df_users = pd.read_csv('users.csv') df_fake = pd.read_csv('fake_user.csv') df_users.append(df_fake, ignore_index=True) stop = timeit.default_timer() print('Time: ', stop - start) ------------------------ Time: 15.556222308427095- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

使用Pandas耗时15s。

import timeit import polars as pl start = timeit.default_timer() df_users = pl.read_csv('users.csv') df_fake = pl.read_csv('fake_user.csv') df_users.vstack(df_fake) stop = timeit.default_timer() print('Time: ', stop - start) ----------------------- Time: 3.475433263927698- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

Polars居然最使用了约3.5s,这里Polars比Pandas快了4.5倍。

通过上面的比较,Polars在处理速度上表现得相当不错。

可以是大家在未来处理数据时,另一种选择~

当然,Pandas目前历时12年,已经形成了很成熟的生态,支持很多其它的数据分析库。

Polars则是一个较新的库,不足的地方还有很多。

如果你的数据集对于Pandas来说太大,对于Spark来说太小,那么Polars便是你可以考虑的一个选择。

-

相关阅读:

Rank-embedded Hashing for Large-scale Image Retrieval

福建建筑模板厂家-能强优品木业

全球排名前十的搜索引擎,你猜百度排名在第几位?bing稳居二位!

java2022最新面试题及答案,轻松过秋招

【vue-router 路由篇】 传入私有数据给目标路由地址而不显示在url上

【机器学习12】集成学习

使用 ECharts 绘制咖啡店各年订单的可视化分析

OPENCV实现暴力特征匹配

如何在 SAP Spartacus 中编写 ASM-Compatible 的代码

前端--CSS

- 原文地址:https://blog.csdn.net/m0_54252387/article/details/126171623