-

Spark读取多目录

项目场景:

上游任务按类型生成json文件存放到hdfs上,会生成很多目录。

下游任务需要读取这些目录下得文件,生成df进行处理。

解决方案:

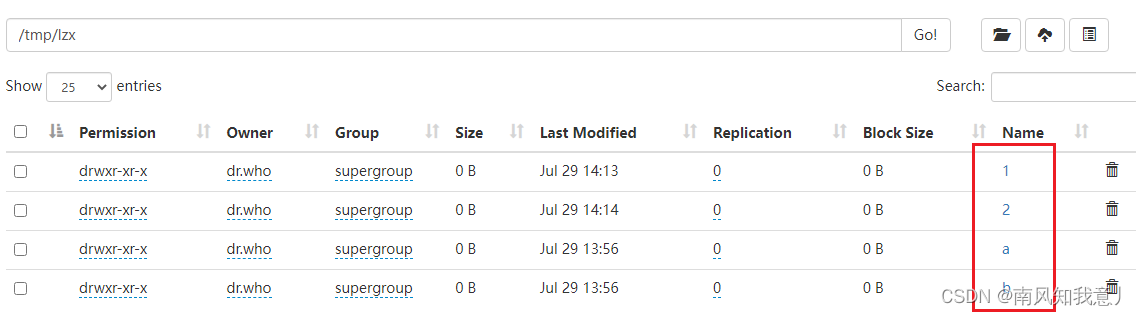

目录结构:

1.sparkContext

方式一

val session: SparkSession = SparkSession.builder().master("local[*]").appName("read_Muti_catalogue").getOrCreate() val sc: SparkContext = session.sparkContext import session.implicits._ //方式一: sc.textFile("/tmp/lzx/a,/tmp/lzx/b").toDF().show(false)- 1

- 2

- 3

- 4

- 5

- 6

- 7

方式二

val session: SparkSession = SparkSession.builder().master("local[*]").appName("read_Muti_catalogue").getOrCreate() val sc: SparkContext = session.sparkContext import session.implicits._ //2.1.方式二:匹配字符 val path1 = "/tmp/lzx/[a]" val path2 = "/tmp/lzx/[b]" val arryPath: Array[String] = Array(path1, path2) val rdds: Array[RDD[String]] = arryPath.map(sc.textFile(_)) sc.union(rdds).toDF().show(false) //2.2.方式二:匹配数字 val path3 = "/tmp/lzx/*1" val path4 = "/tmp/lzx/*2" val arryPath2: Array[String] = Array(path3, path4) val rdds2: Array[RDD[String]] = arryPath2.map(sc.textFile(_)) sc.union(rdds2).toDF().show(false) session.close()- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

2.sparkSession

//3.SparkSession println("3.SparkSession-----------------------") val path5 = "/tmp/lzx/*1" val path6 = "/tmp/lzx/*2" val arryPath3: Array[String] = Array(path5, path6) // :_* 作为一个整体,一般可以用于获取一个数组的全部字段 //spark.read.textFile方法返回只有一列value的DataSet表。 val ds: Dataset[String] = session.read.textFile(arryPath3: _*) ds.show() //spark.read.text方法返回只有一列value的DataFrame表。 val df: DataFrame = session.read.text(arryPath3: _*) df.show()- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

3.通配符使用说明

注意:

每个路径都要定位到最后一级。

路径之间不能存在包含关系。

目录与文件不要混放,即放在同一个目录下。

路径中可使用通配符参考

https://blog.csdn.net/weixin_40829577/article/details/103847405

-

相关阅读:

vs2019 新建项目显示空白,无法新建文件

HTTP协议分析

QT+OSG/osgEarth编译之二十四:SpatiaLite+Qt编译(一套代码、一套框架,跨平台编译,版本:SpatiaLite-5.0.1)

数据库复制:Spectral Core Full Convert Ultimate 2022

回归分析:多项式回归与广义线性回归,非线性问题的拟合

软件测试周刊(第89期):编程是思考,而不是打字。

QT学习日记7——QMainWindow

一个完整的测试流程包括哪些?测试人员需要做什么?

外包干了3个月,技术倒退2年。。。

python项目实战——银行取款机系统(六)

- 原文地址:https://blog.csdn.net/Lzx116/article/details/126059493