-

信息论基础

一、前言:

信息论,对我而言,最早接触是在大二的专业课上。那个时候刚学完概率论,高数什么什么的,这是第一门需要将数学工具应用到实际分析之中的课,可想而知,我的成绩果然是飘过及格线。后面考研、读研期间,就再也没有接触过这方面的知识了。这一段时间的信息论对我而言,仅仅是一门课。

然而在一年前,由于工作方向的变化,我不得不从新将信息论捡了起来。过了几年再来看这门课,真是感慨良多。必须说得是,信息论作为一门后发的通信理论,不仅为之前的通信结论做出了牢固的理论支撑,还为未来通信技术的研究规划了方向。大三大四时候光顾着死记硬背什么MIMO容量,调制近似容量了,怎么来的完全不知道。自从把信息论捡了起来后,我仿佛又有那么一点理解了。

要问笔者为什么又要回去重新捡起信息论?不得不说这是一个亡羊补牢的结果。由于6G牵涉到很多新的通信方式,其中的一些区别于之前的射频通信。因此对于信号、信道的一些判断,如果继续沿用原来的结论将是错误的。我决定从新从信息论开始分析这些新的通信方式带来的不同。事实上,分析所得出的结果确实一定程度上辅助了我们对新关键技术的一些判断。

随着之前成果的逐步落实,现在想把总结的笔记分享出来。本笔记主要基于B站《信息论》课程视频来的,综合了多个视频。在此向国防科大和西安交大的老师们表示感谢。

未经授权,本笔记不得用于商业用途。

本笔记的内容概括如下:

二、目录:

绪论:Ø信息的定义;信息测度的基本概念;信息论的发展

信源模型及信息熵:Ø信源的数学模型;信息熵,联合熵与条件熵。

熵的基本性质:Ø非负性,确定性,对称性,扩展性,链式法则

信源的相关性及剩余度

信道模型与平均互信息:Ø信道模型、平均互信息(疑义度、性质)、信道容量

信道容量的概念:Ø信道容量的定义、对称离散信道的信道容量、信道容量的一般计算方法

三、绪论

1、信息的定义

Ø 解释:通信系统传输和处理的对象,泛指消息和信号的具体内容和意义。通常通过处理和分析来提取。那么信息和消息的区别是什么?

Ø 用文字、符号、数据、语言、音符、图片、图像等能够被人感觉器官所感知的形式,把客观物质运动和主观思维活动的状态表达出来就称为消息。Ø 信息是事物运动状态或存在方式的不确定性的描述。( Shannon 信息)简单来说就是:消息是信息的载体,信息是抽象的传输主体。

那么信号又是什么呢?

Ø 把消息变换成适合信道传输的物理量,这种物理量就称为信号。

对于我们的通信系统来说,通信的实质是通过消息的传递,消除不确定性,获得信息。

2、信息测度

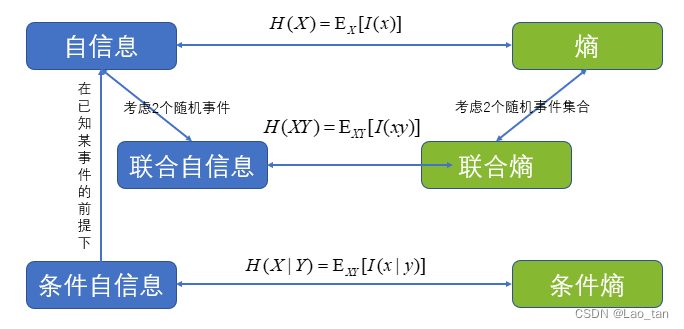

2.1、自信息

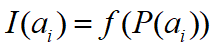

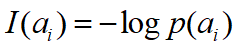

自信息表示事件出现的不确定性大小,或者说事件的发生概率有关,因此可以这么建模:

一般来说,不确定性越大,则携带信息应该越多。因此I(ai)这个函数应该是概率P(ai)的单调递减函数,且P(ai)=1时I(ai)=0,P(ai)=0时I(ai)=1。

此外,如果说一个事件出现的概率极小,那么他出现的难度接近无穷。那么I(x)如何建模才可以符合上述要求呢?

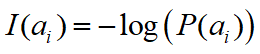

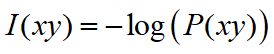

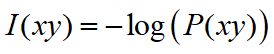

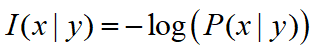

明显,如果使用对数函数,可以完美的合乎上述要求。因此,对一个事件ai发生的概率,可以得到该事件所携带的自信息为:

上述公式称为事件ai的自信息,也可以说是测度函数。

进一步考虑二维的情况。

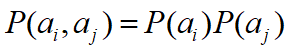

当有两个随机事件时,先简单地假定它们独立,即

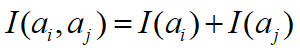

,两个独立事件的自信息应该满足如下关系:

,两个独立事件的自信息应该满足如下关系:

根据概率论可以知道,同时发生事件ai和aj的情况是一个联合事件,如果用不同的随机变量X和Y来表示,则可以简写成:

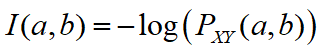

其中某个具体发生的事件x=a,y=b的自信息为:

上式也成为联合自信息,他表示a,b两个事件联合出现的一个不确定性。

(*自信息有2个隐藏的含义:当事件ai发生以前,自信息表示ai发生的不确定性;当ai发生以后,自信息表示ai所提供的信息量。)

上式可以简写为:

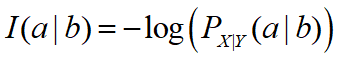

扩展到条件概率的情况,则有条件自信息:

或

或

根据对数的底的不同,这些信息的单位也不同:以2为底时,单位表示bit,以e为底则为nat,以10为底则为hart。

给出一个例题,以加强记忆。

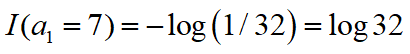

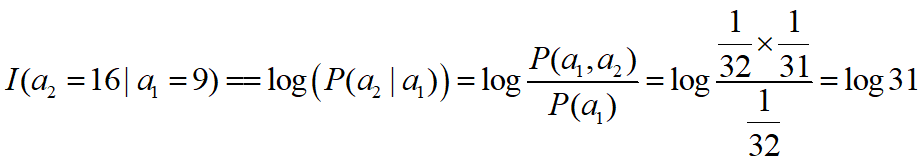

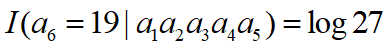

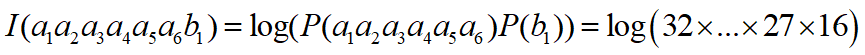

例3.1

双色福利球抽奖:两个大转箱有一堆带有编号的乒乓球(一个球对应唯一一个编号,红 32 个,蓝 16 个),从红中选 6 个,从蓝中选 1 个。每次落下一个,先抽红球箱子,再抽蓝球箱子。Q1 :猜中第一个球为 7 的难度?Q2 :第一个球为 9 出现后,猜中第二个球为 16 的难度?Q3 :已知前五个球号码为 7 , 16 , 21 , 17 , 1 ,猜中第 6 个球为 19 的难度?Q4 :猜中双色球为:红: 7 , 16 , 21 , 17 , 1 , 19 ;蓝: 14 的难度?答:(*注意:由于在红转箱中两次取球间是独立的,因此条件概率就等于每次取球的概率。)

A1:

A2:

A3:

A4:

3、信息论的发展

百度百科说的挺好,不再赘述了,总之就是香农yyds!

四、信源模型及信息熵

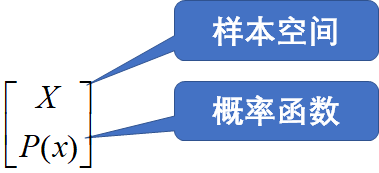

1、信源的数学模型

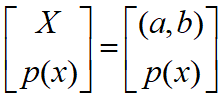

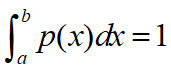

信息的获得是与消息出现的随机性是有很大关系的,信源的本质特征可以这么总结:信源是一个随机出现的消息的集合,可以用样本空间和分布律来表征信源特性。这和我们高中做的题一样,可以这么来写:

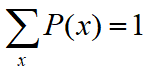

当然,概率空间还需要保证完备性:

1.1、信源的分类

根据随机事件,我们可以将信源分为以下几种:

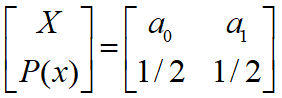

(1)离散信源和连续信源

离散信源,比如说抛硬币,正反两面是可能发生的结果,它的分布律可以写为:

连续信源,比如说音频信号,音频信号在幅度上可以当做是连续的。

(2)无记忆信源(符号间彼此独立)和有记忆信源

(3)简单信源(信源输出的消息以单个符号给出)和复杂信源(一个消息由一串符号表示,例如电话号码)。

2、信息熵

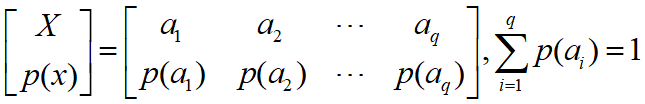

如果有一个离散信源,其概率空间为:

则信源输出的一个符号ai,则其自信息量为:

由于信源输出的消息是随机出现的,所以自信息也相当于随机变量。那么如何表征整个信源呢?

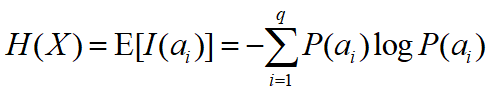

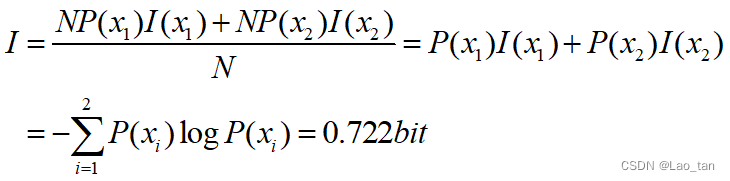

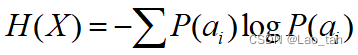

通过概率论的知识,我们很容易联想到使用期望来表征整个信源的信息量,这个数学期望也称为信源的平均自信息量:

这个平均信息量也称为信源X的熵或信息熵。H(X)仅取决于X的分布,而非其具体值,因此信源熵是一个固定的值。

信息熵用于描述信源X的平均不确定性,表示平均每个信源符号所携带的信息量。

思考:自信息和信息熵的相同和不同点是什么呢?

相同点:都是描述不确定性的大小;不同点:个别事件与整个集合。

例4.1

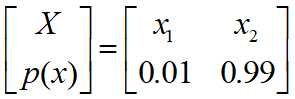

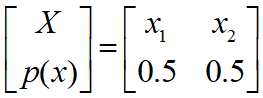

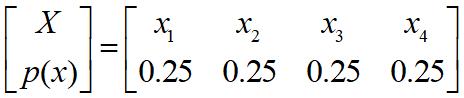

计算下面3个信源的信源熵:

1、

2、

3、

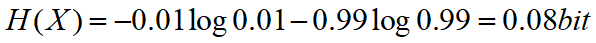

A1:

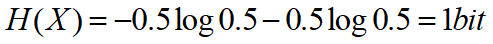

A2:

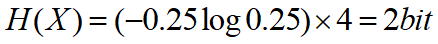

A3:

例4.2

考虑一个经典的独立重复实验,一个袋子内100个球,70个红30个白。随机摸一个猜颜色(放回),求平均每次试验的信息量。

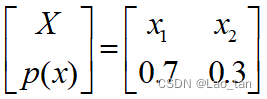

A:根据概率论的知识我们可以很快地写出这个实验的分布律或者说分布函数,如下:

如果我一共摸了N次试验,则红球的期望是0.7N次,白球是0.3N次。用n1和n2分别表示摸出红球和摸出白球发生的次数,则有

那么N次试验的总信息量为:

经过这个例子我们可以发现:熵值的大小表征了一个信源平均每输出一个消息能提供多大的信息量.

例4.3

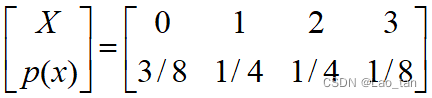

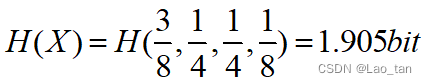

有如下一个四进制离散无记忆信源,其分布函数如下:

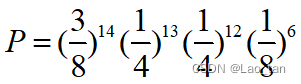

若发出的消息为:2021 2013 0213 0012 0321 0110 3210 1002 1032 0112 2321 0,则求

(1)此消息中平均每个符号携带的信息量是多少?

(2)此信源中平均每个符号携带的信息量是多少?

A2:由于我们拿到了信源的分布函数,这使得回答第二个问题更为简单,根据前面对信息熵的定义,该信源的信息熵为:

需要注意的是,这里的平均其实没有意义了,因为信源的信息熵本身就是一个期望。

A1:求此消息中平均每个符号的信息量并不是求对应的信源的信息量,因为我们已经发出了具体的消息。这个问题实际上是求该消息出现时所携带的信息量,而平均在这里表示的应该是这一消息中每个符号上的平均。根据具体消息形式,该消息出现的概率为:

因此该消息中平均每个符号出现的信息量为:

3、联合熵与条件熵

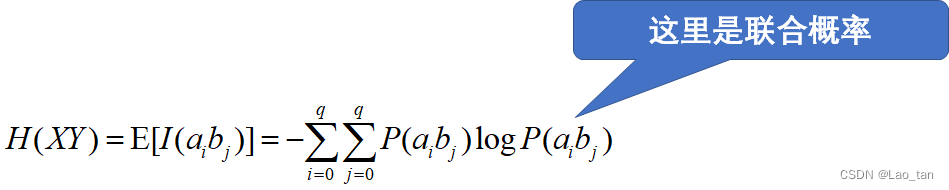

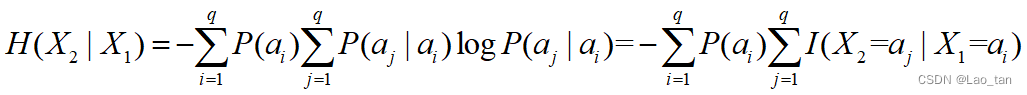

这里我只给出最简单的定义,对于多个随机事件,定义联合自信息的平均值为联合熵。当然这需要知道多个随机事件的联合分布,如果它们互相独立那么会使这个问题大大简化。考虑两个随机事件X和Y,他们的联合熵为:

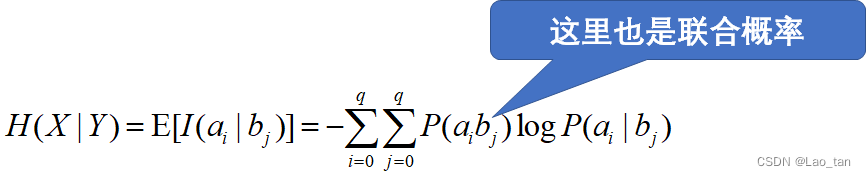

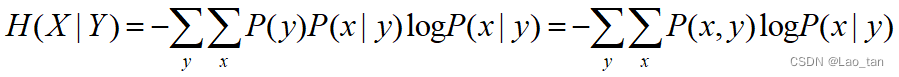

对于条件分布,也有对应的条件自信息,条件熵定义为条件自信息的平均值,即条件熵是用联合概率对条件自信息进行加权平均。

或

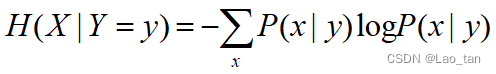

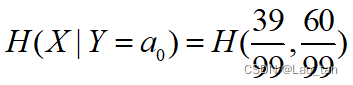

在具体事件Y=y的情况下,条件熵为:

例4.4

箱子中有100个球,40黑60白,从中取球且不放回,连续取2次,试求猜中第二个球颜色的难度。

A:明显,这是一个条件概率,我们需要求的难度指的就是条件熵。用事件X表示第一次取球的结果,用事件Y表示第二次取球的结果。那么我们有:

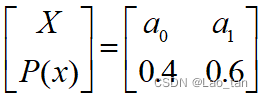

事件X的分布函数为:

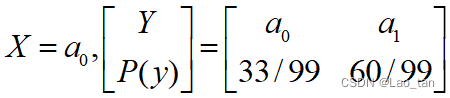

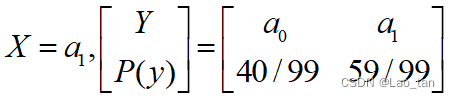

事件Y的条件分布函数为:

或

或

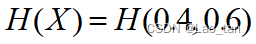

事件X的信息熵为:

X摸出黑球时,Y的条件熵为:

X摸出白球时,Y的条件熵为:

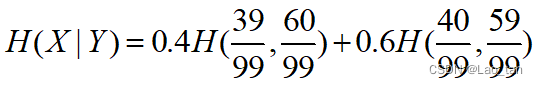

再求一次平均可以得Y的条件熵为:

例4.5

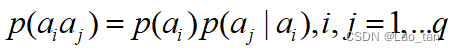

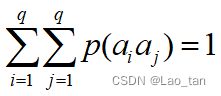

有一二维离散平稳信源

,

,且

,

, 则信源X平均每符号输出的信息量为?

则信源X平均每符号输出的信息量为?A:这是一个离散有记忆信源,平稳的意思是:随机序列的概率分布与时间起点无关,称为平稳序列。如果继续套用信源的信息熵不能反映信源的记忆性。对于有记忆信源,通常考虑条件熵,而联合熵常用于工程近似。

*(补充:什么是平稳随机过程?平稳随机过程是在固定时间和位置的概率分布与所有时间和位置的概率分布相同的随机过程,即随机过程的统计特性不随时间的推移而变化,因此数学期望和方差这些参数不随时间和位置变化。平稳过程是一种重要的随机过程,其主要的统计特性不会随时间推移而改变。)

4、总结

什么时候用熵?

什么时候用联合熵?

什么时候用条件熵?

需要考察信源输出对象的形式,如果信源是无记忆信源,则用基本信源熵就可以,而且是单符号的;如果考察的是若干个集合组成的信源,则联合熵;如果考察的是一个有记忆信源,一般来说还是考察这个信源每输出一个符号能够提供的信息量,但是这个符号可能受到之前符号的影响。如果考察的是一个N维平稳信源,则怎么表示信源熵呢?则第N个符号的不确定性受到前面N-1个符号的影响,仍然需要找到联合概率和条件自信息。

--------------------------------------------------------------------------------------------------------------------

今天的停更线,东西太多需要慢慢总结。2022.6.28

-

相关阅读:

分库分表之历史表如何选择最佳分片路由规则

数据集成用于哪些行业

访问者模式你了解了吗?

RHCSA 02 - 自启动rootless容器

汇编:调用Win32 API

pandas.eval()/pandas.Series()/lambda/itertools.product

iOS自动化测试元素定位

面向对象详解,面向对象的三大特征:封装、继承、多态

LayUI项目之(查询&会议签字)

二、postgre数据库SQL优化:查看执行计划

- 原文地址:https://blog.csdn.net/Lao_tan/article/details/125486024