-

基于Faster R-CNN的安全帽目标检测

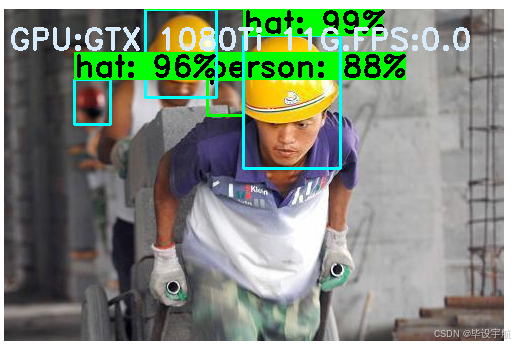

基于Faster R-CNN的安全帽目标检测项目通常旨在解决工作场所,特别是建筑工地的安全监管问题。这类项目使用计算机视觉技术,特别是深度学习中的Faster R-CNN算法,来自动检测工人是否正确佩戴了安全帽,从而确保遵守安全规定并减少事故风险。

项目背景与目标: 在建筑、矿山和其他高风险作业环境中,安全帽是保护工人免受头部伤害的基本装备。然而,人工检查安全帽的佩戴情况效率低下且容易出错。因此,开发自动化检测系统可以提高工作效率和安全性。

技术细节:

- 数据收集: 项目首先需要收集大量包含工人头像和安全帽的图像数据,这些数据可能来自于监控摄像头或专门拍摄的照片。

- 数据标注: 对于每一张图片,需要手动标注安全帽的位置,这通常涉及划定边界框并标记类别(例如,有安全帽、无安全帽)。

- 模型训练: 使用标注过的数据集来训练Faster R-CNN模型。Faster R-CNN是一个两阶段的目标检测模型,它包括一个区域提议网络(RPN)用于生成候选区域,以及一个用于分类和定位的后续网络。

- 模型评估: 在测试集上评估模型的性能,调整超参数以优化准确性和召回率。

- 部署: 将训练好的模型部署到实际环境中,如连接到现场的摄像头,实时分析视频流,识别未戴安全帽的人员。

应用与优势:

- 实时监控:系统能够连续地分析视频流,及时发现未佩戴安全帽的情况。

- 减少人力成本:自动化检测减少了对人工监督的需求,节省了人力资源。

- 提高安全性:通过及时提醒未遵守安全规定的工人,降低潜在的事故风险。

- 数据分析:收集的数据可用于进一步分析安全行为模式,帮助改善安全管理策略。

挑战与限制:

- 光照条件变化:室外环境光照变化大,可能影响检测效果。

- 遮挡问题:工人的姿势、其他物体或人群的遮挡会增加检测难度。

- 计算资源:实时视频处理需要强大的计算能力,尤其是在边缘设备上。

总之,基于Faster R-CNN的安全帽目标检测项目是一个综合了数据科学、计算机视觉和深度学习技术的解决方案,旨在提高工作场所的安全性。

1. 🔥 训练模型前的准备

- A.数据准备

数据的标注仍然采用VOC格式的数据标注形式,如果是其他的标注形式比如COCO请自行实现相关代码。将数据最终转化为如下形式:

- # 单行数据的结构: (path_filename, x1, y1, x2, y2, class_name)

- # Note:

- # 一个path_filename 可能对应多个类别(class_name),每个类别占用一行数据

- # x1, y1, x2, y2 是原图像的坐标, 而不是ratio后图像上的坐标

- # (x1, y1) 标注框的左上坐标; (x2, y2) 标注框的右下坐标

- # x1,y1-------------------

- # | |

- # | |

- # | |

- # | |

- # ---------------------x2,y2

可以运行如下代码实现数据集的准备工作:

python3 ./data/data_pro.py将在

./data文件夹下生成annotation.txt文件,这样训练数据的准备工作即完成。- # path_filename, x1, y1, x2, y2, class_name

- /home/myuser/xujing/Faster-R-CNN_hat/data/JPEGImages/000605.jpg,37,12,151,154,hat

- /home/myuser/xujing/Faster-R-CNN_hat/data/JPEGImages/000605.jpg,243,1,393,176,hat

- /home/myuser/xujing/Faster-R-CNN_hat/data/JPEGImages/PartB_02176.jpg,92,593,180,684,person

- /home/myuser/xujing/Faster-R-CNN_hat/data/JPEGImages/PartB_02176.jpg,229,648,357,777,person

- B.配置文件准备

根据自己的训练集和训练任务修改

./keras_frcnn/config.py的配置文件,相关参数的解释和配置如下:- self.verbose = True # 显示训练过程

- self.network = 'vgg' # backbone 目前支持vgg(VGG16),resnet50,xception,inception_resnet_v2

- # 数据增强策略

- self.use_horizontal_flips = False # 水平随机裁剪

- self.use_vertical_flips = False # 垂直随机裁剪

- self.rot_90 = False # 随机90度旋转

- # Anchor Box的scale

- # 根据具体的情况去修改,一般是图像或目标的大小做调整!!!!

- # self.anchor_box_scales = [128,256,512]

- self.anchor_box_scales = [4,8,16,64,128,256,512,1024]

- # Anchor Box的ratio

- self.anchor_box_ratios = [[1, 1], [1, 2], [2, 1]]

- # self.anchor_box_ratios = [[1, 1]]

- # 图像最小变填充后的尺寸

- self.im_size = 600

- # 图像channel-wise上的mean和std,这个值是根据ImageNet数据集得到的

- # 可以根据自己训练集调整

- self.img_channel_mean = [103.939, 116.779, 123.68]

- self.img_scaling_factor = 1.0

- # 一次得到的ROI的个数

- self.num_rois = 32

- # RPN网络特征图的缩小倍数(VGG16的是16,其他网络请自行修改该参数)

- # 换网络时 要换的!!!

- self.rpn_stride = 16

- # 训练时是否做类别blance

- self.balanced_classes = False

- # Regression时的scaling the stdev

- self.std_scaling = 4.0

- self.classifier_regr_std = [8.0, 8.0, 4.0, 4.0]

- # 训练集制作过程中的正负样本的划分策略,详细才考faster R-CNN原论文

- # overlaps for RPN

- self.rpn_min_overlap = 0.3

- self.rpn_max_overlap = 0.7

- # overlaps for classifier ROIs

- self.classifier_min_overlap = 0.1

- self.classifier_max_overlap = 0.5

- # class类别映射

- self.class_mapping = None

- # base network的预训练模型的存放位置

- # keras预训练模型可以在这里下载: https://github.com/fchollet/deep-learning-models

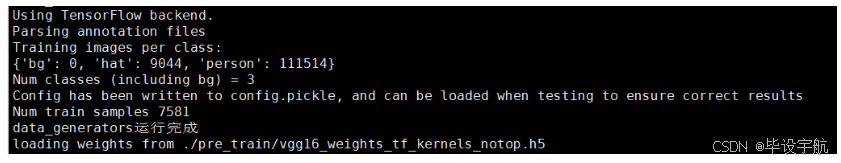

- self.model_path = './pre_train/vgg16_weights_tf_kernels_notop.h5' # 我们使用VGG16

2. 🐎 训练模型

预训练模型:Shell下运行

python3 train_frcnn.py --path="./data/annotation.txt" --network="vgg" --input_weight_path="./pre_train/vgg16_weights_tf_kernels_notop.h5"windows下直接运行我们写好的批处理文件:

run_train.bat

3. 🚀 模型推断

将需要测试的图像和视频拷贝到

./new_test文件夹- A.单张图像推断

Shell下运行:

python3 test_frcnn.py --path="./new_test"windows下直接运行我们写好的批处理文件:

run_inference.bat- B.视频推断

Shell下运行:

python3 test_frcnn_video.py --path="./new_test/test_video.mp4"windows下直接运行我们写好的批处理文件:

test_video.bat4. 🎉 DEMO

-

相关阅读:

ElasticSearch中RESTFUL API(创建索引、增删改查、DSL搜索、高亮显示、聚合)

计算机网络专栏 学习导航or使用说明

Java核心技术第十章学习笔记

测试人生 | 转行测试开发,4年4“跳”年薪涨3倍,我的目标是星辰大海(附大厂面经)!

C# 第八章『多线程』◆第2节:线程的属性

王道书 P150 T20 + 拓展(表达式树的计算)

(WebFlux)003、多数据源R2dbc事务失效分析

nginx必须使用域名访问的两种设置方法

BLUElegend传奇引擎不使用路由器架设单传奇的办法

吾爱破解置顶的“太极”,太好用了吧!

- 原文地址:https://blog.csdn.net/2301_78240361/article/details/140429147