-

《统计学习方法》 第4章 朴素贝叶斯法

前言

本文只要记录一些书中的一些小知识点,挑一些本人认为重要的地方进行总结。

各位道友!道长(zhǎng) 道长(chǎng)

一、朴素贝叶斯法

朴素贝叶斯法是基于贝叶斯定理与特征条件独立假设的分类方法。

首先基于特征条件独立假设学习输入输出的联合概率分布

然后基于此模型,对给定的输入x,利用贝叶斯定理求出后验概率最大的输出y。

朴素贝叶斯法实现简单,效率高,常用二、朴素贝叶斯法的学习和分类

两个小概念:

- 先验概率:事情没有发生,根据经验判断结果发生的概率。由因求果

- 后验概率:事情已经发生,根据发生的结果,判断是什么原因引起的该结果。由果求因

已知输入空间上的随机变量X和输出空间上的随机变量Y.

先验概率分布为:

P ( Y = c k ) , k = 1 , 2... K P(Y=c_k), k=1,2...K P(Y=ck),k=1,2...K

( c k c_k ck为类标记)

条件概率分布为:

P ( X = x ∣ Y = c k ) P(X=x|Y=c_k) P(X=x∣Y=ck)

于是得到了联合概率分布 P ( X , Y ) P(X,Y) P(X,Y)

由于条件概率分布 P ( X = x ∣ Y = c k ) P(X=x|Y=c_k) P(X=x∣Y=ck)有指数级别的参数,于是做出了一个条件独立性的假设。

P ( X = x ∣ Y = c k ) = ∏ j = 1 n P ( X ( j ) ∣ Y = c k ) P(X=x|Y=c_k)=\prod_{j=1}^nP(X^{(j)}|Y=c_k) P(X=x∣Y=ck)=j=1∏nP(X(j)∣Y=ck)这样,通过学习到的模型计算后验概率分布 P ( Y = c k ∣ X = x ) P(Y=c_k|X=x) P(Y=ck∣X=x):

P ( Y = c k ∣ X = x ) = P ( X = x ∣ Y = c k ) P ( Y = c k ) ∑ k P ( X = x ∣ Y = c k ) P ( Y = c k ) P(Y=c_k|X=x)=\frac{P(X=x|Y=c_k)P(Y=c_k)}{\sum_kP(X=x|Y=c_k)P(Y=c_k)} P(Y=ck∣X=x)=∑kP(X=x∣Y=ck)P(Y=ck)P(X=x∣Y=ck)P(Y=ck)

将条件独立假设带入可得

P ( Y = c k ∣ X = x ) = P ( Y = c k ) ∏ j P ( X ( j ) ∣ Y = c k ) ∑ k P ( Y = c k ) ∏ j P ( X ( j ) ∣ Y = c k ) P(Y=c_k|X=x)=\frac{P(Y=c_k) \prod_{j}P(X^{(j)}|Y=c_k)}{\sum_kP(Y=c_k)\prod_jP(X^{(j)}|Y=c_k)} P(Y=ck∣X=x)=∑kP(Y=ck)∏jP(X(j)∣Y=ck)P(Y=ck)∏jP(X(j)∣Y=ck)这就是朴素贝叶斯法的基本公式,于是朴素贝叶斯分类起可以表示为:

y = f ( x ) = arg max c k P ( Y = c k ) ∏ j P ( X ( j ) ∣ Y = c k ) ∑ k P ( Y = c k ) ∏ j P ( X ( j ) ∣ Y = c k ) y=f(x)=\arg \max_{c_k} \frac{P(Y=c_k) \prod_jP(X^{(j)}|Y=c_k)}{\sum_kP(Y=c_k)\prod_jP(X^{(j)}|Y=c_k)} y=f(x)=argckmax∑kP(Y=ck)∏jP(X(j)∣Y=ck)P(Y=ck)∏jP(X(j)∣Y=ck)

由于所有分母对于所有的 c k c_k ck都是相同的,所以只需要使分子部分极大化即可y = f ( x ) = arg max c k P ( Y = c k ) ∏ j P ( X ( j ) = x ( j ) ∣ Y = c k ) y=f(x)=\arg \max_{c_k} P(Y=c_k) \prod_jP(X^{(j)}=x^{(j)}|Y=c_k) y=f(x)=argckmaxP(Y=ck)j∏P(X(j)=x(j)∣Y=ck)

三、朴素贝叶斯算法

输入:训练数据集 T = ( x 1 , y 1 ) . . . ( x N , y N ) T= {(x_1,y_1)...(x_N,y_N) } T=(x1,y1)...(xN,yN);实例 x x x

输出: x x x的分类- (其中 x = ( x ( 1 ) , x ( 2 ) . . . . x ( n ) ) x=(x^{(1)},x^{(2)}....x^{(n)}) x=(x(1),x(2)....x(n)), x i ( j ) x_i^{(j)} xi(j)表示第I个样本的第j个特征。y=(c1,c2,…,cK)表示类别)

(1)计算先验概率及条件概率

先验概率的极大似然估计是:

P ( Y = c k ) = ∑ i = 1 N I ( y i = c k ) N , k = 1 , 2... K P(Y=c_k)=\frac{\sum_{i=1}^NI(y_i=c_k)}{N} ,k=1,2...K P(Y=ck)=N∑i=1NI(yi=ck),k=1,2...K

条件概率的极大似然估计是:

P ( X ( j ) = a j l ∣ Y = c k ) = ∑ i = 1 N I ( x i ( j ) = a j l , y i = c k ) ∑ i = 1 N I ( y i = c k ) P(X^{(j)}=a_{jl}|Y=c_k)=\frac{\sum_{i=1}^NI(x_i^{(j)}=a_{jl},y_i=c_k)}{\sum_{i=1}^NI(y_i=c_k)} P(X(j)=ajl∣Y=ck)=∑i=1NI(yi=ck)∑i=1NI(xi(j)=ajl,yi=ck)(2)对于给定的 x = ( x ( 1 ) , x ( 2 ) . . . . x ( n ) ) x=(x^{(1)},x^{(2)}....x^{(n)}) x=(x(1),x(2)....x(n))计算

P ( Y = c k ) ∏ j = 1 n P ( X ( j ) = x ( j ) ∣ Y = c k ) P(Y=c_k) \prod_{j=1}^nP(X^{(j)}=x^{(j)}|Y=c_k) P(Y=ck)j=1∏nP(X(j)=x(j)∣Y=ck)

(3)确定x的类

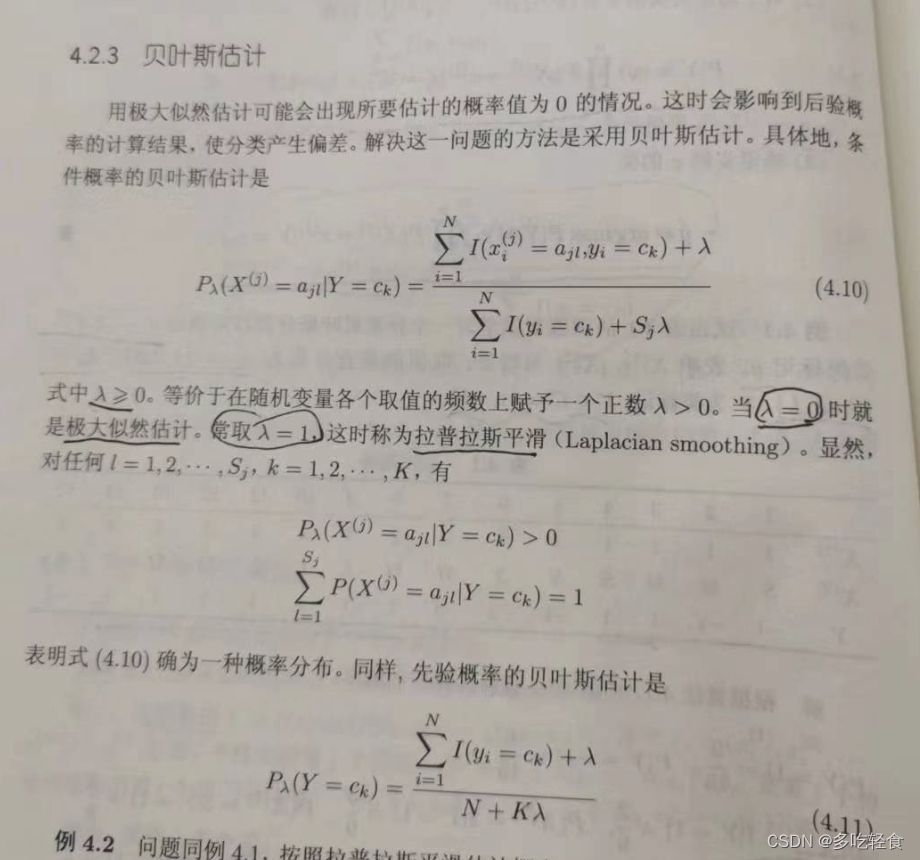

y = arg max c k P ( Y = c k ) ∏ j = 1 n P ( X ( j ) = x ( j ) ∣ Y = c k ) y=\arg \max_{c_k} P(Y=c_k) \prod_{j=1}^n P(X^{(j)}=x^{(j)}|Y=c_k) y=argckmaxP(Y=ck)j=1∏nP(X(j)=x(j)∣Y=ck)四、贝叶斯估计

总结

今天的内容是统计学习方法的第一章节,挺容易理解的,结合模型图理解更加方便

-

相关阅读:

KafKa C++实战

ROS SMACH个人学习记录

SpringBoot(三)缓存

“图”学习提纲

适用于现代制造业的ERP系统有哪些?

《Spring Security 简易速速上手小册》第4章 授权与角色管理(2024 最新版)

java智慧农贸商户设备检测系统ssm-springboot

混沌工程测试工具:chaosblade:基础命令

某大型房地产公司绩效面谈项目成功案例纪实

vue3中hooks的介绍及用法

- 原文地址:https://blog.csdn.net/weixin_46034279/article/details/138079952