-

spark性能调优 | 内存优化

我们先了解一下有哪些内存

1.storage内存 存储数据,缓存 可预估 2.shuffle内存 计算join groupby 不可预估 spark1.6之前 静态管理的,spark1.6之后变成动态管理 默认0.5- 1

- 2

- 3

温馨提示

在公司尽量不要写rdd(性能不好)

RDD示范(spark版本2.1.1)

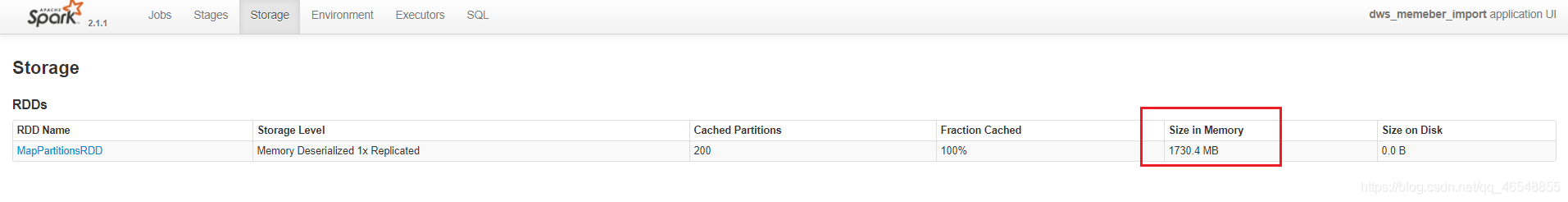

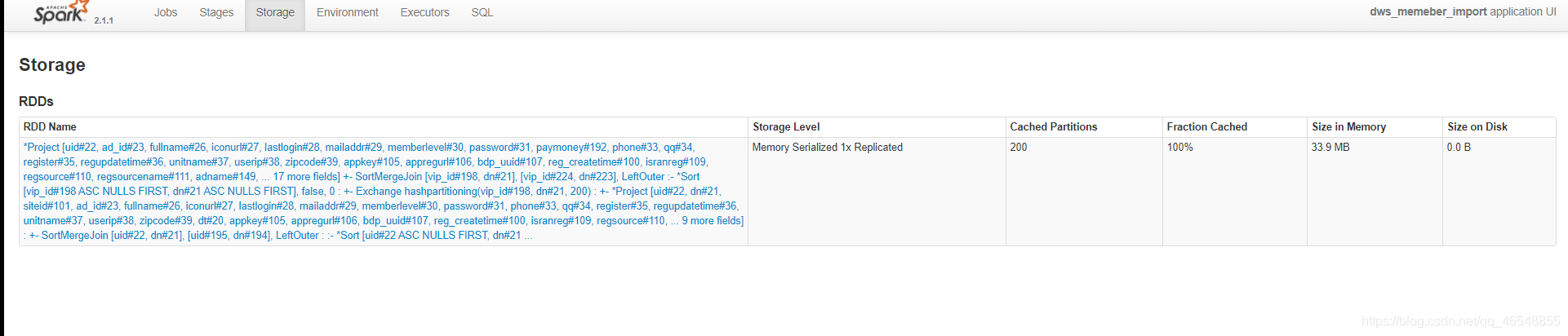

我们转成rdd去跑任务,看看内存占有多大

我们也可以去excutor看内存大小

显示红色,是因为我写了while循环

RDD进行优化

看官网

https://spark.apache.org/docs/2.4.5/configuration.html#compression-and-serialization

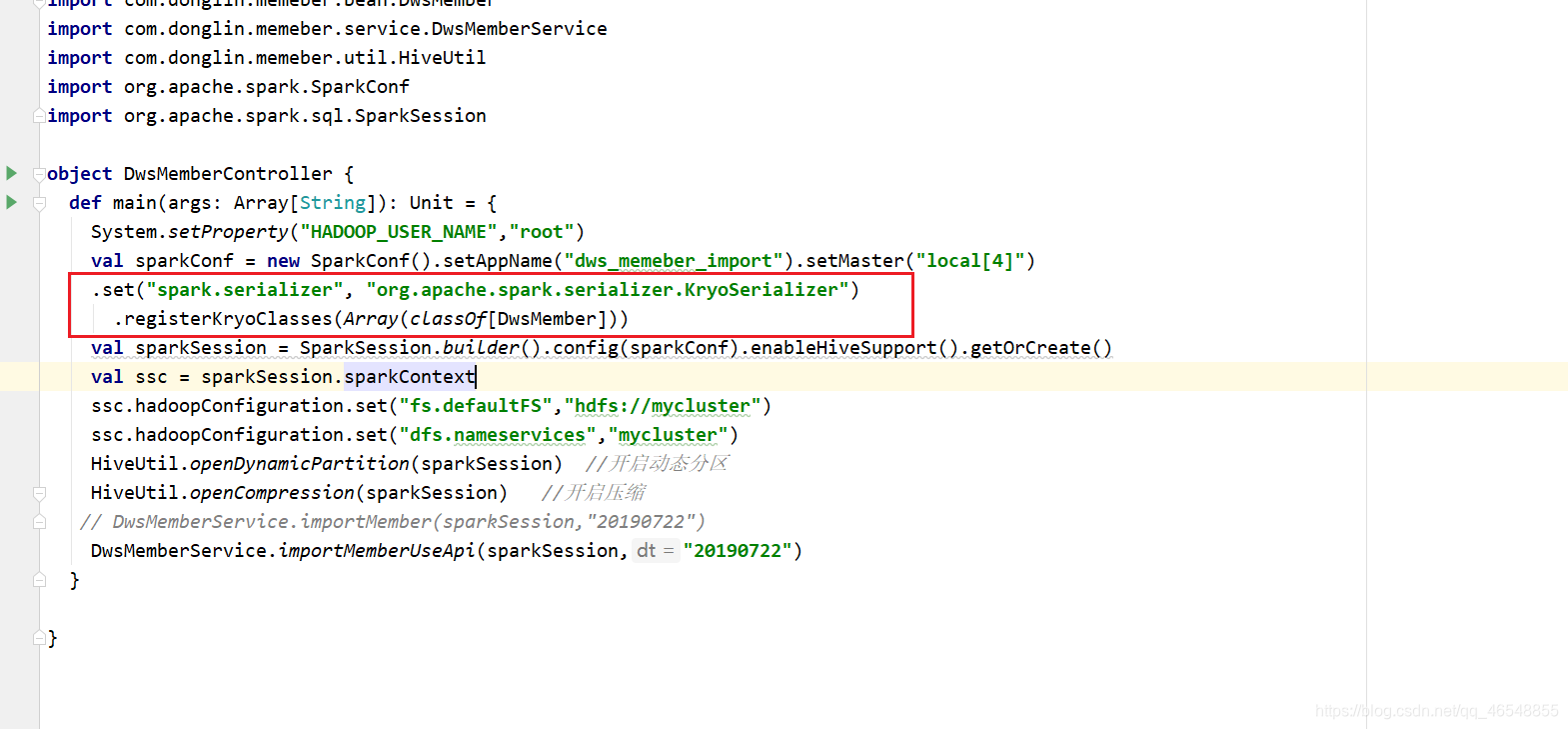

我们采用kryo(只支持rdd)

我们需要看看rdd的缓存级别

https://spark.apache.org/docs/2.4.5/rdd-programming-guide.html#which-storage-level-to-choose

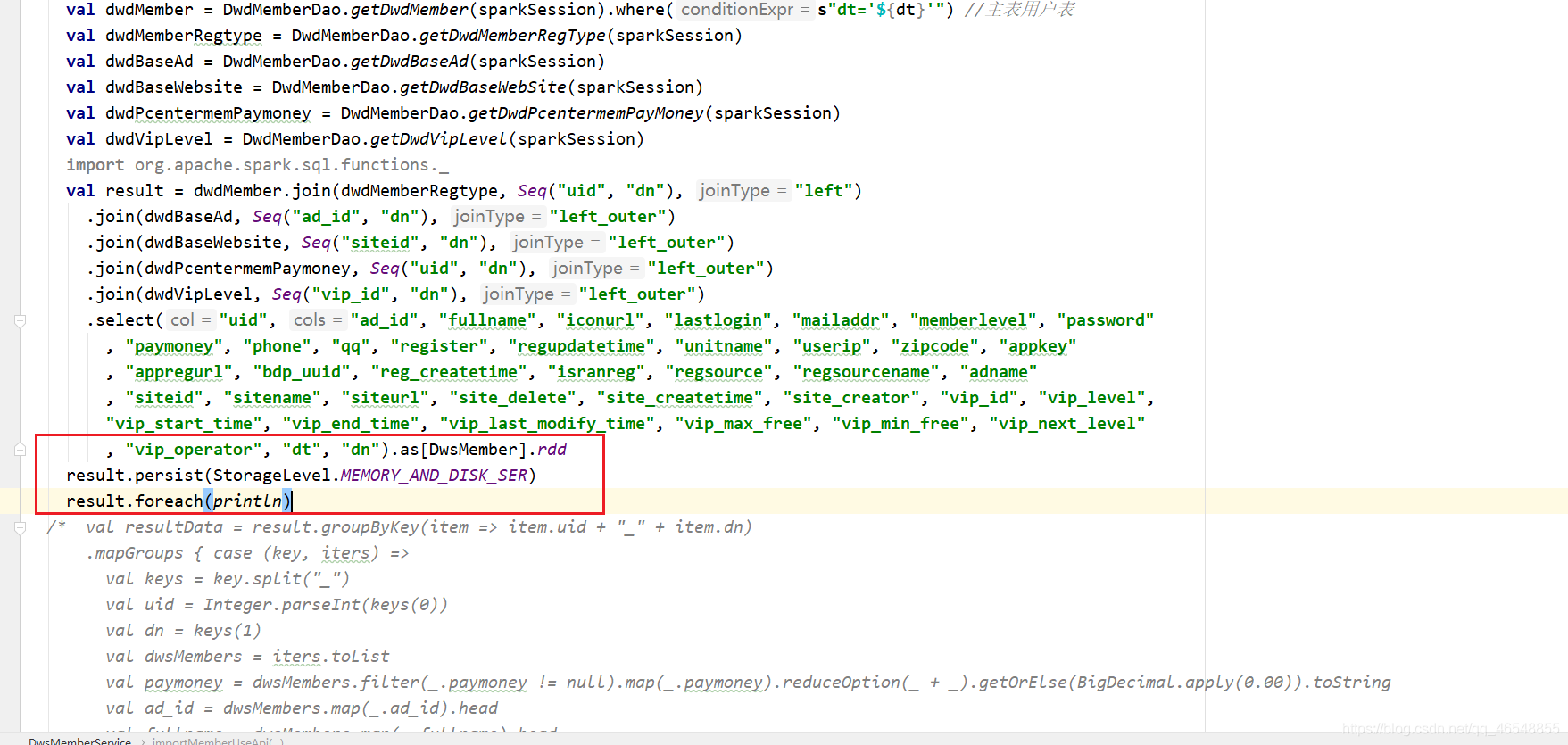

使用序列化的缓存级别

发现1.7g直接变成了270m,优化还是挺大的!

Df和Ds进行示范

看官网

https://spark.apache.org/docs/2.4.5/sql-getting-started.html#creating-datasets

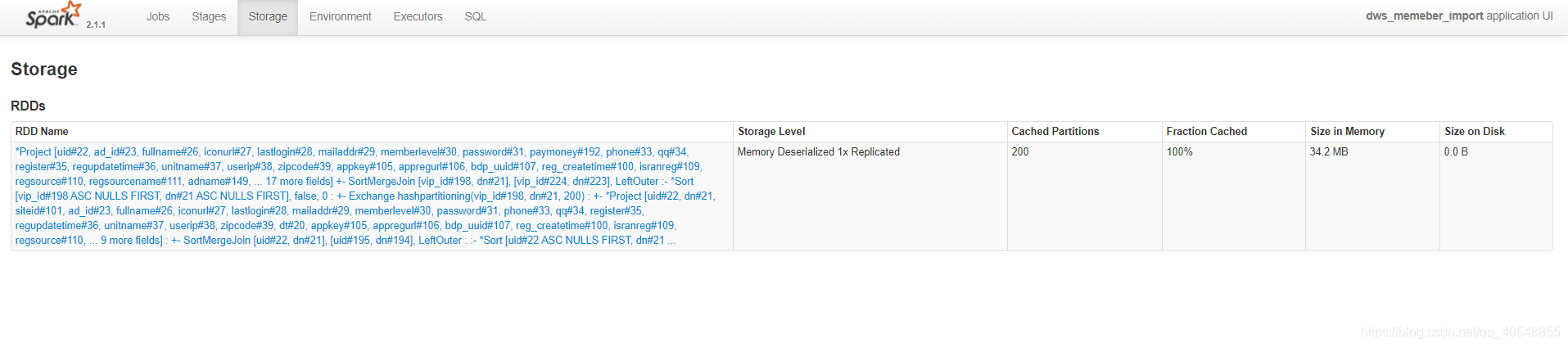

Ds会专门使用自己的偏码进行序列化

内存大小34.2M

我们还可以进行序列化(变化不大)

进行优化之后33.9M

-

相关阅读:

使用Oracle SQL Developer管理Oracle Database Express Edition (XE)

js--处理object的常用方法

MACday1

TCP缓存

【2023年11月第四版教材】第19章《配置与变更管理》(合集篇)

创意电子学-小知识:晶体管

集成随机惯性权重和差分变异操作的樽海鞘群算法-附代码

Pod 管理与使用

lua C++循环引用导致的内存泄露及解决方案

4.Android应用架构指南:概览

- 原文地址:https://blog.csdn.net/qq_46548855/article/details/112533018