-

2023-11 | 短视频批量下载/爬取某个用户的所有视频 | Python

这里以鞠婧祎的个人主页为demo

https://www.douyin.com/user/MS4wLjABAAAACV5Em110SiusElwKlIpUd-MRSi8rBYyg0NfpPrqZmykHY8wLPQ8O4pv3wPL6A-oz

【2023-11-4 23:02:52 星期六】可能后面随着XX的调整, 方法不再适用, 请注意

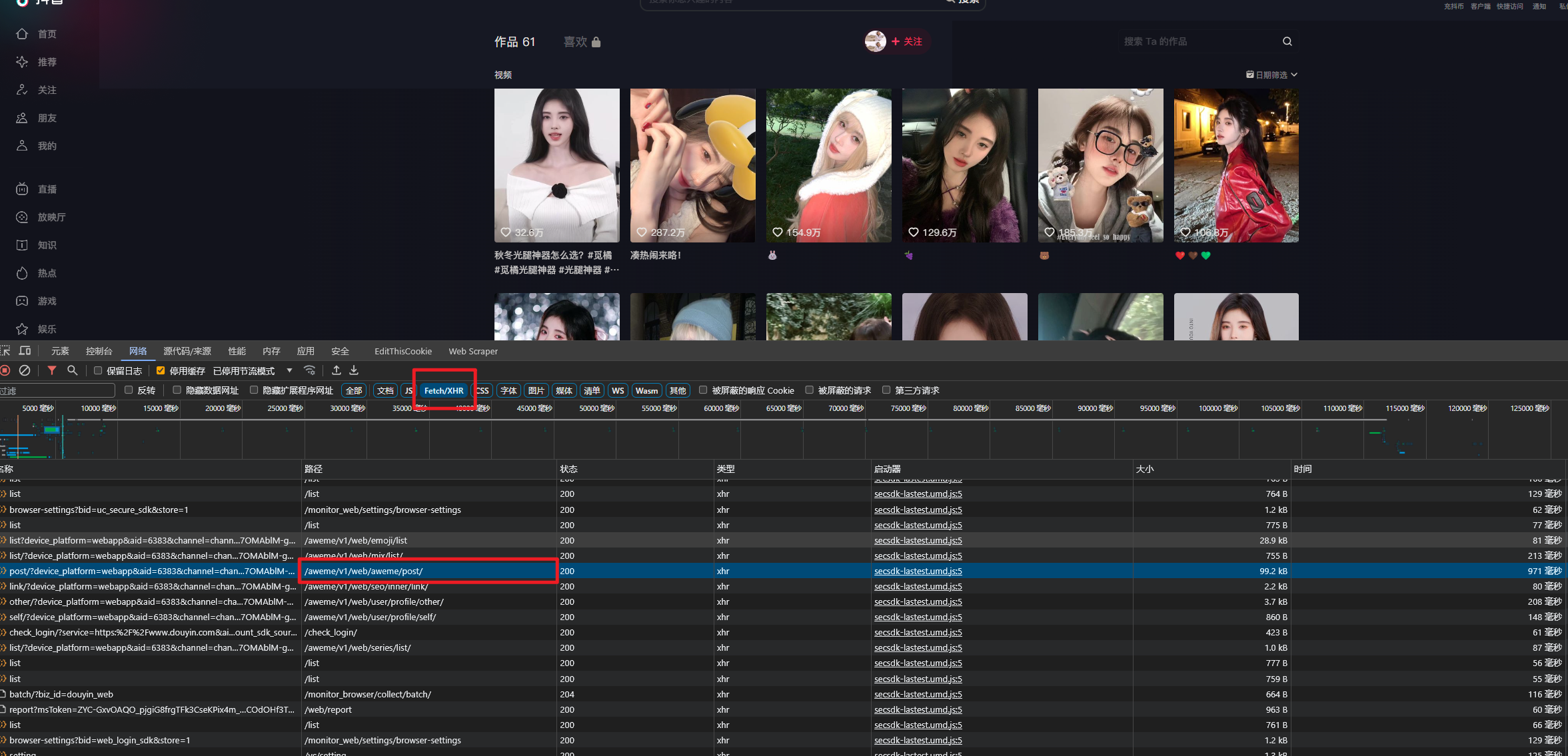

找到接口

找到

/aweme/v1/web/aweme/post/路劲的接口

预览响应数据, 应该是能跟所发布视频的描述所对应的就OK, 但是只只有18条数据

余下的数据, 滚动进度条的时候就会出来了

接口整整37个参数, 随便改一个都会导致请求不到数据(返回状态码200, 但就是没数据), 没想到解决办法…

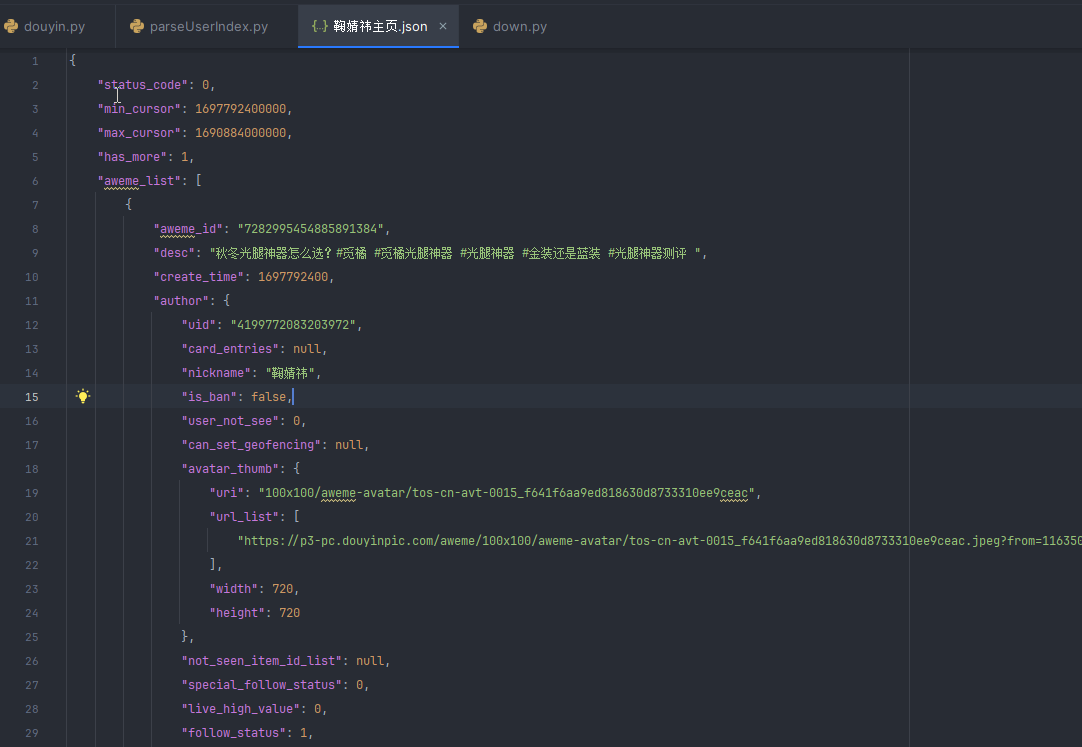

将返回的数据保存到json文件中

下载视频

import requests import json import os # todo 错误处理 def download_video(url, path): print('\n开始下载视频...', path.split('/')[-1]) r = requests.get(url, stream=True) with open(path, 'wb') as f: # 进度条 total_length = int(r.headers.get('content-length')) print('视频大小:', total_length) for chunk in r.iter_content(chunk_size=1024 * 1024): if chunk: f.write(chunk) # 打印进度条 print('\r' + '[下载进度]:%s%.2f%%' % ( '>' * int((f.tell() / total_length) * 50), float(f.tell() / total_length) * 100), end='') index = 0 # json_file, 接口返回的json文件位置 # save_file_dir, 保存视频的文件夹路径 def save_video_batch(json_file, save_file_dir): global index if not os.path.exists(save_file_dir): os.makedirs(save_file_dir) # 读取json文件 with open(json_file, 'r', encoding='utf-8') as f: json_data = json.load(f) aweme_list = json_data['aweme_list'] for aweme in aweme_list: video_url_list = aweme['video']['play_addr']['url_list'] video_name = aweme['desc'] # 一个视频有三个地址, 成功一个就break index += 1 for video_url in video_url_list: # print(video_url) try: download_video(video_url, f'{save_file_dir}{index}-{video_name}.mp4') break except Exception as e: print('下载失败') save_video_batch('../params/鞠婧祎主页.json', '../data/鞠婧祎主页/')- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

下载结果

尝试直接去获取html页面, 解析html页面, 但是获取的html页面并不是实际浏览器中浏览的页面(不是验证码界面我看了)

请求接口也是, API调试工具中能请求到, 但是使用代码就不行了, 也是返回200状态, 但是没有数据, 下面是代码, 不知道缺了什么

响应200但是没有数据, 试试param参数使用拼接到url后面的形式, 避免=被转义%3D

(有些敏感的数据, 需要自己替换)现在的方法还很麻烦, 有待改进,

设想我只需要输入主页的url地址, 比如

https://www.douyin.com/user/MS4wLjABAAAACV5Em110SiusElwKlIpUd-MRSi8rBYyg0NfpPrqZmykHY8wLPQ8O4pv3wPL6A-oz, 自动下载主页中所有视频【2023-11-7 17:02:20 星期二】

已经改进了, 只需输入 主页的url地址, 即可下载视频

演示视频: https://www.抖印.com/video/7298386922798468406抖印 换成 douyin 即可, 直接写抖音审核不过…

源码: https://githubfast.com/tiam-bloom/DouyinSpider

【2024-1-17 19:06:34 星期三】

msToken, x-bogus咋用?

分页参数# _*_ coding : UTF-8 _*_ # @Time : 2024/1/16 13:38 # @Auther : Tiam # @File : second_page # @Project : DouyinSpider # @Desc : 作品请求逻辑测试 from urllib.parse import urlencode, urlparse import requests from v2.signature import Signature cookies = { 'ttwid': '1%7Cxxxxxxxx', } headers = { 'referer': 'https://www.douyin.com/user/MS4wLjABAAAArcoz8pyUJSASISQnP_JMfUgNATaCTOJJzQsG6HSzeAU?vid=7313558967433694498', 'user-agent': 'xxxxxxxxxx', } params = ( ('device_platform', 'webapp'), ('aid', '6383'), ('channel', 'channel_pc_web'), ('sec_user_id', 'MS4wLjABAAAArcoz8pyUJSASISQnP_JMfUgNATaCTOJJzQsG6HSzeAU'), ('max_cursor', '1698760139000'), # 第一页 => 0, 其他页 => 前一页返回的max_cursor字段; 第二页: 1702216896000, 第三页: 1698760139000 # ('locate_item_id', '7313558967433694498'), # 可选参数, 用于定位视频, 一般不用 ('locate_query', 'false'), ('show_live_replay_strategy', '1'), ('need_time_list', '0'), # 第一页 => 1, 其他页 => 0 ('time_list_query', '0'), ('whale_cut_token', ''), ('cut_version', '1'), ('count', '18'), # 120 or 18 ('publish_video_strategy_type', '2'), ('pc_client_type', '1'), ('version_code', '170400'), ('version_name', '17.4.0'), ('cookie_enabled', 'true'), ('screen_width', '1707'), ('screen_height', '1067'), ('browser_language', 'zh-CN'), ('browser_platform', 'Win32'), ('browser_name', 'Edge'), ('browser_version', '120.0.0.0'), ('browser_online', 'true'), ('engine_name', 'Blink'), ('engine_version', '120.0.0.0'), ('os_name', 'Windows'), ('os_version', '10'), ('cpu_core_num', '16'), ('device_memory', '8'), ('platform', 'PC'), ('downlink', '10'), ('effective_type', '4g'), ('round_trip_time', '100'), ('webid', 'xxx'), ('msToken', Signature.gen_ms_token()), ) encode_params = urlencode(params, safe='=') url = 'https://www.douyin.com/aweme/v1/web/aweme/post/?' + encode_params # 生成 X-Bogus xbogus = Signature.gen_xbogus(url, headers['user-agent']) url = url + '&X-Bogus=' + xbogus # 解析url参数 query = urlparse(url).query print(query) response = requests.get(url, headers=headers, cookies=cookies) print(response.status_code) if response.status_code != 200: print('请求失败') exit(0) # 存入文件 with open('second_page.json', 'w', encoding='utf-8') as f: f.write(response.text)- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

- 60

- 61

- 62

- 63

- 64

- 65

- 66

- 67

- 68

- 69

- 70

- 71

- 72

- 73

- 74

- 75

- 76

- 77

- 78

请把

webid,UA,ttwid改一下 -

相关阅读:

基于kolla的openstack在线变更网卡(bond)

3.7-3.11特殊数据结构

ping数据包中的进程号

打印机语言监视器

2023中国民航大学计算机考研信息汇总

Pytorch模型model&data.to(device) | .cuda | .cpu()

C++使用nlohmann的简单示例

github.com不能访问原因不是因为DNS,而是因为故意间歇性抽风,可改用镜像站

竞赛选题 基于机器视觉的行人口罩佩戴检测

解决微信小程序(uniapp)中无法读取本地音频问题

- 原文地址:https://blog.csdn.net/qq_50969362/article/details/134225161