-

卷积网络的发展历史-LeNet

简介

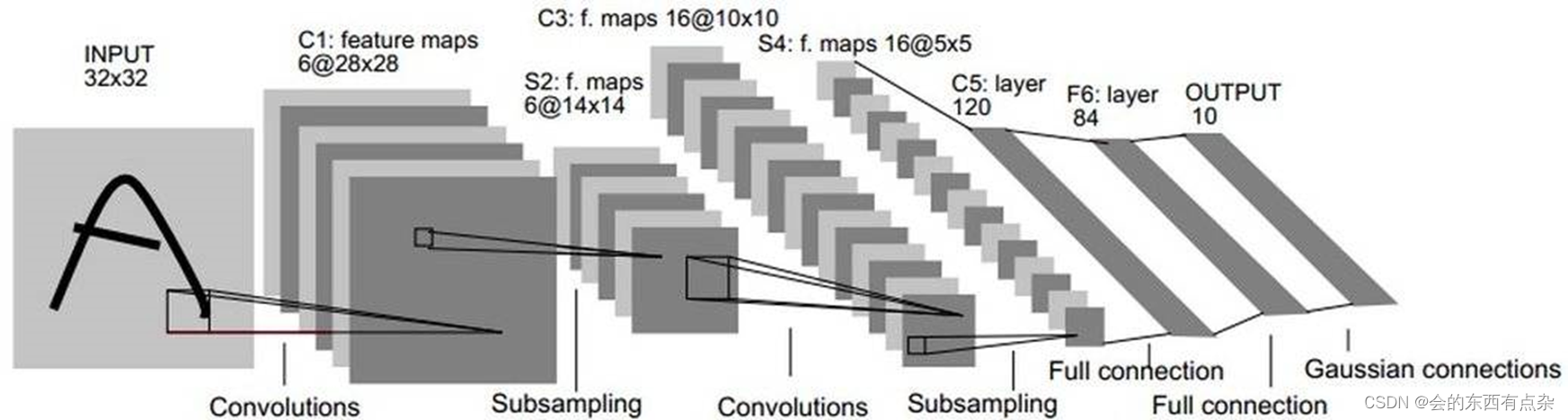

LeNet是CNN结构的开山鼻祖,第一次定义了卷积神经网络的结构。

LeNet模型包含了多个卷积层和池化层,以及最后的全连接层用于分类。其中,每个卷积层都包含了一个卷积操作和一个非线性激活函数,用于提取输入图像的特征。池化层则用于缩小特征图的尺寸,减少模型参数和计算量。全连接层则将特征向量映射到类别概率上。

特点

LeNet 的特点如下所示:

(1)定义了卷积神经网络(Convolutional Neural Network, CNN)的基本框架:卷积层+池化层(Pooling Layer)+全连接层;

(2)定义了卷积层(Convolution Layer),与全连接层相比,卷积层的不同之处有两点:局部连接(引进“感受野”这一概念)、权值共享(减少参数数量),卷积计算公式:

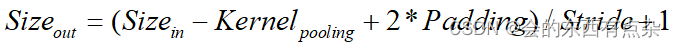

(3)利用池化层进行下采样(Downsampooling),从而减少计算量,池化计算公式:

(4)用tanh作为非线性激活函数(现在看到的都是改进过的LeNet了,用ReLu代替 tanh。相较于sigmoid,tanh以原点对称(zero-centered),收敛速度会快。

python实例

- import tensorflow as tf

- def lenet_model():

- inputs = tf.placeholder(tf.float32, shape=[None, 28, 28, 1])

- conv1 = tf.layers.conv2d(inputs=inputs, filters=6, kernel_size=(5, 5), strides=(1, 1), padding='valid', activation=tf.nn.relu)

- pool1 = tf.layers.max_pooling2d(conv1, (2, 2), strides=(2, 2))

- conv2 = tf.layers.conv2d(inputs=pool1, filters=16, kernel_size=(5, 5), strides=(1, 1), padding='valid', activation=tf.nn.relu)

- pool2 = tf.layers.max_pooling2d(conv2, (2, 2), strides=(2, 2))

- flatten = tf.layers.flatten(pool2)

- dense1 = tf.layers.dense(flatten, 120, activation=tf.nn.relu)

- dense2 = tf.layers.dense(dense1, 84, activation=tf.nn.relu)

- logits = tf.layers.dense(dense2, 10)

- return inputs, logits

-

相关阅读:

探寻欧洲市场的机遇:深度剖析欧洲跨境电商

聚观早报 | 东方甄选与顺丰、京东合作;拼多多跨境电商平台上线

linux内核initcall放置在各个section中函数执行流程

7款最佳的图片编辑App

qt qml中listview出现卡顿情况时的常用处理方法

Pruning Pre-trained Language Models Without Fine-Tuning

EMD、EEMD、FEEMD、CEEMDAN分解的对比(其中CEEMDAN分解可以有效消除模态分解)

线程的控制与同步

LeetCode 2455. Average Value of Even Numbers That Are Divisible by Three【数学】简单

Qt国际化翻译解决方案

- 原文地址:https://blog.csdn.net/qq_20660115/article/details/133610746