-

趋动云GPU云平台部署ChatGLM-6B

目录

ChatGLM-6B是什么?

ChatGLM-6B是一个基于GLM的生成式对话模型。由清华大学团队开发,旨在改进对话机器人的生成质量和逻辑。

模型部署

模型部署过程按照Dtatawhale文档给出的教程就可以。

如何用免费GPU线上跑AI项目实践 - 飞书云文档 (feishu.cn)

Step1. 创建项目并上传代码

-

进入趋动云用户工作台,选择:当前空间,请确保当前所在空间是注册时系统自动生成的空间。

-

点击:快速创建,选择创建项目,创建新项目。

-

填写相关的项目信息,镜像及数据集选择如下。

-

项目名称:可自定义,如 “ChatGLM2-6B广告文案创作”。

-

代码:选择 本地代码。

-

镜像:选择 官方 镜像 PyTorch 2.0.0。

-

数据:选择 社区 > 全部 下的 AdvertiseGen 数据集;再选择 公开 下的 chatglm2-6b(作者为 “趋动云小助手”)。

4. 单击 创建,创建成功,同时弹出 上传代码 框。

5. 点击已获取的代码 (opens new window)下载压缩包,然后直接拖拽至 “上传代码” 框中,随后单击 “确定”。

Step2. 环境准备

-

左侧导航栏选择 开发,随后单击 初始化开发环境实例。

-

资源配置选B1.large,镜像中先点x,再点添加镜像,选择 公开 中的 ChatGLM2-6B_PyTorch2.0.1(作者为“趋动云小助手”),然后点击确认

-

点击添加端口,内部端口数字可自由填写,如77。确认无误后,点击右下角的确认

-

环境初始化好以后,点击进入开发环境

-

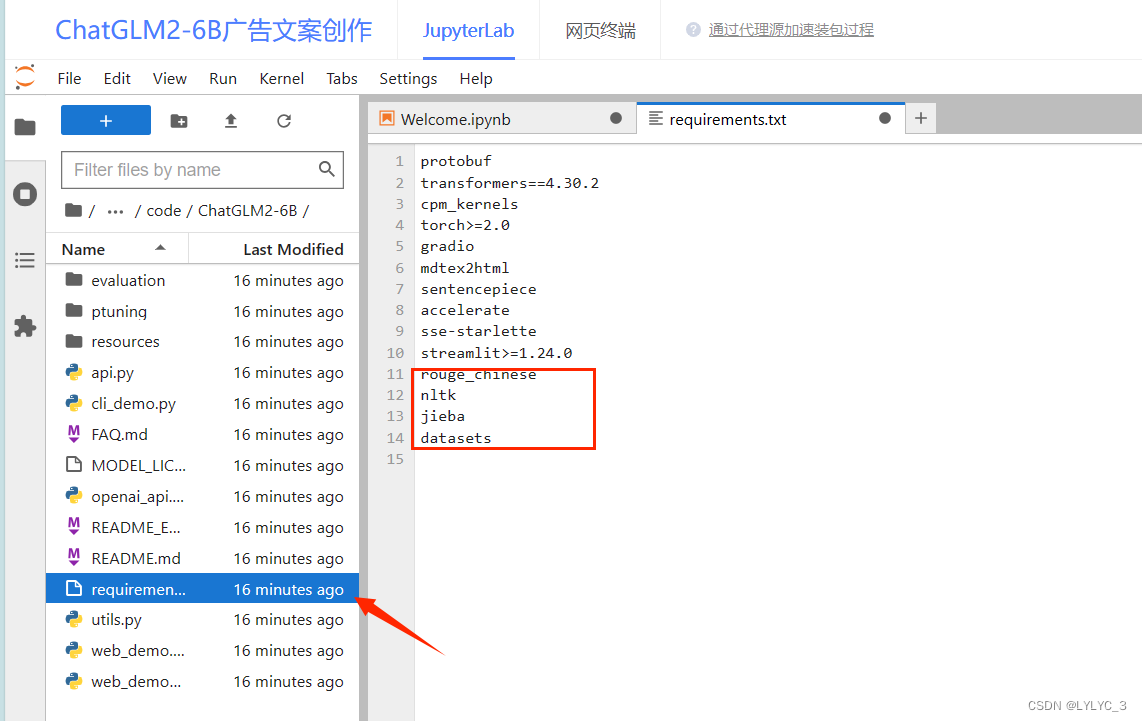

左侧目录进入 ChatGLM2-6B/requirements.txt,增加如下内容并保存:

rouge_chinese

nltk

jieba

datasets

6. 切换至网页终端,并执行如下命令。等待约 1-2 分钟执行完,执行过程中无

error报错,则安装成功。pip install -r ChatGLM2-6B/requirements.txt -i https://pypi.virtaicloud.com/repository/pypi/simple

Step3. 加载模型

以命令行形式加载模型并进行问答测试,来确认环境是否准备成功。

-

切换至 JupyterLab。修改 cli_demo.py 中模型的地址,将

THUDM/chatglm2-6b替换为/gemini/data-2(即模型实际挂载到环境的地址)

-

切换至 网页终端。执行如下命令唤醒交互式对话。等待最终

Loading checkpoint shards: 100%且返回用户:字样。。python ChatGLM2-6B/cli_demo.py - 在

用户:行输入您的问题并回车,等待 ChatGLM 回答您的问题。ChatGLM:行若有相应信息返回,则成功。

-

-

相关阅读:

synchronized关键字详解-偏向锁、轻量级锁、偏向锁、重量级锁、自旋、锁粗化、锁消除

ChatGPT:SQL 逻辑运算符的优先级和运算顺序解释

第20章 使用Spring进行事务管理(一)

My-cmsms 靶机

Object.prototype.toString.call()的原理

栈 之 如何实现一个栈

微软Build 2023两大主题:Copilots和插件

单调栈的性质和使用场景

岩藻多糖-聚已内酯 Fucoidan-PCL 聚已内酯-PEG-岩藻多糖

如何实现浏览器标签页之间的通信

- 原文地址:https://blog.csdn.net/LYLYC_3/article/details/133325280