-

elasticsearch2-es和kibana的安装

个人名片:博主:酒徒ᝰ.

个人简介:沉醉在酒中,借着一股酒劲,去拼搏一个未来。

本篇励志:三人行,必有我师焉。

本项目基于B站黑马程序员Java《SpringCloud微服务技术栈》,SpringCloud+RabbitMQ+Docker+Redis+搜索+分布式【SpringCloud+RabbitMQ+Docker+Redis+搜索+分布式,系统详解springcloud微服务技术栈课程|黑马程序员Java微服务】 点击观看

一、初识elasticsearch

4. 安装es、kibana

参考课前资料:

安装elasticsearch.md

准备工作:

部署网络docker network create es-net- 1

安装elasticsearch

- 导入资料

将资料中的es.tar复制到虚拟机 - 解压文件

docker load -i es.tar- 1

- 运行

docker run -d \ --name es \ -e "ES_JAVA_OPTS=-Xms512m -Xmx512m" \ -e "discovery.type=single-node" \ -v es-data:/usr/share/elasticsearch/data \ -v es-plugins:/usr/share/elasticsearch/plugins \ --privileged \ --network es-net \ -p 9200:9200 \ -p 9300:9300 \ elasticsearch:7.12.1- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 查看

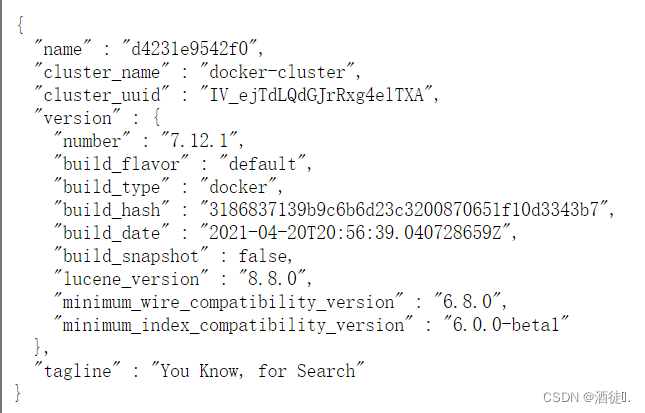

浏览器输入ip地址+端口号(9200)

安装kibana

- 导入资料

将资料中的kibana.tar复制到虚拟机 - 解压文件

docker load -i kibana.tar- 1

- 运行

docker run -d \ --name kibana \ -e ELASTICSEARCH_HOSTS=http://es:9200 \ --network=es-net \ -p 5601:5601 \ kibana:7.12.1- 1

- 2

- 3

- 4

- 5

- 6

- 查看

浏览器输入IP地址+端口号(5601)

注意:

这个进入会比较慢,可以多等一会。

当出现这个标志是,可能是还未加载完成,需要再等一会。分词器

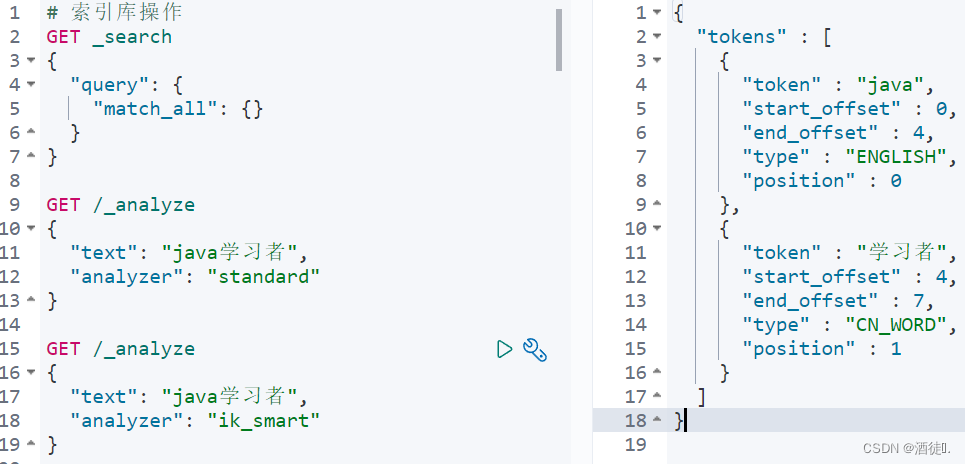

在es中,默认的分词对中文不是很友好,几乎都是分成单个词。

安装ik分词器:

- 查看es在plugins目录中的位置。

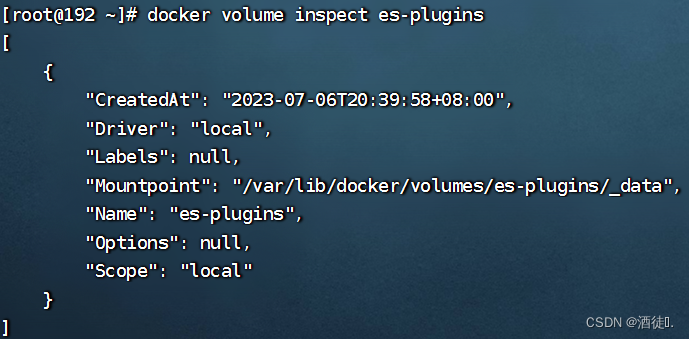

docker volume inspect es-plugins- 1

可以看出es被挂载到了/var/lib/docker/volumes/es-plugins/_data位置- 将资料中的ik文件夹复制到虚拟机相应的位置,即/var/lib/docker/volumes/es-plugins/_data中

- 重启es

docker restart es- 1

-

测试

-

扩展词典

使用ik分词器后有一些分词仍然没有很好地分开,这些新的词就需要我们自己添加

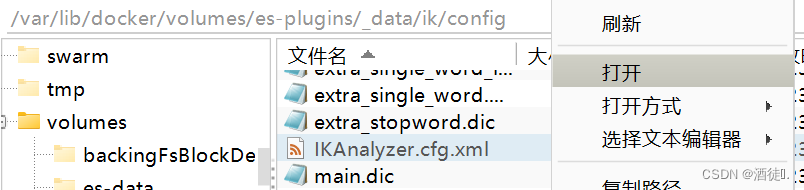

打开相应文件:

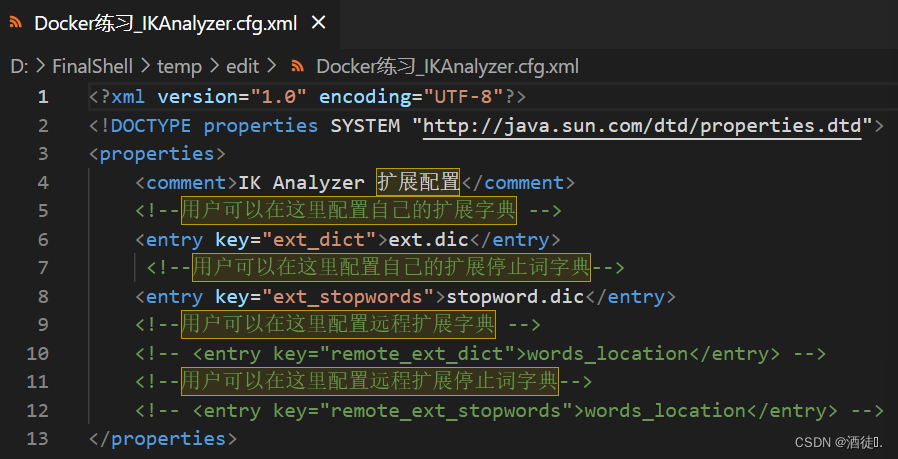

在相应位置添加自定义文件名

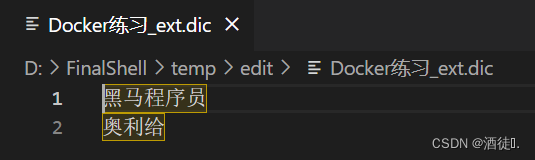

建立相应文件ext.dic(新词)和stopword.dic(禁用词),在其中添加新词语。

重启es。

再次查找是就可以使用了

总结

分词器的作用是什么?

- 创建倒排索引时对文档分词

- 用户搜索时,对输入的内容分词

IK分词器有几种模式?

- ik_smart:智能切分,粗粒度

- ik_max_word:最细切分,细粒度

IK分词器如何拓展词条?如何停用词条?

- 利用config目录的IkAnalyzer.cfg.xml文件添加拓展词典和停用词典

- 在词典中添加拓展词条或者停用词条

-

相关阅读:

chap8-fluent python

Xlua在unity中使用luaide打断点

【面试经典150 | 哈希表】单词规律

【Docker】Compose容器编排:微服务实战

Webmin(CVE-2019-15107)远程命令执行漏洞复现

Inno Setup 选择安装路径的问题

刷题记录(NC235267 星球大战,NC216012 Let‘s Play Curling,NC235294 任务,NC235569 牛可乐与NCPC)

mac 版本 Lightroom Classic 2024 正式版来了 七个有趣的新功能值得更新

关于2022年9月以太坊合并你需要知道的10件事

Pytorch教程

- 原文地址:https://blog.csdn.net/m0_65144570/article/details/132927910