-

yolov5剪枝实战1: 论文及yolov5剪枝实战项目介绍

本系列博客介绍yolov5剪枝方法1. 介绍

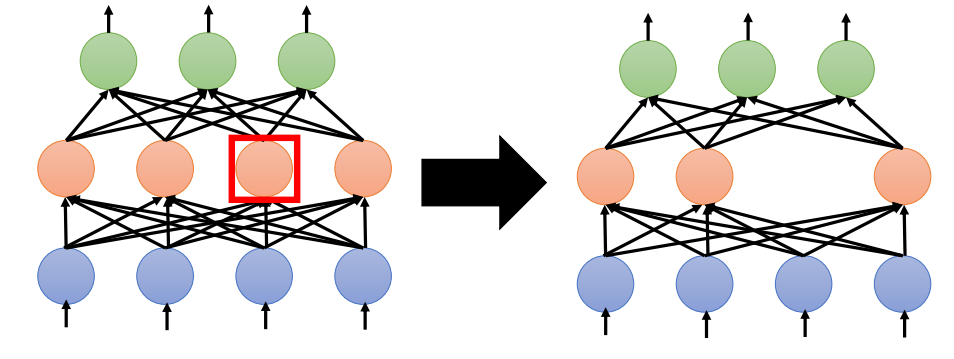

神经网络一般都存在过

参数化(over-parameterized)的问题,存在冗余的神经元或权重,所以可以进行剪枝。

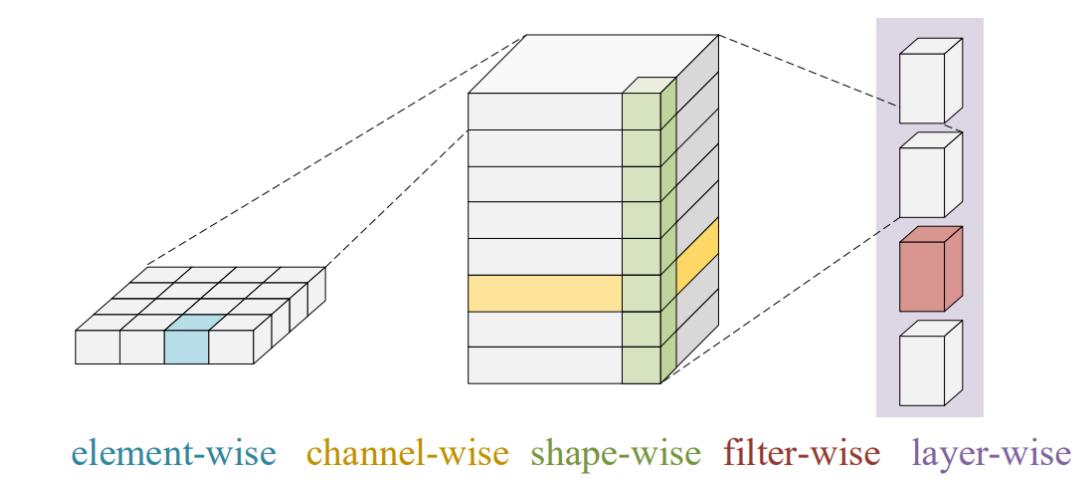

其实对网络可以针对不同的颗粒度进行剪枝,可以进行权重、神经元级别的剪枝,也可以基于channel, shape,filter以及layer级别的剪枝。

如果对element-wise级别的剪枝会导致非结构化的网络剪枝,所以我们研究的重点是结构化的剪枝方法。2. Network Slimming剪枝的原理

Network Sliming就是一种结构化的网络剪枝方法,论文发表于ICCV 2017, 论文的题目是:Learning Efficient Convolutional Networks through Network Slimming,它是一种实用高效的通道级别的结构化剪枝方法。

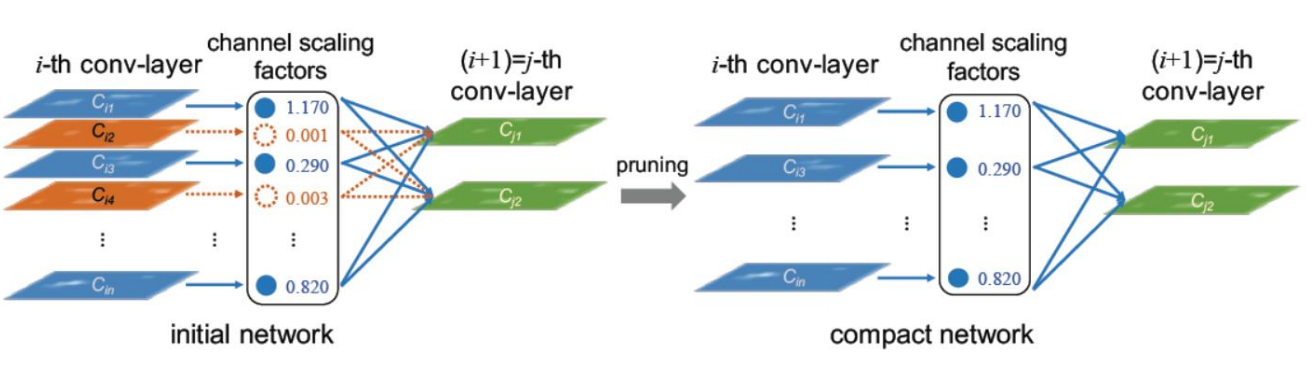

- 它利用BN层的缩放因子,将缩放因子与卷积层中的每个通道相关联。

- 在训练期间对这些缩放因子施加稀疏正则化,就可以自动识别不重要的通道。在上图的示意图中橙色的Channel的缩放因子

scale factor就比较小,这种通道就会认为不重要的通道,就会被剪掉。剪枝以后,就能得到更加精简的网络模型。 - 剪枝后,获得紧凑的模型,然后对其进行

微调finetune以达到与正常训练网络相当的精度。

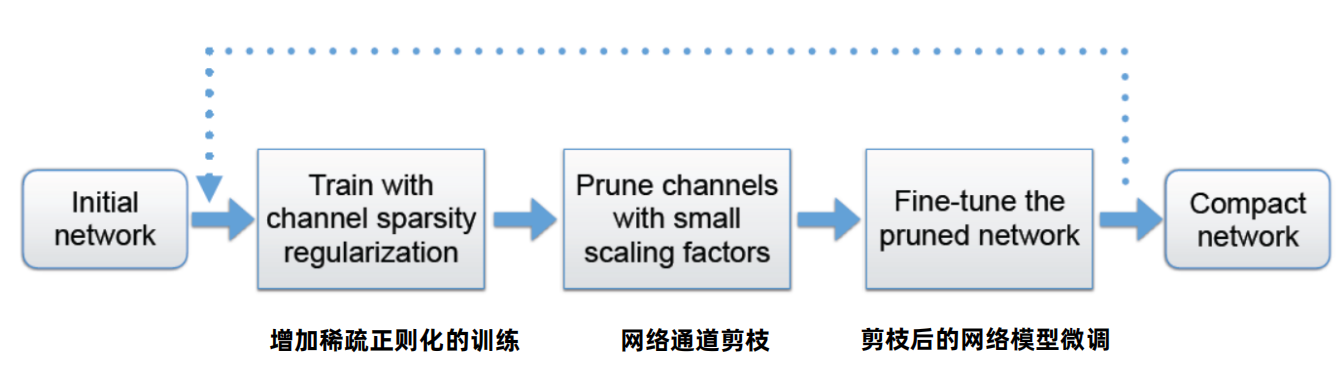

2. 1 剪枝步骤

2. 2 稀疏训练

- 首先对基准模型,进行稀疏化正则训练,然后对scale factor小的通道进行剪枝,剪枝后进行fine-tune训练,对剪枝后的网络进行微调。

- 中间的稀疏化训练、通道剪枝、fine-tune这3个步骤可以进行多次循环迭代

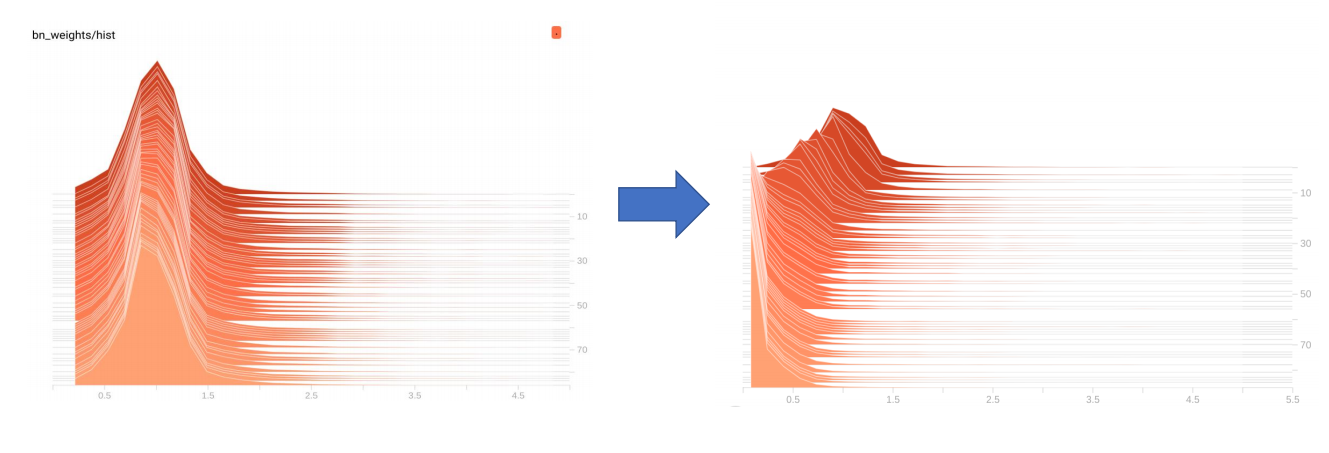

上图可以看出,正常训练如果我们不施加L1正则化训练的话,训练结束后的BN层的scale factor(gamma)分布近似正态分布,无法进行剪枝。

采用稀疏化训练以后,随着epoch的增加,越来越多的gamma逼近0,所以稀疏训练是非常关键的,在此基础上我们可以裁剪比较小的gamma值所对应的通道。

2. 3 剪枝后的性能

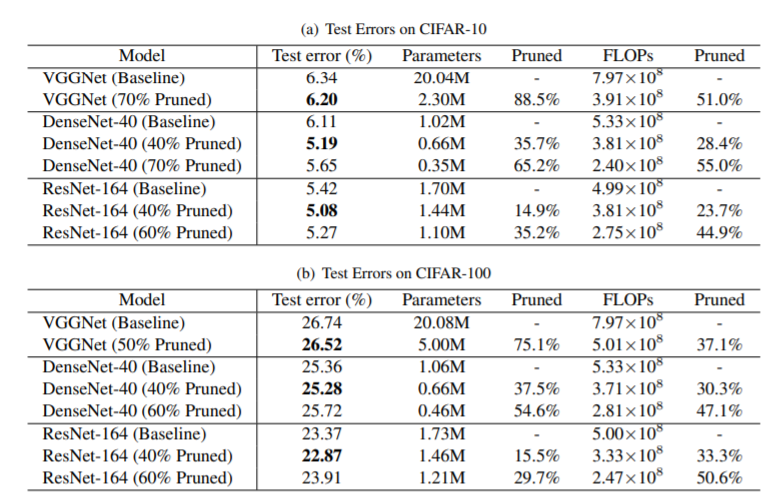

论文中作者证明了剪枝后的网络性能具有良好的表现,作者尝试了VggNet,DenseNet,ResNet,可以看到对ResNet进行了40%,60%的剪枝,它的Test error反而有所降低。它的Parameters大大的减少,它的运算量Flops也有所减少。

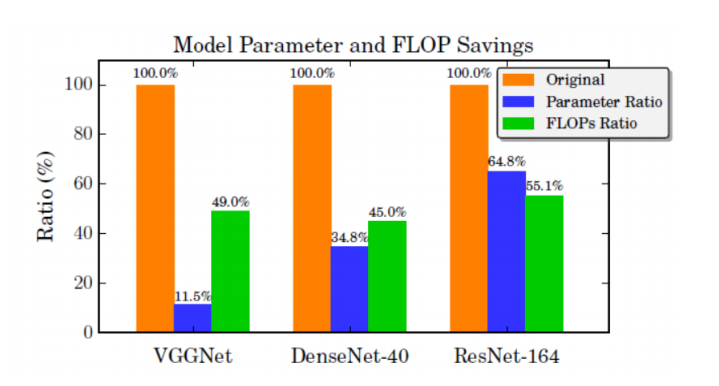

这里对比了不同网络剪枝后,网络的参数量和Flops降低的比率,所以效果还是比较显著的3. yolov5剪枝实战项目介绍

3.1 项目介绍

本项目利用yolov5对足球数据集进行训练,并进行Network Slimming剪枝,本系列博客主要包括以下内容。

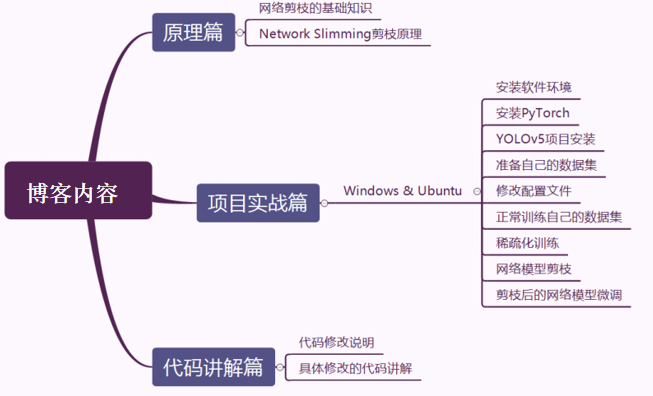

具体内容包括:原理篇、实战篇、代码讲解篇,在原理篇将介绍网络剪枝的基础知识及Network Slimming的剪枝原理,在项目实战中包括windows和ubantu系统中项目代码的讲解。在代码讲解篇将说明针对网络剪枝代码的修改以及具体哪些代码进行了修改。3.2 Yolov5s剪枝效果

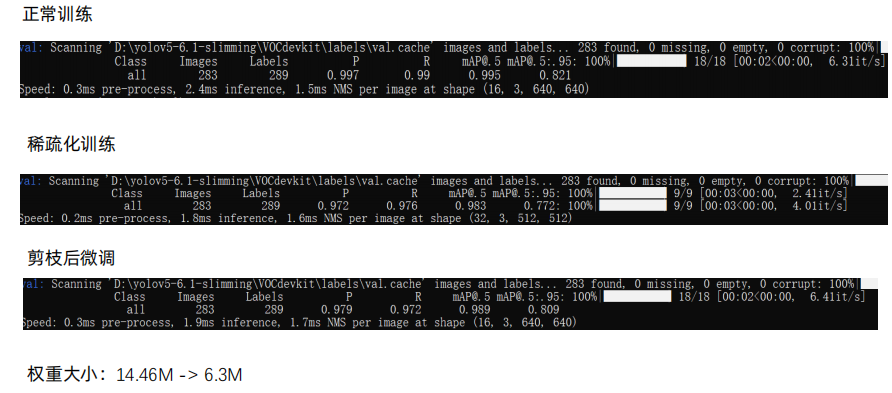

在项目实战中,我们对yolov5s网络进行了剪枝,我们会得到正常训练模型的性能,包括precision,recall,mAP以及推理时间。然后我们再进行稀疏化训练得到它的性能指标,然后再剪枝后对模型进行微调,可以发现他的precision,recall,mAP和正常训练模型效果近似。剪枝后yolov5s模型的大小从14.46降低到6.3M左右 -

相关阅读:

SSH客户端连接远程服务器

springboot接口参数校验(JSR303)

FebHost:荷兰.NL域名一个富有影响力域名

Oracle两个日期都存在返回最小/最大的,如果只存在一个就返回存在的日期

【二叉树】树是什么?-树和二叉树的基本必会概念讲解

C++从入门到起飞之——输入&输出!

第5讲:SQL语句之DML类型的数据操纵语言

【luogu P8326】Fliper(图论)(构造)(欧拉回路)

Leetcode:125.验证回文串,917仅仅反转字母,387字符串的第一个唯一字符

城市易涝点怎么安装万宾科技内涝积水监测仪?

- 原文地址:https://blog.csdn.net/weixin_38346042/article/details/127912893