-

Sqoop Hook

环境:

ambari大数据平台

sqoop版本1.4.7

hive版本3.1.0

Atlas版本2.2.0

Atlas使用官网给的sqoop hook

具体安装步骤

1、官网安装步骤:https://atlas.apache.org/#/HookSqoop

2、其他安装步骤:https://www.freesion.com/article/45701353391/

根据以上两个安装的步骤可以解决sqoop hook的安装

在安装中遇到的问题:

在安装完sqoop hook的时候,执行sqoop导入,会一直卡在连接zookeeper中的hiveserver2。

通过查看源码发现,sqoop1.4.7是通过beeline的方式连接hive。而一直卡在这里的原因就是等待用户名和密码的输入。而实际上我们并没有配beeline自动连接的用户名和密码。所以一直卡在这里。

解决方案:

在hive中bin目录下的beeline种添加如下图所示

注意项:

1、sqoop是在sqoop任务执行完之后才会把数据发送给kafka,所以在执行的时候一定要保证sqoop完全执行完(在这排查了很久)

2、sqoop hook只支持improt hive,也就是sqoop中需要有参数–import-hive(官网在这块说的也比较明确)

3、使用beeline命令连接会去连接zookeeper

4、hive版本与sqook hook版本没有直接关系

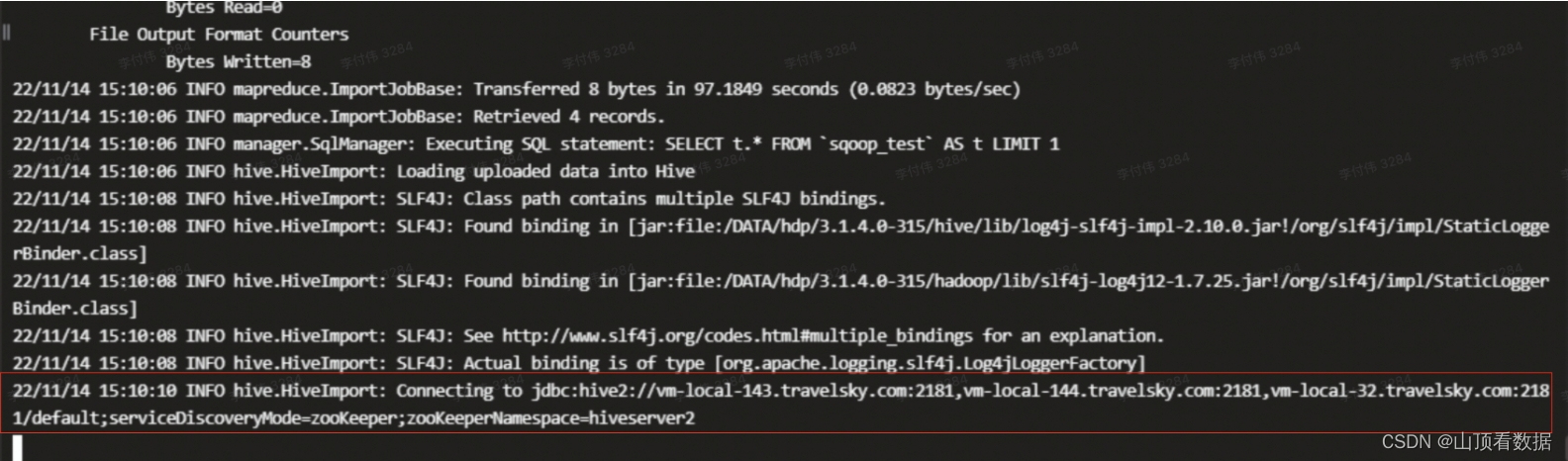

完整版sqoop hook导入的日志

由于日志太多这边截一些主要日志:

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-1efkGTH1-1668563873709)(/Users/fuwei/Library/Application Support/typora-user-images/image-20221116094943762.png)]

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-fzUOx5NH-1668563873709)(/Users/fuwei/Library/Application Support/typora-user-images/image-20221116094917377.png)]

-

相关阅读:

如何创建多语言WordPress网站[专家建议]

七、函数-存储过程-触发器

vue实战入门后台篇五:springboot+mybatis实现网站后台-操作日志功能实现

go开发之个微机器人的二次开发

[Java] 异常的使用

Promise解决异步

【深度学习】分类问题探究(多标签分类转为多个二分类,等)

Hadoop3:MapReduce之简介、WordCount案例源码阅读、简单功能开发

【模式识别大作业】

基于Hadoop架构的可视化大数据挖掘建模平台

- 原文地址:https://blog.csdn.net/li1579026891/article/details/127879166