-

人家网站都免费了,你还用Python去爬?

⛳️ 实战场景

这次实战的目标是一个叫做猫肯的字体站点,该站点所有的字体都是免费可商用的,所以为什么还要去下载呢?

答案是练手,借免费站点学习爬虫,🌋

目标站点地址:https://www.maoken.com/all-fonts

目标页截图如下所示:

使用的模块是requests+lxml,用最少的代码,学习最纯粹的爬虫。⛳️ 实战编码

基于捕获到的页面源码,直接提取内容。

import requests from lxml import etree def get_html(): headers = { "user-agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/106.0.0.0 Safari/537.36" } res = requests.get('https://www.maoken.com/all-fonts', headers=headers) ele = etree.HTML(res.text) div_list = ele.xpath("//div[@class='basetabcon']") for div in div_list: tr_list = div.xpath(".//tr") for tr in tr_list: print(tr.xpath("./td/text()")) if __name__ == '__main__': get_html()- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

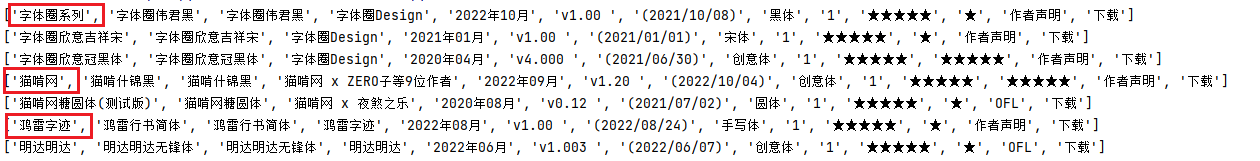

本部分代码中,可以看到优先提取了

class='basetabcon'的div,然后遍历其所有节点,提取tr元素,并且打印了其子节点td中的文本内容,输出如下:['字体系列', '字体名称', 'PS中名称', '开发者', '发布时间', '最新版本', '分类', '字重数', '简体字数', '繁体字数', '授权方式', '下载'] [] ['字体圈系列', '字体圈伟君黑', '字体圈Design', '2022年10月', 'v1.00 ', '黑体', '1', '★★★★★', '★'] ['字体圈欣意吉祥宋', '字体圈Design', '2021年01月', 'v1.00 ', '宋体', '1', '★★★★★', '★'] ['字体圈欣意冠黑体', '字体圈Design', '2020年04月', 'v4.000 ', '创意体', '1', '★★★★★', '★★★★★']- 1

- 2

- 3

- 4

- 5

此时发现出现了数据问题,第一行和第二行属于冗余数据,需要清理。

def get_html(): headers = { "user-agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/106.0.0.0 Safari/537.36" } res = requests.get('https://www.maoken.com/all-fonts', headers=headers) ele = etree.HTML(res.text) div_list = ele.xpath("//div[@class='basetabcon']") for div in div_list: tr_list = div.xpath(".//tr") # 去除第一行冗余 tr for tr in tr_list[1:]: # 去除空数据 if len(tr.xpath("./td/text()")) == 0: continue print(tr.xpath("./td/text()"))- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

按照上述内容对数据进行处理之后,得到下述信息:

['字体圈系列', '字体圈伟君黑', '字体圈Design', '2022年10月', 'v1.00 ', '黑体', '1', '★★★★★', '★'] ['字体圈欣意吉祥宋', '字体圈Design', '2021年01月', 'v1.00 ', '宋体', '1', '★★★★★', '★'] ['字体圈欣意冠黑体', '字体圈Design', '2020年04月', 'v4.000 ', '创意体', '1', '★★★★★', '★★★★★']- 1

- 2

- 3

下面要处理的是合并单元格问题,在正式编码前优先核对一下界面显示规则。

其中字体圈系列 显示被合并了,从内容输出看,单元格字体圈系列所在的行多一个单元格,即列表多一个元素,如下所示。

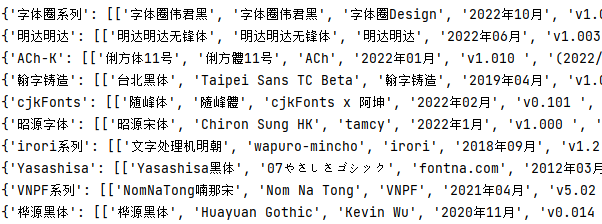

接下来我们对数据进行再次整理,当单元格数量等于 13 的时候,新增一个字典 KEY,后续的字体都追加到该字典项中。def get_html(): headers = { "user-agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) ……" } res = requests.get('https://www.maoken.com/all-fonts', headers=headers) ele = etree.HTML(res.text) div_list = ele.xpath("//div[@class='basetabcon']") for div in div_list: tr_list = div.xpath(".//tr") # 去除第一行冗余 tr result = {} for tr in tr_list[1:8]: td_content = tr.xpath("./td//text()") # 去除空数据 if len(td_content) < 4: continue # 合并单元格 if len(td_content)==13: head = td_content[0] td_list = td_content[1:] result[head] = [] # 建立一个空字典 result[head].append(td_list[:-2]) # 字典的值增加项 else: result[head].append(td_content) print(result)- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

此时运行代码就可以获取到完整的表格数据了,效果如下所示,与网页对比之后,无数据丢失问题。

该案例实战中最需要学习的部分是单元格的解析,其中用到了差异对比,在实践中最大的风险是需要保证数据是完整的,即数据量中无缺项,否则无法进行硬编码解析数据。本次实战通过 div 进行了首次提取,最终输出的数据是基于单元格位置进行拆分的,学习的时候重点掌握该解题方法。

📢📢📢📢📢📢

💗 你正在阅读 【梦想橡皮擦】 的博客

👍 阅读完毕,可以点点小手赞一下

🌻 发现错误,直接评论区中指正吧

📆 橡皮擦的第 737 篇原创博客从订购之日起,案例 5 年内保证更新

-

相关阅读:

数据分析技能点-双变量的相关分析

【运筹学】【如何使用Excel求解线性规划】

操作系统13章(个人笔记)

WEB 自动化神器 TestCafe(一)—安装和入门篇

什么是单向数据流

excel中用Index函数取出数组中任意一个位置的值

ngx_http_set_response_header阅读

丢失宠物发布找寻平台

初次远程面试阿里团队,4面以为没结果了,真没想到收到录取通知

Windows使用小技巧

- 原文地址:https://blog.csdn.net/hihell/article/details/127494694