-

虚拟人实时互动之基于Android驱动表情随动

ZEGO Avatar表情随动功能简介

ZEGO Avatar SDK 提供了

表情随动功能,基于领先的人脸关键点精准识别,结合面部、舌头、眼球在内的 52 种基础面部表情维度,实时捕获用户脸部的表情动作,在虚拟形象上进行实时的还原渲染。可广泛应用于社交互动、语聊直播等场景中。

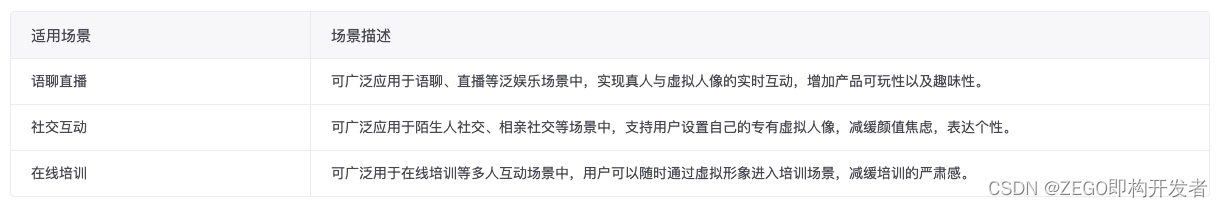

虚拟人适用业务场景

适用语聊直播、社交互动、在线培训等场景,实现真人与虚拟人像的实时互动,增加产品可玩性和趣味性。

虚拟人表情驱动的前提条件

在实现“表情随动”功能之前,请确保:

虚拟形象表情随动 Android实现流程

开发者请参考以下步骤,实现 “表情随动” 功能。

1 开始虚拟人表情检测

- 开启表情检测前,请确认已开启摄像头权限。

- 开发者如果使用了 ZegoCharacterHelper,则无需再调用

ZegoCharacter的任何相关接口。

搭建出基本的虚拟人物形象后,调用

startDetectExpression接口,设置驱动模式为Camera,通过前置摄像头,开始检测表情;然后可以直接通过 ZegoCharacterHelper 的setExpression接口设置表情,驱动当前虚拟人物的面部表情变化。// 开始表情检测 ZegoAvatarService.getInteractEngine().startDetectExpression(ZegoExpressionDetectMode.Camera, expression -> { // 前提是 mCharacterHelper 已经创建好,并且设置了 AvatarView 和设置了默认形象(使用 setDefaultAvatar 或 setAvatarJson 设置过。)。 // 驱动虚拟人物的脸部变化 mCharacterHelper.setExpression(expression); });- 1

- 2

- 3

- 4

- 5

- 6

2 停止虚拟人表情检测

将应用切换到后台运行、或退出当前页面时,需要调用

stopDetectExpression接口,停止表情检测。// 停止表情检测 ZegoAvatarService.getInteractEngine().stopDetectExpression();- 1

- 2

-

相关阅读:

常用docker命令

算法基础学习|前缀和差分

python绘制混淆矩阵

CASIO—4500P计算器在公路工程测量中的应用

[无监督学习] 15.详细图解混合高斯分布

Linux之计划任务

Java多线程——synchronized,volatile,CAS,ReentrantLock

【数据分析】2022年北京交通大学计算机学院学术型博士录取数据分析

uview使用u-action-sheet添加滚动条

[ACNOI2022]做过也不会

- 原文地址:https://blog.csdn.net/ZEGO123/article/details/126937075