-

已解决urllib.request.urlretrieve下载文件报错403

已解决(python使用urlopen/urlretrieve下载文件时出现403 forbidden)urllib.error.HTTPError: HTTP Error 403: Forbidden

报错代码

urllib.urlretrieve(url[, filename[, reporthook[, data]]])参数说明:

- url:外部或者本地url

- filename:指定了保存到本地的路径(如果未指定该参数,urllib会生成一个临时文件来保存数据);

- reporthook:是一个回调函数,当连接上服务器、以及相应的数据块传输完毕的时候会触发该回调。我们可以利用这个回调函数来显示当前的下载进度。

- data:指post到服务器的数据。该方法返回一个包含两个元素的元组(filename, headers),filename表示保存到本地的路径,header表示服务器的响应头。

最近用urllib编写了一个简单的爬虫下载网上文件的代码,刚运行没多久就每个url都报403错误。但是手动在浏览器端访问却是能够访问的。报错代码如下:

from urllib.request import urlretrieve import wget url = "http://cdict.qq.pinyin.cn/download?dict_id=s49272" # 请求下载文件地址 urlretrieve(url, '1.qcel') # 第二个参数表示路径

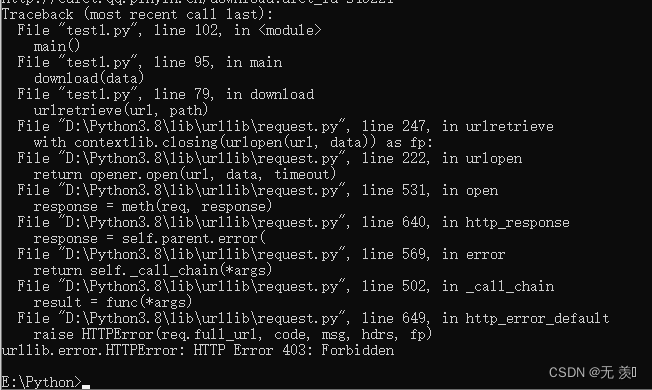

报错信息截图如下:

报错翻译

报错信息翻译:

错误。HTTP错误403:禁止

报错原因

报错原因:

访问网站403错误:资源不可用,403错误是一种在网站访问过程中,常见的错误提示,表示资源不可用。服务器理解客户的请求,但拒绝处理它,通常由于服务器上文件或目录的权限设置导致的WEB访问错误。

出现该错误的原因是服务器开启了反爬虫,一般情况下只需要设置header模拟浏览器即可,但是urlretrieve并未提供header参数。

解决方法

排查发现可能是服务器开启了反爬虫,针对这种情况添加headers浏览器头,模拟人工访问网站行为:

from urllib.request import urlretrieve import urllib import random url = "http://cdict.qq.pinyin.cn/download?dict_id=s49272" # 请求下载文件地址 urlretrieve(url, '1.qcel') # 第二个参数表示路径 opener = urllib.request.build_opener() # 构建请求头列表每次随机选择一个 ua_list = ['Mozilla/5.0 (Windows NT 10.0; Win64; x64; rv:102.0) Gecko/20100101 Firefox/102.0', 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/103.0.0.0 Safari/537.36', 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/103.0.5060.114 Safari/537.36 Edg/103.0.1264.62', 'Mozilla/5.0 (Windows NT 10.0; Win64; x64; rv:98.0) Gecko/20100101 Firefox/98.0', 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/72.0.3626.81 Safari/537.36 SE 2.X MetaSr 1.0' ] opener.addheaders = [('User-Agent', random.choice(ua_list))] urllib.request.install_opener(opener) urlretrieve(url, '1.qcel')

以上是此问题报错原因的解决方法,欢迎评论区留言讨论是否能解决,如果有用欢迎点赞收藏文章谢谢支持,博主才有动力持续记录遇到的问题!!!

千人全栈VIP答疑群联系博主帮忙解决报错

由于博主时间精力有限,每天私信人数太多,没办法每个粉丝都及时回复,所以优先回复VIP粉丝,可以通过订阅限时9.9付费专栏《100天精通Python从入门到就业》进入千人全栈VIP答疑群,获得优先解答机会(代码指导、远程服务),白嫖80G学习资料大礼包,专栏订阅地址:https://blog.csdn.net/yuan2019035055/category_11466020.html

-

优点:作者优先解答机会(代码指导、远程服务),群里大佬众多可以抱团取暖(大厂内推机会),此专栏文章是专门针对零基础和需要进阶提升的同学所准备的一套完整教学,从0到100的不断进阶深入,后续还有实战项目,轻松应对面试!

-

专栏福利:简历指导、招聘内推、每周送实体书、80G全栈学习视频、300本IT电子书:Python、Java、前端、大数据、数据库、算法、爬虫、数据分析、机器学习、面试题库等等

-

注意:如果希望得到及时回复,订阅专栏后私信博主进千人VIP答疑群

免费资料获取,更多粉丝福利,关注下方公众号获取

-

相关阅读:

太原师范学院计算机考研资料汇总

传输层协议 --TCP报文格式详细介绍

Element UI + Vue 新增和编辑共用表单校验无法清除问题(已解决)

MYSQL表的连接方式

35【Storage接口】

Modelsim的仿真之路(结束篇之波形比较)

Shell-条件控制语句2

用 NEON 实现高效的 FIR 滤波器

找不到vcruntime140.dll,无法继续执行代码的详细解决方案

场景中的解剖学方向标记_vtkAnnotatedCubeActor

- 原文地址:https://blog.csdn.net/yuan2019035055/article/details/126609663