-

自注意力机制

场景引入

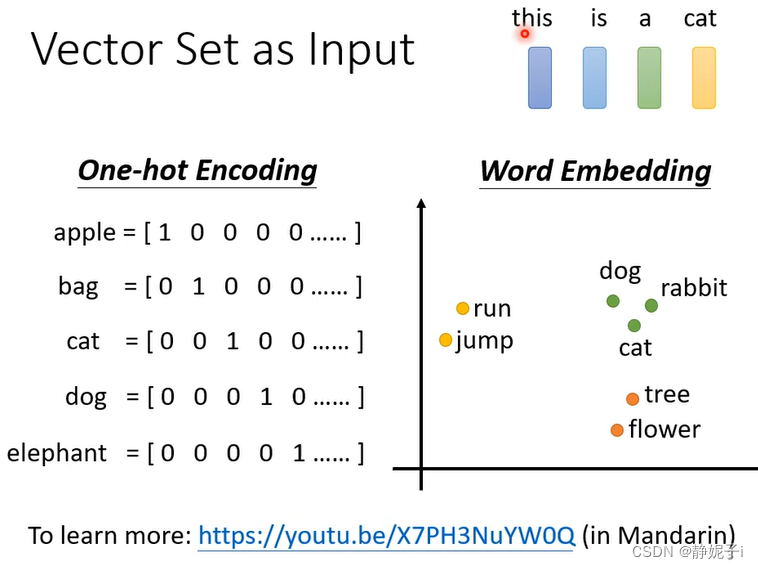

vector set as input

语句输入

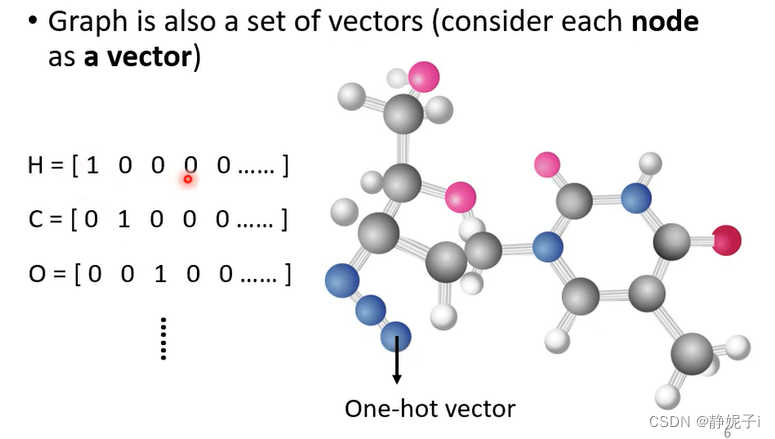

图输入

图输入

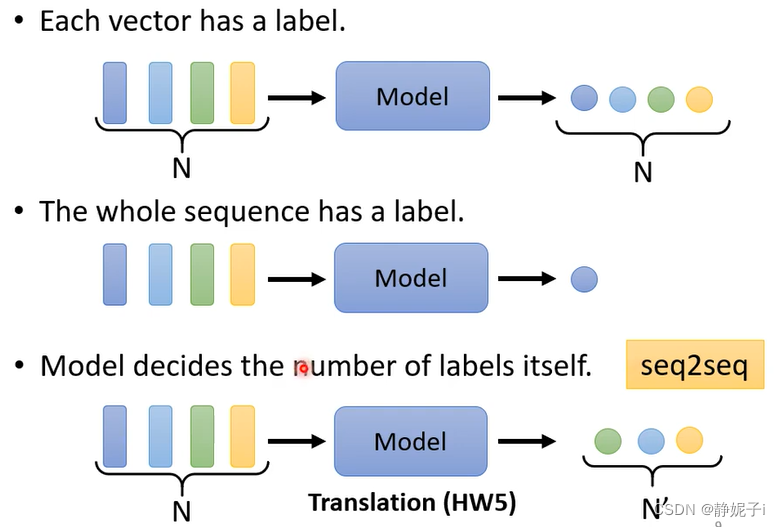

output

每个向量都有一个标签(sequence labeling)

整个句子只有一个标签

or

输出不设限

sequence labeling

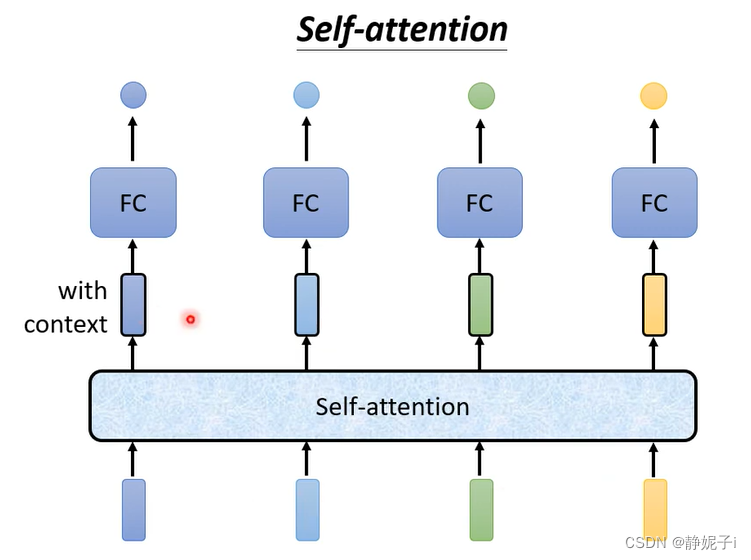

让全连接考虑上下文特性

如何确定不等长句子的window size

self-attention可以接受一整个sequence的信息,输入几个vector结合context就可以输出几个label

self-attention

注: b i ( 1 ≤ i ≤ 4 ) 是同时计算出来的, a i , j 为 q i 和 k j 的内积。

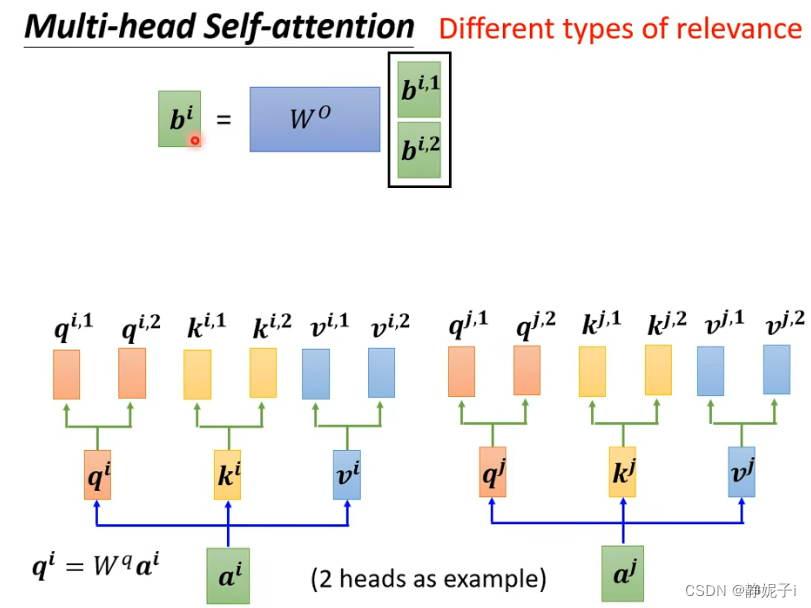

multi-head self-attention

多个QKV,并将结果拼接起来

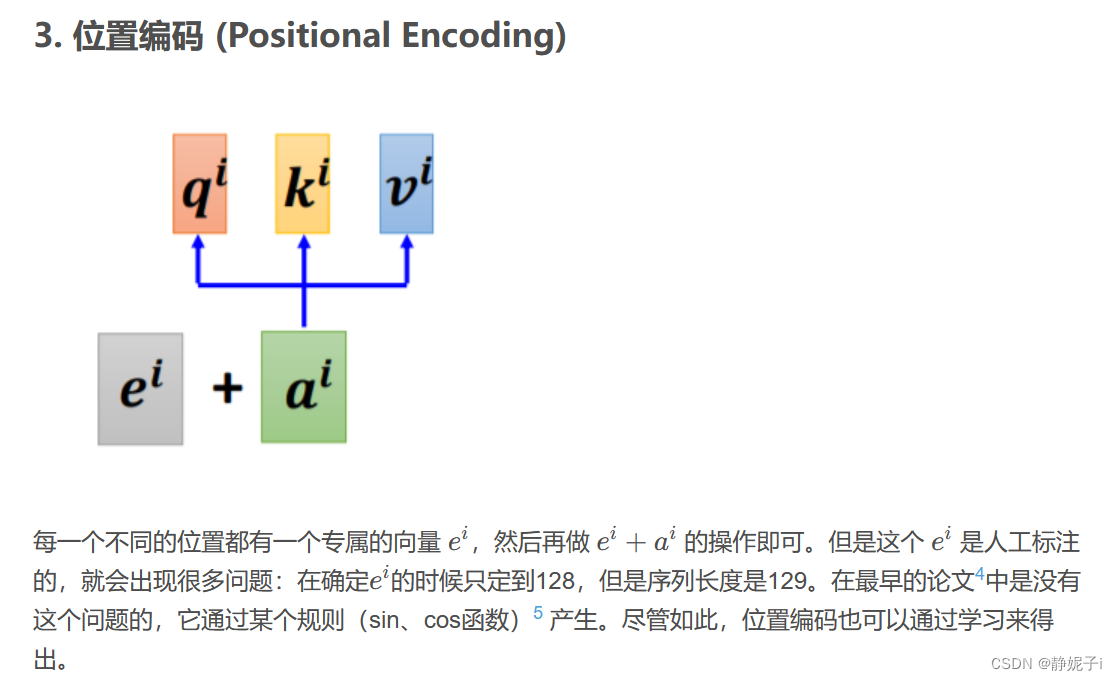

position encoding

对于Self-attention来说,并没有序列中字符位置的信息。例如动词是不太可能出现在句首的,因此可以降低动词在句首的可能性,但是自注意力机制并没有该能力。因此需要加入 Positional Encoding 的技术来标注每个词汇在句子中的位置信息。

每一个位置都有一个特有的位置向量ei

token新的向量表示将位置向量与表示向量融合以获得新的表示

self-attention与CNN对比

self-attention与CNN对比

An Image is Worth 16×16 Words:Transformers for Image Recognition at Scale

self-attention与RNN的对比

Transformers are RNNs:Fast Autoregressive Transformers with Linear Attentionself-attention for graph

只需要计算有边相连的点之间的attention

GCN

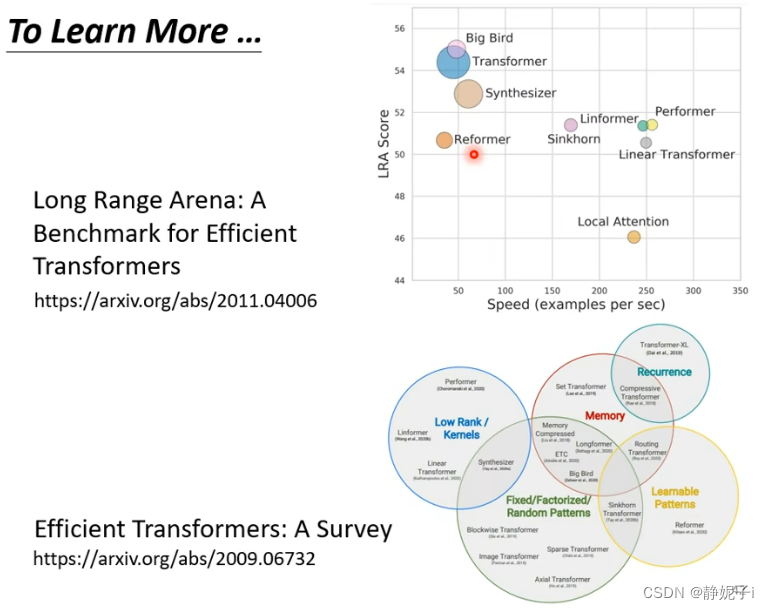

更全面的介绍:综述——Effcient Transformers:A Survey自注意力机制的缺点就是计算量非常大,因此如何优化其计算量是未来研究的重点。

-

相关阅读:

数据库基本操作--DML

详解 Flink CDC 的介绍和入门案例

创建型模式-原型模式(五)

F (1083) : DS堆栈--行编辑

【数据结构第2.5讲(栈和队列)】

Java中方法的注意事项

Python操作Excel表格

mysql8.0 服务器和服务器启动程序 客户端程序

神经网络系列---分类度量

2014NOIP普及组真题 2. 比例简化

- 原文地址:https://blog.csdn.net/qq_39848541/article/details/127102530