-

kafka笔记(一):kafka概述及入门-基础框架/消息队列/安装部署/命令行操作

目录

kafka概述

kafka定义

Kafka传统定义:Kafka是一个分布式的基于发布/订阅模式的消息队列,主要应用于大数据实时处理领域。

Kafka最新定义 :Kafka是 一个开源的分布式事件流平台(Event Streaming Platform)被数千家公司用于高性能数据管道、流分析、数据集成和关键任务应用。

消息队列

目前企业中比较常见的消息队列产品主要有Kafka、ActiveMQ 、RabbitMQ 、RocketMQ 等。 在大数据场景主要采用Kafka作为消息队列。在JavaEE开发中主要采用ActiveMQ、RabbitMQ、RocketMQ。

(1)传统消息队列的应用场景

传统消息队列的主要应用场景包括:缓存/消峰、解耦和异步通信。

1)缓冲/消峰:有助于控制和优化数据流经过系统的速度,解决生产消息和消费消息的处理速度不一致的情况。

例:购物平台的秒杀系统最大处理能力为1千万用户/s,参加秒杀的用户很有可能超过一千万,这时候就需要消息队列,消息队列先按照顺序把数据写入消息队列,然后处理,几秒后等处理完成获取数据。

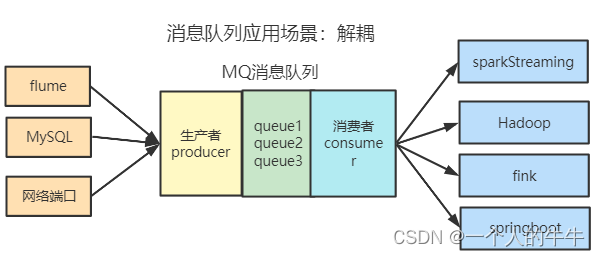

2)解耦:允许你独立的扩展或修改两边的处理过程,只要确保它们遵守同样的接口约束。

3)异步通信:允许用户把消息放入队列,但不立即处理它,需要的时候再去处理它们。

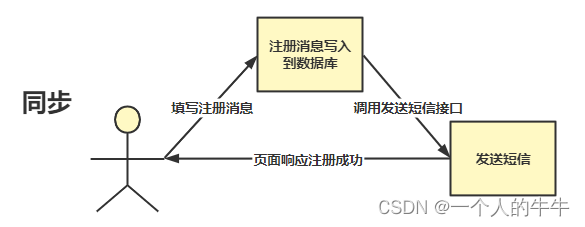

注册的主要步骤是注册,发送短信验证可以写入另一个模块,同时写在一起影响性能及用户体验感。

下面是同步

(2)消息队列的两种模式

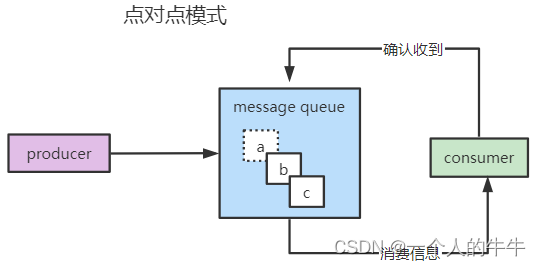

1)点对点模式

消费者主动拉取数据,消息收到后删除消息

2)发布/订阅模式

可以有多个topic(评论、点赞……);

每一个消费者相对独立,都可以消费数据;

收到消息后不删除;

kafka基础框架

(1)Producer:消息生产者,向Kafka broker发消息的客户端;

(2)Consumer:消息消费者,向Kafka broker提取消息的客户端;

(3)Consumer Group(CG):消费者组,由多个consumer组成;消费者组内每个消费者负责消费不同分区的数据,一个分区只能由一个组内消费者消费;消费者组之间互不影响;所有的消费者都属于某个消费者组,即消费者组是逻辑上的一个订阅者。

(4)Broker:一台Kafka服务器就是一个broker;一个集群由多个broker组成。一个broker可以容纳多个topic;上图的broker是Hadoop01,Hadoop02,Hadoop03;

(5)Topic:可以理解为一个队列,生产者和消费者面向的都是一个 topic。

(6)Partition:为了实现扩展性,一个非常大的topic可以分布到多个broker上,一个topic可以分为多个partition,每个partition是一个有序的队列;

(7)Replica:副本。一个topic的每个分区都有若干个副本,一个Leader和若干个Follower;

(8)Leader:每个分区多个副本的“主”,生产者发送数据的对象,以及消费者消费数据的对象都是Leader;

(9)Follower:每个分区多个副本中的“从”,实时从Leader中同步数据,保持和Leader数据的同步。Leader发生故障时,某个Follower会成为新的Leader;

kafka入门

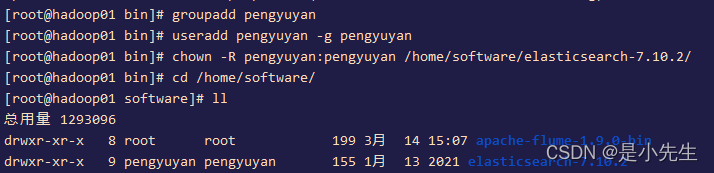

安装部署

(1)安装参考:

kafka单机和集群(全分布)的安装部署过程_一个人的牛牛的博客-CSDN博客_kafka 分区 单机

(2)集群启停脚本

ka.sh

- #! /bin/bash

- case $1 in

- "start"){

- for i in hadoop01 hadoop02 hadoop03 hadoop04

- do

- echo "============ $i ==========="

- ssh $i "/training/kafka_2.11-2.4.1/bin/kafka-server-start.sh -daemon /training/kafka_2.11-2.4.1/config/server.properties"

- echo "success to start $i kafka"

- echo -e "\n\n"

- done

- };;

- "stop"){

- for i in hadoop01 hadoop02 hadoop03 hadoop04

- do

- echo "============= $i ==============="

- ssh $i "/training/kafka_2.11-2.4.1/bin/kafka-server-stop.sh -daemon /training/kafka_2.11-2.4.1/config/server.properties"

- echo "success to stop $i kafka"

- echo -e "\n\n"

- done

- };;

- esac

添加执行权限

chmod +x ka.sh启动集群命令

ka.sh start停止集群命令

ka.sh stop注:停止Kafka集群时一定要等Kafka所有节点进程全部停止后再停止Zookeeper集群。

因为Zookeeper集群当中记录着Kafka集群相关信息,Zookeeper集群一旦先停止,Kafka集群就没有办法再获取停止进程的信息,只能手动杀死Kafka进程了。

kafka命令行操作

(1)主题命令行操作

1)操作主题命令参数

参数 描述 --bootstrap-server 连接的kafka broker主机名和端口号 --topic 操作的topic名称 --create 创建主题 --delete 删除主题 --alter 修改主题 --list 查看所有主题 --describe 查看主题详细描述 --partition 设置分区数 --replication-factor 设置分区副本数 --config 更新系统默认的配置 2)查看当前服务器的所有topic

kafka-topics.sh --zookeeper hadoop01:2181 --list3)创建topic,topic名为first

- bin/kafka-topics.sh --create --zookeeper hadoop01:2181

- --replication-factor 1 --partitions 1 --topic first

4)查看topic详情

bin/kafka-topics.sh --zookeeper hadoop01:2181 --describe --topic firstbin/kafka-topics.sh --bootstrap-server hadoop01:9092 --topic first --describe5)修改topic分区数

- bin/kafka-topics.sh --zookeeper hadoop001:2181

- --alter --topic first --partitions 3

6)删除topic

bin/kafka-topics.sh --zookeeper hadoop001:2181 --delete --topic first(2)生产者命令行操作

1)生产者信息

bin/kafka-console-producer.sh --broker-list hadoop001:9092 --topic first(3)消费者命令行操作

参数 描述 --bootstrap-server 连接的kafka broker主机名和端口数 --topic 操作topic的名称 --from-beginning 从头开始消费 --group 指定消费者组名称 1)消费者信息

bin/kafka-console-consumer.sh --bootstrap-server hadoop001:9092 --topic first- bin/kafka-console-consumer.sh --bootstrap-server

- hadoop01:9092 --from-beginning --topic first

本文为学习笔记!!!

-

相关阅读:

kafka的ISR工作机制原理

Springboot美食点评系统gb9o5计算机毕业设计-课程设计-期末作业-毕设程序代做

【学习笔记】Python 使用 matplotlib 画图

js面向对象(工厂模式、构造函数模式、原型模式、原型和原型链)

神经网络是参数模型吗,神经网络参数量计算

MyBatis ---- 动态SQL

Java8特性-Lambda表达式

【算法】【递归与动态规划模块】判断字符串的顺序交错组成

Mybatis巧用@Many注解一个SQL联合查询语句搞定一对多查询

四川大学计算机学院与华为基于昇腾共建多模态动物监测可视化算法平台

- 原文地址:https://blog.csdn.net/qq_55906442/article/details/126845452