-

论文解析[2] UNet++: A Nested U-Net Architecture for Medical Image Segmentation

发表年份:2018

论文地址:https://arxiv.org/abs/1807.10165

代码地址:https://github.com/MrGiovanni/Nested-UNet论文概要

提出了UNet++:一种更有效的医学图像分割结构。它是一种深度监督的编码-解码器网络,编码器和解码器通过一系列嵌套、稠密的跳跃路径连接。

重新设计的跳跃路径旨在减小编码器和解码器特征图之间的语义鸿沟。我们认为当编码器和解码器特征图之间的语义鸿沟更小时,优化器就会处理一个更简单的学习任务。

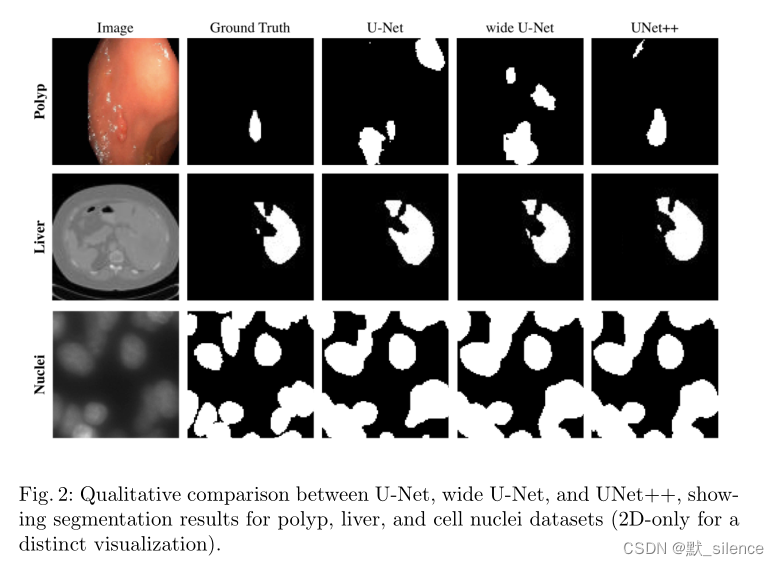

我们在不同的医学图像分割任务上评估UNet++,并与U-Net、wide U-Net对照。实验证明了带有深度监督的UNet++模型比U-Net、wide U-Net的平均IoU高出3.9和3.4。

1 介绍

目前图像分割性能最好的模型都是编码器-解码器结构的变形,像U-Net和FCN。这些网络有一个关键的共同点:跳跃连接,它可以将解码器的深层、语义、粗粒度特征图和编码器的浅层、低水平、细粒度特征图结合。跳跃连接在恢复目标物体细粒度细节、生成分割掩膜方面被证明是有效的。它也是instance-level分割模型成功的基础

但是分割医学图像中的病变和异常需要比自然图像中更高的准确率。为了解决需求,我们提出了UNet++,一种基于嵌套和稠密跳跃连接的结构。

这种结构背后的基本假说是,当编码器网络的高分辨率特征图与解码器网络的语义丰富的特征图融合之前逐渐丰富时,该模型可以更有效的捕获前景对象的细粒度细节。

对比于使用普通跳跃连接的U-Net,U-Net直接将高分辨率的特征图从编码器快进传入解码器,导致了语义不相似的特征图融合。

2 相关工作

FCN、U-Net、H-denseunet

GridNet、Mask-RCNN

3 提出的网络模型

UNet++包括编码器和解码器,它们通过一系列嵌套稠密的卷积块连接。UNet++的主要想法是在融合之前减小编码器和解码器特征图之间的语义鸿沟。区分UNet++和U-Net(黑色部分)的是重新设计的跳跃路径(绿色和蓝色部分)和深度监督(红色部分)的使用

3.1 重新设计的跳跃路径

x i , j x^{i,j} xi,j 代表节点 X i , j X^{i,j} Xi,j 的输出, i i i 是编码器的下采样层的索引, j j j 跳跃路径上卷积层的索引H ( ) H() H() 表示一个卷积操作后面跟随一个激活函数, μ ( ) μ() μ() 表示一个上采样层, [ ] [~] [ ] 表示连接层

- 当 j = 0 j=0 j=0 时,节点仅接收来自上一层编码器的一个输入。

- 当 j = 1 j=1 j=1 时,接收来自编码器两个不同层的两个输入。

- 当 j > 1 j>1 j>1 时,接收 j + 1 j+1 j+1 个输入,其中 j j j 个来自于相同跳跃路径的前 j j j 个节点,最后一个输入是低一层跳跃路径的上采样输出。

3.2 深度监督

使用深度监督可以使模型能够在两个模式运行:

- 准确模式,输出来自于所有分割分支的均值

- 快速模式,最后的分割图像仅来自于分割分支中的一个(分支的选择决定了模型的修剪程度和速度增益)

由于稠密的跳跃路径,UNet++生成全分辨率特征图于不同的语义水平, { x 0 , j , j ∈ { 1 , 2 , 3 , 4 } } \{x^{0,j},j∈\{1,2,3,4\}\} {x0,j,j∈{1,2,3,4}}

我们使用了二分交叉熵和骰子系数的结合来作为以上四个语义水平中每一个的损失函数:

如图1a所示,UNet++与U-Net有三处区别:1)在跳跃路径有卷积层(绿色),减小了编码器和解码器特征图之间的语义鸿沟

2)跳跃路径有稠密的跳跃连接(蓝色),提高了梯度流

3)有深度监督(红色),可以使模型修剪和提升,或者在最坏的情况下实现与仅使用一个损失层相当的性能。

4 实验

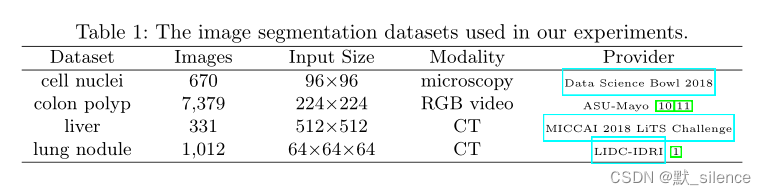

数据集

模型

作为对照,我们使用了原始U-Net和一个特定的wide U-Net(与建议的结构有相似的参数)。结果

在四个数据集上的正确率

分割比较模型修剪

展示了在不同程度修剪后的模型性能如图所示, L 3 L^3 L3 平均减少了32.2%的推理时间,但IoU只降低了0.6。进一步的修剪会减少推理时间,但代价是显著的正确率下降。

5 结论

- 为解决医学图像分割更高准确率的需求,我们提出了UNet++

- 这种结构利用了重新设计的跳跃路径和深度监督。(重新设计的跳跃路径旨在减小编码器和解码器之间的语义鸿沟,使优化问题更简单。深度监督能够更精确的分割,特别是多尺度出现的病变)

- 我们在四个医学图像数据集上评估了UNet++,比U-Net和wide U-Net的平均IoU高出了3.9和3.4

参考资料

论文精读:UNet++:https://zhuanlan.zhihu.com/p/543874630

深度学习论文精读[6]:UNet++:https://blog.csdn.net/weixin_37737254/article/details/125923940

FCN、Unet、Unet++医学图像分割那点事儿:https://zhuanlan.zhihu.com/p/159173338?from=singlemessage

【论文笔记】医学图像分割 U-Net++:https://blog.csdn.net/muyijames/article/details/117438141 -

相关阅读:

亚商投资顾问 早餐FM/0920 苹果涨2.51%,领涨道指

【Linux系统编程】命令模式2

计算机毕业设计Java学生学习评价系统(源码+系统+mysql数据库+Lw文档)

Nacos 2.1.1 正式发布,微服务大变天

【生日快乐】Node.js 实战 第1章 欢迎进入Node.js 的世界 1.1 一个典型的Node Web 应用程序

【Git】git命令大全(持续更新)

【MySQL】数据库进阶之触发器内容详解

大家都说Java有三种创建线程的方式!并发编程中的惊天骗局!

轻量级xshell+manager远程监控jvisualvm

SpringAOP底层原理

- 原文地址:https://blog.csdn.net/weixin_43772166/article/details/126861773