-

DeconvNet--学习笔记

- 普通的反卷积:

- 为理解卷积网络而提出,为理解中间层的特征值提供了办法。

- 反卷积网络的每一层都可以看做卷积网络中对应层的逆过程,它们拥有相同的卷积核和池化索引,因此反卷积将特征值逆映射回了输入图片的像素空间,借此说明图片中的哪些像素参与激活了该特征值。

- 卷积网络将一张图片作为输入,计算得到各层的特征表示;为了验证某层一个具体的特征值,将该层特征值之外的所有值置零后,将其作为反卷积网络的输入,经过反卷积网络每一层的操作,该特征值被映射回了输入图片的像素空间。

- 反卷积网络的构成:

- 反池化:理论上,卷积网络中的最大池化操作是不可逆的,但可以通过池化索引进行近似可逆

- 矫正[对应卷积网络ReLU操作]:卷积网络中采用ReLU确保特征值非负,为了确保正逆过程的一致性,将反卷积网络每一层的重构特征也通过ReLU得到非负值。

- 反卷积操作:

- 卷积操作是低效操作,主流神经网络框架都是通过im2col+矩阵乘法实现卷积,以空间换效率。

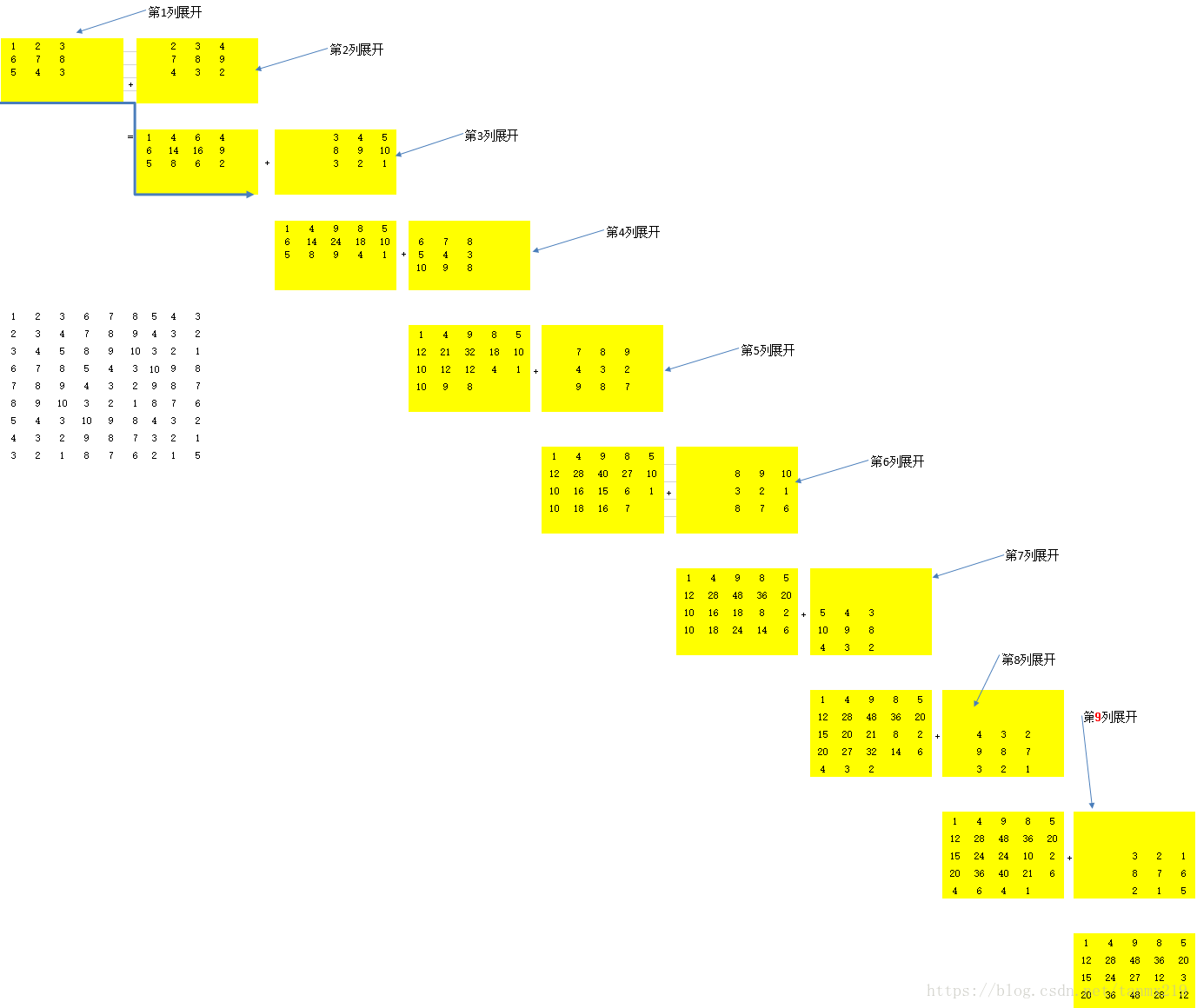

- im2col:

- 卷积核也拉成一列后(Kernel),左乘(即拉直后的卷积核在左边)输入矩阵,得到卷积结果(Output)

- 此处的反卷积实际是转置卷积,神经网络框架借助转置卷积实现梯度的反向传播:将卷积核矩阵转置(Weight_T)后,左乘梯度输出(GradOutput),得到梯度列矩阵(GradColumns),通过col2im还原到输入大小,便得到了相对于输入的梯度(GradInput)。

- col2im:

- 复原结果,是一个逆过程(结构是可逆的,结果不是)

- (图中的展开应该是以该列为起始列与之前得到的结果累加)

- 注意此处的转置卷积不用于梯度反向传播,操作对象不是梯度而是特征值。

- col2im:

- 卷积操作是低效操作,主流神经网络框架都是通过im2col+矩阵乘法实现卷积,以空间换效率。

- 可视化特征:

- 为了避免出现类似基于错误的信息做出判断的著名的“坦克分类问题”。

- 可视化之后,还可以把热力图中显著的部分挡住看是否会影响最后的分类结果。

- 用于语义分析的DeconvNet:

- 提出原因:FCN的限制:

- 网络的感受野尺寸是预先固定。对于输入图片中比感受野大或者小的物体可能会被忽略。即对于较大的物体,只有局部的细节信息能够被正确标记,或者标记的结果是不连续的,而对于小物体会被忽略。

- 卷积后送入反卷积层的feature map十分稀疏,而反卷积的过程又十分的粗糙,输入图片中的结构细节信息会有所损失。

- DeconvNet架构的贡献:

- 学习一个带有反卷积层,上采样层,ReLU层的深层反卷积网络。

- 将训练好的模型,应用到图片的proposals中,得到实例级分割结果,最终将这些结合组成最终的分割结果,解决了原始FCN网络中的尺寸问题,同时,物体的细节信息更详尽。

- 网络架构:

- 两个部分,卷积网络和反卷积网络两部分,完全对称。

- 网络的最后一层输出是一张概率map,与输入图片的大小相同,表示每个像素代表属于某个类别的概率。

- 卷积层:使用的是VGG16的前13层。在卷积层后接Relu和Maxpooling。增加了两个全连接层(1×1的卷积)来强化特定类别的投影。

- 反卷积:转置卷积,可学习 进行上采样,是卷积层的镜像。其中的unpooling操作是通过pooling过程中所用的Max值索引实现的。

- 低层的deconvolution获得目标的位置,形状等较粗信息,高层的deconvolution获得更精细的信息。

- unpooling是为了获得图像空间结构细节,deconvolution获得的是物体类别分类信息。

- 提出原因:FCN的限制:

- 额外知识点:批处理中的维度约定:

- 输入数据:(N,C,H,W)

- 卷积核:(FN,C,FH,FW)

- 偏置:(FN,1,1)

- 输出数据:(N,FN,OH,OW)

- 普通的反卷积:

-

相关阅读:

基于Matlab模拟用于海况海洋学研究的 X 波段雷达系统(附源码)

数据增强系列(5)PyTorch和Albumentations用于语义分割

软考 系统架构设计师系列知识点之基于架构的软件开发方法ABSD(7)

Matlab|【分布鲁棒】数据驱动的多离散场景电热综合能源系统分布鲁棒优化算法

RISC-V函数调用约定 ABI

23. Docker image Digest你真的了解吗?

基于SSM+Vue的咖啡销售系统

使用BitLocker实现磁盘加密、u盘加密、移动硬盘加密

ipad手写笔有必要买原装吗?第三方性价比高的手写笔推荐

python如何进行内存管理

- 原文地址:https://blog.csdn.net/weixin_45647721/article/details/126858071