-

秸秆焚烧视频监控系统

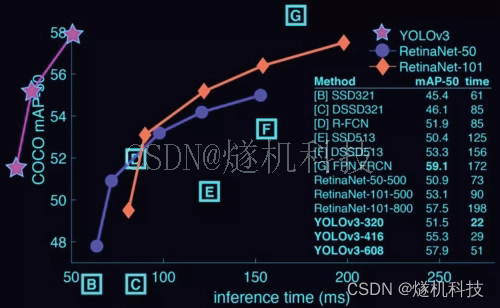

秸秆焚烧视频监控通过机器视觉边缘分析技术以及yolov3深度学习模型对现场画面实时分析检测,对秸秆燃烧行为进行7*24小时不间断识别。YOLO V1的前20层是卷积层,得到7*7*1024的feature map,然后接3*3的mean pooling,得到7*7*1024的pooling feature map,再接两个全连接层,得到7*7*30的输出。

基本的逻辑就是对坐标+iou误差、分类误差进行修正。 在训练的时候,每个样本的ground truth的box是知道的,对应于图片的feature map,也能找到在feature map中对应的box位置(box由多个grid cell组合而成)。如果一个grid cell是该物体的中心位置,则这个grid cell负责预测这个物体;每个grid cell都预测了若干个bounding box(假设S = 7,B = 2,则bounding box的数目 = 7×7×2 = 98个),其中会有一个bounding box具有与ground truth的某个box有最大的IOU,则由这个bounding box负责调整box的位置(另外的97个bounding box就忽略了)。

YOLOv5检测算法中还是存在很多可以学习的地方,虽然这些改进思路看来比较简单或者创新点不足,但是它们确定可以提升检测算法的性能。其实工业界往往更喜欢使用这些方法,而不是利用一个超级复杂的算法来获得较高的检测精度。

Adapter接口定义了如下方法:

public abstract void registerDataSetObserver (DataSetObserver observer)

Adapter表示一个数据源,这个数据源是有可能发生变化的,比如增加了数据、删除了数据、修改了数据,当数据发生变化的时候,它要通知相应的AdapterView做出相应的改变。为了实现这个功能,Adapter使用了观察者模式,Adapter本身相当于被观察的对象,AdapterView相当于观察者,通过调用registerDataSetObserver方法,给Adapter注册观察者。public abstract void unregisterDataSetObserver (DataSetObserver observer)

通过调用unregisterDataSetObserver方法,反注册观察者。public abstract int getCount () 返回Adapter中数据的数量。

public abstract Object getItem (int position)

Adapter中的数据类似于数组,里面每一项就是对应一条数据,每条数据都有一个索引位置,即position,根据position可以获取Adapter中对应的数据项。public abstract long getItemId (int position)

获取指定position数据项的id,通常情况下会将position作为id。在Adapter中,相对来说,position使用比id使用频率更高。public abstract boolean hasStableIds ()

hasStableIds表示当数据源发生了变化的时候,原有数据项的id会不会发生变化,如果返回true表示Id不变,返回false表示可能会变化。Android所提供的Adapter的子类(包括直接子类和间接子类)的hasStableIds方法都返回false。public abstract View getView (int position, View convertView, ViewGroup parent)

getView是Adapter中一个很重要的方法,该方法会根据数据项的索引为AdapterView创建对应的UI项。 -

相关阅读:

全志ARM926 Melis2.0系统的开发指引⑤

JMeter压测如何分配业务比例?

Css 将div设置透明度,并向上移50px,盖住上面的元素一部分

【无标题】

ES6中扩展运算符的作用

开源AI家庭自动化助手-手机控制家庭智能家居服务

使用kubekey部署k8s集群和kubesphere、在已有k8s集群上部署kubesphere

实现一个三角形、扇形、宽高自适应的正方形

细说react源码中的合成事件

Python的pytest框架(6)--测试钩子(hooks)

- 原文地址:https://blog.csdn.net/KO_159/article/details/126697551