-

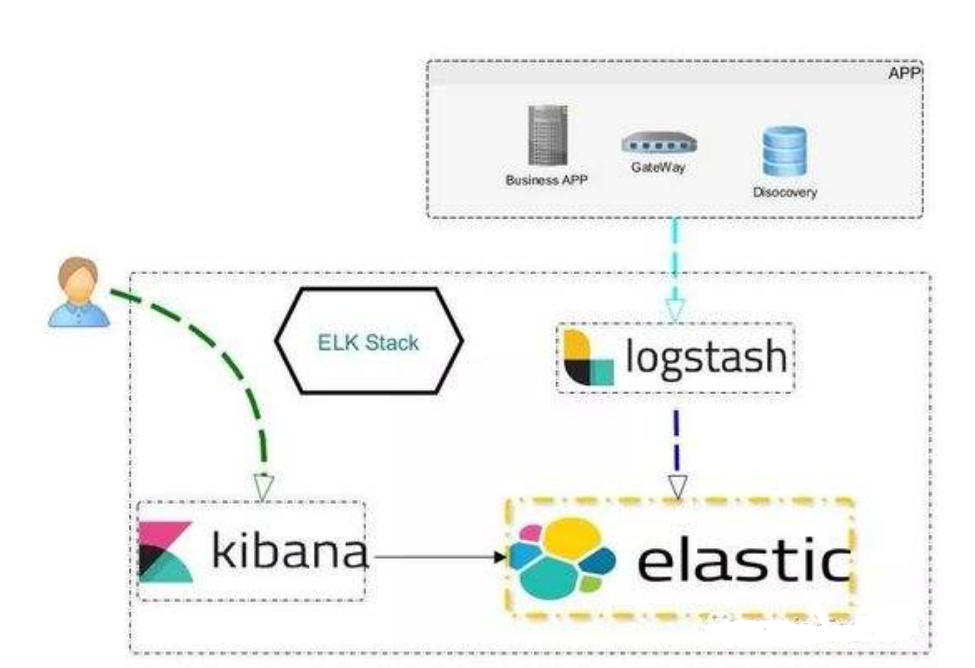

『互联网架构』ELK集群的搭建

说说部署,这里确实要注意下,我自己最开始部署的时候,遇到了很多的坑,会给大家说,避免自己部署的时候在遇到。

(一)如何快速搭建一套稳定的ELK环境

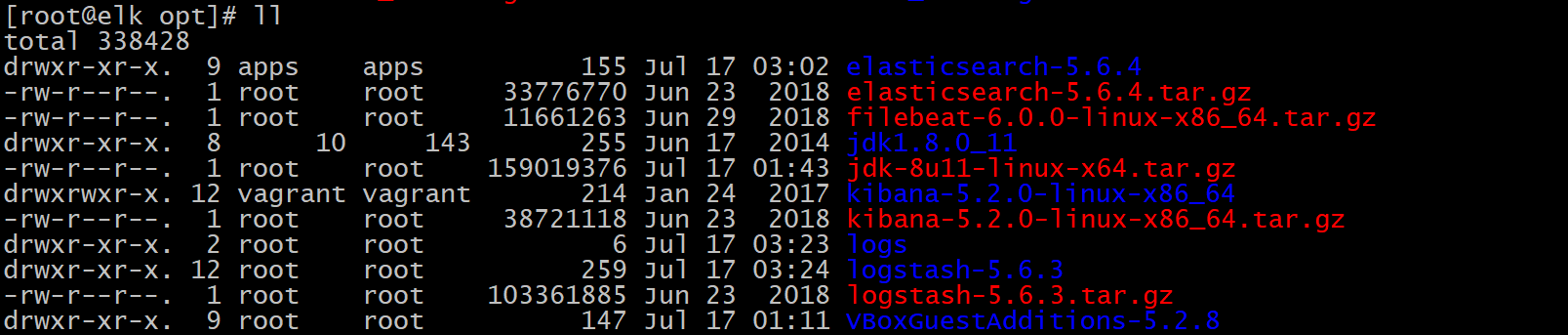

- elasticsearch 5.6.4 + kibana5.2.0 + logstash5.6.3

线上环境就是这个比较稳定。实践过的。

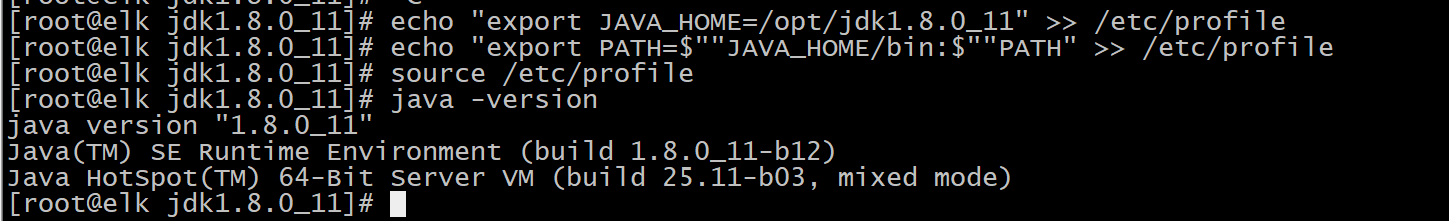

- JDK1.8安装

wget --no-cookies --no-check-certificate --header "Cookie: gpw_e24=http%3A%2F%2Fwww.oracle.com%2F; oraclelicense=accept-securebackup-cookie" "http://download.oracle.com/otn-pub/java/jdk/8u141-b15/336fa29ff2bb4ef291e347e091f7f4a7/jdk-8u141-linux-x64.tar.gz" tar -zxvf jdk* cd jdk* pwd echo "export JAVA_HOME=/opt/jdk1.8.0_11" >> /etc/profile echo "export PATH=$""JAVA_HOME/bin:$""PATH" >> /etc/profile source /etc/profile- 1

- 2

- 3

- 4

- 5

- 6

- 7

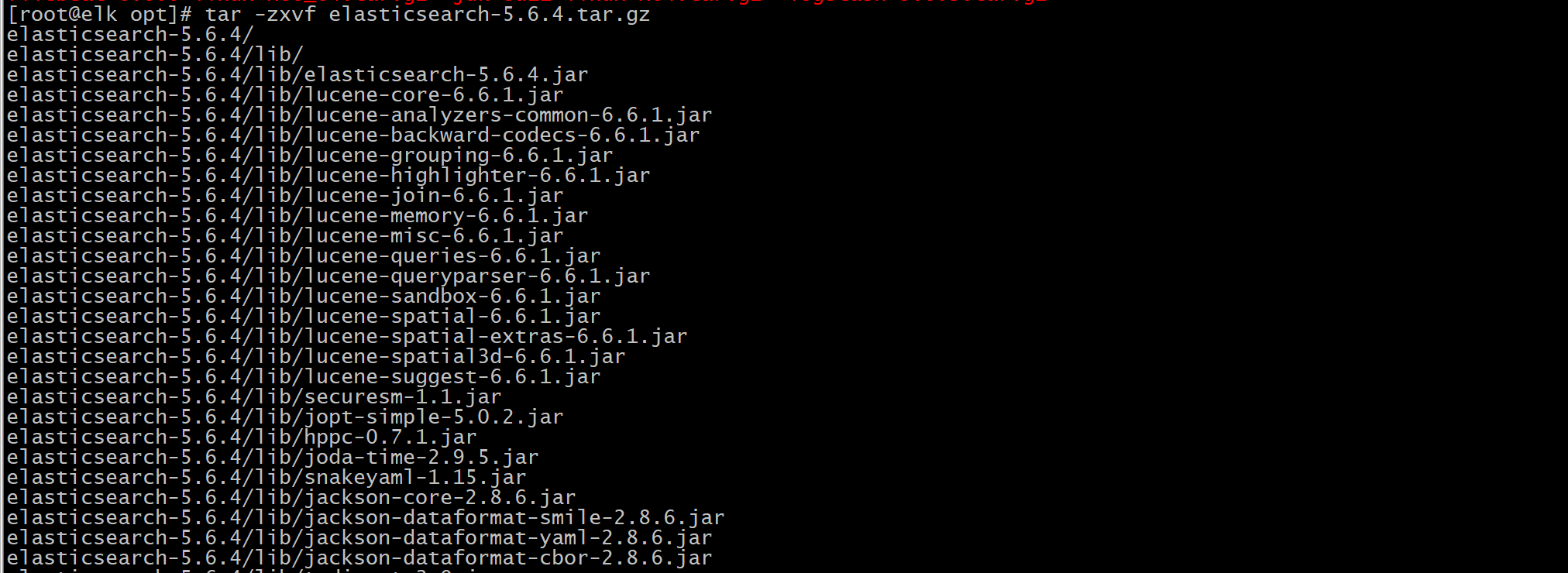

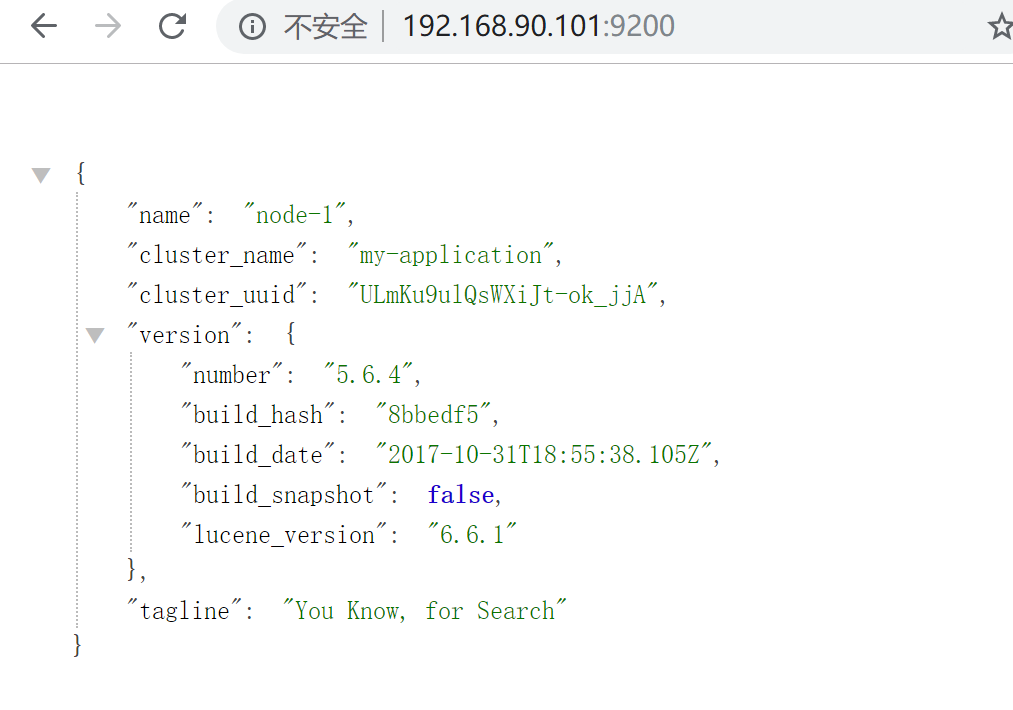

- ES

之前很多的版本都是ES都是2.X和5.X有很大的差别,使用的功能上都有差别。2.X考虑的太久了2001几年吧,5.6还是比较新的。支持的JDK是1.8,ES建议不要使用太新和太久的。ELK中最难装的就是ES。

cd /opt/ tar -zxvf elasticsearch-5.6.4.tar.gz- 1

- 2

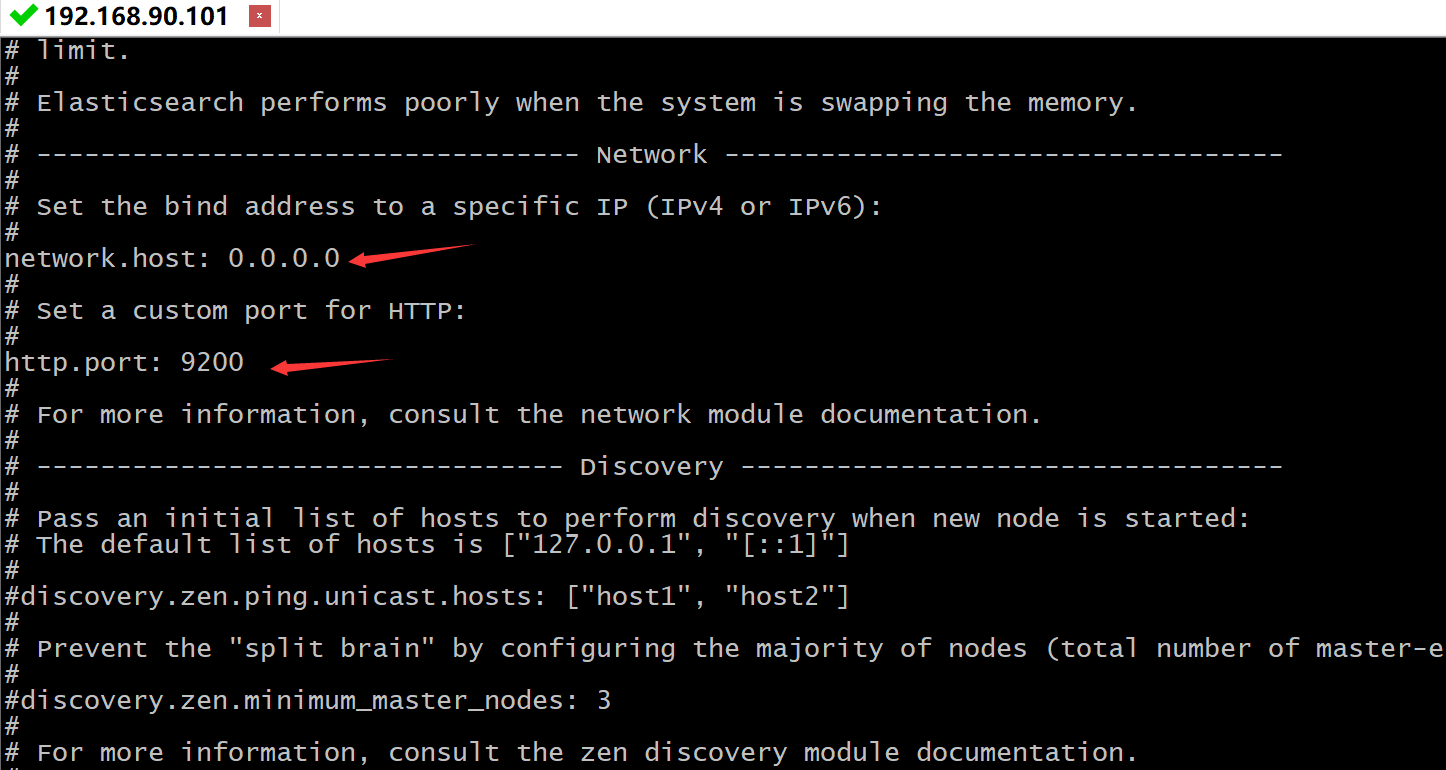

#修改配置 vi config/elasticsearch.yml cluster.name : my-application node.name : node-1 network.host : 0.0.0.0 http.port : 9200- 1

- 2

- 3

- 4

- 5

- 6

ELK中的核心,启动的时候一定要注意,因为es不可以进行root账户启动,所以你还需要重新添加一个账户,我这里是apps

adduser apps passwd apps #密码设置成123- 1

- 2

- 3

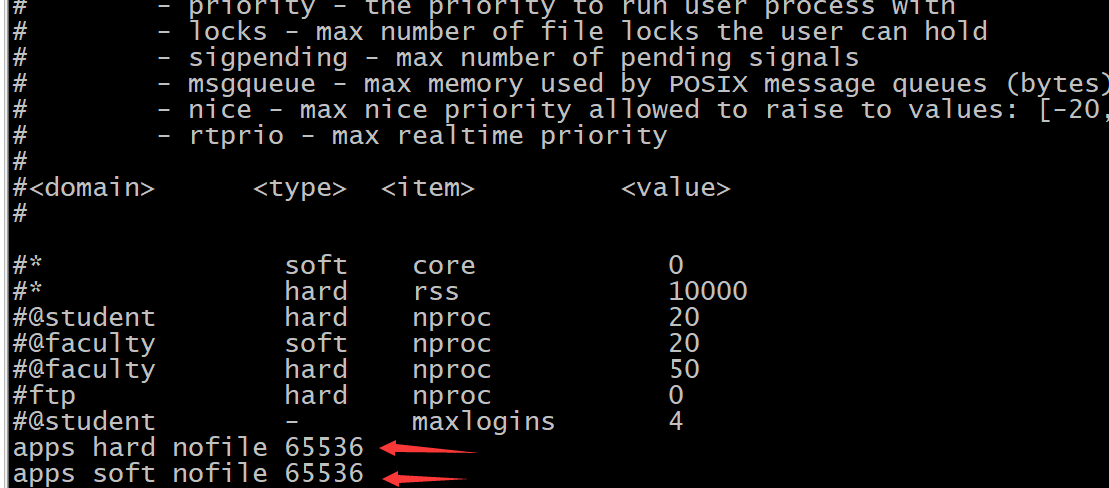

sudo vi /etc/security/limits.conf #添加这些内容,注意这里面的apps这个名称是根据自己定义的来修改的用户名。 apps hard nofile 65536 apps soft nofile 65536- 1

- 2

- 3

- 4

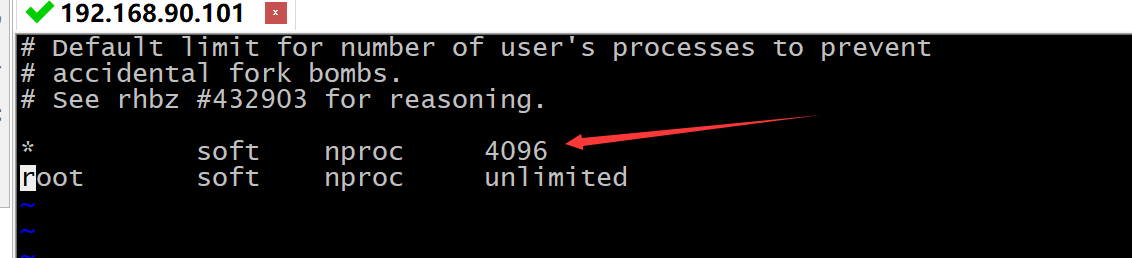

vi /etc/security/limits.d/20-nproc.conf #添加这些内容 * soft nproc 1024 #修改为 * soft nproc 2048- 1

- 2

- 3

- 4

- 5

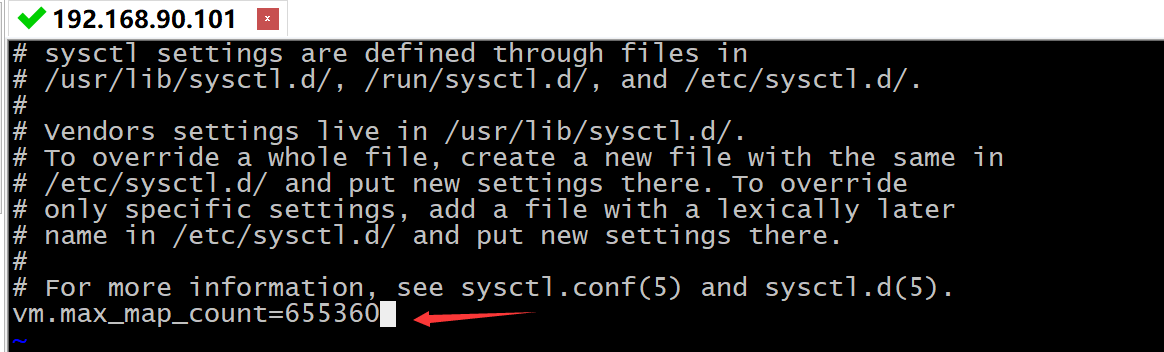

vi /etc/sysctl.conf #添加下面配置 vm.max_map_count=655360 #执行 sysctl -p- 1

- 2

- 3

- 4

- 5

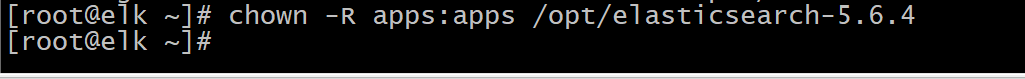

apps增加权限

chown -R apps:apps /opt/elasticsearch-5.6.4- 1

启动ES

./bin/elasticsearch- 1

谷歌插件:elasticsearch-head

- logstash 安装

解压

tar -zxvf logstash-5.6.3.tar.gz- 1

在config目录建:logstash.conf

cd /opt/logstash-5.6.3/config vi logstash.conf- 1

- 2

做好input ,filter,output三大块, 其中input是吸取logs文件下的所有log后缀的日志文件,filter是一个过滤函数,配置则可进行个性化过滤,output配置了导入到hosts为127.0.0.1:9200的elasticsearch中,每天一个索引。start_position是监听的位置,默认是end,即一个文件如果没有记录它的读取信息,则从文件的末尾开始读取,也就是说,仅仅读取新添加的内容。对于一些更新的日志类型的监听,通常直接使用end就可以了;相反,beginning就会从一个文件的头开始读取。但是如果记录过文件的读取信息,则不会从最开始读取。重启读取信息不会丢失。

如果是指定的tomcat,直接到path修改成指定的日志路径名称就可以了。

input { file { type => "log" path => "/apps/svr/servers/logs/*.log" start_position => "beginning" } } output { stdout { codec => rubydebug { } } elasticsearch { hosts => "127.0.0.1" index => "log-%{+YYYY.MM.dd}" } }- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

bin目录下启动logstash了,配置文件设置为conf/logstash.conf,加&后台启动。

cd ./bin/logstash -f ../config/logstash.conf &- 1

- 2

配置多个文件:./logstash -f …/config 指定启动目录,然后启动目录下配置多个*.Conf文件。里面指定不同的logpath。

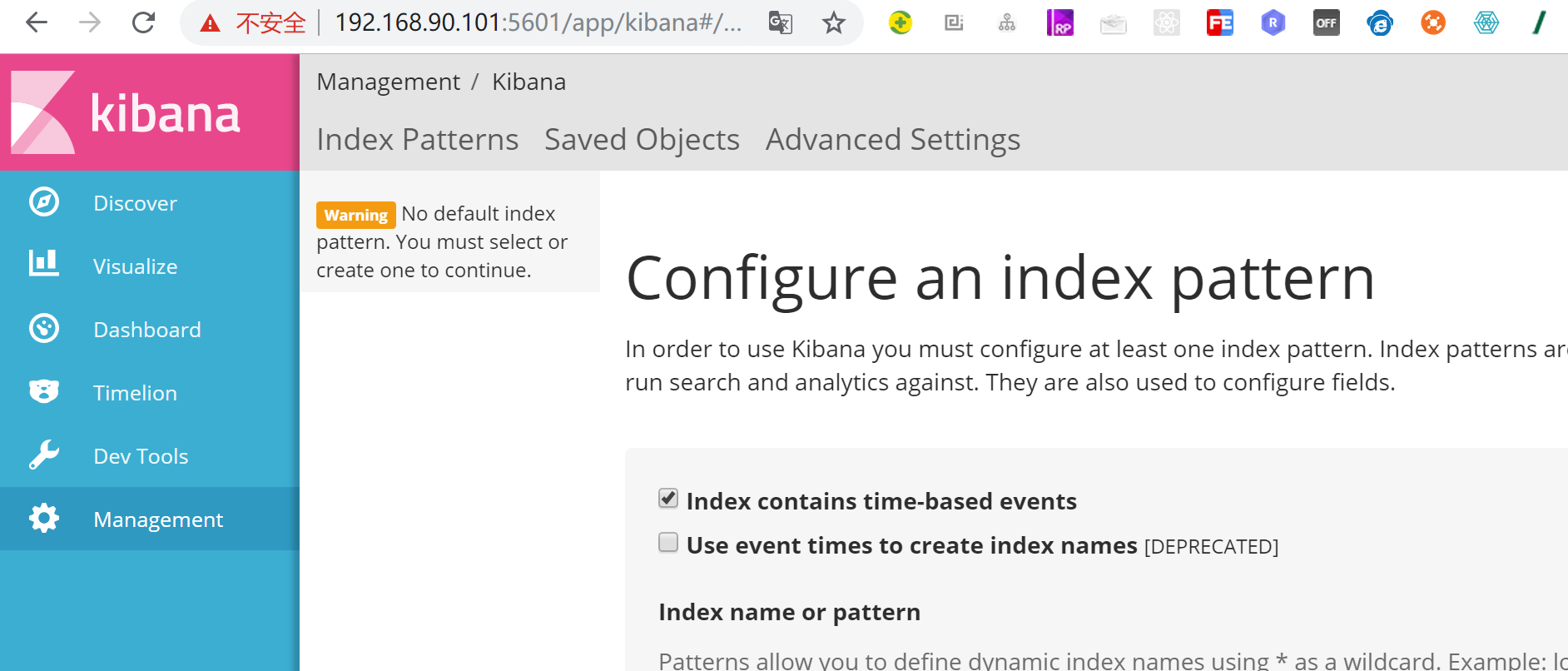

- kibana-5.2.0-linux-x86_64 安装

tar -zxvf /opt/kibana-5.2.0-linux-x86_64.tar.gz- 1

配置kibana,文件中指定一下你需要读取的elasticSearch地址和可供外网访问的bind地址就可以了

cd /opt/kibana-5.2.0-linux-x86_64/bin vi /opt/kibana-5.2.0-linux-x86_64/config/kibana.yml # elasticsearch.url: http://localhost:9200,如果是集群则配置master节点。 # server.host: 0.0.0.0- 1

- 2

- 3

- 4

配置启动

cd /opt/kibana-5.2.0-linux-x86_64/ ./bin/kibana & #如果需要删除指定端口的服务可以这样 # netstat -tlnp|grep 端口- 1

- 2

- 3

- 4

- 5

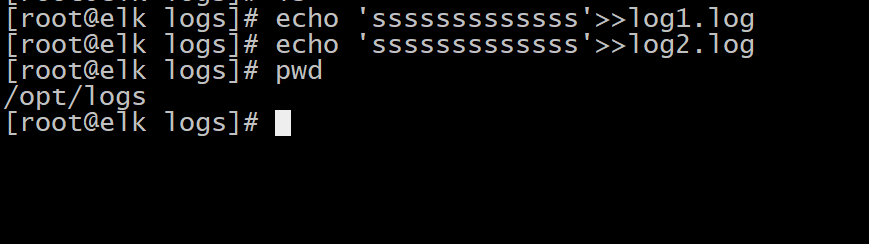

在/opt/logs/写入文件

echo 'ssssssssssss' >> log1.log- 1

#填入log-*,create创建下就可以了。 log-*- 1

- 2

收集到的日志信息

PS:可以监听当前服务器的流量。电脑配置至少4G内存,ES默认是2G的内存,目前是使用的伪分布式的方式,多台电脑也是这样的。

-

相关阅读:

数据在内存如何分布的?

英语——分享篇——每日100词——601-700

“高校”行业智能运维解决方案解析(含落地实践)

2023中国山东·第五届济南国际大健康产业博览会·山东健博会

Python将.arff文件转换为.mat文件

EasyExcel使用实体类进行读操作和写操作

UE5笔记【十】第一个蓝图项目:bluePrint。

取分隔字符后面的字符串-C语言

PCIE下载的驱动安装

科学与财富杂志科学与财富杂志社科学与财富编辑部2022年第27期目录

- 原文地址:https://blog.csdn.net/zhugeaming2018/article/details/126578415