-

Java多线程使用HttpClient技术爬取多个网站的资源

Java多线程使用HttpClient技术爬取多个网站的资源

1、背景介绍

之前的博客已经讲解了多线程的使用,以及用HttpClient爬取网页内容,现在我们将两者结合起来使用,多线程爬取网页资源。

之前的博客链接:

优势

当我们要爬取大量网站的时候,单线程明显上爬取的效率会慢很多,此时如果使用了多线程爬取,我们的程序爬取速率会翻倍。

2、需要的依赖

<dependency> <groupId>org.apache.httpcomponentsgroupId> <artifactId>httpclientartifactId> <version>4.5.8version> dependency> <dependency> <groupId>org.jsoupgroupId> <artifactId>jsoupartifactId> <version>1.10.2version> dependency>- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

3、ThreadHttpClientUtil

解释说明:这里我们List集合用于存储我们要爬取的网站

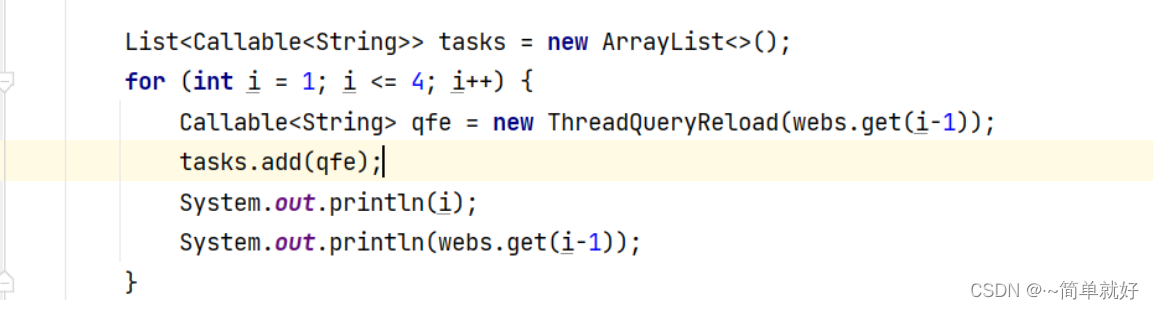

package com.hmdp.httpclienTest.ThreadReload.util; import com.hmdp.utils.ThredQuery; import java.util.ArrayList; import java.util.Collections; import java.util.List; import java.util.concurrent.Callable; import java.util.concurrent.ExecutorService; import java.util.concurrent.Executors; import java.util.concurrent.Future; public class ThreadHttpClientUtil { public static void main(String[] args) throws Exception { //将要爬取的url存在list集合里 List<String> webs = new ArrayList<>(); webs.add("https://taolitop.com/"); webs.add("https://taolitop.com/jj.whtml"); webs.add("https://taolitop.com/dzhrjsjykf.whtml"); webs.add("https://taolitop.com/zxns.whtml"); List<String> result = ThreadHttpClientUtil.getMultiCombineResult(webs); int i=1; for (String html : result) { System.out.println("第"+i+"个网页内容"); System.out.println(html); i++; } } /** * 获取多线程结果并进行结果合并 * @return */ public static List<String> getMultiCombineResult(List<String> webs) throws Exception { //开始时间 long start = System.currentTimeMillis(); //返回结果 List<String> result = new ArrayList<>(); List<Callable<String>> tasks = new ArrayList<>(); for (int i = 1; i <= 4; i++) { Callable<String> qfe = new ThreadQueryReload(webs.get(i-1)); tasks.add(qfe); System.out.println(i); System.out.println(webs.get(i-1)); } try{ //定义固定长度的线程池 防止线程过多,4就够用了 //4条数据,分成4个线程来查询 ExecutorService executorService = Executors.newFixedThreadPool(4); //Future用于获取结果 List<Future<String>> futures=executorService.invokeAll(tasks); //处理线程返回结果 if(futures!=null&&futures.size() > 0){ for (Future<String> future:futures){ result.addAll(Collections.singleton(future.get())); } } //关闭线程池,一定不能忘记 executorService.shutdown(); }catch (Exception e){ e.printStackTrace(); } long end = System.currentTimeMillis(); System.out.println("线程查询数据用时:"+(end-start)+"ms"); return result; } }- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

- 60

- 61

- 62

- 63

- 64

- 65

- 66

- 67

- 68

- 69

- 70

我们以创建4个线程为例,每一个线程去爬取一个网站,这里如果你有大量的数据,可以重新设计,让每一个线程去爬取多个网站,提高效率。我的以每个线程爬取一个网站为例:

4、ThreadQueryReload线程执行类

import com.hmdp.httpclienTest.HttpClientT4; import java.util.concurrent.Callable; public class ThreadQueryReload implements Callable<String> { //每个线程查询出来的数据集合 private String datas; public ThreadQueryReload(String url) throws Exception { String html = HttpClientT4.resultHtml(url); datas=html; } @Override public String call() throws Exception { return datas; } }- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

5、测试

此时:我们将会爬取到每一个网页的内容,同时呢也提高了效率。

-

相关阅读:

解决 Elasticsearch 分页查询记录超过10000时异常

《Qt开发》基于QWT的柱形图绘制

扩散模型浅析

nvm常用命令有哪些?nvm如何切换node版本?nvm如何下载node?nvm安装包

解决windeployqt打包exe的“VCINSTALLDIR is not set“问题

数据结构上机实验——栈和队列的实现、栈和队列的应用、进制转换、约瑟夫环问题

2022最新 Netty底层数据交互源码剖析二

【毕业设计】ESP32单片机疫情防交叉感染洗手液分配系统 -物联网 嵌入式

c# 学习笔记 PropertyChangedEventHandler、 =>、DependencyObject、DataContext

如何衡量算法的优劣??

- 原文地址:https://blog.csdn.net/qq_45830276/article/details/126567914