-

如何评价一个算法的优劣——时间复杂度

算法复杂度包括时间复杂度和空间复杂度。好算法的评判标准就是高效率和低存储,高效率即时间复杂度小,低存储即空间复杂度小。

时间复杂度指算法运行需要的时间。

一般将算法的基本运算执行次数作为时间复杂度的度量标准。

举个栗子:

int sum(int n){ int sum = 0; //1次 for(int i = 1 ; i <= n ; i <++{ // n + 1次 sum += i; // n次 } return sum; //1次 }- 1

- 2

- 3

- 4

- 5

- 6

- 7

总的执行次数为 2 x n + 3。

用一个函数T(n) = 2n + 3表示,算法运行时主要取决于最高项。

→ 如果用时间复杂度的渐进上界O表示,那么该算法的时间复杂度为O(n)。

其实没有必要计算每一行代码的运行次数,只需要计算语句频度最多的语句即可。

再举个栗子:

sum = 0; // 运行1次 total = 0; //运行1次 for(int i = 0 ; i <= n ; i++){ //运行n + 1次,最后1次判断条件不成立,结束。 sum += i; //运行n次 for(j = 1; j <= n ; j ++){ // 运行n*(n+1)次 total = total + i * j; //运行n * n次 } }- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

循环内层的语句往往是运行次数最多的,对运行时间“贡献”最大。

在上面那个栗子中,total = total + i * j 最大,所以只需要计算语句的运行次数即可,该算法的时间复杂度为O(n ^ 2)。

常见的算法时间复杂度如下:

- 常数阶:算法运行的次数是一个常数,O(1)

- 对数阶:时间复杂度运行效率较高,常见的有O(logn)、O(nlogn)。

- 多项式阶:很多算法的时间复杂度是多项式,常见的有O(n)、O(n^2)、O(n ^ 3)

- 指数阶:指数阶时间复杂度运行效率极差。常见的有O(2 ^ n)、O(n!)、O(n ^ n)

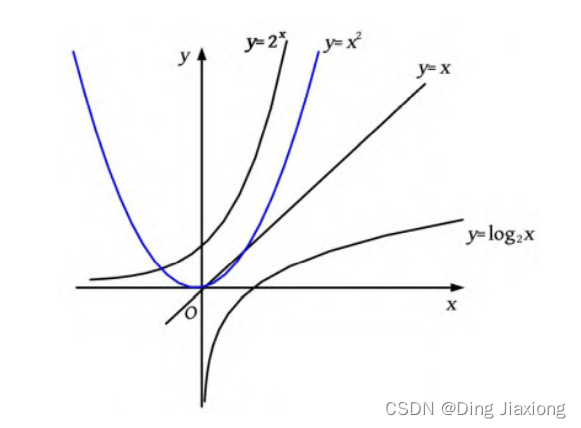

常见的时间复杂度函数曲线:

它们的关系是:

O(1) < O(logn) < O(n) < O(nlogn) < O(n ^ 2) < O(n ^ 3) < O(2 ^ n) < O(n !) < O(n ^ n)

-

相关阅读:

java中线程池的使用+优雅的spring释放资源

css:一个容器(页面),里面有两个div左右摆放并且高度和容器高度一致,左div不会随着页面左右伸缩而变化,右div随页面左右伸缩宽度自适应(手写)

机器视觉工程师能不能去海康做机器视觉?

XML序列化与反序列化接口对接实战,看这篇就够了

Java 调用 PaddleDetection 模型

web前端-javascript-自增++和自减--(a++和++a,都在自身基础上+1,a--和--a都在自增基础上-1,自增和自减的练习)

《Effective C++》条款12

计算机网络八股文(2022最新整理)

职场题:有一件特别紧急的事,群众要办理,且联系不上领导,你怎么办?(1)

大神之路-起始篇 | 第1章.计算机科学导论之【基础绪论】学习笔记

- 原文地址:https://blog.csdn.net/weixin_44226181/article/details/126531160