-

深度学习之神经网络优化方法

1.SGD(根据使用批次样本的不同分为批量BGD、小批量MBGD、随机SGD):

2.动量角度改进方法(类似于行程更新由速度和时间得到,而速度由加速度和时间得到,包括

sgdm和NAG):

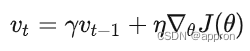

- SGDM(速度由上一时刻速度和当前时刻加速度加权得到):

- NAG(速度由上一时刻速度和下一时刻加速度加权得到):

3.学习率角度改进方法:

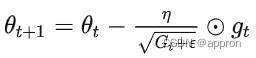

- AdaGrad:G_t是一个对角矩阵,其对角线元素 (i,i) 位置的值 Gt,ii 表示从时间点0到时间点 t 参数 θi 的梯度的平方的和。

- RMSprop:G_t变成了这个加权而非累加的梯度平方和G_t=

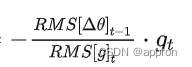

- Adadelta:为了单位一致性,G_t变成了这个全职更新的加权和梯度平方和的加权之比

4.动量和学习率同时改进方法:

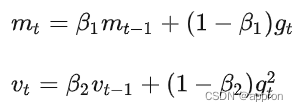

- Adam:RMSprop+SGDM得到速度和学习率范数,然后为了避免初始化后很长一段时间都偏向于0进行校正。

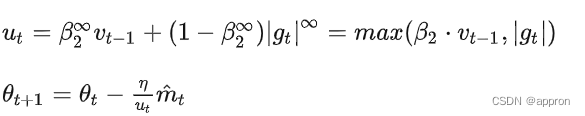

- Adamax:进一步针对偏向于0进行校正。利用v_t的无穷级数u_t代替v_t速度来更新,

- Nadm:将Adam中速度的更新使用NAG方法

- SGDM(速度由上一时刻速度和当前时刻加速度加权得到):

-

相关阅读:

docker-容器相关:运行、启动、停止、进入、导出和导入、删除

正则表达式中的元字符,量词:贪婪和非贪婪,转义符: \s: 记得使用-z --null-data: 使用ascii码中空字符来替换新行,分组:““,和‘‘

17.RedHat认证-Ansible自动化运维(下)

2023火锅展/江西火锅食材展/中国火锅展/火锅用品展

【JavaScript 逆向】猿人学 web 第五题:乱码增强

电脑重装系统c盘如何备份资料

iNFTnews|传统Web2品牌商如何进军元宇宙?

前后端分离项目使用宝塔部署

面向对象进阶

读书笔记:《海龟交易法则》

- 原文地址:https://blog.csdn.net/pingguolou/article/details/126462638