-

学习笔记:机器学习之支持向量机(五、线性支持向量机-合页损失函数)

活动地址:CSDN21天学习挑战赛

1 合页损失函数

前一节是通过解决凸二次规划问题获得分类超平面,线性支持向量机还有另一种解释方式,最小化以下目标函数:

∑ i = 1 N [ 1 − y i ( w ⋅ x i + b ) ] + + λ ∣ ∣ w ∣ ∣ 2 \sum^N_{i=1}[1-y_i(w\cdot x_i+b)]_++\lambda||w||^2 i=1∑N[1−yi(w⋅xi+b)]++λ∣∣w∣∣2

L ( y ( w ⋅ x + b ) ) = [ 1 − y ( w ⋅ x + b ) ] + L(y(w \cdot x+b))=[1-y(w \cdot x+b)]_{+} L(y(w⋅x+b))=[1−y(w⋅x+b)]+称为合页损失函数(hinge loss function)

[ z ] + = { z , z > 0 0 , z ⩽ 0 [z]_{+}=\left\{\right. [z]+={z,0,z>0z⩽0,"+"表示取正值,其他取值为0。z , z > 0 0 , z ⩽ 0

用合页损失函数对原来的目标函数进行变换:

min w , b C ∑ i = 1 N [ 1 − y i ( w ⋅ x i + b ) ] + + ∥ w ∥ 2 2 \min _{w, b}C \sum_{i=1}^{N}\left[1-y_{i}\left(w \cdot x_{i}+b\right)\right]_{+}+\frac{\|w\|^{2}}{2} w,bminCi=1∑N[1−yi(w⋅xi+b)]++2∥w∥2

令 1 2 C = λ \frac{1}{2C}=\lambda 2C1=λ,则:

min w , b ∑ i = 1 N [ 1 − y i ( w ⋅ x i + b ) ] + + λ ∥ w ∥ 2 \min _{w, b} \sum_{i=1}^{N}\left[1-y_{i}\left(w \cdot x_{i}+b\right)\right]_{+}+\lambda\|w\|^{2} w,bmini=1∑N[1−yi(w⋅xi+b)]++λ∥w∥22 三个损失函数的比较

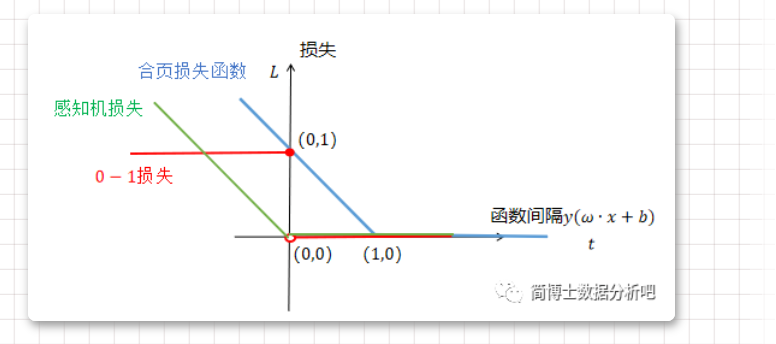

0-1损失函数、感知机损失函数、合页损失函数的比较。

对于合页损失函数来说,只有函数间隔小于1时,损失值为1-t,由此可见SVM不仅要求分类正确还要确信度尽可能高。参考

1.《统计学习方法》——李航

2. https://mp.weixin.qq.com/s/mbjigfoc-SXJ6QsR0tc96A -

相关阅读:

小程序+Php获取微信手机号

day05-离线留言和离线文件

好物周刊#13:免费下载软件

JVM - 内存模型

阿里云配置https,配置SSL证书

什么是智能密码钥匙?Ukey的主要功能? 安当加密

ArcGIS:如何制作数据统计图?

低代码开发平台助力生产管理:采购成本管理的优化

搓一个Pythonic list

质量平台-sonarlint-接入项目gitlab配置

- 原文地址:https://blog.csdn.net/qq_44635691/article/details/126428683