-

【机器学习】什么是随机马尔科夫决策过程?

系列文章目录

第十八章 Python 机器学习入门之强化学习

目录

前言

马尔科夫决策过程是基于马尔科夫过程理论的随机动态系统的最优决策过程。马尔科夫决策过程是序贯决策的主要研究领域。它是马尔科夫与确定性的动态规划相结合的产物,故又称马尔科夫型随机动态规划,属于运筹学中数学规划的一个分支。

序贯决策——有些决策问题,决策者只需要作一次决策即可,这类决策方法称单阶段决策。但是很多时候,不仅需要单阶段决策,更需要进行多阶段决策,即序贯决策。

一、什么是 随机马尔科夫决策过程

随机马尔科夫决策过程 也就是 强化学习应用程序中的动作。

我们简化的火星探测器示例,如果它在状态4,如果我们让它往左走,那么它有90%的概率向左,也有10%的概率向右走;如果我们让它往右走,那么它有90%的概率向右,也有10%的概率向左走。

这将是一个随机环境的例子,

让我们看看这个强化学习问题会发生什么?

如果在状态4,你让它向左走,它可能一直向左走,并到达状态1,终端位置;

也可能你让它向左走,它第一步向左,到达状态3 ,第二步向左,它滑倒了并往右走回到了状态4,接着再往左走,一直到状态1;

也可能让它向左走,它滑倒了并向右走了一步到达状态5,接着向右走到达状态6,终端位置。

二、随机马尔科夫决策过程的重点

我们之前将总回报写为折扣奖励的总和,但是当强化问题是随机的时候,奖励数列也不是固定的,我们可能会看到不同的奖励序列。

在随机强化问题中,我们感兴趣的不是最大化回报,因为那是一个随机数,我们感兴趣的是最大化折扣奖励总和的平均值。

这个平均价值的意思是,如果我们进行很多次随机强化学习,我们可能会得到许多不同的奖励序列,如果你要对所有这些折扣奖励的的组合的 不同的序列取平均值,这就是我们所说的预期回报(expected return)。预期就是表示平均值的意思。这意味着我们想要最大化我们平均期望得到的折扣奖励的总和。

如上图,我们可以将公式写成E[ ] ,强化学习算法的工作是选择一个策略Pi来最大化,折扣奖励的平均或预期总和。

如果我们遇到随机强化学习问题或一个随机马尔科夫决策过程,目标是选择一个策略Pi, 告诉我们在状态S 中采取什么行动A 以最大化预期收益。

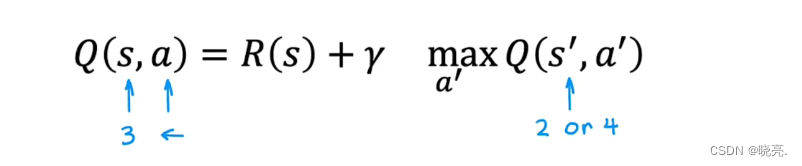

对于随机马尔科夫决策问题,贝尔曼方程也需要进行修改,

起始下一步的状态S' 是随机的,如果起始状态是3,那么下一步状态可能是2也可能是4.

其中,R(S)表示马上得到的奖励,也叫做即时奖励;gamma 表示折扣系数γ;Q(s',a')表示我们期望获得的平均未来回报。

总结

随机马尔科夫决策过程有一个特点,我们知道随机马尔科夫决策过程 也就是 强化学习应用程序中的动作的随机性,就像上面说的序贯决策。

在前面说的马尔科夫决策过程中,也就是强化学习中,只需要做出判断行动一次就会得到最佳的结果,而随机马尔科夫决策过程不同,我们要进行多次选择,选择合适的动作。

-

相关阅读:

数据库设备列表的某设备在EasyCVR不显示?原来是垃圾数据,需立刻清理

【数据结构】二叉树

关于深度学习中概念【训练集】【验证集】【测试集】【参数】【超参数】的理解

你与网站建立的链接并非完全安全?建议全站开启https

群论学习记录

Xcode中给UIView在xib中添加可视化的属性

杭电oj 2037 今年暑假不AC C语言

外汇天眼:喜报!外汇天眼获得菲律宾官方“值得信赖的外汇交易商查询平台”奖项

解析DNA甲基化临床科研 | 无论什么科室,一定要有project的经典视角|易基因

git pull 拉取项目的时候 失败说有冲突 但是不知道哪冲突了

- 原文地址:https://blog.csdn.net/m0_51816252/article/details/126401559