-

Trino 391 安装配置

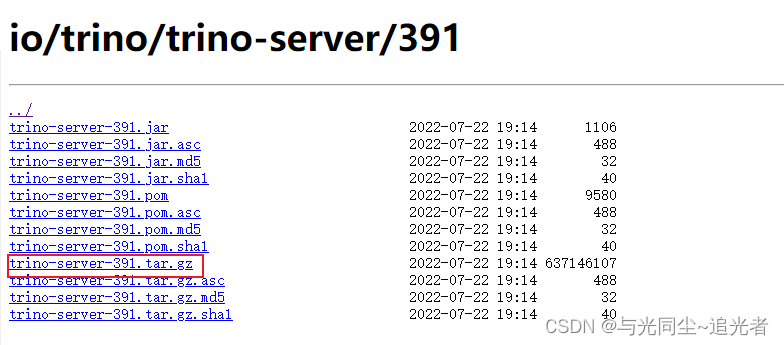

一、下载

https://repo1.maven.org/maven2/io/trino/trino-server/391/

二、环境要求

2.1 Linux操作系统

-

需要 64 位

-

为运行 Trino 进程的用户提供足够的 ulimit

- vim /etc/security/limits.conf

- trino soft nofile 131072

- trino hard nofile 131072

2.2 Java运行环境

-

Trino 需要 64 位版本的 Java 17,最低要求版本为 17.0.3。Java 8 或 Java 11 等早期主要版本不起作用。不支持较新的主要版本,例如 Java 18 或 19——它们可能工作,但未经测试

2.3 Python

-

版本 2.6.x、2.7.x 或 3.x

-

bin/launcher仅脚本需要

三、上传trino和jdk11安装包

- tar -zxf trino-server-391.tar.gz -C /opt/module/

- tar -zxf jdk-17_linux-x64_bin.tar.gz -C /opt/module/

- #jdk17下载地址

- https://www.oracle.com/java/technologies/downloads/#java17

四、Trino配置

在安装目录中创建一个

etc目录,并在etc下创建一个catalog目录4.1 config.properties

- #coordinator

- coordinator=true

- node-scheduler.include-coordinator=true #true:表示既是coordinator又是worker false:仅是coordinator

- http-server.http.port=8080

- query.max-memory=10GB

- query.max-memory-per-node=5GB

- discovery-server.enabled=true

- discovery.uri=http://bigdata01:8080

- web-ui.authentication.type=fixed

- web-ui.user=hadoop

- #workers

- coordinator=false

- http-server.http.port=8080

- query.max-memory=10GB

- query.max-memory-per-node=5GB

- discovery.uri=http://bigdata01:8080

4.2 node.properties

- node.environment=bigdata_test

- node.id=bigdata01

- node.data-dir=/data/trino/data

上述属性描述如下:

-

node.environment: 环境的名称。集群中的所有 Trino 节点必须具有相同的环境名称。名称必须以小写字母数字字符开头,并且仅包含小写字母数字或下划线 (_) 字符。 -

node.id:此安装 Trino 的唯一标识符。这对于每个节点必须是唯一的。此标识符应在 Trino 重新启动或升级期间保持一致。如果在一台机器上运行多个 Trino 安装(即同一台机器上的多个节点),每个安装必须有一个唯一的标识符。标识符必须以字母数字字符开头,并且只能包含字母数字-、 或_字符。 -

node.data-dir:数据目录的位置(文件系统路径)。Trino 在此处存储日志和其他数据。

4.3 jvm.config

- -server

- -Xmx10G

- -XX:InitialRAMPercentage=80

- -XX:MaxRAMPercentage=80

- -XX:G1HeapRegionSize=32M

- -XX:+ExplicitGCInvokesConcurrent

- -XX:+ExitOnOutOfMemoryError

- -XX:+HeapDumpOnOutOfMemoryError

- -XX:-OmitStackTraceInFastThrow

- -XX:ReservedCodeCacheSize=512M

- -XX:PerMethodRecompilationCutoff=10000

- -XX:PerBytecodeRecompilationCutoff=10000

- -Djdk.attach.allowAttachSelf=true

- -Djdk.nio.maxCachedBufferSize=2000000

- -XX:+UnlockDiagnosticVMOptions

- -XX:+UseAESCTRIntrinsics

4.4 log.properties

io.trino=INFO默认的最低级别是

INFO,有四个级别:DEBUG,INFO,WARNandERROR4.5 catalog目录下相关配置

- #clickhouse.properties

- connector.name=clickhouse

- connection-url=jdbc:clickhouse://bigdata03:8123/

- connection-user=default

- connection-password=xxx

- clickhouse.map-string-as-varchar=true

- #doris.properties

- connector.name=mysql

- connection-url=jdbc:mysql://bigdata03:9030

- connection-user=xxxx

- connection-password=xxxx

- #hive.properties

- connector.name=hive

- hive.metastore.uri=thrift://bigdata01:9083,thrift://bigdata02:9083

- hive.config.resources=/opt/module/hadoop-3.3.3/etc/hadoop/core-site.xml,/opt/module/hadoop-3.3.3/etc/hadoop/hdfs-site.xml

- hive.allow-drop-table=true

- hive.recursive-directories=true

- hive.insert-existing-partitions-behavior=OVERWRITE

- hive.storage-format=PARQUET

- hive.compression-codec=SNAPPY

- hive.non-managed-table-writes-enabled=true

- hive.translate-hive-views=true

- hive.validate-bucketing=false

- hive.parquet.use-column-names=false

- #jmx.properties

- connector.name=jmx

- jmx.dump-tables=java.lang:type=Runtime,trino.execution.scheduler:name=NodeScheduler

- jmx.dump-period=10s

- jmx.max-entries=86400

- #mongodb.properties

- connector.name=mongodb

- mongodb.connection-url=mongodb://xxxxx:27017/

五、启动

注意:因为使用的jdk1.8的 所以需要在bin/launcher执行文件中添加jdk17的路径

PATH=/opt/module/jdk-17.0.4/bin:$PATH

- #运行以下命令作为守护进程启动

- bin/launcher start

- #前台运行,将日志和其他输出

- bin/launcher run

六、遇到的问题

6.1 Unable to create input format org.apache.hadoop.mapred.TextInputFormat

- 解决:

- 1、找到hadoop下的hadoop-lzo-0.4.21-SNAPSHOT.jar包

- 2、将hadoop-lzo-0.4.21-SNAPSHOT.jar包复制到trino/plugin/hive/下

- 3、重启trino

-

-

相关阅读:

web前端-javascript-运算符(介绍说明,算术运算符、+、-、*、/、%,隐式类型转换、转换为String、转换为Number)

并发bug之源(二)-有序性

Vue急速入门-5

MyBatis学习:动态SQL中<if>标签的使用

IB数学与音乐的融合

判断子序列

对于一个即将上线的网站,如何测试

(提供数据集下载)基于大语言模型LangChain与ChatGLM3-6B本地知识库调优:数据集优化、参数调整、Prompt提示词优化实战

生物医药行业密钥管理系统特点 安当加密

手写验证码(附代码)

- 原文地址:https://blog.csdn.net/qq_37056683/article/details/126399379