-

Uinux网络模型-IO模型

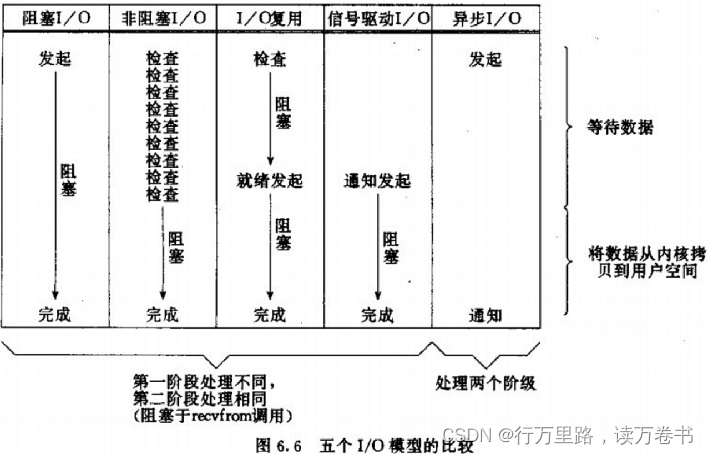

在《UNIX网络编程》一书中,总结归纳了5种IO模型:

- 阻塞IO(Blocking IO)

- 非阻塞IO(Nonblocking IO)

- IO多路复用(IO Multiplexing)

- 信号驱动IO(Signal Driven IO)

- 异步IO(Asynchronous IO)

1. 阻塞IO

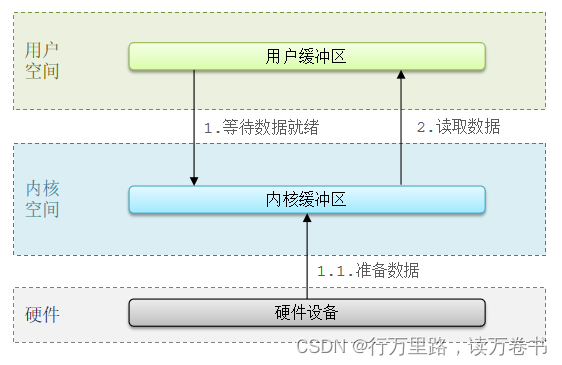

顾名思义,阻塞IO就是两个阶段都必须阻塞等待:

阶段一:

- 用户进程尝试读取数据(比如网卡数据)

- 此时数据尚未到达,内核需要等待数据

- 此时用户进程也处于阻塞状态

阶段二:

- 数据到达并拷贝到内核缓冲区,代表已就绪

- 将内核数据拷贝到用户缓冲区

- 拷贝过程中,用户进程依然阻塞等待

- 拷贝完成,用户进程解除阻塞,处理数据

可以看到,阻塞IO模型中,用户进程在两个阶段都是阻塞状态。

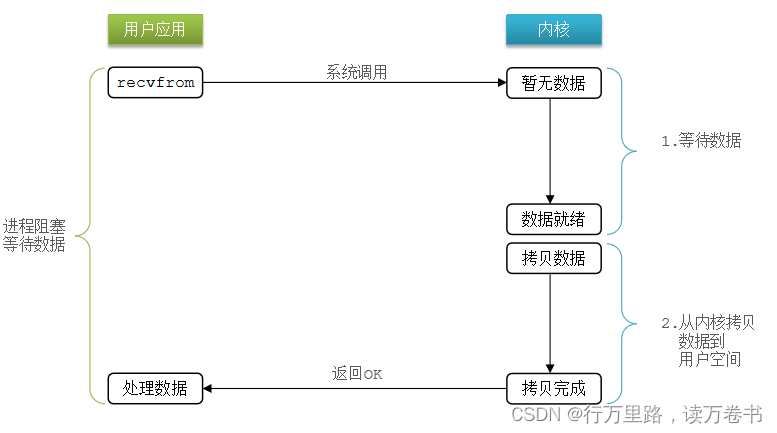

2. 非阻塞IO

顾名思义,非阻塞IO的recvfrom操作会立即返回结果而不是阻塞用户进程。

阶段一:

- 用户进程尝试读取数据(比如网卡数据)

- 此时数据尚未到达,内核需要等待数据

- 返回异常给用户进程

- 用户进程拿到error后,再次尝试读取

- 循环往复,直到数据就绪

阶段二:

- 将内核数据拷贝到用户缓冲区

- 拷贝过程中,用户进程依然阻塞等待

- 拷贝完成,用户进程解除阻塞,处理数据、

可以看到,非阻塞IO模型中,用户进程在第一个阶段是非阻塞,第二个阶段是阻塞状态。虽然是非阻塞,但性能并没有得到提高。而且忙等机制会导致CPU空转,CPU使用率暴增。

在这里插入图片描述

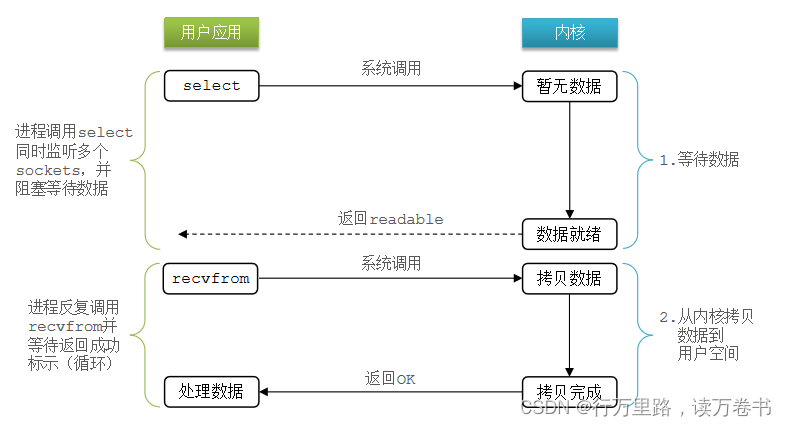

3. IO多路复用

无论是阻塞IO还是非阻塞IO,用户应用在一阶段都需要调用recvfrom来获取数据,差别在于无数据时的处理方案:

- 如果调用recvfrom时,恰好没有数据,阻塞IO会使CPU阻塞,非阻塞IO使CPU空转,都不能充分发挥CPU的作用。

- 如果调用recvfrom时,恰好有数据,则用户进程可以直接进入第二阶段,读取并处理数据

而在单线程情况下,只能依次处理IO事件,如果正在处理的IO事件恰好未就绪(数据不可读或不可写),线程就会被阻塞,所有IO事件都必须等待,性能自然会很差。

就比如服务员给顾客点餐,分两步:

- 顾客思考要吃什么(等待数据就绪)

- 顾客想好了,开始点餐(读取数据)

要提高效率有几种办法?

- 方案一:增加更多服务员(多线程)

- 方案二:不排队,谁想好了吃什么(数据就绪了),服务员就给谁点餐(用户应用就去读取数据)

那么问题来了:用户进程如何知道内核中数据是否就绪呢?

文件描述符(File Descriptor):简称FD,是一个从0 开始的无符号整数,用来关联Linux中的一个文件。在Linux中,一切皆文件,例如常规文件、视频、硬件设备等,当然也包括网络套接字(Socket)。

IO多路复用:是利用单个线程来同时监听多个FD,并在某个FD可读、可写时得到通知,从而避免无效的等待,充分利用CPU资源。

阶段一:

- 用户进程调用select,指定要监听的FD集合

- 内核监听FD对应的多个socket

- 任意一个或多个socket数据就绪则返回readable

- 此过程中用户进程阻塞

阶段二:

- 用户进程找到就绪的socket

- 依次调用recvfrom读取数据

- 内核将数据拷贝到用户空间

- 用户进程处理数据

不过监听FD的方式、通知的方式又有多种实现,常见的有:

- select

- poll

- epoll

差异:

- select和poll只会通知用户进程有FD就绪,但不确定具体是哪个FD,需要用户进程逐个遍历FD来确认

- epoll则会在通知用户进程FD就绪的同时,把已就绪的FD写入用户空间

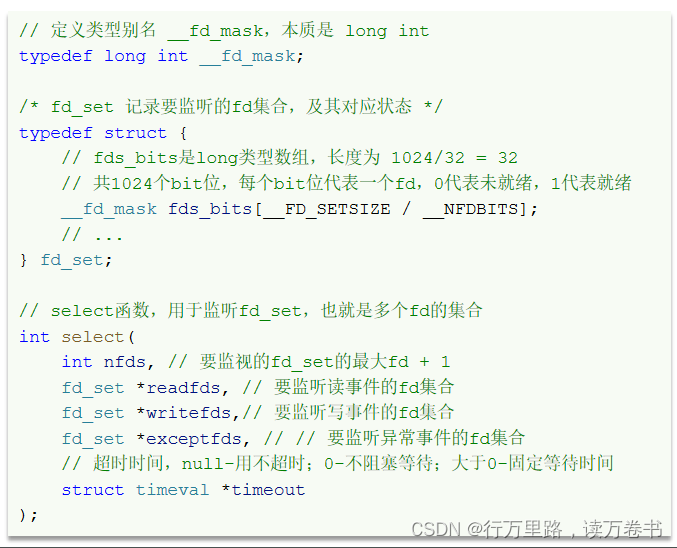

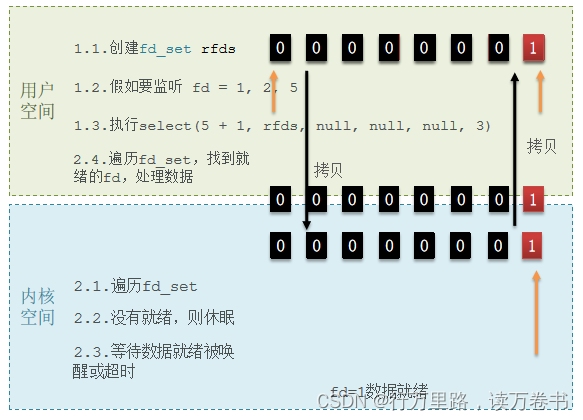

3.1 IO多路复用-select

select是Linux中最早的I/O多路复用实现方案:

select模式存在的问题:- 需要将整个fd_set从用户空间拷贝到内核空间,select结束还要再次拷贝回用户空间

- select无法得知具体是哪个fd就绪,需要遍历整个fd_set

- fd_set监听的fd数量不能超过1024

3.2 IO多路复用-poll

poll模式对select模式做了简单改进,但性能提升不明显,部分关键代码如下:

IO流程:

- 创建pollfd数组,向其中添加关注的fd信息,数组大小自定义

- 调用poll函数,将pollfd数组拷贝到内核空间,转链表存储,无上限

- 内核遍历fd,判断是否就绪

- 数据就绪或超时后,拷贝pollfd数组到用户空间,返回就绪fd数量n

- 用户进程判断n是否大于0

- 大于0则遍历pollfd数组,找到就绪的fd

与select对比:

- select模式中的fd_set大小固定为1024,而pollfd在内核中采用链表,理论上无上限

- 监听FD越多,每次遍历消耗时间也越久,性能反而会下降

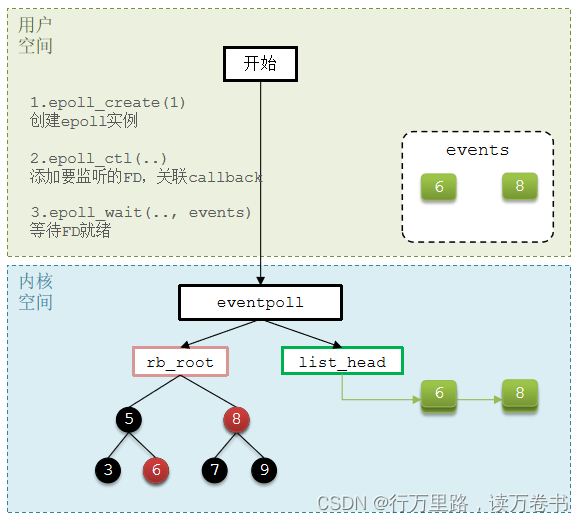

3.3 IO多路复用-epoll

epoll模式是对select和poll的改进,它提供了三个函数:

3.4 总结

select模式存在的三个问题:

- 能监听的FD最大不超过1024

- 每次select都需要把所有要监听的FD都拷贝到内核空间

- 每次都要遍历所有FD来判断就绪状态

poll模式的问题:

- poll利用链表解决了select中监听FD上限的问题,但依然要遍历所有FD,如果监听较多,性能会下降

epoll模式中如何解决这些问题的?

- 基于epoll实例中的红黑树保存要监听的FD,理论上无上限,而且增删改查效率都非常高

- 每个FD只需要执行一次epoll_ctl添加到红黑树,以后每次epol_wait无需传递任何参数,无需重复拷贝FD到内核空间

- 利用ep_poll_callback机制来监听FD状态,无需遍历所有FD,因此性能不会随监听的FD数量增多而下降

3.5 IO多路复用-事件通知机制

当FD有数据可读时,我们调用epoll_wait(或者select、poll)可以得到通知。但是事件通知的模式有两种:

- LevelTriggered:简称LT,也叫做水平触发。只要某个FD中有数据可读,每次调用epoll_wait都会得到通知。

- EdgeTriggered:简称ET,也叫做边沿触发。只有在某个FD有状态变化时,调用epoll_wait才会被通知

举个栗子:

- 假设一个客户端socket对应的FD已经注册到了epoll实例中

- 客户端socket发送了2kb的数据

- 服务端调用epoll_wait,得到通知说FD就绪

- 服务端从FD读取了1kb数据

- 回到步骤3(再次调用epoll_wait,形成循环)

结果:

- 如果我们采用LT模式,因为FD中仍有1kb数据,则第⑤步依然会返回结果,并且得到通知

- 如果我们采用ET模式,因为第③步已经消费了FD可读事件,第⑤步FD状态没有变化,因此epoll_wait不会返回,数据无法读取,客户端响应超时。

结论

- LT:事件通知频率较高,会有重复通知,影响性能

- ET:仅通知一次,效率高。可以基于非阻塞IO循环读取解决数据读取不完整问题

- select和poll仅支持LT模式,epoll可以自由选择LT和ET两种模式

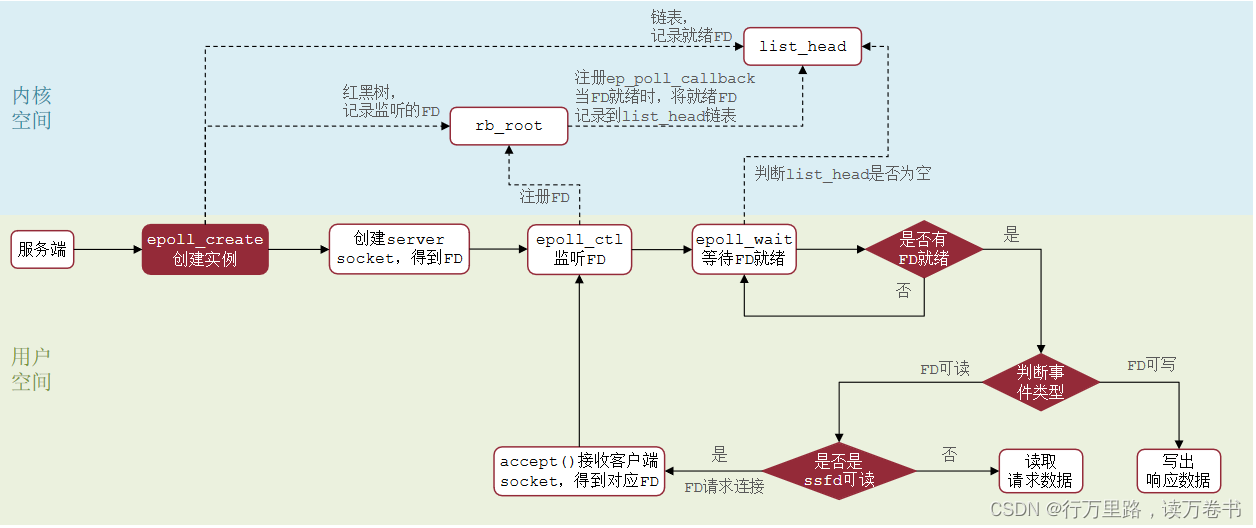

3.6 IO多路复用-web服务流程

基于epoll模式的web服务的基本流程如图:

4.信号驱动IO

信号驱动IO是与内核建立SIGIO的信号关联并设置回调,当内核有FD就绪时,会发出SIGIO信号通知用户,期间用户应用可以执行其它业务,无需阻塞等待。

阶段一:- 用户进程调用sigaction,注册信号处理函数

- 内核返回成功,开始监听FD

- 用户进程不阻塞等待,可以执行其它业务

- 当内核数据就绪后,回调用户进程的SIGIO处理函数

阶段二:

- 收到SIGIO回调信号

- 调用recvfrom,读取

- 内核将数据拷贝到用户空间

- 用户进程处理数据

缺点:当有大量IO操作时,信号较多,SIGIO处理函数不能及时处理可能导致信号队列溢出,而且内核空间与用户空间的频繁信号交互性能也较低。

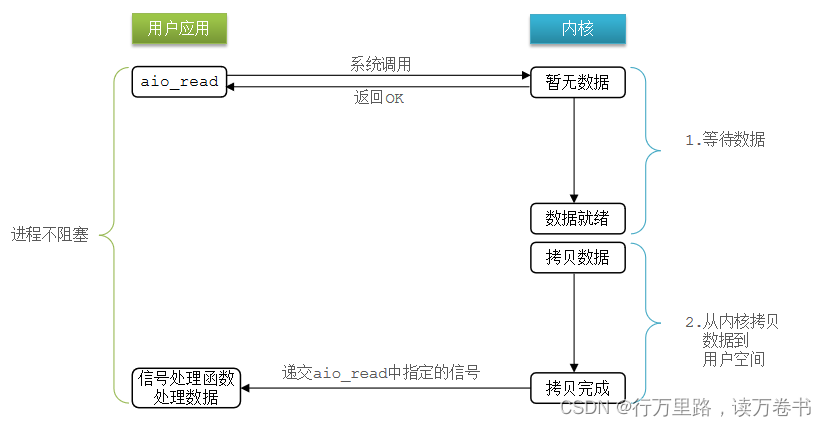

5. 异步IO

异步IO的整个过程都是非阻塞的,用户进程调用完异步API后就可以去做其它事情,内核等待数据就绪并拷贝到用户空间后才会递交信号,通知用户进程。

阶段一:

- 用户进程调用aio_read,创建信号回调函数

- 内核等待数据就绪

- 用户进程无需阻塞,可以做任何事情

阶段二:

- 内核数据就绪

- 内核数据拷贝到用户缓冲区

- 拷贝完成,内核递交信号触发aio_read中的回调函数

- 用户进程处理数据

可以看到,异步IO模型中,用户进程在两个阶段都是非阻塞状态。

5.1 同步和异步

IO操作是同步还是异步,关键看数据在内核空间与用户空间的拷贝过程(数据读写的IO操作),也就是阶段二是同步还是异步:

-

相关阅读:

金蝶云星空和管易云接口打通对接实战

为什么golang不支持可重入锁

调整elment-ui的表头字体大小

Kotlin inline、noinline、crossinline 深入解析

node笔记记录28aynsc和await之3

DSL查询文档

【爬坑之路一】windows系统下更新升级node版本【亲测有效】

PLC 学习day02 硬件输入/输入的知识

【Docker 基础教程】容器数据持久化(一)------ 数据持久化概述

Go语言中JSON的反序列化规则

- 原文地址:https://blog.csdn.net/qq_40742428/article/details/126329226