-

Spark Windos模式

由于在学习时,每次都需要启动虚拟机,启动集群,这是一个比较繁琐的过程,并且会占大量的系统资源,导致系统执行变慢,不仅仅影响学习效果,也影响学习进度,Spark 非常暖心地提供了可以在 windows 系统下启动本地集群的方式,这样,在不使用虚拟机的情况下,也能学习 Spark 的基本使用

1 解压缩文件

将文件 spark-3.0.0-bin-hadoop3.2.tgz 解压缩到无中文无空格的路径中

链接:https://pan.baidu.com/s/1Vi9bgI1KXxoI1zYUGybo5w 提取码:s6w0- 1

- 2

2 准备数据

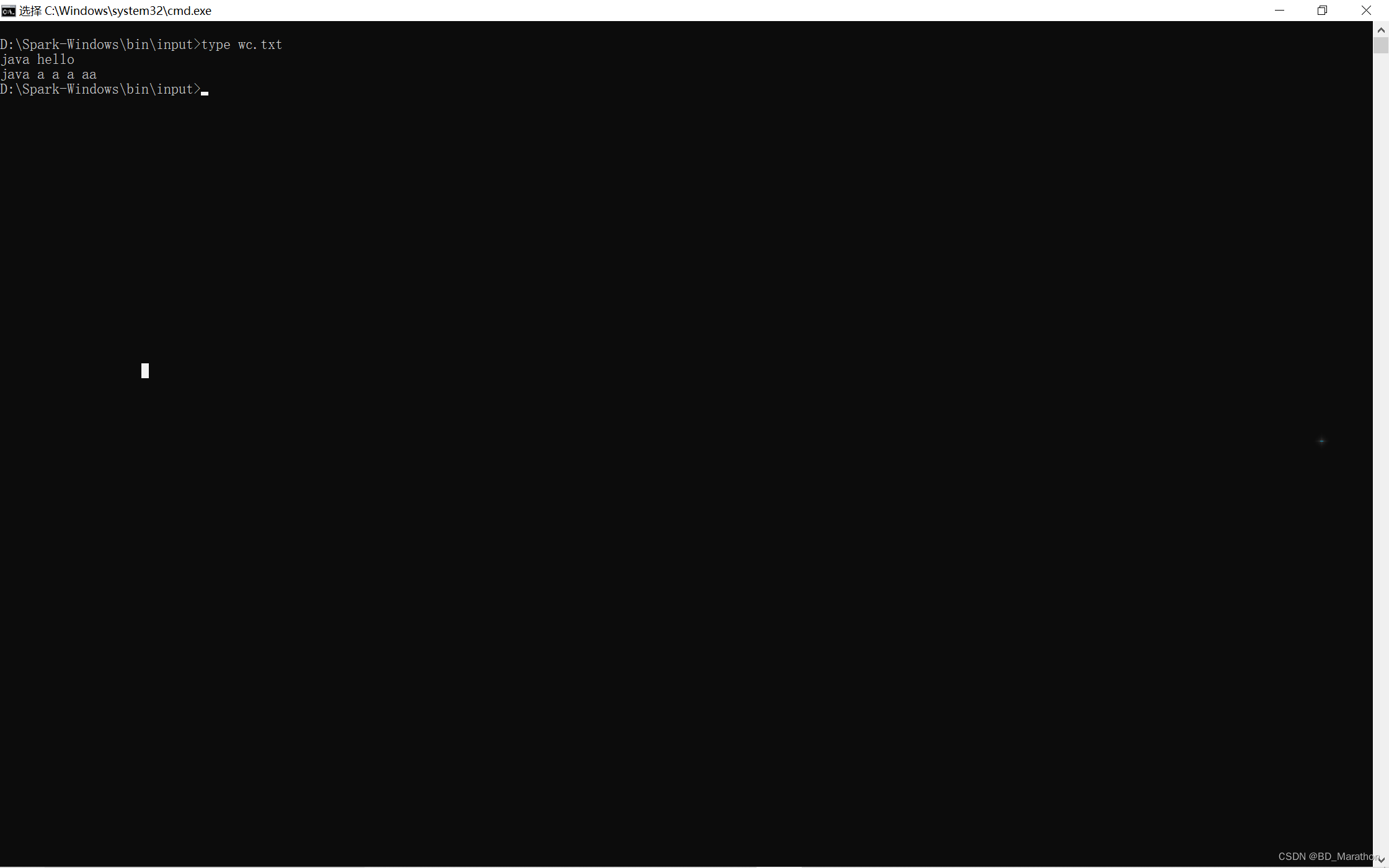

在 bin 目录中创建 input 目录,并添加 wc.txt 文件,文件中添加如下单词

java hello java a a a aa- 1

- 2

3 编写代码并且打包

package SparkCore.Demand import org.apache.spark.rdd.RDD import org.apache.spark.{SparkConf, SparkContext} object WordCount { def main(args: Array[String]): Unit = { val sc = new SparkContext(new SparkConf().setAppName("").setMaster("local[*]")) val rdd: RDD[String] = sc.textFile("D:\\Spark-Windows\\bin\\input").flatMap(_.split(" ")) rdd.map((_, 1)).reduceByKey(_ + _).collect().foreach(println) }}- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

4 命令行提交应用

spark-submit --class SparkCore.Demand.WordCount --master local[*] Spark-1.0-SNAPSHOT.jar- 1

5 查看结果

-

相关阅读:

升级Jenkins从2.263.3到2.440.2

[译]这几个CSS小技巧,你知道吗?

最新文章合集

【Qt控件之QTabBar】介绍及使用

运动蓝牙耳机哪个品牌好?推荐五款好用的运动耳机

cocos creater 2.4 Error Bundle resources doesn‘t contain

代码研发规范考试

Qgis 开发初级 《ToolBox》

设计模式之组合模式与观察者模式应用例题

平安校园智慧安防监控摄像头的布控建议

- 原文地址:https://blog.csdn.net/qq_43494013/article/details/126194833