-

Hadoop学习笔记(2)——HDFS(1)

目录

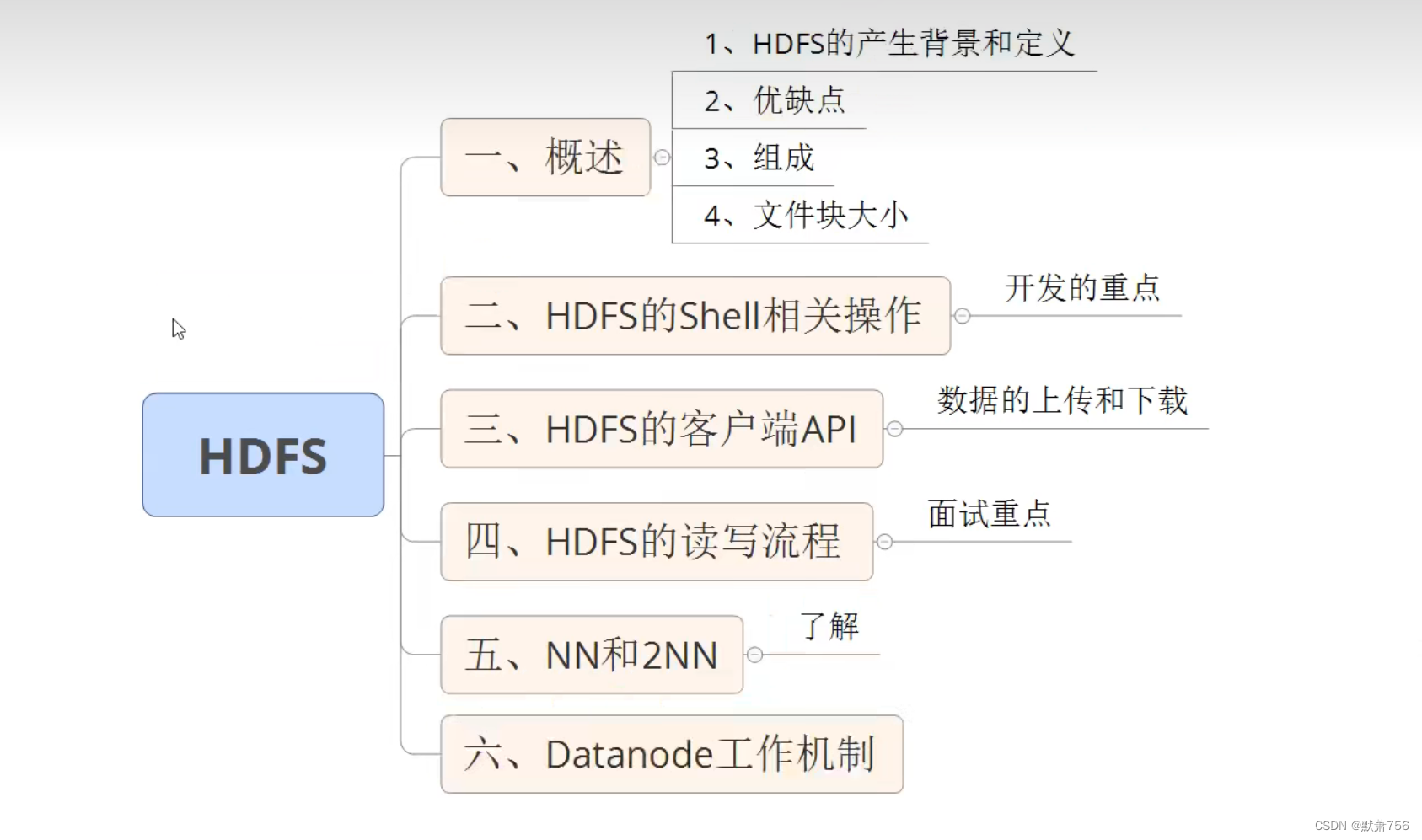

HDFS章节内容:

一、HDFS概述

1、HDFS产出背景及意义

1.1 HDFS产生背景

1.2 HDFS定义

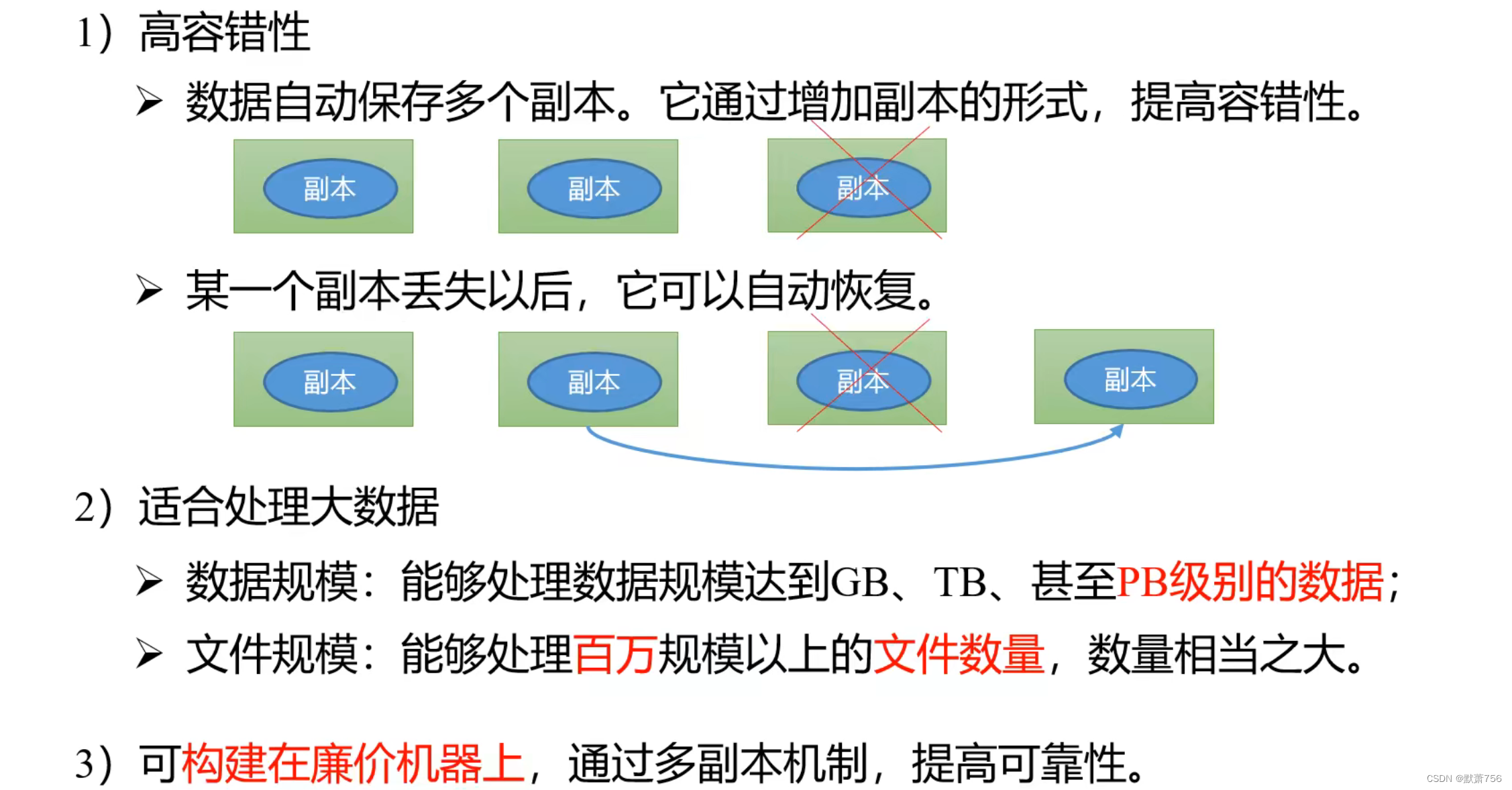

2、HDFS优缺点

2.1 HDFS优点

2.2 HDFS缺点

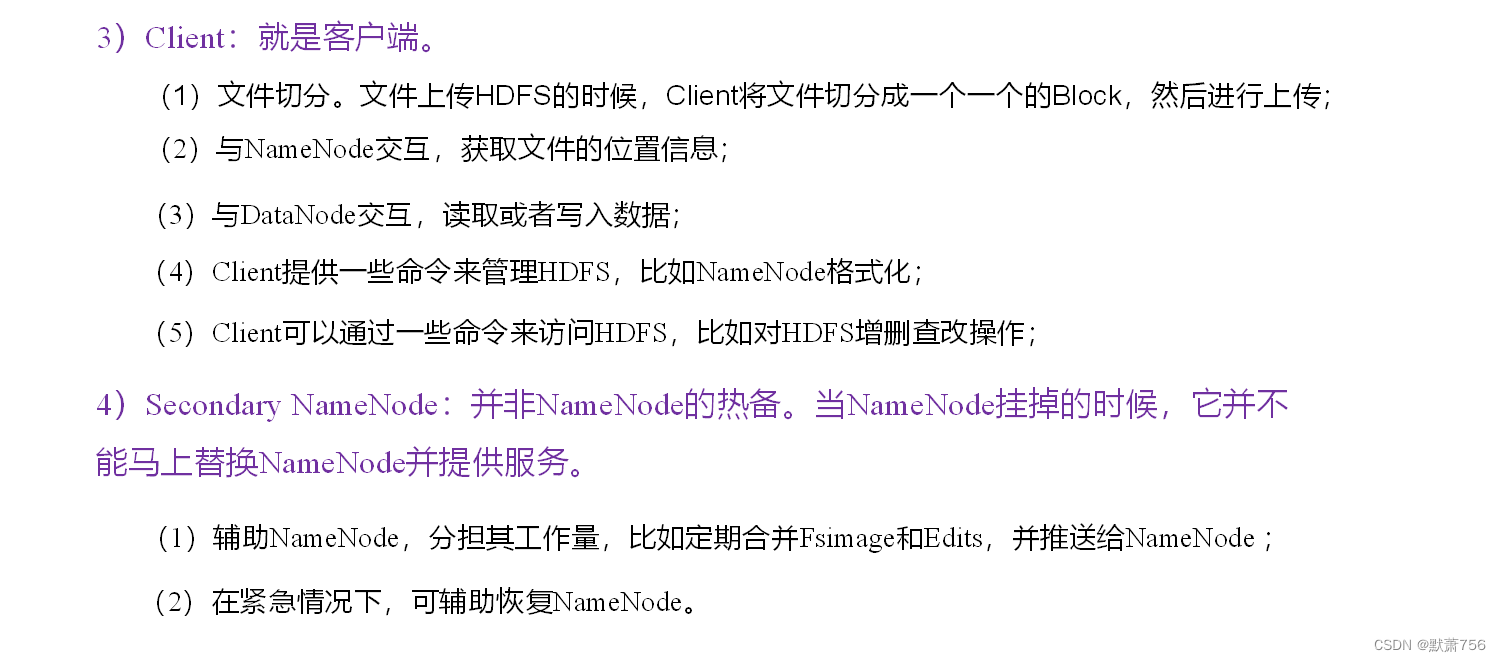

3、HDFS组成

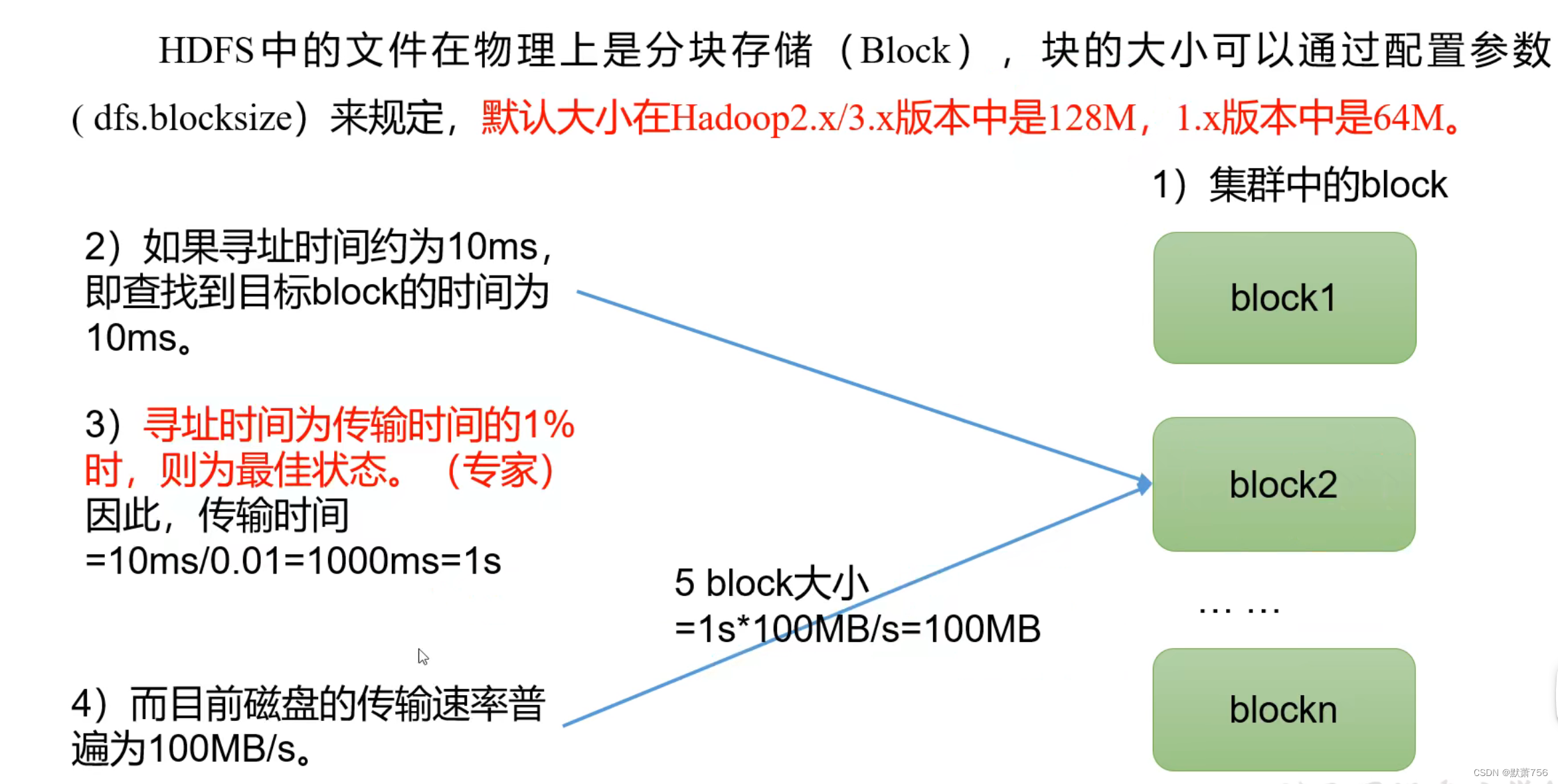

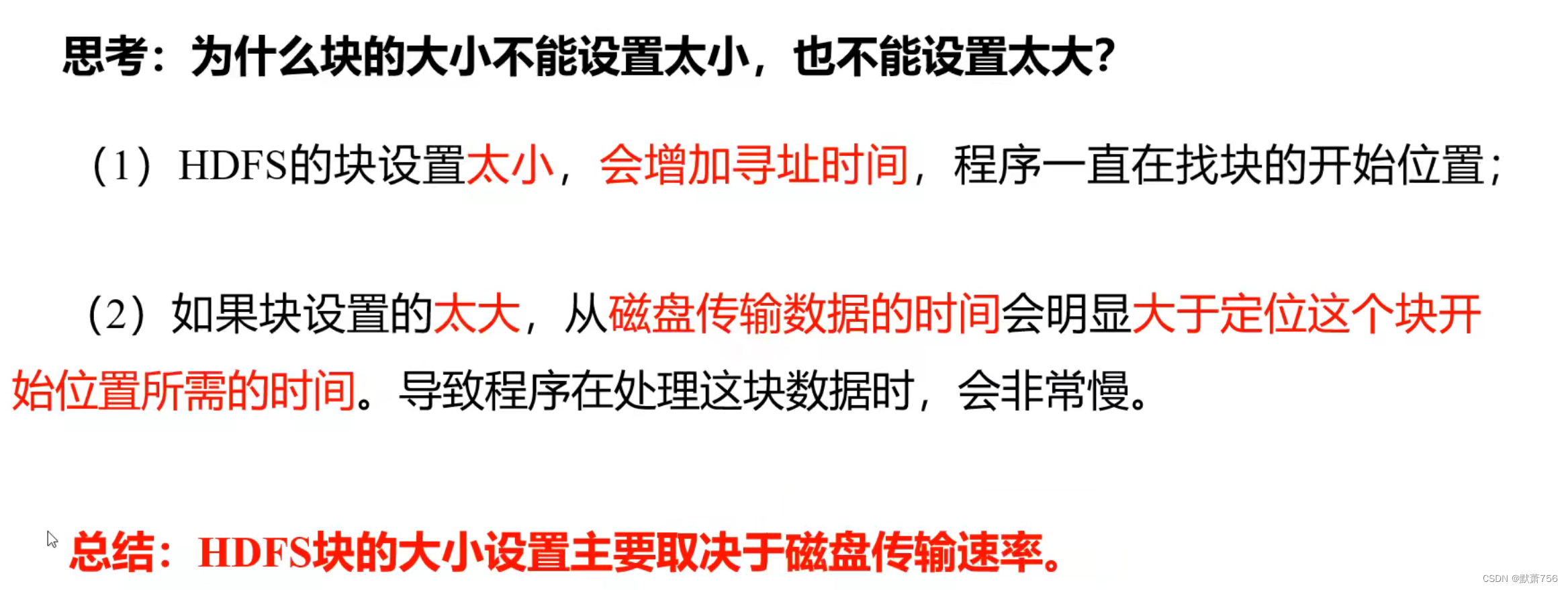

4、HDFS文件块大小

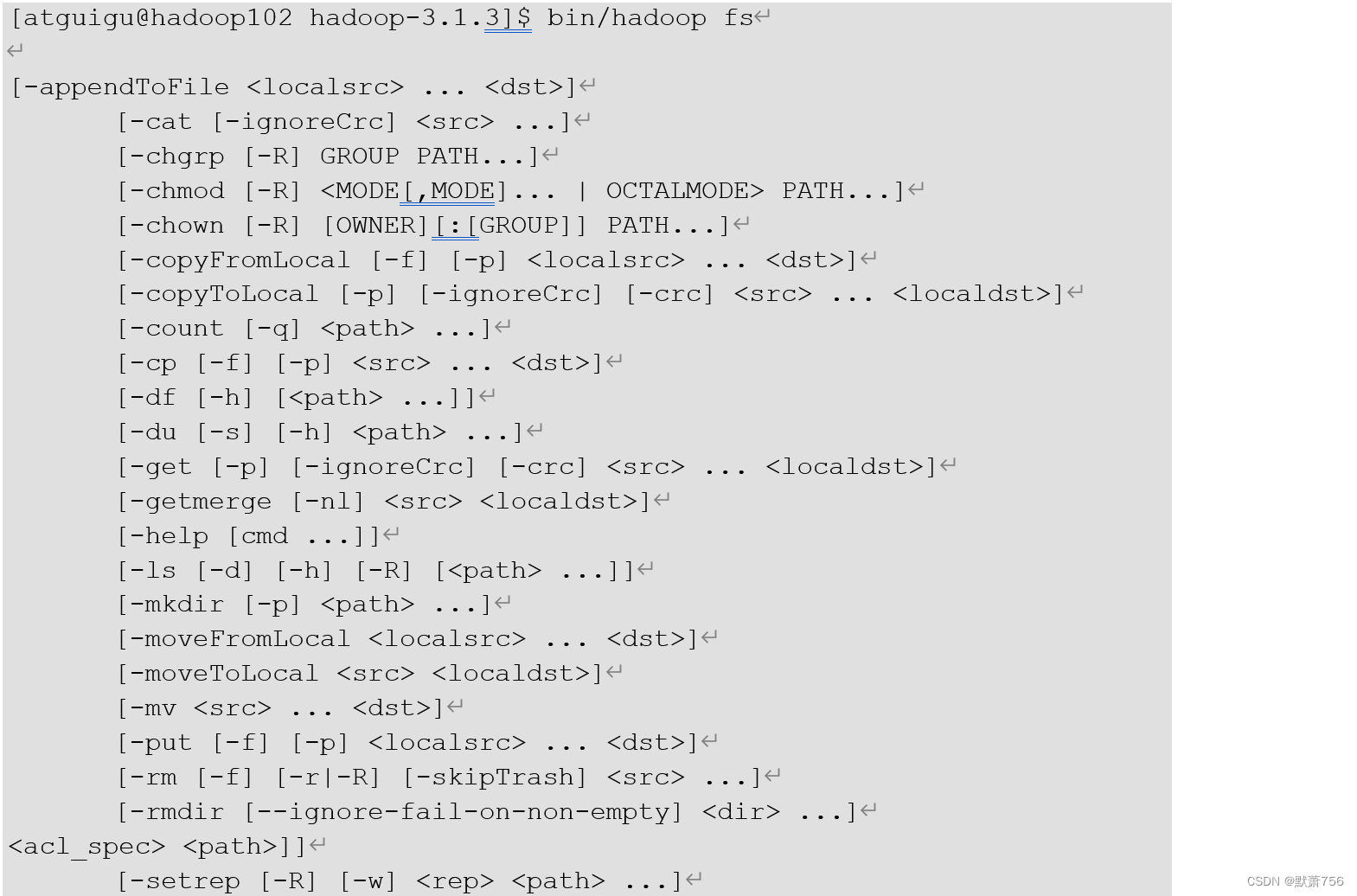

二、HDFS的Shell操作

1、基本语法

hadoop fs 具体命令 或者 hdfs dfs 具体命令(两者完全相同)

2、命令大全

3、常用命令实操(重要)

3.1 准备工作

用之前自定义的myhadoop.sh start/stop启动

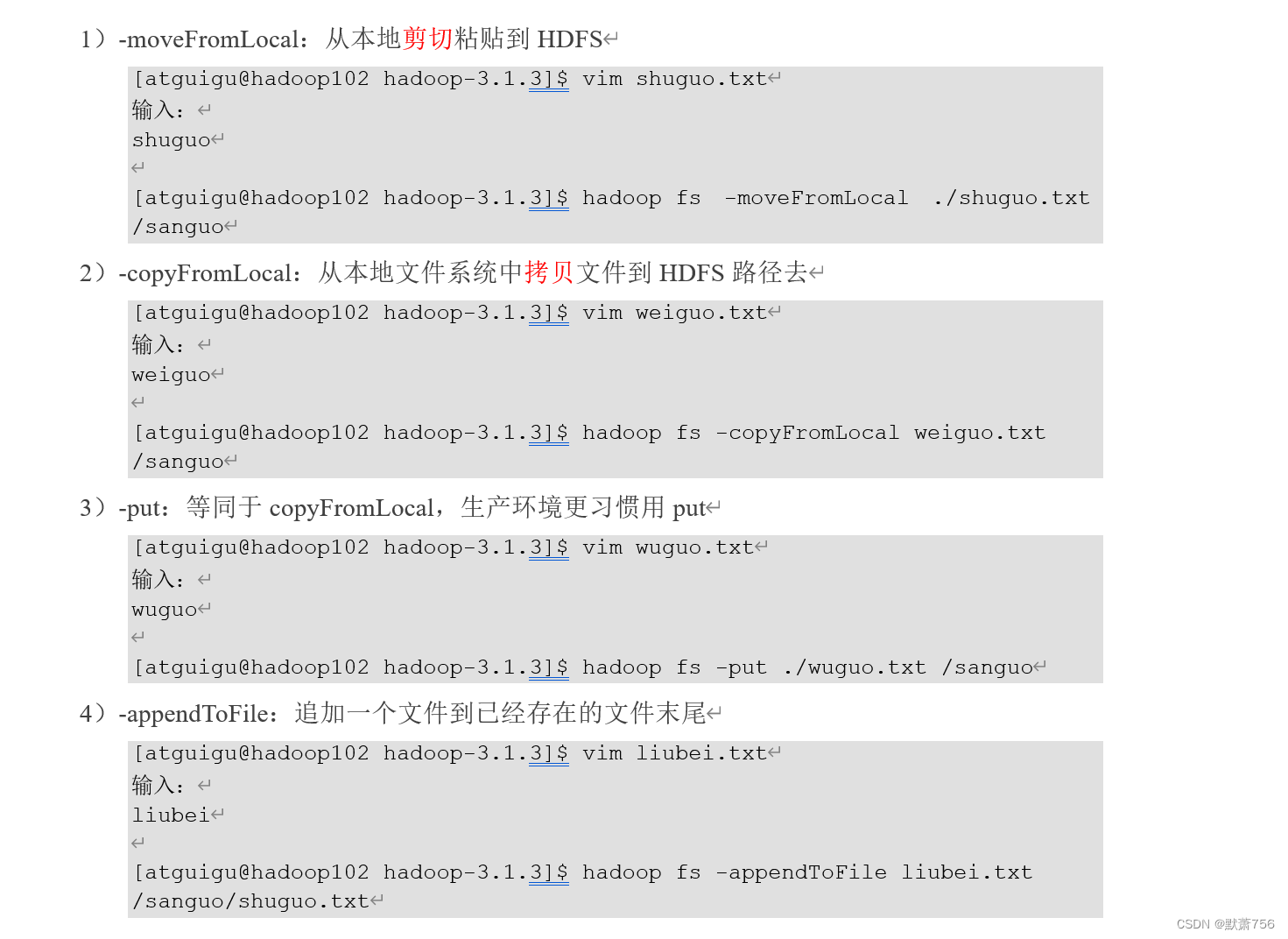

3.2 上传命令

3.3 下载命令

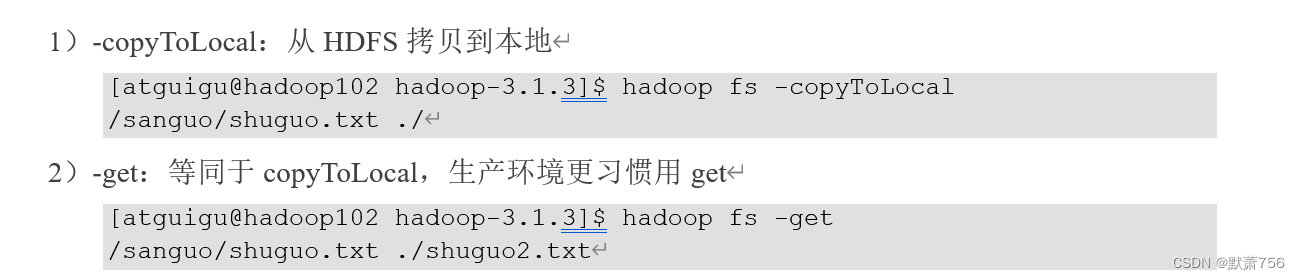

可以更改名字的

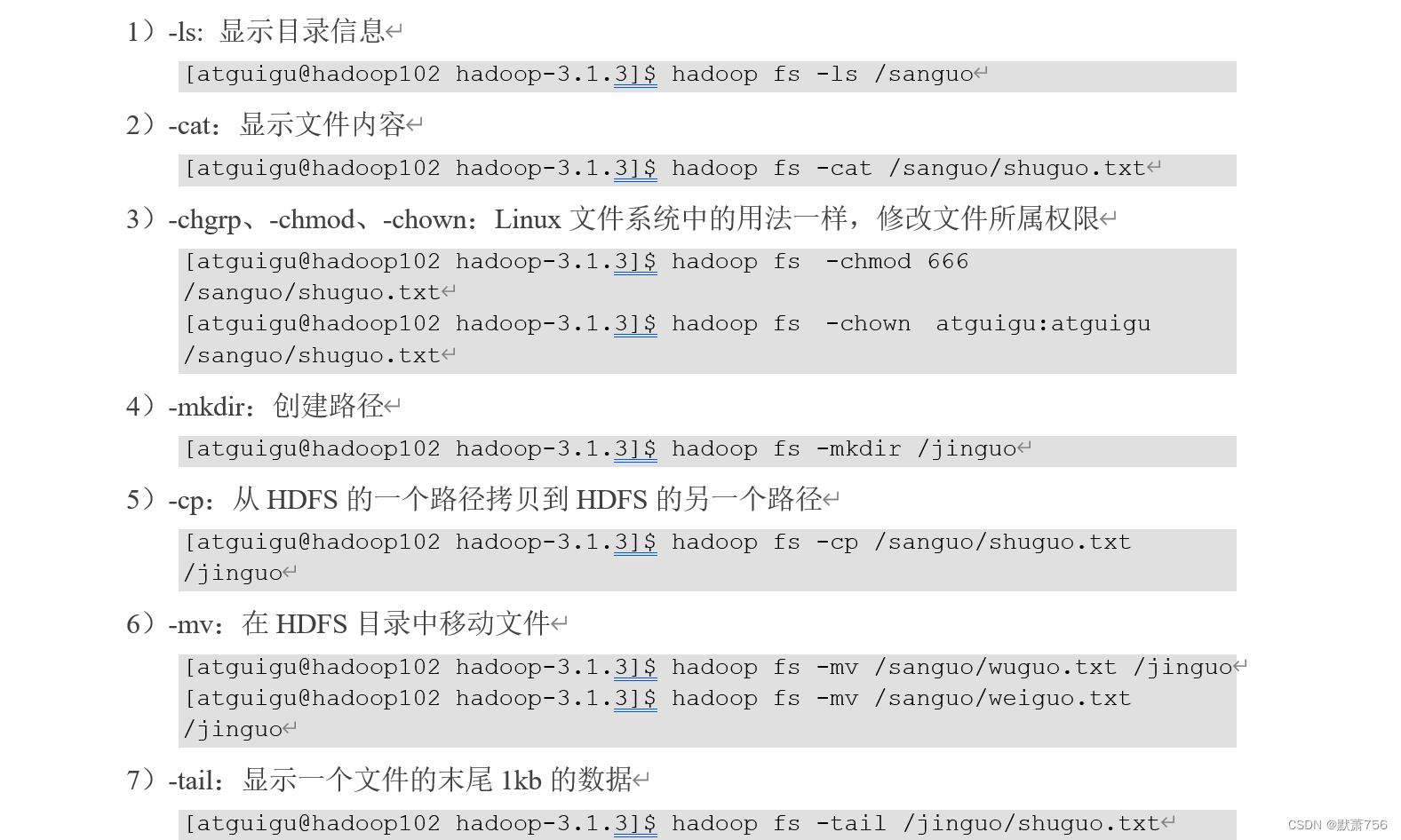

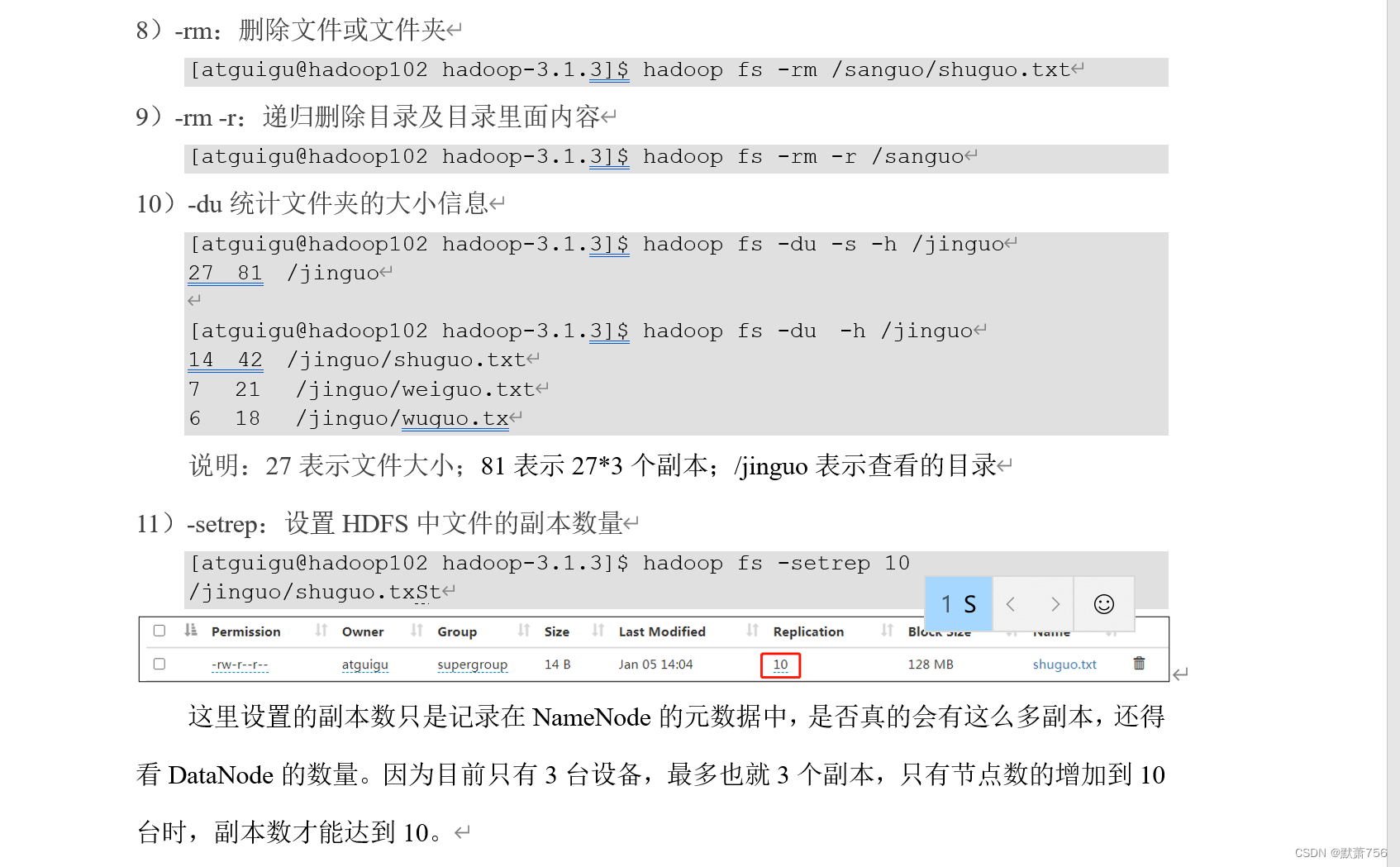

3.4 HDFS直接操作

三、HDFS的API操作

1、API环境准备

要去配置以下Maven以及依赖包等

2、API操作

2.1 API创建文件夹及文件上传

- package com.me.hdfs;

- import org.apache.hadoop.conf.Configuration;

- import org.apache.hadoop.fs.FileSystem;

- import org.apache.hadoop.fs.Path;

- import org.junit.After;

- import org.junit.Before;

- import org.junit.Test;

- import java.net.URI;

- /**

- * 客户端代码常用套路

- * 1、获取一个客户端对象

- * 2、执行相关的操作命令

- * 3、关闭资源

- *

- * 典型代表:HDFS zookeeper

- */

- public class HdfsClient {

- private FileSystem fs;

- @Before

- public void init() throws Exception{

- //连接的集群nn地址

- URI uri = new URI("hdfs://hadoop102:8020");

- //创建一个配置文件

- Configuration configuration = new Configuration();

- //用户

- String user="me";

- //1.获取到了客户端对象

- fs = FileSystem.get(uri, configuration,user);

- }

- @After

- public void close() throws Exception{

- //3.关闭资源

- fs.close();

- }

- //创建目录

- @Test

- public void testmkdir() throws Exception {

- //2/创建一个文件夹

- fs.mkdirs(new Path("/xiyou/huaguoshan1"));

- }

- }

2.2 上传文件

- //上传文件

- @Test

- public void testPut() throws Exception{

- //参数解读:参数一:表示是否删除原数据; 参数二:是否运行被覆盖; 参数三:原数据路径; 参数四:目的地路径;

- fs.copyFromLocalFile(true,true,new Path("D:\\sunwukong.txt"),new Path("hdfs://hadoop102//xiyou/huaguoshan"));

- }

这里的HDFS的路径可以带上协议的hdfs:://hadoop102,也可以不带

2.3 API参数优先级

- /**

- * 参数优先级从低到高:

- * hdfs-default.xml ==> hdfs-site-xml ==> 在项目资源目录下的配置文件 ==> 代码里面的优先级最高

- * @throws Exception

- */

2.4 下载文件

- //文件下载

- @Test

- public void testGet() throws Exception{

- //参数解读:参数一:表示是否删除原文件; 参数二:原文件路径HDFS; 参数四:目的地路径windows; 参数四:是否开启校验(true就不开启校验);

- fs.copyToLocalFile(true,new Path("hdfs://hadoop102/xiyou/huaguoshan"),new Path("D:\\"),true);

- }

1、crc文件是一种校验方式

2、如果要下载sunwukong.txt,在参数二后面加上/sunwukong.txt即可

2.5 删除

- //删除

- @Test

- public void testRm() throws Exception{

- //参数解读:参数1:要删除的路径; 参数2:是否递归删除;

- //删除文件

- //fs.delete(new Path("/jdk-8u212-linux-x64.tar.gz"),false);

- //删除空目录

- //fs.delete(new Path("/xiyou"),false);

- //删除非空目录(要递归删除)

- fs.delete(new Path("/jinguo"),true);

- }

2.6 文件的移动及更名

- //文件的更名和移动

- @Test

- public void testmv() throws Exception{

- //参数解读:参数1:原文件路径; 参数2:目标文件路径(这里就更名了)

- //fs.rename(new Path("/input/word.txt"),new Path("/input/ss.txt"));

- //文件的移动和更名

- //fs.rename(new Path("/input/ss.txt"),new Path("/cls.txt"));

- //目录的更名

- fs.rename(new Path("/input"),new Path("/output"));

- }

2.7 获取文件详细信息

- //获取文件详情信息

- @Test

- public void fileDetail() throws Exception {

- //获取所有文件信息

- RemoteIterator

listFiles= fs.listFiles(new Path("/"),true); - //遍历文件

- while(listFiles.hasNext()){

- LocatedFileStatus fileStatus = listFiles.next();

- System.out.println("============="+fileStatus.getPath()+"============");

- System.out.println(fileStatus.getPermission());

- System.out.println(fileStatus.getOwner());

- System.out.println(fileStatus.getGroup());

- System.out.println(fileStatus.getLen());

- System.out.println(fileStatus.getModificationTime());

- System.out.println(fileStatus.getReplication());

- System.out.println(fileStatus.getBlockSize());

- System.out.println(fileStatus.getPath().getName());

- //获取块信息(获取到副本的hadoop102...)

- BlockLocation[] blockLocations = fileStatus.getBlockLocations();

- System.out.println(Arrays.toString(blockLocations));

- }

- }

2.8 判断是文件还是目录

- //判断是文件还是文件夹

- @Test

- public void testFile() throws Exception{

- FileStatus[] listStatus= fs.listStatus(new Path("/"));

- for(FileStatus status: listStatus){

- if(status.isFile()){

- System.out.println("文件:"+status.getPath().getName());

- }

- else{

- System.out.println("目录:"+status.getPath().getName());

- }

- }

- }

-

相关阅读:

如何做代码评审(code review)

【Zookeeper】——服务器动态上下线监听案例&分布式锁案例

html+css+js制作LOL官网,web前端大作业(3个页面+模拟登录+链接)

iOS 消息推送面试题

倍福使用AdsRemote组件实现和C#的ADS通讯

PySpark数据分析基础:PySpark基础功能及DataFrame操作基础语法详解

Undo Log、Redo Log、binlog与两阶段提交

算法训练第五十八天

编译原理网课笔记——第二章

k8s入门之Secret(十)

- 原文地址:https://blog.csdn.net/qq_64557330/article/details/126065864