-

音视频开发的正确(学习思路+技术指导)

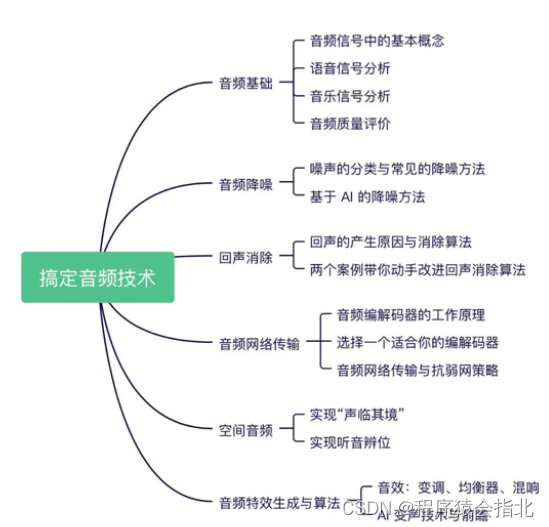

音视频技术一句话简单来说就是通过网络将图像和声音从生产端分发给消费端的技术。可以是以点播的方式,也可以是直播的方式,也可以是像视频会议一样互动的方式。现在的网络流量一多半都是在传输音视频的数据,音视频相关的app几乎每个人都在使用,占据了大众娱乐的半壁江山。

音视频运作流程

**音视频生产端:**音视频的采集 ->预处理-> 编码 -> 封装 -> 网络发送

**音视频消费端:**网络接收 -> 解封装 -> 解码 -> 渲染

1、音视频采集

android平台上的音频采集一般就三种:1.利用android内置的应用程序 2.使用MediaRecorder进行音频捕获 3.使用AudioRecord进行音频捕获。此3种方式的灵活性逐渐增大,相应的所需要做的工作也逐渐增多。

2、预处理

视频数据的预处理一般包括视频图像的滤镜处理、美颜处理、加字幕,绿幕抠图。

音频的预处理一般包括声音的3A算法和变速变调处理,这个在 WebRTC里面有详细的介绍和实现。

- AGC:自动增益补偿功能(Automatic Gain Control)

- ANS:背景噪音抑制功能(Automatic Noise Suppression)

- AEC:回声消除器(Acoustic Echo Canceller)

3、编码

视频的编码标准:

- H264

- H265

- VP8

- VP9

- AV1

音频的编码标准:

- AAC

- Opus

- mp3

以我目前的工作经验最常用的视频编码是 h264 音频编码是 AAC 编码。

4、封装

音视频编码后需要将音视频包以某种容器封装起来,这个步骤成为音视频的封装。常见的封装格式

- flv

- mp4

- ts

- rtp

ffmepg 支持非常丰富的媒体封装格式。查看 ffmepg 支持的封装格式命令如下

ffmpeg -muxers- 1

5、传输

常见的音视频的网络传输协议有 rtmp http-flv rtsp srt hls rtc udp ,各有优劣,这里不做详细对比。

感兴趣可以百度 google搜索了解。6、解封装

解封装是上面介绍的封装的逆操作,从音视频的容器中将音频包、视频包分离出来放到各自的队列,等待各自的解码线程去解码渲染视频,播放音频。

7、解码

编码的逆操作,将视频包解码成原始的视频帧,将音频包解码成原始的pcm音频数据。

8、渲染

视频的渲染 windows 平台下可以使用 Direct3D 技术渲染视频,macOS,Android 和 Linux 可以使用 OpenGL 、OpenGLES 技术渲染视频。

拓展知识:FFmpeg进阶

要学习音视频,无论是直播还是音视频处理,ffmpeg 和webrtc 基本是绕不过去的,相对webrtc 来说,ffmpeg 应用的更广 。

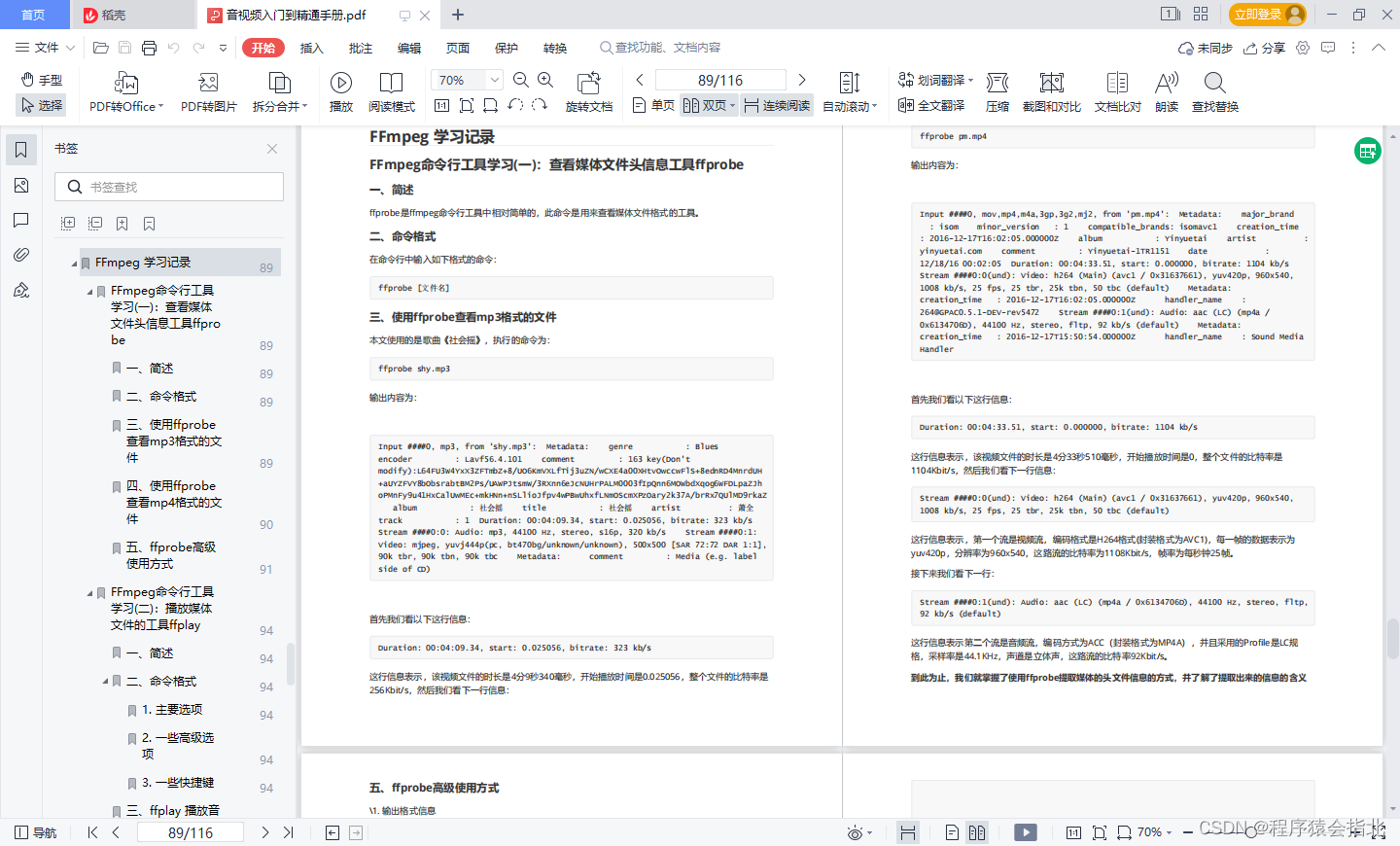

技术参考资料:《全套音视频入门到精通手册》

音视频的知识范围很广,要学的东西很深。文章篇幅有限,我把根据音视频的学习思路,整理出的一套系统性的学习笔记。我把这套学习笔记放在文章链接中,对音视频感兴趣的人,可以借鉴加深学习!

总结

本人在学习音视频开发的过程中,深刻体会到了由于知识的分散、过渡断层带来的种种困惑和痛苦,因此希望通过自己的理解,可以把音视频开发相关的知识总结出来,并形成系列文章,循序渐进,剖析各个环节,一则对自己所学做一个总结和巩固,二则希望可以帮助想入门音视频开发的开发者小伙伴们。

冰冻三尺非一日之寒,滴水石穿非一日之功。

加油!让我们早日成为音视频开发者六边形战士!

-

相关阅读:

基于多目标粒子群优化算法的冷热电联供型综合能源系统运行优化附Matlab代码

Anaconda安装使用以及Pycharm教程

[LitCTF 2023]导弹迷踪

HTML+CSS+JS制作一个迅雷看看电影网页设计实例 ,排版整洁,内容丰富,主题鲜明,简单的网页制作期末作业

AI能给百融云带来什么?

Python安装教程(Windows10系统)

线程常用方法与守护线程

基于Java毕业设计养老机构管理信息系统源码+系统+mysql+lw文档+部署软件

JavaScript学习笔记(未完待续)

【类型转换】使用c#实现简易的类型转换(Emit,Expression,反射)

- 原文地址:https://blog.csdn.net/m0_71524094/article/details/126064330