-

为什么都去卷文本生成图像???

卷友们好,我是rumor。

躺在我微信浮窗里最多的就是文本生成图像的工作了,本来这个方向我以为我是可以拿捏的,结果自从他们开始用Diffusion模型之后我就再也跟不上了,而且这类文章动辄20页起,慢慢地我就放过了自己。

那天我在清理这些报道库存时,突然油然而生一个拷问:为什么大家都在卷这个方向?这些生成的画作虽然让人惊艳,但它们能产生实际的价值吗?应该如何去落地甚至商业化呢?

带着这个问题,我一狠心把知道的Paper都下载了,它们分别是:

OpenAI的DALLE (21/01)、GLIDE (22/03)、DALLE2 (22/04)

Meta的Make-A-Scene (22/03)

Google的Imagen (22/05)、Parti (22/06)

智源悟道2.0 (21/06)、智源阿里达摩院和清华合作的CogView (21/11)

百度的文心ERNIE-ViLG (21/12)

字节的CLIP-GEN (22/03)

可以看到今年这个方向有多热闹了,Google和OpenAI甚至开始自己卷自己,前后脚放出不同的工作。

说回正题,关于为什么大家都在卷这个方向,在看过了上述文章们的Intro之后,我发现观点还是比较统一的,核心就是不断追求模型的理解能力。

正如ERNIE-ViLG所引用Richard Feynman的话:

What I cannot create, I do not understand

当模型能根据文本创造准确对应的图像时,就证明它已经具备了CogView中所列举的四种能力:

从像素点中解藕出形状、颜色等一系列特征,也就是说给模型输入一张图片时,它真的能像人一样去「看」到其中的各种物体和特征,而不是一个个无意义的像素点

理解文本

将图像中的物体和特征与单词对齐(包括同义词),意味着模型能够把同一事物的两种模态联系起来

学习到如何将各种物体、特征组合起来,这种生成能力需要更高的认知水平

随着资源的不断投入,这些生成的图片以肉眼可见的速度越来越强,那么这些图片虽然fancy,但能如何落地、产生什么实际价值呢?

首先最直接的,就是辅助艺术家进行创作,甚至独立创作,比如去年底我就发现一位博士同学用AI生成的4张画作在淘宝拍卖卖到了2304元,也调研到了一些国外的网站,利用AI技术付费生成特定风格的创作。在写这篇文章的时候我又在淘宝搜索,发现依然有人在拍卖AI生成的艺术品,而且价格不菲:

说实话我不是这个落地方向的支持者,我认为画作背后「人」的思考和经历才是成就艺术的原因。但价值是人定的,恰巧最近又赶上了NFT,所以这个方向究竟会发展成什么样也未可知。

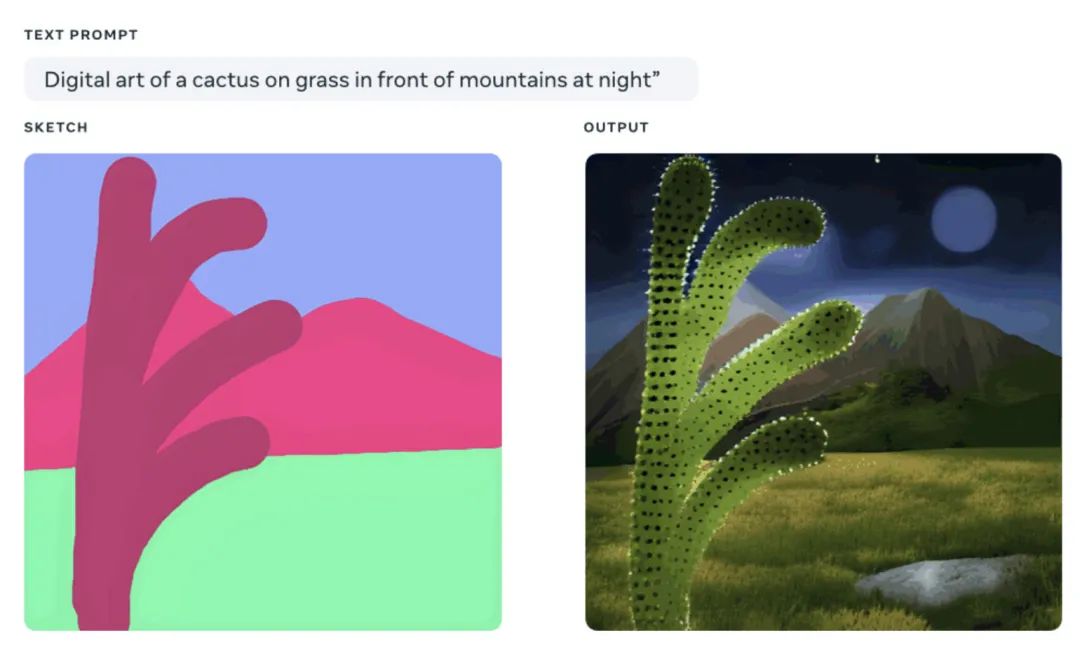

另一个落地方向,是儿童教育。Meta最新的工作Make-A-Scene就很适合这个方向,让儿童们绘制草图,描述场景,就可以生成很棒的作品,从而启蒙孩子对美术的兴趣和想象力。这个方向还是很有实际意义并且能变现的。

还有一个方向,是内容制作。这个方向的前景就很广阔了,先说3D的,现在3D动画和游戏的市场已经不必多说了(还捎带上元宇宙),但做一个3D人物和场景都需要建模、贴纹理、绑定骨骼、做动画、加特效等复杂的流程,如果AI能辅助其中几个环节的生产,会节省很多人力成本,提升内容产出速度。而且目前模型生成的真实物体也很逼真了,再往远了想,以后说不定输入一个剧本,就能输出一部电影了。

不过目前的模型能力离终极目标还有不小的距离,模型的可控性还需要进一步提升。

AI一直在潜移默化地影响我们的生活,有好有坏,比如搜索引擎用AI算法做排序,就有人用AI算法生成大量垃圾内容做SEO;再比如剪辑软件利用AI来减少人工配音成本,就有人盗取他人视频,用AI换个声音洗稿制作大量垃圾剪辑。

虽然有不好的事情发生,但好在这是一个对抗的过程,两方的算法都会在对抗中越来越强大。

我是朋克又极客的AI算法小姐姐rumor

北航本硕,NLP算法工程师,谷歌开发者专家

欢迎关注我,带你学习带你肝

一起在人工智能时代旋转跳跃眨巴眼

「希望可以早日提升我做B站视频的速度」

-

相关阅读:

Cocos Creator 3.6 新特性详解 2/3:渲染篇

1336:【例3-1】找树根和孩子

centos更换yum源

【云原生Kubernetes系列第三篇】二进制部署单节点Kubernetes(k8s)v1.20

使用RNN联合注意力机制实现机器翻译

MybatisPlus实践积累

保护 Web 服务器安全性

[附源码]计算机毕业设计springboot校园招聘系统设计

php运行原理详细说明

【C语言】C语言-学生成绩管理系统(源码+数据文件+课程论文)【独一无二】

- 原文地址:https://blog.csdn.net/m0_37310036/article/details/125986474