-

Spring项目整合 XXL-JOB分布式任务调度平台

XXL-JOB是一个分布式任务调度平台,其核心设计目标是开发迅速、学习简单、轻量级、易扩展。

版本说明

- Maven3.5+

- Jdk1.8+

- Mysql8.0+

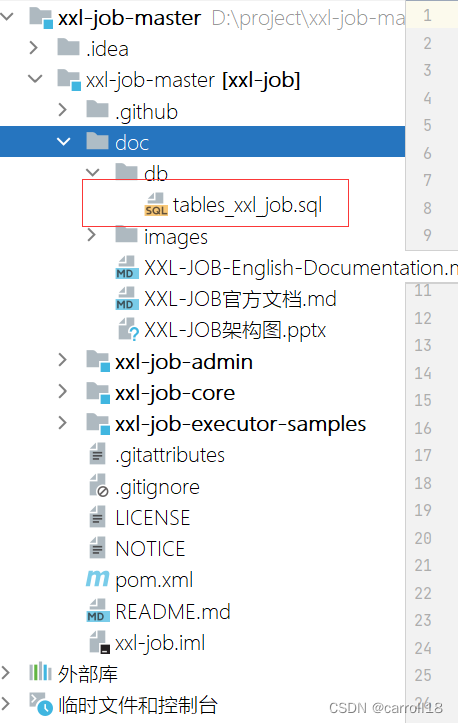

初始化“调度中心数据库”

-

下载项目源码并解压,获取 “调度中心数据库初始化SQL脚本” (

doc/db/tables_xxl_job.sql)并执行即可。

-

调度中心的作用:统一管理任务调度平台上调度任务,负责触发调度执行,并且提供任务管理平台。

Docker部署调度中心

/** * 如需自定义 mysql 等配置,可通过 "-e PARAMS" 指定,参数格式 PARAMS="--key=value --key2=value2" ; * 配置项参考文件:/xxl-job/xxl-job-admin/src/main/resources/application.properties * 如需自定义 JVM内存参数 等配置,可通过 "-e JAVA_OPTS" 指定,参数格式 JAVA_OPTS="-Xmx512m" ; */ docker run -e PARAMS="--spring.datasource.url=jdbc:mysql://[xxx.xxx.xxx.xxx:端口号]/[数据库名]?useUnicode=true&characterEncoding=UTF-8&autoReconnect=true&serverTimezone=Asia/Shanghai --spring.datasource.username=[数据库用户名] --spring.datasource.password=[数据库密码] --spring.datasource.driver-class-name=com.mysql.cj.jdbc.Driver" -p 8080:8080 -v /tmp:/home/asa/xxl-job/data/applogs --name xxl-job-admin -d xuxueli/xxl-job-admin:2.3.0- 1

- 2

- 3

- 4

- 5

- 6

- docker run 会创建一个新的容器并运行一个命令。

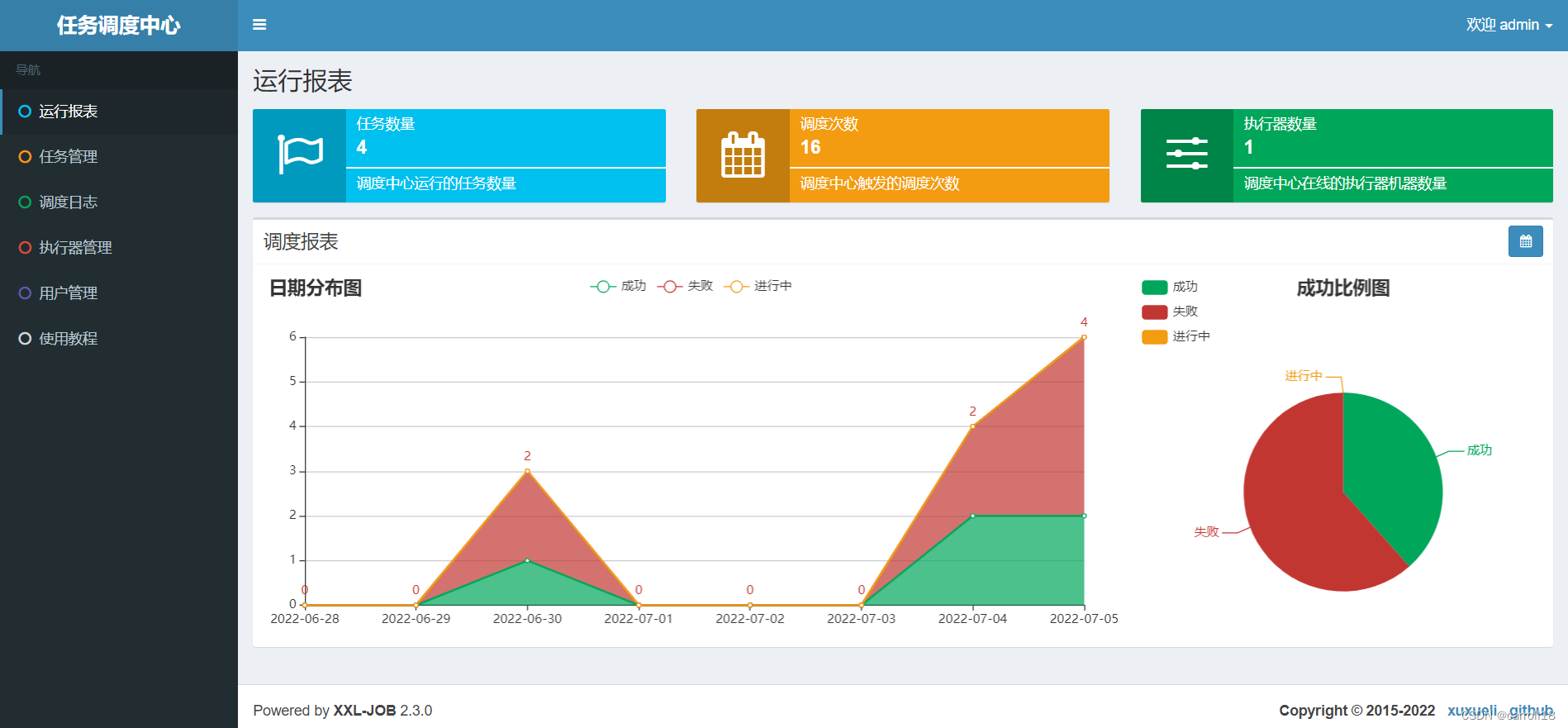

- docker容器启动成功后,访问调度中心访问地址:

http://ip地址:8080/xxl-job-admin,默认用户名:admin和密码:123456。登录成功,如图:

- 至此“调度中心”项目已经部署成功。

项目配置部署“执行器”

- 引入对应依赖

<dependency> <groupId>com.xuxueli</groupId> <artifactId>xxl-job-core</artifactId> <version>2.3.0</version> </dependency>- 1

- 2

- 3

- 4

- 5

- 添加配置类

xxl: job: admin: ### 调度中心部署根地址 addresses: http://ip地址:8080/xxl-job-admin accessToken: executor: ### 执行器AppName:执行器心跳注册分组依据 appname: xxl-job-demo ### 执行器注册:优先使用该配置作为注册地址,为空时使用内嵌服务 ”IP:PORT“ 作为注册地址 address: ### 执行器IP:默认为空表示自动获取IP, ip: ### 执行器端口号:小于等于0则自动获取;默认端口为9999 port: 9999 ### 执行器运行日志文件存储磁盘路径 :需要对该路径拥有读写权限;为空则使用默认路径; logpath: ./applogs/xxl-job/jobhandler ### 执行器日志文件保存天数 logretentiondays: 30- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

@Configuration @Slf4j public class XxlJobConfig { private Logger logger = LoggerFactory.getLogger(XxlJobConfig.class); @Value("${xxl.job.admin.addresses}") private String adminAddresses; @Value("${xxl.job.accessToken}") private String accessToken; @Value("${xxl.job.executor.appname}") private String appname; @Value("${xxl.job.executor.address}") private String address; @Value("${xxl.job.executor.ip}") private String ip; @Value("${xxl.job.executor.port}") private int port; @Value("${xxl.job.executor.logpath}") private String logPath; @Value("${xxl.job.executor.logretentiondays}") private int logRetentionDays; @Bean public XxlJobSpringExecutor xxlJobExecutor() { logger.info(">>>>>>>>>>> xxl-job config init."); XxlJobSpringExecutor xxlJobSpringExecutor = new XxlJobSpringExecutor(); xxlJobSpringExecutor.setAdminAddresses(adminAddresses); xxlJobSpringExecutor.setAppname(appname); xxlJobSpringExecutor.setAddress(address); xxlJobSpringExecutor.setIp(ip); xxlJobSpringExecutor.setPort(port); xxlJobSpringExecutor.setAccessToken(accessToken); xxlJobSpringExecutor.setLogPath(logPath); xxlJobSpringExecutor.setLogRetentionDays(logRetentionDays); return xxlJobSpringExecutor; } }- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

测试xxl-job:BEAN模式(方法形式)

-

Bean模式任务,支持基于方法的开发方式,每个任务对应一个方法。

- 优点:

- 每个任务只需要开发一个方法,并添加”@XxlJob”注解即可,更加方便、快速。

- 支持自动扫描任务并注入到执行器容器。

- 缺点:要求Spring容器环境;

- 优点:

-

1.执行器项目中,开发Job方法

@Component public class MyJob { @XxlJob("demoJobHandler") public ReturnT<String> demoJobHandler() throws Exception { String param = XxlJobHelper.getJobParam(); XxlJobHelper.log("XXL-JOB, Hello World:{}",param); return ReturnT.SUCCESS; } }- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 2.调度中心,新建调度任务

配置属性详细说明:

基础配置: - 执行器:任务的绑定的执行器,任务触发调度时将会自动发现注册成功的执行器, 实现任务自动发现功能; 另一方面也可以方便的进行任务分组。每个任务必须绑定一个执行器, 可在 "执行器管理" 进行设置; - 任务描述:任务的描述信息,便于任务管理; - 负责人:任务的负责人; - 报警邮件:任务调度失败时邮件通知的邮箱地址,支持配置多邮箱地址,配置多个邮箱地址时用逗号分隔; 触发配置: - 调度类型: 无:该类型不会主动触发调度; CRON:该类型将会通过CRON,触发任务调度; 固定速度:该类型将会以固定速度,触发任务调度;按照固定的间隔时间,周期性触发; 固定延迟:该类型将会以固定延迟,触发任务调度;按照固定的延迟时间,从上次调度结束后开始计算延迟时间,到达延迟时间后触发下次调度; - CRON:触发任务执行的Cron表达式; - 固定速度:固件速度的时间间隔,单位为秒; - 固定延迟:固件延迟的时间间隔,单位为秒; 任务配置: - 运行模式: BEAN模式:任务以JobHandler方式维护在执行器端;需要结合 "JobHandler" 属性匹配执行器中任务; GLUE模式(Java):任务以源码方式维护在调度中心;该模式的任务实际上是一段继承自IJobHandler的Java类代码并 "groovy" 源码方式维护,它在执行器项目中运行,可使用@Resource/@Autowire注入执行器里中的其他服务; GLUE模式(Shell):任务以源码方式维护在调度中心;该模式的任务实际上是一段 "shell" 脚本; GLUE模式(Python):任务以源码方式维护在调度中心;该模式的任务实际上是一段 "python" 脚本; GLUE模式(PHP):任务以源码方式维护在调度中心;该模式的任务实际上是一段 "php" 脚本; GLUE模式(NodeJS):任务以源码方式维护在调度中心;该模式的任务实际上是一段 "nodejs" 脚本; GLUE模式(PowerShell):任务以源码方式维护在调度中心;该模式的任务实际上是一段 "PowerShell" 脚本; - JobHandler:运行模式为 "BEAN模式" 时生效,对应执行器中新开发的JobHandler类“@JobHandler”注解自定义的value值; - 执行参数:任务执行所需的参数; 高级配置: - 路由策略:当执行器集群部署时,提供丰富的路由策略,包括; FIRST(第一个):固定选择第一个机器; LAST(最后一个):固定选择最后一个机器; ROUND(轮询):; RANDOM(随机):随机选择在线的机器; CONSISTENT_HASH(一致性HASH):每个任务按照Hash算法固定选择某一台机器,且所有任务均匀散列在不同机器上。 LEAST_FREQUENTLY_USED(最不经常使用):使用频率最低的机器优先被选举; LEAST_RECENTLY_USED(最近最久未使用):最久未使用的机器优先被选举; FAILOVER(故障转移):按照顺序依次进行心跳检测,第一个心跳检测成功的机器选定为目标执行器并发起调度; BUSYOVER(忙碌转移):按照顺序依次进行空闲检测,第一个空闲检测成功的机器选定为目标执行器并发起调度; SHARDING_BROADCAST(分片广播):广播触发对应集群中所有机器执行一次任务,同时系统自动传递分片参数;可根据分片参数开发分片任务; - 子任务:每个任务都拥有一个唯一的任务ID(任务ID可以从任务列表获取),当本任务执行结束并且执行成功时,将会触发子任务ID所对应的任务的一次主动调度。 - 调度过期策略: - 忽略:调度过期后,忽略过期的任务,从当前时间开始重新计算下次触发时间; - 立即执行一次:调度过期后,立即执行一次,并从当前时间开始重新计算下次触发时间; - 阻塞处理策略:调度过于密集执行器来不及处理时的处理策略; 单机串行(默认):调度请求进入单机执行器后,调度请求进入FIFO队列并以串行方式运行; 丢弃后续调度:调度请求进入单机执行器后,发现执行器存在运行的调度任务,本次请求将会被丢弃并标记为失败; 覆盖之前调度:调度请求进入单机执行器后,发现执行器存在运行的调度任务,将会终止运行中的调度任务并清空队列,然后运行本地调度任务; - 任务超时时间:支持自定义任务超时时间,任务运行超时将会主动中断任务; - 失败重试次数;支持自定义任务失败重试次数,当任务失败时将会按照预设的失败重试次数主动进行重试;- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

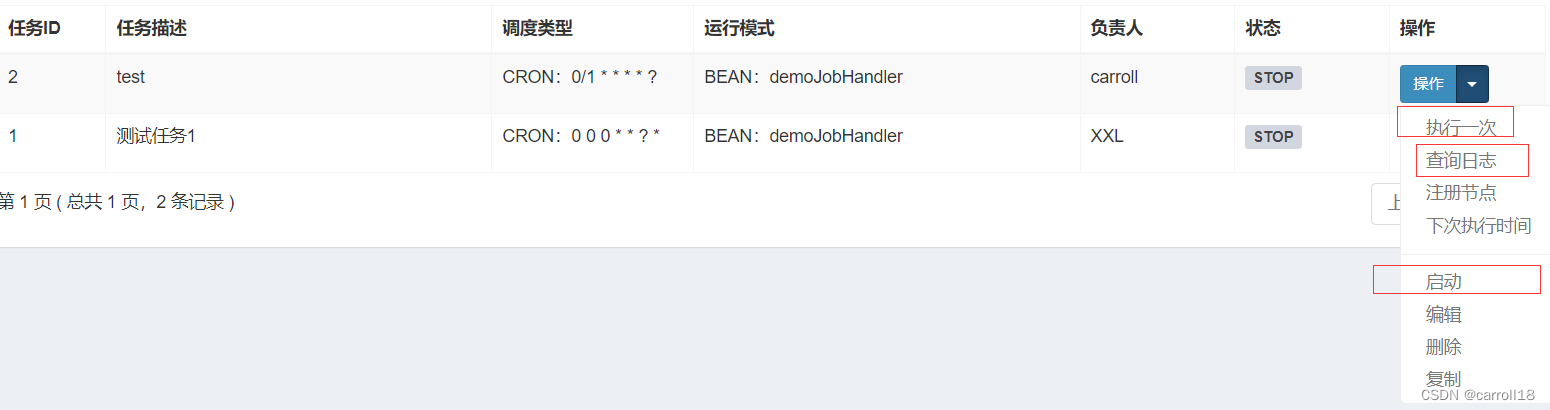

- 可对任务进行“启动”和“停止”操作

- 点击“执行一次”按钮,可手动触发一次任务调度,不影响原有调度规则。

- 点击“查看日志”按钮,可以查看任务历史调度日志。在历史调入日志界面可查看每次任务调度的调度结果、执行结果等。

一次完整的任务调度通讯流程

- 1、“调度中心”向“执行器”发送http调度请求: “执行器”中接收请求的服务,实际上是一台内嵌Server,默认端口9999;

- 2、“执行器”执行任务逻辑;

- 3、“执行器”http回调“调度中心”调度结果: “调度中心”中接收回调的服务,是针对执行器开放一套API服务;

你知道的越多,你不知道的越多。

-

相关阅读:

ICC2: ICG clone与ICG merge

数据库的基本操作(2)

【 java 面向对象】类的继承和方法重写

Django05_反向解析

LLM.int8()——自适应混合精度量化方法

MySQL筑基篇之增删改查

More effective C++:条款3.绝对不要以多态方式处理数组及条款4:非必要不提供default construcor

uniapp-vue3微信小程序实现全局分享

虹科Pico汽车示波器学院 | 第二课直播精彩回顾

飞行动力学 - 第19节-part2-尾旋及改出 之 基础点摘要

- 原文地址:https://blog.csdn.net/qq_40722827/article/details/125629791