-

spark伪分布部署

原创申明: 未经许可,禁止以任何形式转载,若要引用,请标注链接地址

全文共计1577字,阅读大概需要3分钟

欢迎关注我的个人公众号:不懂开发的程序猿一、 任务描述

本实验任务主要完成基于ubuntu环境的Spark伪分布部署、配置和调试工作。通过完成本实验任务,要求学生熟练掌握Spark伪分布部署方法,为后续实验的开展奠定Spark平台基础,也为从事大数据平台运维工程师、大数据技术支持工程师等岗位工作奠定夯实的技能基础。

二、 任务目标

掌握Spark伪分布环境的搭建配置

三、 任务环境

本次环境是:Ubuntu16.04 所需root密码为simpleware-ssh

四、 任务分析

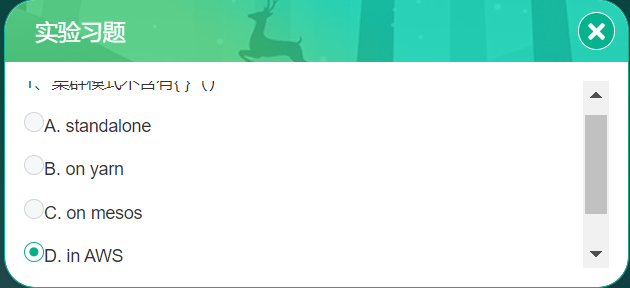

spark有以下几种安装模式,每种安装模式都有自己不同的优点和长处。

local(本地模式):

常用于本地开发测试,本地还分为local单线程和local-cluster多线程;

standalone(集群模式):

典型的Mater/slave模式,Master可能有单点故障的;Spark支持ZooKeeper来实现 HA。

on yarn(集群模式):

运行在 yarn 资源管理器框架之上,由 yarn 负责资源管理,Spark 负责任务调度和计算。

on mesos(集群模式):

运行在 mesos 资源管理器框架之上,由 mesos 负责资源管理,Spark 负责任务调度和计算。

on cloud(集群模式):

比如 AWS 的 EC2,使用这个模式能很方便的访问 Amazon的 S3;Spark 支持多种分布式存储系统:HDFS 和 S3。

目前Apache Spark支持三种分布式部署方式,分别是standalone、Spark on mesos和 spark on YARN,在学习Spark编程的过程中,往往因机器资源有限而采用伪分布式部署来实现spark的运算。♥ 知识链接

Standalone模式

即独立模式,类似于MapReduce 1.0所采用的模式,内部实现了容错性和资源管理,自带完整的服务,可单独部署到一个集群中,无需依赖任何其他资源管理系统。从一定程度上说,该模式是其他两种的基础。五、 任务实施

步骤1、解压缩

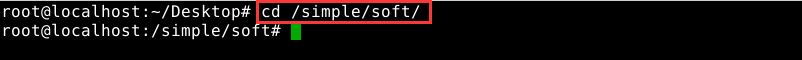

执行命令:cd /simple/soft进入soft目录,如图1所示:

图片1 进入安装包目录

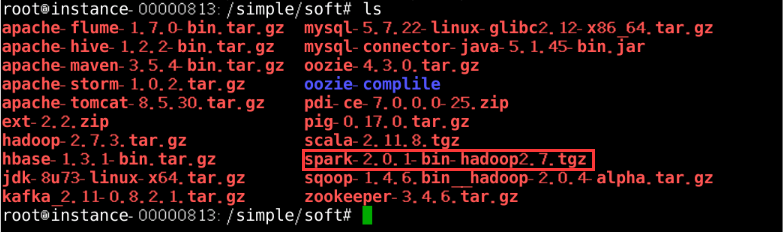

执行命令:ls查看spark安装包,如图2所示:

图片2 查看spark安装包

执行命令:tar -zxvf spark-2.0.1-bin-hadoop2.7.tgz -C /simple进行解压缩,如图3所示:

图片3 解压缩

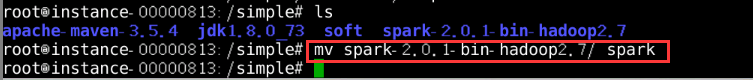

进入simple目录,执行命令:ls查看spark解压后的文件夹并修改为简称,如图4所示:

图片4 重命名解压文件

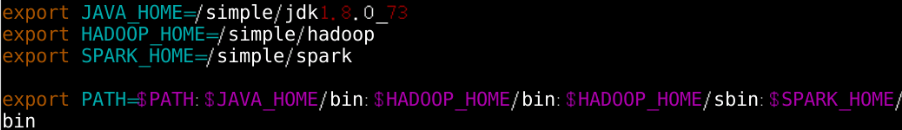

修改spark环境变量,在任意目录下执行命令:vim ~/.bashrc编辑配置文件如图5所示:

图片5 修改环境变量

环境变量配置文件生效,执行命令:source ~/.bashrc,如图6所示:

图片6 环境变量配置文件生效

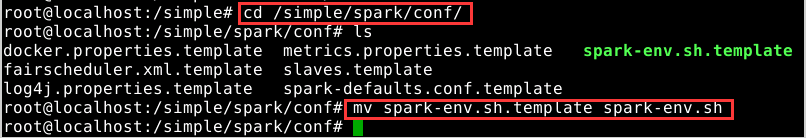

步骤2、spark伪分布集群配置

切换至spark安装目录下的/simple/spark/conf文件并执行命令:ls查看所有配置文件,并重命名文件spark-env.sh.template和slaves.template为spark-env.sh和slaves文件,如图7所示:

图片7 重命名文件

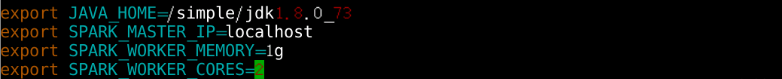

配置spark-env.sh。在conf目录下执行命令:vim spark-env.sh并编辑其中内容,如图8所示:

图片8 添加环境变量

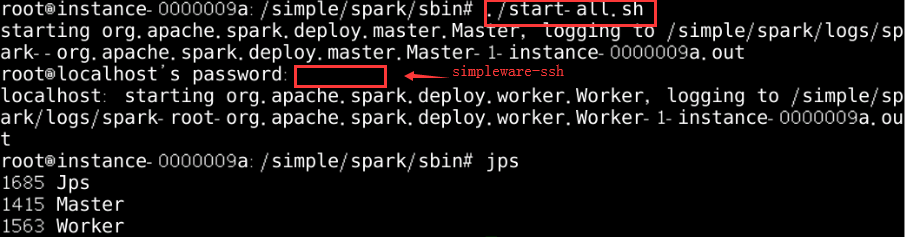

在spark目录下的sbin目录执行./start-all.sh启动spark服务,如图9所示:

图片9 启动spark服务

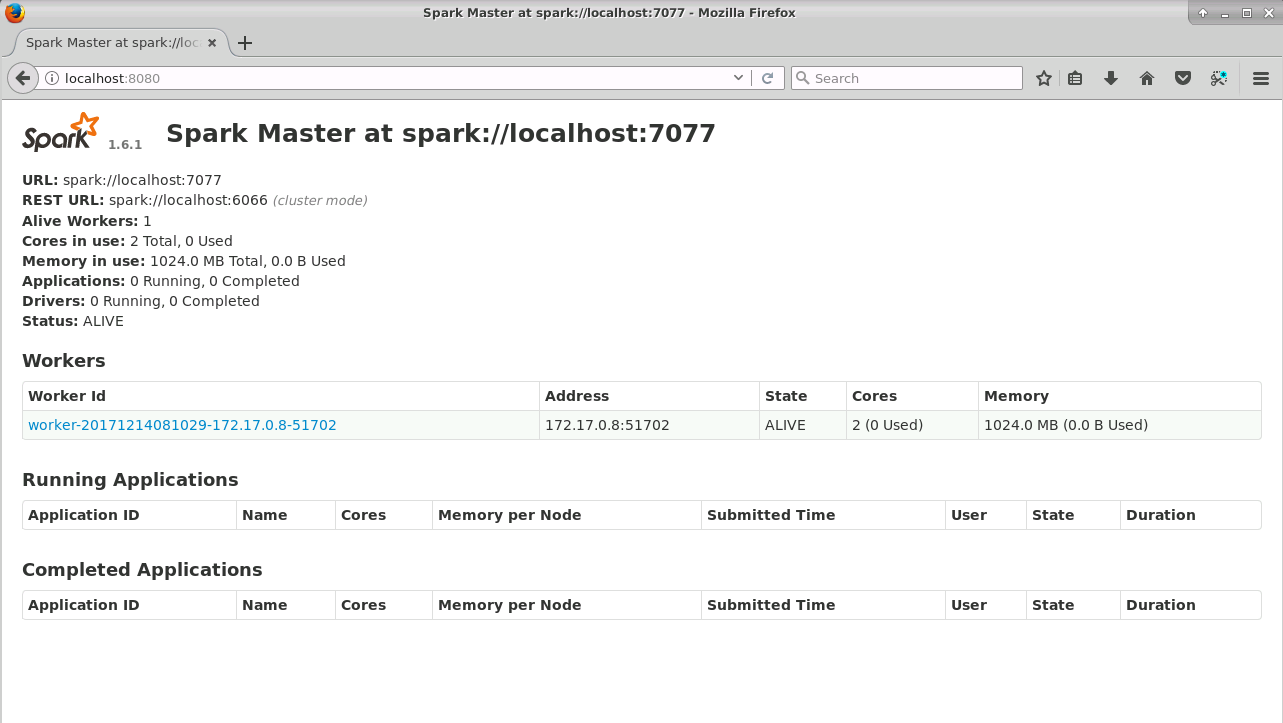

集群启动是否成功,启动浏览器并输入地址,如图9所示,显示部署成功,如图10所示:

图片10 访问集群

♥ 温馨提示

配置好环境变量后一定要执行使配置生效的命令;启动spark服务时要进入spark安装目录下的sbin目录执行./start-all.sh命令

-

相关阅读:

Linux学习笔记——系统函数IO

实现el-table打印功能,样式对齐,去除滚动条

【机器学习-周志华】学习笔记-第六章

半个月时间把MySQL重新巩固了一遍,梳理了一篇几万字 “超硬核” 文章!

苹果macOS系统M1、M2芯片关闭sip的方法

Spring笔记一:简介及入门案例

股票交易查询接口api新增哪些了特点?

Linux /proc 文件系统-机型定义

Spring Boot Auto-Configuration

【Vue-Element-Admin】select模糊查询

- 原文地址:https://blog.csdn.net/qq_44807756/article/details/125517836