-

多快好省,低门槛AI部署工具FastDeploy测试版来了!

本文已在飞桨公众号发布,查看请戳链接;

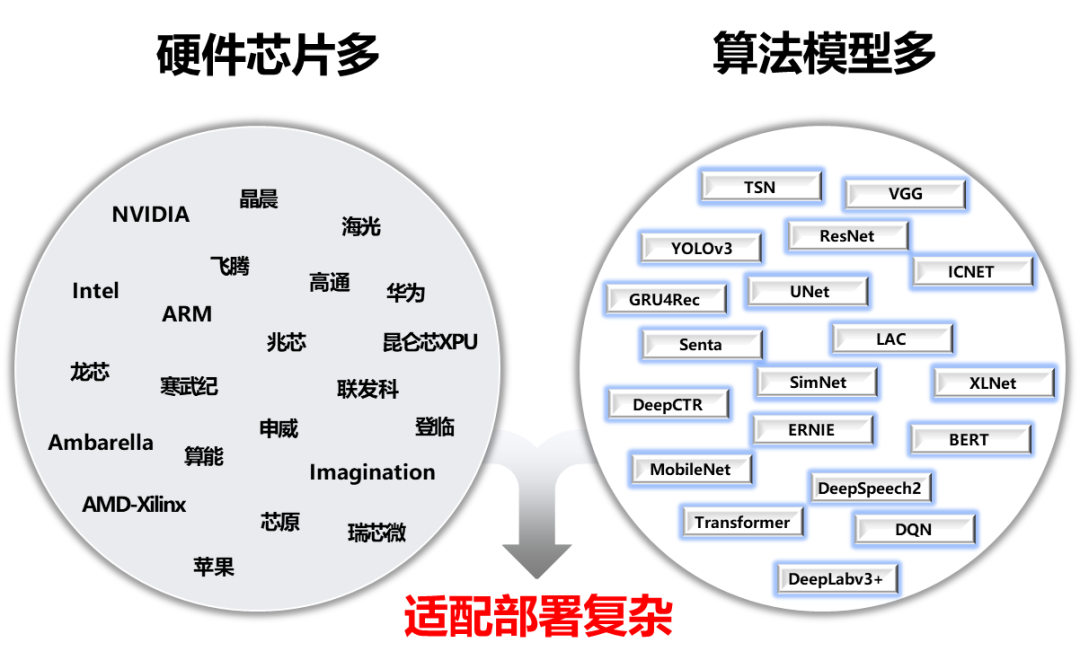

多快好省,低门槛AI部署工具FastDeploy测试版来了人工智能产业应用发展得越来越快,开发者需要面对的适配部署工作也越来越复杂。一方面,新的算法模型层出不穷,另一方面,各种AI硬件芯片也不断涌现。同时,在实际算法落地中,也是需要处理不同场景(服务器部署、服务化部署、嵌入式部署、手机端部署等),不同操作系统(Linux、Windows、Android、iOS等),不同编程语言(Python、C++等),这些都为AI开发者项目落地带来不小的挑战。

针对上述痛点问题,我们开始尝试一种新的产品FastDeploy,它可以针对产业落地场景中的重要AI模型,在不同的硬件环境下,支持开发者下载已经预编译好的多种SDK,开发者参考文档,简单几步即可完成AI模型的部署,大幅降低部署难度和时间成本。

现在,FastDeploy发布了0.1版本,该版本具备三类特色能力:

-

低门槛:一行命令下载SDK,一行命令即可体验部署Demo;不同硬件平台一致的代码体验,降低基于业务模型和业务逻辑二次开发难度;经过官方验证,算法模型精度和推理鲁棒性有保证。

-

多场景:支持云、边、端(包括移动端)丰富软硬件环境部署,支持图像、视频流、一键服务化等部署方式,满足不同场景的AI部署诉求。

-

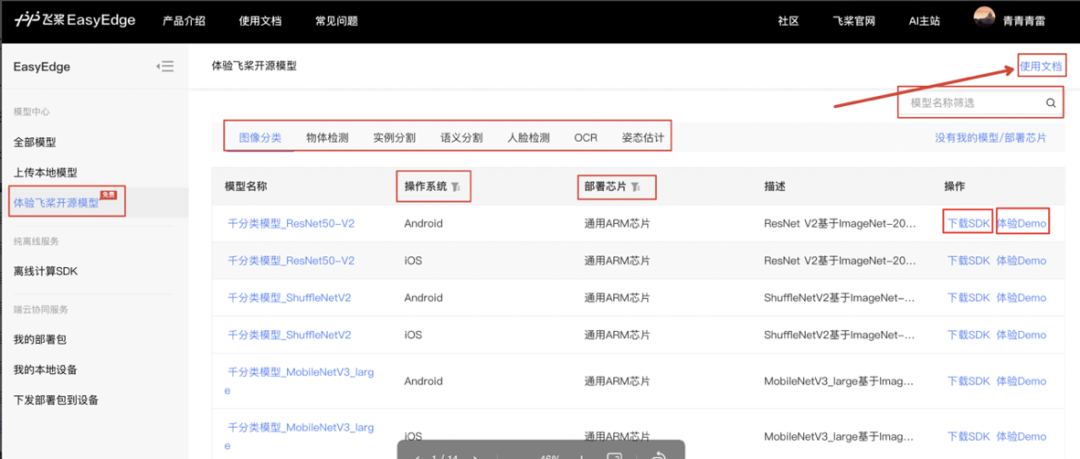

多算法:支持图像分类、目标检测、图像分割、人脸检测、人体关键点检测、文本识别等30多个主流算法模型选型。

点击获得项目传送门

https://github.com/PaddlePaddle/FastDeploy

低门槛使用

一行命令快速体验部署

FastDeploy通过配置文件的方式,实现AI算法的前后处理,新手开发者也可以轻松完成部署。不同平台的API接口定义风格统一,方便开发者基于业务模型和业务逻辑灵活的二次开发。针对开发环境中的部署编译难题,FastDeploy向开发者提供了经官方验证的编译环境和编译脚本,降低AI部署落地的门槛。目前FastDeploy提供了两种SDK下载方式:

- 页面体验,下载即可使用。

- GitHub命令行体验,通过简单的一行命令,即可下载对应的SDK。开发者可以参照文档,快速将下载后的SDK部署到实际项目中。

多场景覆盖

云边端多平台一网打尽

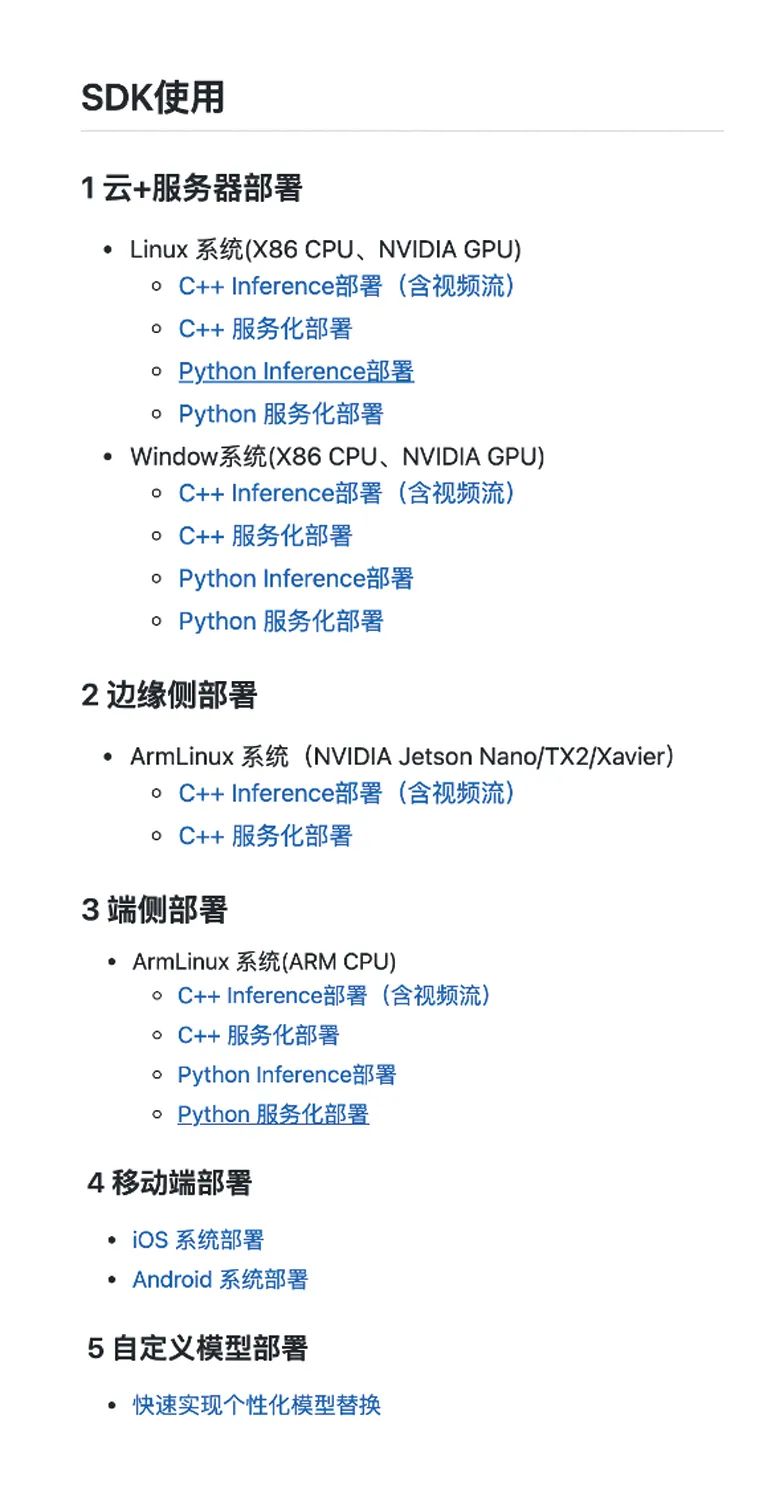

FastDeploy v0.1目前支持Intel X86_64 CPU、NVIDIA GPU X86、ARM CPU(v7、v8)、Jetson Nano、Jetson TX2、Jetson Xavier系列硬件,并支持Windows、Linux、Android、iOS四种操作系统;支持图像、视频流(包括RTSP、RTMP、HLS、HTTP等常见网络协议)输入推理部署,并且可以服务化部署和网页体验;在多数场景同时支持C++部署和Python部署,满足了不同开发者的差异化部署诉求。

多算法支持

赋能不同行业AI落地

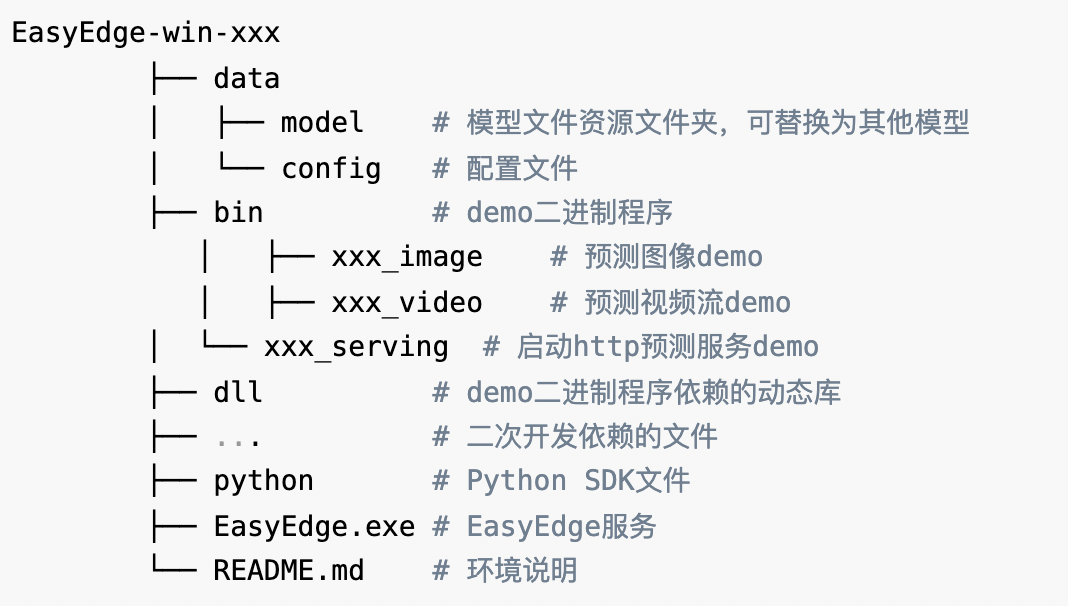

FastDeploy v0.1覆盖7大类算法(图像分类、目标检测、语义分割、实例分割、人脸检测、人体关键点检测、文本识别),提供近300个SDK。同时,FastDeploy可以快速实现个性化模型替换,开发者只需要将训练好的模型替换到部署SDK中,即可完成自己业务模型的快速部署。

快速开始教程

开发者仅需要下载对应模型、硬件、操作系统的SDK,一行代码即可体验FastDeploy丰富的部署能力。

我们以YOLOv5为例,来看下FastDeploy在不同平台(Linux系统、Windows系统、Android系统、iOS系统)的SDK工程实例。

- YOLOv5在NVIDIA GPU / X86 CPU Windows下的工程实例:

- YOLOv5在NVIDIA GPU / X86 CPU Linux下的工程实例(包括C++和python语言):

- YOLOv5在ARM CPU Android下的工程实例:

- YOLOv5在ARM CPU iOS下的工程实例:

FastDeploy包含两种使用方法,图形化界面方式和命令行方式。详细操作步骤见下图。

- 图形界面方式:

- 命令行方式:

了解更多

想了解更多如何使用FastDeploy快速推理,可以:

- 参考对应的文档:

向下滑动查看所有内容

- 更多FastDeploy产品信息,可以参看GitHub详细了解:

https://github.com/PaddlePaddle/FastDeploy

- 欢迎更多参与AI模型部署的的开发者们,加入FastDeploy的社区交流。

私享线上交流会

为了充分和开发者交流产品使用中遇到的难题,6月30日晚20:30,FastDeploy产研团队核心成员将和进群开发者一起召开一次线上腾讯会议讨论会,针对性地讨论目前大家遇到的问题与未来需求,欢迎大家扫码进群,获取6月30日线上会议链接!限定200席,报满为止。

关注飞桨公众号,报名线上交流会

关注【飞桨PaddlePaddle】公众号

获取更多技术内容~

-

-

相关阅读:

[附源码]java毕业设计-室内田径馆预约管理系统

JavaScript基础

VALSE2022内容总结

软件测试(三)测试分类

性能测试-基础01

计算机毕业设计Java校园社团管理平台演示录像2021(源码+系统+mysql数据库+Lw文档)

GitHub WebHook 使用教程

NX二次开发-UFUN获取对象的显示属性(图层,颜色,空白状态,线宽,字体,高亮状态)UF_OBJ_ask_display_properties

RPC和HTTP的理解

537页15万字大数据治理体系、大数据可视化平台及应用方案

- 原文地址:https://blog.csdn.net/PaddlePaddle/article/details/125490981