-

CVPR2022-不对称分辨率图像的立体匹配

CVPR2022-不对称分辨率图像的立体匹配

0. 摘要

- 研究问题:一对不同分辨率图像的立体匹配;

- 方法:无监督学习、特征度量一致性、自增强优化策略;

- 验证:在各种退化的模拟数据集和自收集的真实数据集上的实验验证了所提方法优于现有解决方案。

1. 介绍

-

研究背景及意义:目前,由两个(或多个)不同焦距镜头组成的远距离相机系统广泛应用于智能手机中。这类系统通常在一次拍摄中生成一对(或一组)具有不同分辨率的图像,这使得许多理想的应用成为可能,例如连续光学变焦和图像质量增强。对于这些应用,分辨率不对称立体图像的对应点估计是一个关键步骤,通常由传统对称立体匹配算法(如SGM)和图像上采样来进行。然而这种方法很容易受到图像上采样引入的伪影影响,当上采样范围很大时这种影响更加明显。

-

贡献总结:

- 第一个使用无监督学习方法从分辨率非对称立体对中估计对应点;

- 实现特征度量一致性,以避免因未知退化而导致的光度不一致性;

- 一种通过渐进损失更新来增强特征度量一致性的自增强策略;

- 在模拟数据集和真实数据集上,与比较方法相比有明显的性能提升。

-

研究方法介绍:

-

无监督学习:对于分辨率非对称的情况,有监督方法不仅需要视差真值和高质量的退化视图作为标签,而且还需要明确退化形式来学习网络参数,这使得它很难适用于各种复杂的现实世界系统。因此,我们转向无监督学习的方向。

-

特征度量一致性:对于无监督立体匹配,最广泛采用的假设是光度一致性。

-

如图1(a)所示,对称立体对中的对应像素有 I L [ p L ] = I R [ p R ] I_{L}[p_{L}]=I_{R}[p_{R}] IL[pL]=IR[pR];

-

如图1(b)所示,非对称立体对中的对应像素可以不具有相同的强度或颜色,这种光度不一致会给对应点学习带来新的困难;

-

现有的解决方法是通过超分辨率(SR)技术将LR视图恢复到HR视图,然而,现有的SR方法大多是退化特定的,实际退化与假设的退化不同时,性能就会下降;

-

本文提出了通过在特征空间中而不是在图像空间中施加两个视图的一致性,称为特征度量一致性,通过特征提取器可以产生特定具有一致性的特征,即,图1(b)中的 F L [ p L ] = F R [ p R ] F_{L}[p_{L}]=F_{R}[p_{R}] FL[pL]=FR[pR]。然后可以利用这些特征来制定一个特征度量损失,以避免光度不一致。

特征度量一致性是通过实验发现的。虽然用光度损失训练网络效果不是最好的,但是训练出来的 特征提取器能够提取具有一致性的特征。

-

-

- 自增强优化策略:通过特征度量损失对立体匹配网络进行优化时,特征提取器也得到了优化,能进一步增强特征度量一致性。为此,引入了一种自增强策略来迭代优化特征提取器。具体地说,我们使用从前一阶段学习到的特征提取器来形成当前阶段的新的特征度量损失,新的特征度量损失再用于下一阶段网络训练学习新的特征提取器,依次迭代优化。这样,本文方法即使对大的退化仍然有效。

2. 分辨率非对称立体匹配方法介绍

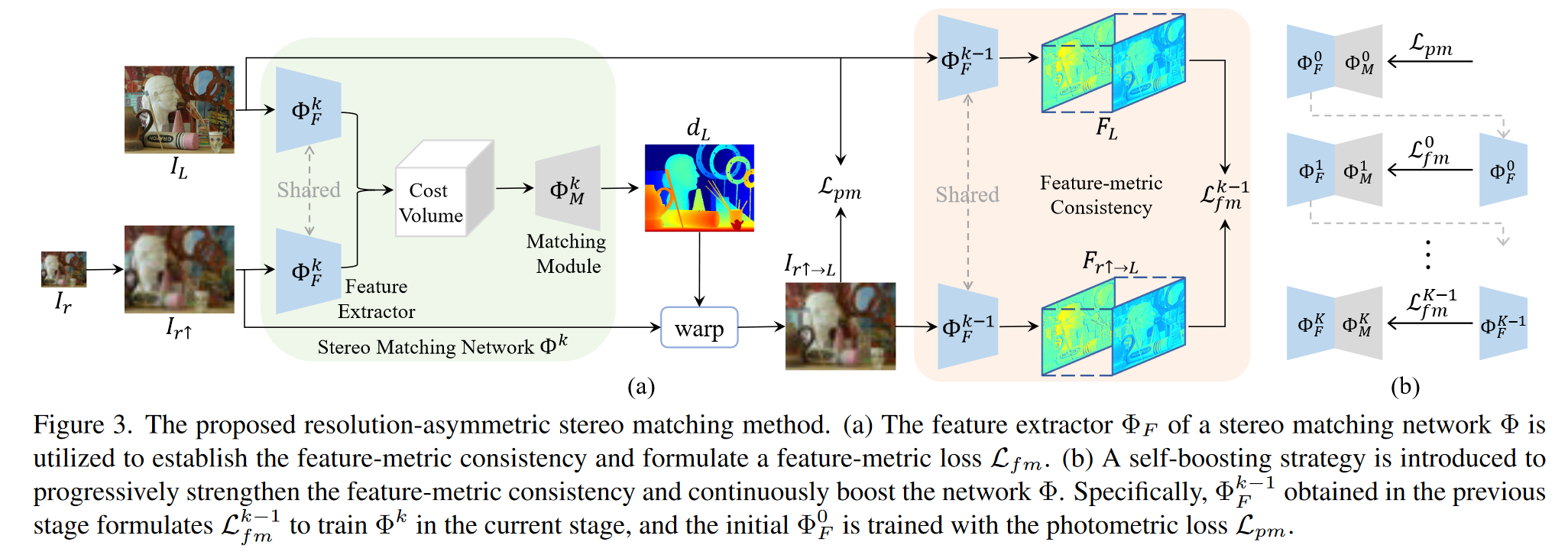

本文方法流程图:

2.1 光度一致性学习

-

将立体对 I L I_{L} IL和 I r ↑ I_{r \uparrow} Ir↑作为输入,无监督立体匹配网络 Φ ( ⋅ ; θ ) \Phi(\cdot ; \theta) Φ(⋅;θ)预测相对于左视图 I L I_{L} IL的视差图 d L = Φ ( I L , I r ↑ ; θ ) d_{L}=\Phi(I_{L},I_{r \uparrow} ; \theta) dL=Φ(IL,Ir↑;θ),基于对应点的光度一致性进行训练,即:

I L [ p L ] = I r ↑ [ p r ↑ ] (1) I_{L}[p_{L}]=I_{r \uparrow}[p_{r \uparrow}] \tag {1} IL[pL]=Ir↑[pr↑](1)

-

如果视差 d L [ p L ] d_{L}[p_{L}] dL[pL]得到精确地估计,那么左图的 I L [ p L ] I_{L}[p_{L}] IL[pL]可以由右图的 I r ↑ [ p L ] I_{r \uparrow}[p_{L}] Ir↑[pL]结合视差变换得到,即:

I r ↑ → L [ p L ] = I r ↑ [ p L − d L [ p L ] ] (2) I_{r \uparrow \rightarrow L}[p_{L}]=I_{r \uparrow}[p_{L}-d_{L}[p_{L}]] \tag {2} Ir↑→L[pL]=Ir↑[pL−dL[pL]](2)

-

因此,光度损失可由 I L I_{L} IL及其重建结果 I r ↑ → L I_{r \uparrow \rightarrow L} Ir↑→L之间的误差构成,一般是带权重 α \alpha α的 L 1 L_{1} L1和 S S I M SSIM SSIM距离的组合,即:

L p m = ∥ I L − I r ↑ → L ∥ 1 + α ( 1 − S S I M ( I L , I r ↑ → L ) ) (3) \mathcal{L}_{pm}=\| I_{L}-I_{r \uparrow \rightarrow L} \|_{1}+\alpha (1-SSIM(I_{L},I_{r \uparrow \rightarrow L})) \tag {3} Lpm=∥IL−Ir↑→L∥1+α(1−SSIM(IL,Ir↑→L))(3)

SSIM:结构相似性指标(Structural Similarity Index Measure)

先用光度一致性损失 L p m \mathcal{L}_{pm} Lpm训练出一个初始网络 Φ 0 \Phi^{0} Φ0包含特征提取网络 Φ F 0 \Phi^{0}_{F} ΦF0和匹配网络 Φ M 0 \Phi^{0}_{M} ΦM0

2.2 特征度量一致性学习

- 给定一个立体对 I L I_{L} IL和 I r ↑ I_{r \uparrow} Ir↑, Φ ( ⋅ ; θ F ) \Phi (\cdot ;\theta _{F} ) Φ(⋅;θF)提取的特征 F L = Φ F ( I L ; θ F ) F_{L}=\Phi_{F} (I_{L};\theta _{F}) FL=ΦF(IL;θF)和 F r ↑ = Φ F ( I L ; θ F ) F_{r \uparrow}=\Phi_{F} (I_{L};\theta _{F}) Fr↑=ΦF(IL;θF),这两个特征在非对称像素的对应点上是一致的,即:

F L [ p L ] = F r ↑ [ p r ↑ ] (4) F_{L}[p_{L}]=F_{r \uparrow}[p_{r \uparrow}] \tag {4} FL[pL]=Fr↑[pr↑](4)

-

将特征 F L F_{L} FL和 F r ↑ F_{r \uparrow} Fr↑串联成一个代价体,并用 Φ M ( ⋅ ; θ M ) \Phi_{M} (\cdot ; \theta _{M}) ΦM(⋅;θM)进行正则化,回归出视差图 d L d_{L} dL。在获得根据 d L d_{L} dL变换后的左视图 I r ↑ → L I_{r \uparrow \rightarrow L} Ir↑→L ,利用特征提取器 Φ F ( ⋅ ; θ F ) \Phi_{F} (\cdot ;\theta _{F} ) ΦF(⋅;θF)将 I L I_{L} IL和 I r ↑ → L I_{r \uparrow \rightarrow L} Ir↑→L 投影到特征空间,得到 F L F_{L} FL和 F r ↑ → L = Φ F ( I r ↑ → L ; θ F ) F_{r \uparrow \rightarrow L}=\Phi_{F} (I_{r \uparrow \rightarrow L} ;\theta _{F} ) Fr↑→L=ΦF(Ir↑→L;θF)。

-

可以仿照光度一致性损失构建特征度量损失 L f m \mathcal{L}_{fm} Lfm:

L f m = ∥ F L − F r ↑ → L ∥ 1 + α ( 1 − S S I M ( F L , F r ↑ → L ) ) (5) \mathcal{L}_{fm}=\| F_{L}-F_{r \uparrow \rightarrow L} \|_{1}+\alpha (1-SSIM(F_{L},F_{r \uparrow \rightarrow L})) \tag {5} Lfm=∥FL−Fr↑→L∥1+α(1−SSIM(FL,Fr↑→L))(5)

然后用特征度量一致性损失 L f m \mathcal{L}_{fm} Lfm重新训练网络得到 Φ 1 \Phi^{1} Φ1包含特征提取网络 Φ F 1 \Phi^{1}_{F} ΦF1和匹配网络 Φ M 1 \Phi^{1}_{M} ΦM1

2.3 自增强策略

如图3(b)所示,给定一个分辨率非对称的立体数据集。

- 首先使用 L p m \mathcal{L}_{pm} Lpm训练一个立体匹配网络 Φ ( ⋅ ; θ F 0 ; θ M 0 ) \Phi (\cdot ;\theta^{0} _{F} ; \theta^{0} _{M}) Φ(⋅;θF0;θM0)(简称 Φ 0 \Phi^{0} Φ0),其特征提取器 Φ F 0 \Phi^{0}_{F} ΦF0形成特征度量损失 L f m 0 \mathcal{L}^{0}_{fm} Lfm0。

- 然后利用 L f m 0 \mathcal{L}^{0}_{fm} Lfm0优化了一个新的立体匹配网络 Φ 1 \Phi^{1} Φ1。在 Φ 1 \Phi^{1} Φ1调整的过程中,用于计算 L f m 0 \mathcal{L}^{0}_{fm} Lfm0的特征提取器是固定的。

- 调整完成后,增强后的 Φ F 1 \Phi^{1}_{F} ΦF1又可以形成更好的特征度量损失 L f m 1 \mathcal{L}^{1}_{fm} Lfm1(将用于下一步增强)。不断利用 L f m k − 1 \mathcal{L}^{k-1}_{fm} Lfmk−1来调整 Φ k \Phi^{k} Φk,其中 k ∈ 1 , . . . , K k \in 1,...,K k∈1,...,K。

注意,我们只在网络 Φ k \Phi^{k} Φk收敛于 L f m k − 1 \mathcal{L}^{k-1}_{fm} Lfmk−1时才构建新的损失 L f m k \mathcal{L}^{k}_{fm} Lfmk,因为频繁改变损失空间可能会使训练过程不稳定。

通过这种自增强策略,可以获得具有逐步增强的特征度量一致性的连续优化网络

3. 实验

3.1 在模拟数据集上的实验

-

数据集:

- Middlebury和KITTI2015;Inria_SLFD和HCI

- 退化方式:

- 双三次下采样(BIC)

- 各向同性高斯核下采样(IG)

- 各向异性高斯核下采样(AG)

- 各向同性高斯核JPEG压缩下采样(IG JPEG)

- 各向异性高斯核JPEG压缩下采样(AG JPEG)

-

评估指标:

- 3像素误差(3PE),全部区域误差超过3像素且超过真实值5%大小的异常点百分比;

- 终点误差(EPE),估计视差和真实视差之间的平均绝对差异。

-

对比的方法:

- SGM

- SR预处理+BaseNet

- RCAN+BaseNet

- DAN+BaseNet

- BsaeNet+其他特征提取器

- BaseNet+CL

- BaseNet+AE

SR:超分辨率恢复,非盲SR方法RCAN,盲SR方法DAN

其他特征提取器:用对比损失(Contrastive Loss,CL)训练的特征网络,用自动编码器(Auto-Encoder,AE)作为特征网络。

BaseNet都是流行的PSMNet。使用ADAM解算器优化网络( β 1 = 0.9 , β 2 = 0.999 \beta 1=0.9,\beta 2=0.999 β1=0.9,β2=0.999)我们将学习率设置为0.001。视差的平滑约束是通过加权平滑度损失来实现的,即:

KaTeX parse error: \tag works only in display equations

因此,所有基于学习的解决方案的总体损失函数可以写成:

KaTeX parse error: \tag works only in display equations

式中, λ \lambda λ是权重因子, L p m / f m \mathcal{L}_{pm/fm} Lpm/fm是第一类方法的光度损失,或是第二类方法和我们的方法的相应特征度量损失。自增强策略中的阶段K数设置为3。

-

结果

-

定量结果

-

定性结果

-

3.2 真实数据集上的实验

-

数据集:不对称立体对由华为P30智能手机捕捉。不对称因子约等于3。经过摄像机标定和立体校正,我们为室内外场景捕获了30对不对称立体对。我们随机分成5对作为测试集,其他作为训练集。

-

结果:

4. 限制和结论

- 限制:

- 除了分辨率之外,还可能存在其他类型的不对称性(例如颜色和亮度)。是否可以通过扩展所提出的方法直接解决其他类型的不对称问题仍然是一个悬而未决的问题。

- 结论:

- 本文揭示了从分辨率非对称立体图像进行无监督对应估计的主要挑战是光度不一致性。为了克服这一挑战,我们以一种有效的方式实现了特征度量一致性,并引入了一种自增强策略来增强这种一致性。通过综合实验验证,我们的方法在处理实际中两个视图之间的各种退化方面表现出了优异的性能。

-

相关阅读:

Less常用内置函数

Linux·socket编程

搭建灾情快速分析系统 | Bigemap助力防灾减灾重点工作

R与Python:编程语言间的差异与魅力

基于SM2证书实现SSL通信

10.4 认识Capstone反汇编引擎

分类预测 | MATLAB实现SSA-CNN-GRU-Attention数据分类预测(SE注意力机制)

Jenkins使用pipeline部署服务到远程服务器

二叉树习题总结

Shapiro-Wilk正态性检验(Shapiro和Wilk于1965年提出)

- 原文地址:https://blog.csdn.net/qq_40918859/article/details/125471569