-

AI算力基础 -- Nvidia TESLA V100 GPU

– 2017年1. Introduction to the NVIDIA Tesla V100 GPU Architecture

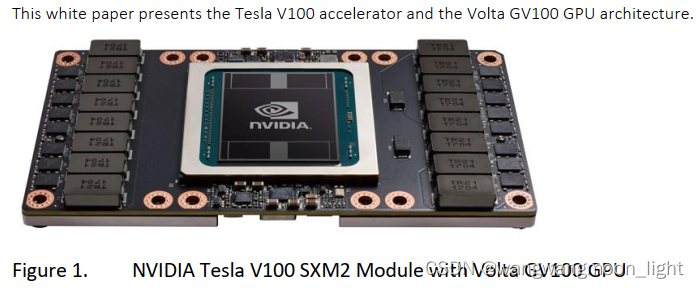

新的NVIDIA®Tesla®V100加速器(如图1所示)集成了强大的新

Volta™GV100 GPU。GV100不仅建立在其前身Pascal™的基础上

GP100 GPU,它显著提高了性能和可扩展性,并增加了许多提高可编程性的新特性。这些进步将为高性能计算、数据中心、超级计算机以及深度学习系统和应用提供动力。

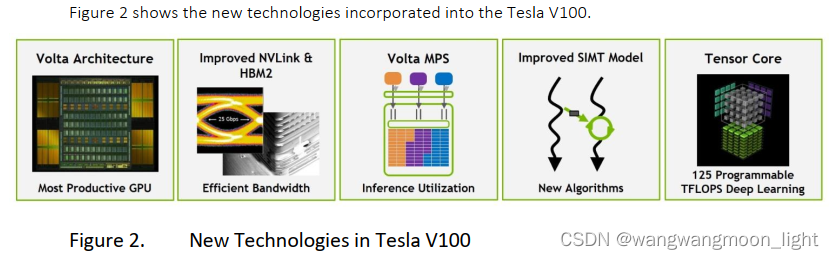

2. Tesla V100:The AI Computing andd HPC PowerHouse

GV100 GPU包含 21.1 billion transistors 个晶体管,芯片尺寸为 815 mm2。它是在一个新的台积电12纳米FFN (FinFET NVIDIA)高性能制造工艺定制

与之前的Pascal GPU一代相比,GV100提供了更多的计算性能,并添加了许多新特性。GV100不仅简化了GPU编程和应用移植,还提高了GPU的资源利用率。GV100是一款非常高效的处理器,每瓦的性能非常出色。KEY FEATURES:

2.1 New Streaming Multiprocessor (SM) Architecture Optimized for Deep Learning

Volta的特点是在GPU的中心位置重新设计了SM处理器架构。新的Volta SM比上一代Pascal设计节能50%,使FP32和FP64的性能在相同的功率范围内大幅提升。

专门为深度学习设计的**新张量核心(Tensor Cores)**可为训练提供高达12倍的峰值TFLOPS,为推理提供高达6倍的峰值TFLOPS。通过独立的并行整数和浮点数据路径,Volta SM在混合计算和寻址计算的工作负载下效率也高得多。2.2 Second-Generation NVIDIA NVLink

第二代 NVIDIA 的 NVLink 高速互连提供了更高的带宽,更多的链路,以及针对多GPU 和 多GPU/CPU 系统配置的改进的可伸缩性。Volta GV100支持最多6条NVLink链路和 300GB/s 的总带宽,而 GP100 支持 4 条 NVLink 链路和 160GB/s 的总带宽。NVLink现在支持基于IBM Power 9 CPU的服务器的CPU控制和缓存一致性功能。新NVIDIA DGX-1搭载V100 AI超级计算机,使用NVLink为超快深度学习训练提供更大的可扩展性。2.3 HBM2 Memory: Faster, Higher Efficiency

Volta的高度 tuned 的16GB HBM2内存子系统提供 900GB/s 的峰值内存带宽。三星新一代HBM2内存和Volta新一代内存控制器的结合,提供了比Pascal GP100高出1.5倍的内存带宽,在许多工作负载下,最高可达95%的内存带宽利用率2.4 Volta Multi-Process Service

Volta MPS (Volta Multi-Process Service)是Volta GV100架构的新特性,提供CUDA MPS服务器关键部件的硬件加速功能,使共享GPU的多个计算应用能够提高性能、隔离和服务质量。Volta MPS还将MPS客户端的最大数量从16个增加到3倍

Pascla to 48 on Volta.2.5 Enhanced Unified Memory and Address Translation Services

GV100统一内存技术包括新的访问计数器,允许更准确地将内存页迁移到最频繁访问它们的处理器,提高了处理器之间共享内存范围的效率。在IBM Power平台上,这是新的地址转换服务(ATS)支持允许GPU直接访问CPU的页表。2.6 Maximum Performance and Maximum Efficiency Modes

在最大性能模式下,Tesla V100加速器将工作到其TDP

(Thermal Design Power)水平300 W,以加快应用程序,需要最快的计算速度和最高的数据吞吐量。最高效率模式允许数据中心管理人员调整 TeslaV100加速器的功率使用,以达到最佳的每瓦性能。在一个机架中,所有gpu都可以设置不超过功耗上限,从而大大降低功耗,同时仍然可以获得优异的机架性能2.7 Cooperative Groups and New Cooperative Launch APIs

协作组是cuda9中引入的一种新的编程模型,用于组织通信线程组。协作组允许开发人员表达线程通信的粒度,帮助他们表达更丰富、更高效的并行分解。Kepler此后,所有NVIDIA gpu都支持基本协作组功能. Pascal和Volta支持新的协作启动api,支持CUDA线程块之间的同步。Volta增加了对新的同步模式的支持。2.8 Volta Optimized Software

新版本的深度学习框架,如Caffe2, MXNet, CNTK, TensorFlow等,利用Volta的性能,提供更快的训练时间和更高的多节点训练性能。Volta优化版本的GPU加速库,如cuDNN, cuBLAS和TensorRT利用Volta GV100架构的新功能,为深度学习推理和High提供更高的高性能计算(HPC)应用。NVIDIA CUDA Toolkit 9.0版本包括新的api和对Volta特性的支持,以提供更简单的编程

EXTREME PERFORMANCE FOR AI AND HPC

3. NVIDIA GPUs – The Fastest and Most Flexible Deep Learning Platform

4. GV100 GPU Hardware Architecture In-Depth

5. GV100 CUDA Hardware and Software Architecture Advances

-

相关阅读:

git常用命令和参数有哪些?【git看这一篇就够了】

【每日一题】53. 最大子数组和-2023.11.20

安科瑞故障电弧探测器在建筑电气的设计与应用

零基础html学习-第五期

彻底搞懂内存屏障(下)

面试官:设计模式是什么?

Kubernetes弃用Dockershim,转向Containerd:影响及如何应对

算法:(六)栈

.NET Core中Emit的使用

【用unity实现100个游戏之12】unity制作一个俯视角2DRPG《类星露谷物语》资源收集游戏demo

- 原文地址:https://blog.csdn.net/wangwangmoon_light/article/details/125453619