论文信息

论文标题:Structural and Semantic Contrastive Learning for Self-supervised Node Representation Learning

论文作者: Kaize Ding 、Yancheng Wang 、Yingzhen Yang、Huan Liu

论文来源:2022, arXiv

论文地址:download

论文代码:download

1 摘要

-

- encoding architecture

- augmentation

- contrastive objective

2 介绍

现存两阶段对比学习框架存在的问题:

-

- Shallow Encoding Architecture

- Arbitrary Augmentation Design

- Semanticless Contrastive Objective

本文提出的方法 S3−CL,包括三个部分:

-

- An encoder network

- A structural contrastive learning module

- A semantic contrastive learning module

框架如下所示:

3 方法

3.1 Structural Contrastive Learning

在无监督表示学习中,对比学习方法将每个样本视为一个不同的类,旨在实现实例区分。以类似的方式,现有的GCL方法通过最大化不同增强视图中相同图元素的表示之间的一致性来实现节点级识别。

3.1.1 Structure Augmentation via Graph Diffusion

Step1 :Graph Diffusion

Graph Diffusion :

S=∞∑l=0θlTl∈RN×N(1)

其中:

-

- T∈RN×N 是转移概率矩阵,T=˜Asym=˜D−1/2˜A˜D−1/2;

- θl 是 lth−hop 邻居的权重参数,此处设置 θl=1,其他的权重参数设置为 0;

通过上述参数设置,那么:S(l)=˜Alsym 。

Step2:Feature propagation

然后,使用增广图结构进行特征传播,并使用一层编码器网络 fθ(⋅) 进一步计算节点表示,如下:

H(l)=fθ(S(l)X)=ReLU(S(l)XΘ)(2)

其中,Θ∈RN×D′ 代表着权重参数,计算出的节点表示 H(l) 可以编码图中来自 l−hops 邻域的特征信息。

为更好的利用局部-全局信息,本文进一步设置不同的 l 来执行多个数据增强。具体来说,H(1) 是从局部视图中学习的,因为只用了在直接邻居之间传递的信息,而 {H(l)}Ll=2 是从一组高阶视图中学习的,这些高阶视图编码了不同级别的全局结构信息。

本文的对比学习架构中,目标是通过最大化每个节点的互信息,最大化每个节点的局部视图和高阶视图之间的一致性。

这里并没有直接使用 fθ(⋅) 输出的表示,而是进一步对生成的表示 H(l) 使用一个投影头 gψ(⋅) 【一个两层MLP】,即生成 {U(l)}Ll=1,其中 U(l)=gψ(H(l))。

3.1.2 Structural Contrastive Objective

最大化局部视图 U1 ,和高阶视图 U(l) 之间的一致性(节点级):

L(l)str=−1NN∑i=1logexp(u(1)i⋅u(l)i/τ1)M∑j=0exp(u(1)i⋅u(l)j/τ1)(3)

其中:

-

- u(1)i 和 u(l)i 分别代表着 U(1) 和 U(l) 的第 i 行表示向量;

- 定义{u(l)j}Mj=0 拥有一个正样本,M 个负样本;

所以总损失为:

Lstr=L∑l=2L(l)str(4)

最终的节点表示 H 可以通过将 ˜X=1L∑Ll=1S(l)X 输入编码器网络来计算,以保留局部和全局结构信息。

3.2 Semantic Contrastive Learning

为探讨输入图的语义信息,进一步提出了一个语义对比学习模块,该模块通过鼓励簇内紧凑性和簇间可分离性来明确地捕获数据语义结构。

它通过迭代的推断节点和其对应原型之间的聚类,并进行语义对比学习,促进节点在潜在空间中对应的聚类原型进行语义相似的聚类。Cluster 原型的表示用一个矩阵表示 C∈RK×D′ ,这里的 K 代表着原型数目。ck 代表着 C 的第 k 行,即第 k 个原型的表示向量。节点 vi 的原型分配定义为 Z={zi}ni=1,其中zi∈{1,…,K} 。

3.2.1 Bayesian Non-parametric Prototype Inference.

我们的语义对比学习模块的一个关键组成部分是推断出具有高度代表性的 cluster prototypes。然而,在自监督节点表示学习的设置下,最优的聚类数量是未知的,因此很难直接采用 K-means 等聚类方法对节点进行聚类。为了解决这个问题,我们提出了一种贝叶斯非参数原型推理( Bayesian non-parametric prototype inference)算法来近似最优的聚类数量并计算聚类原型。

我们建立了一个狄利克雷过程混合模型(Dirichlet Process Mixture Model (DPMM)),并假设节点表示的分布是一个高斯混合模型(GMM),其分量具有相同的固定协方差矩阵σI。每个组件都用于建模一个 cluster 的原型。DPMM 模型可以定义为:

G∼DP(G0,α)ϕi∼G for i=1,…,Nhi∼N(ϕi,σI) for i=1,…,N(5)

其中:

-

- G 是由狄利克雷过程 DP(G0,α) 得到的高斯分布;

- α 是 DP(G0,α) 的浓度参数;

- ϕi 是节点表示的高斯采样的均值;

- G0 是高斯分布的的先验均值,本文取 G0 为一个零均值高斯 N(0,ρI);

- ρI 是协方差矩阵;

接下来,我们使用一个折叠的 collapsed Gibbs sampler 用 DPMM来推断 GMM 的组件。Gibbs sampler 对给定高斯分量均值的节点的伪标签进行迭代采样,并对给定节点的伪标签的高斯分量的均值进行采样。当高斯分量 σ→0 的方差变化时,对伪标签进行采样的过程变得确定性的。设 ˜K 表示当前迭代步骤中推断出的原型数量,原型分配更新可以表述为:

zi=argmink{dik}, for i=1,…,N

dik={‖hi−ck‖2 for k=1,…,˜Kξ for k=˜K+1(6)

其中,dik 是确定节点表示 hi 的伪标签的度量。ξ 是初始化一个新原型的边际。在实践中,我们通过对每个数据集进行交叉验证来选择 ξ 的值。根据 Eq.6 中的公式,将一个节点分配给由最近高斯均值对应的分量建模的原型,除非到最近均值的平方欧氏距离大于 ξ。在获得伪标签后,可以通过以下方法计算集群原型表示:

ck=∑zi=khi∑zi=k1, for k=1,…,˜K(7)

注意,我们迭代地更新原型分配和原型表示直到收敛,然后我们将原型的数量 K 设置为推断出的原型的数量 ˜K。原型推理的算法在附录中总结为 Algorithm 2。

3.2.2 Prototype Refinement via Label Propagation

考虑到贝叶斯非参数算法推断出的伪标签可能不准确,我们进一步基于标签传播对 Gibbs sampler 生成的伪标签进行了重新细化。通过这种方法,我们可以平滑噪声伪标签,并利用结构知识改进聚类原型表示。

首先,我们将原型赋值 Z 转换为一个单热的伪标签矩阵 Z∈RN×K ,其中 Zij=1 当且仅当 zi=k。根据个性化PageRank(PPR)的想法,T 聚合步后 Z(T) 的伪标签更新为:

Z(t+1)=(1−β)˜AsymZ(t)+βZ(0)(8)

其中,Z(0)=Z 和 β 可以视为 PPR 中的转移概率。接下来,我们通过设置 zi=argmaxkZ(T)ik i∈{1,…,N} ,将传播的结果 i∈{1,…,N} 转换为硬伪标签。

在使用标签传播对伪标签 Z 进行细化后,我们使用每个集群中节点表示的平均值作为集群原型表示,由ck=∑zi=khi/∑zi=k1 计算出。

3.2.3 Semantic Contrastive Objective

给定原型分配 Z 和原型表示 C,我们的语义对比学习旨在找到网络参数 θ,最大化对数似然定义为:

Q(θ)=N∑i=1logp(xi∣θ,C)(9)

其中 p 是概率密度函数。作为 p(xi∣θ,C)=∑Kk=1logp(xi,zi=k∣θ,C),我们得到

Q(θ)=N∑i=1K∑k=1logp(xi,zi=k∣θ,C)(10)

Q(θ) 的变分下界由

Q(θ)≥N∑i=1K∑k=1q(k∣xi)logp(xi,zi=k∣θ,C)q(k∣xi)=N∑i=1K∑k=1q(k∣xi)logp(xi,zi=k∣θ,C)−N∑i=1K∑k=1q(k∣xi)logq(k∣xi)(11)

其中,q(k∣xi)=p(zi=k∣xi,θ,C) 表示 zi 的后部。由于上面的第二项是一个常数,我们可以通过最小化函 数 E(θ) 来最大化对数似然 Q(θ),如下:

E(θ)=−N∑i=1K∑k=1q(k∣xi)logp(xi,zi=k∣θ,C)(12)

通过让 q(k∣xi)=1{zi=k},E(θ) 可以通过 −∑Ni=1logp(xi,zi∣θ,C) 来计算。在 xi 在不同原型上的先验分布均匀的假设下,我们有p(xi,zi∣θ,C)∝p(xi∣zi,θ,C) 。由我们的DPMM模型生成的每个原型周围的分布是一个高斯分布。如果我们在节点和原型的表示上应用 ℓ2 归一化,我们可以估计p(xi∣zi,θ,C) 通过:

p(xi∣zi,θ,C)=exp(hi⋅czi/τ2)K∑k=1exp(hi⋅ck/τ2)(13)

其中,τ2∝σ2 和 σ 为 Eq.5 定义的DPMM模型中高斯分布的方差。hi 和 czi 是 xi 和 zi−th 原型的代表。因此,E(θ) 可以通过最小化损失函数来最小化,如下:

Lsem=−1NN∑i=1logexp(hi⋅czi/τ2)K∑k=1exp(hi⋅ck/τ2)(14)

Algorithm 1

4.3 Model Learning

4.3.1 Overall Loss

为了以端到端方式训练我们的模型,并学习编码器fθ(⋅),我们共同优化了结构和语义对比学习损失。总体目标函数的定义为:

L=γLstr+(1−γ)Lsem(15)

我们的目标是在训练中最小化 L,γ 是一个平衡因素来控制每个损失的贡献。

值得注意的是,在语义对比学习中,计算出的伪标签 Z 可以用于负示例抽样过程,以避免结构对比学习中的抽样偏差问题。我们从分配给不同原型的节点中,在 Eq.3 中为每个节点选择负样本。对负示例抽样的详细分析见附录C.2。

4.3.2 Model Optimization via EM

采用EM算法交替估计后验分布 p(zi∣xi,θ,C),并优化网络参数θ。我们描述了在我们的方法中应用的 E−step 和 M−step 的细节如下:

E-step

在这一步中,我们的目标是估计后验分布p(zi∣xi,θ,C)。为了实现这一点,我们修复网络参数θ,估计原型 C 和原型分配 Z为了训练编码器网络的稳定性,我们应用贝叶斯非参数原型推理算法的节点表示计算动量编码器H′=fθ′(˜X),动量编码器的θ′参数θ的移动平均更新:

θ′=(1−m)⋅θ+m⋅θ′(16)

其中:

m∈[0,1) 是动量系数

M-step

给定由 E-step 计算的后验分布,我们的目标是通过直接优化语义对比损失函数Lsem来最大化对数似然 Q(θ) 的期望。为了同时执行结构对比学习和语义对比学习,我们优化了一个如 Eq.15 所示的联合整体损失函数。

在对未标记的输入图进行自我监督的预训练后,预训练的编码器可以直接用于生成各种下游任务的节点表示。

5 Experiments

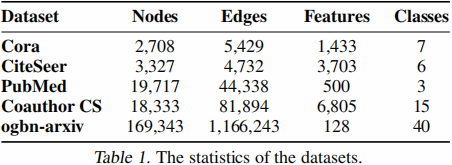

5.1 数据集

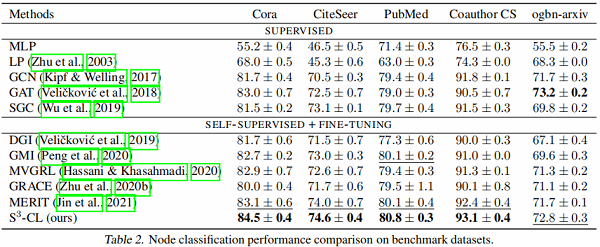

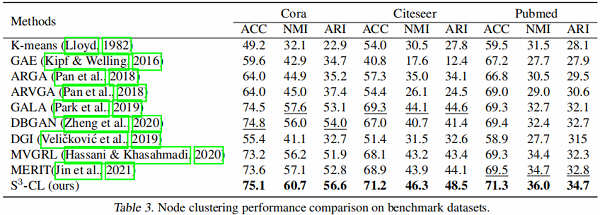

5.2 实验结果

__EOF__