-

大数据学习——安装hive

一. 安装准备

1. 打开虚拟机,启动配置了NameNode节点的虚拟机(一般和mysql在同一台虚拟机)并连接shell

二. 安装

1. 上传hive安装包

提取码:6666

切换到/opt/install_packages目录下

可以将之前解压的rpm文件删除

将安装包拖至目录下

2. 解压

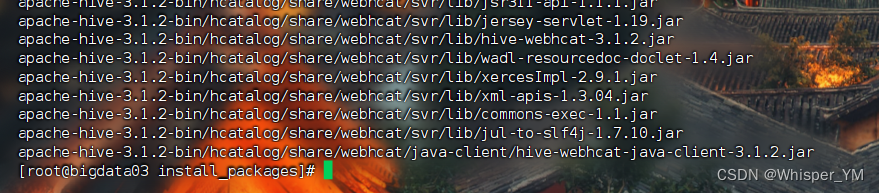

tar -zxvf apache-hive-3.1.2-bin.tar.gz -C /opt/softs/

切到/opt/softs目录下,修改包名称

cd /opt/softs

mv apache-hive-3.1.2-bin/ hive3.1.2

3. 配置环境变量

vim /etc/profile

添加以下内容

#HIVE_HOME

export HIVE_HOME=/opt/softs/hive3.1.2

export PATH=$PATH:$HIVE_HOME/bin

重新加载配置文件

source /etc/profile

输出路径检查

echo $HIVE_HOME

4. 解决jar包冲突

进入hive3.1.2目录下

cd /opt/softs/hive3.1.2

ll

cd lib

ll

(1)将log4j-slf4j-impl-2.10.0.jar设置为不可用(修改后缀的方式)

mv log4j-slf4j-impl-2.10.0.jar log4j-slf4j-impl-2.10.0.jar.bak

(2)上传mysql连接的jar包

提取码:6666

将jar包拖至jar目录下

将上传的jar包拷贝到hive的lib目录下

cp /opt/jar/mysql-connector-java-5.1.37.jar /opt/softs/hive3.1.2/lib/

(3)调整guava-*.jar包

复制一个窗口,到hadoop目录下去找类似的包

cd /opt/softs/hadoop3.1.3/share/hadoop/common/lib/

ll

把高版本的jar包拷贝到hive 的lib目录下

cp guava-27.0-jre.jar /opt/softs/hive3.1.2/lib

执行成功后回到原窗口检查

将原来版本的加上bak后缀

mv guava-19.0.jar guava-19.0.jar.bak

三. 配置文件的修改

修改hive的conf文件

cd /opt/softs/hive3.1.2/conf/

1. hive-site.xml内容如下,编写完成后上传到conf目录下

javax.jdo.option.ConnectionURL

jdbc:mysql://bigdata03:3306/hive?createDatabaseIfNotExist=true&useSSL=false&useUnicode=true&characterEncoding=UTF-8

javax.jdo.option.ConnectionDriverName

com.mysql.jdbc.Driver

javax.jdo.option.ConnectionUserName

root

javax.jdo.option.ConnectionPassword

123456

hive.metastore.warehouse.dir

/user/hive/warehouse

hive.server2.thrift.bind.host

bigdata03

hive.server2.thrift.port

10000

hive.server2.enable.doAs

false

hive.server2.active.passive.ha.enable

true

2. 在hadoop中core-site.xml中添加如下配置

hadoop.proxyuser.root.hosts

*

hadoop.proxyuser.root.groups

*

vim /opt/softs/hadoop3.1.3/etc/hadoop/core-site.xml

3. 将修改同步到另外两台虚拟机

scp core-site.xml root@bigdata04:/opt/softs/hadoop3.1.3/etc/hadoop/

scp core-site.xml root@bigdata05:/opt/softs/hadoop3.1.3/etc/hadoop/

分别到另两台虚拟机上查看

分别到另两台虚拟机上查看cat /opt/softs/hadoop3.1.3/etc/hadoop/core-site.xml

四. 初始化hive的元数据库

1.开启mysql并连接数据库

2. 进行初始化

再复制一台虚拟机

cd /opt/softs/hive3.1.2/bin

schematool -dbType mysql -initSchema

3. 查看

在原虚拟机上查看数据库

use hive;

show tables;

五. 启动hive

在复制的虚拟机上执行hive命令

出错喽

因为没启动hdfs

启动一下

start-dfs.sh

再次启动hive

如果启动有问题,可以查看hive日志

tail -500f /tmp/root/hive.log

-

相关阅读:

SQL数据分析极简入门——SQL简介与基础知识

android studio 编译乱码的问题

2023.10.01 homework

数据分析利器:XGBoost算法最佳解析

npm-install 命令报错 -4048

geneious中有的功能无法使用

商场做小程序商城的作用是什么?

困在赛博世界里的“仿生机器人”

微软Surface/Surface pro笔记本电脑进入bios界面

解读HarmonyOS 应用与服务生态

- 原文地址:https://blog.csdn.net/2301_78409414/article/details/139634393