-

深度学习之激活函数——Leaky ReLU

Leaky ReLU激活函数是为了解决ReLU激活函数会出现的dead relu神经元死亡的现象,而这一现象的根本原因是ReLU函数在 x < 0 x<0 x<0的范围内梯度恒为0,无法更新参数。所以Leaky ReLU将 x < 0 x<0 x<0的部分换成一个斜率很小的一个线性函数来解决这一问题。

函数表达式

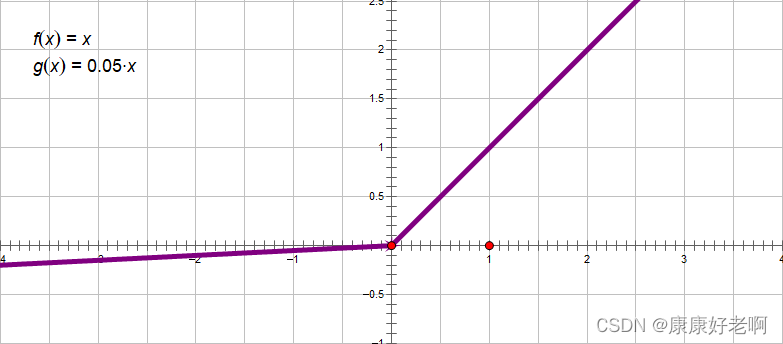

f ( x ) = m a x { α x , x } , 其中 α < < 1 f(x)=max\{\alpha x,x\},其中\alpha<<1 f(x)=max{αx,x},其中α<<1

当 x < 0 x<0 x<0时,函数值为 f ( x ) = α x f(x)=\alpha x f(x)=αx,比如像 f ( x ) = 0.001 x f(x)=0.001x f(x)=0.001x;当 x > 0 x>0 x>0时,函数值为 f ( x ) = x f(x)=x f(x)=x

函数图像

函数特性

虽然其是ReLU的优化,但是实验中其整体效果不如ReLU(或者说不相上下,但是在ReLU调参合理的情况下,Leaky ReLU优势很弱)。如果数据处理后绝大部分为正数或者归一化到(0,1),则无需使用Leaky ReLU。

优点:

- 可以在一定程度上解决ReLU出现的dead ReLU问题,虽然斜率 α \alpha α的值很小,但是依然存在梯度可以更新

缺点:

- 由于该函数很像一个线性函数,所以其对复杂分类的效果不是很好

-

相关阅读:

学生HTML个人网页作业作品 HTML+CSS校园环保(大学生环保网页设计与实现)

短链系统设计-用户自定义短链

(STM32)从零开始的RT-Thread之旅--基础项目构建与时钟配置

Linux找茬

11.CF522D Closest Equals 线段树+离线询问

Java 泛型中的通配符

如何让开发者直接在应用后台控制用户的运动状态?

SpringCloud之gateway——流量控制组件Sentinel实战

文档检索(search project)

【记录】深度学习环境配置(pytorch版)

- 原文地址:https://blog.csdn.net/m0_61787307/article/details/139023742