-

【nlp】2.4 GRU模型

1 GRU介绍

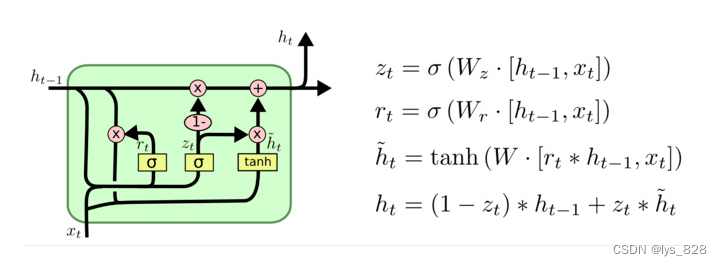

GRU(Gated Recurrent Unit)也称门控循环单元结构, 它也是传统RNN的变体, 同LSTM一样能够有效捕捉长序列之间的语义关联, 缓解梯度消失或爆炸现象. 同时它的结构和计算要比LSTM更简单, 它的核心结构可以分为两个部分去解析:

- 更新门

- 重置门

2 GRU的内部结构图

2.1 GRU结构分析

有了前面RNN和LSTM模型的理解,对于GRU的结构认知理解就简单多了。

当Zt=1,表示完全使用本次隐藏层信息

当Zt=1,表示完全使用本次隐藏层信息

当Zt=0,表示完全使用上一个隐藏层信息结构解释图:

-

相关阅读:

java计算机毕业设计web考试资料交易系统设计与实现源码+mysql数据库+系统+lw文档+部署

CAUSE: 加载证书时出错PKCS12 key store mac invalid - wrong password

Java注解式开发

【Vue】Router路由无法跳转问题整理

【工作规划】未来自我学习计划及发展注意事项

Matlab中rdivide函数的使用

Mac上安装Mysql8.0修改my.cnf配置文件(忽略大小写)

【剑指offer系列】44. 数字序列中某一位的数字

Spring security5.5.7出现Encoded password does not look like BCrypt异常

在 SQL Server 中,可以使用内置函数 NEWID() 来生成一个随机的 GUID(全局唯一标识符)。可以将此 GUID 作为字符串拼接到查询结果中。

- 原文地址:https://blog.csdn.net/lys_828/article/details/134399477