-

ECA-Net(Efficient Channel Attention Network)

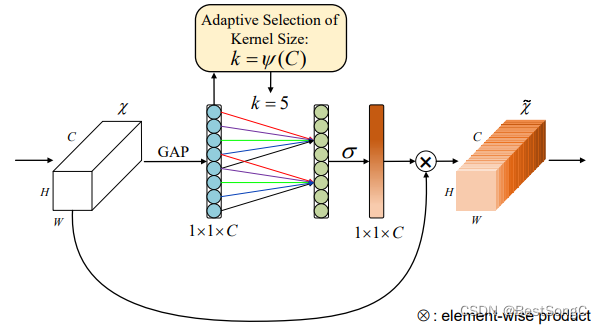

ECA-Net(Efficient Channel Attention Network)是一种用于计算机视觉任务的注意力模型,旨在增强神经网络对图像特征的建模能力。本文详细介绍ECA-Net注意力模型的结构设计,包括其背景、动机、组成部分以及工作原理。ECA-Net模块的整体结构如下图所示:

背景

在计算机视觉领域,卷积神经网络(CNNs)已经取得了巨大的成功,但它们在处理图像时存在一些限制。其中之一是CNNs倾向于平等地对待图像中的所有特征通道,而忽视了不同通道之间的相关性。这导致网络在提取特征时可能会受到冗余信息的干扰,从而降低了性能。为了解决这一问题,注意力机制被引入到CNNs中,允许网络动态地调整对不同特征通道的关注度。ECA-Net是一种基于注意力机制的模型,通过引入通道注意力来增强网络对特征的建模能力。

动机

ECA-Net的设计灵感来自于SE-Net(Squeeze-and-Excitation Network)和CBAM(Convolutional Block Attention Module)等注意力模型。SE-Net通过学习通道权重来增强网络对不同通道的关注度,而CBAM结合了通道注意力和空间注意力。然而,这些模型通常需要更多的计算资源和参数。ECA-Net的动机是在保持计算效率的同时提供有效的通道注意力机制。

ECA-Net的结构设计

ECA-Net的核心思想是在卷积层之后引入通道注意力,以动态地调整不同通道的响应。以下是ECA-Net的主要结构设计:(1)基本卷积网络:ECA-Net通常采用标准的卷积神经网络作为其基本网络结构(2)全局平均池化(Global Average Pooling):在卷积层的输出之后,使用全局平均池化来降维特征图。全局平均池化将每个特征通道的数值取平均,生成一个通道数相同的向量;(3)通道注意力模块(Channel Attention Module):通道注意力模块是ECA-Net的核心组成部分。它在全局平均池化的基础上引入了注意力机制,以学习不同通道的重要性。通道注意力模块包括以下步骤:

-

Squeeze:通过全连接层(通常是一个单一的全连接层)将全局平均池化的输出降维到一个较小的向量。这个向量捕捉了每个通道的全局信息

-

Excitation:通过激活函数,如Sigmoid或ReLU,对Squeeze阶段的输出进行非线性变换。这将产生每个通道的注意力权重

-

Scale:将Excitation阶段的输出应用于卷积层的输入,从而动态地调整不同通道的响应

-

重标定(Re-scaling):通道注意力模块的输出被用于重新缩放卷积层的输出。这意味着具有更高注意力权重的通道将得到更大的响应,而具有较低权重的通道将受到抑制

-

残差连接:通道注意力模块的输出与卷积层的输入进行残差连接,以确保信息的无损传递

-

后续卷积层:通道注意力模块的输出可以连接到后续的卷积层,从而允许网络继续学习更高级别的特征表示

ECA-Net的设计允许网络自适应地学习每个通道的重要性,从而提高了特征的表示能力,同时保持了计算效率。这使得ECA-Net在多个计算机视觉任务中表现出色,成为了一个有力的工具。ECA-Net是一种基于通道注意力的模型,用于增强卷积神经网络的特征建模能力。通过全局平均池化和通道注意力模块的结合,它能够动态地调整不同通道的响应,提高网络在图像处理任务中的性能。

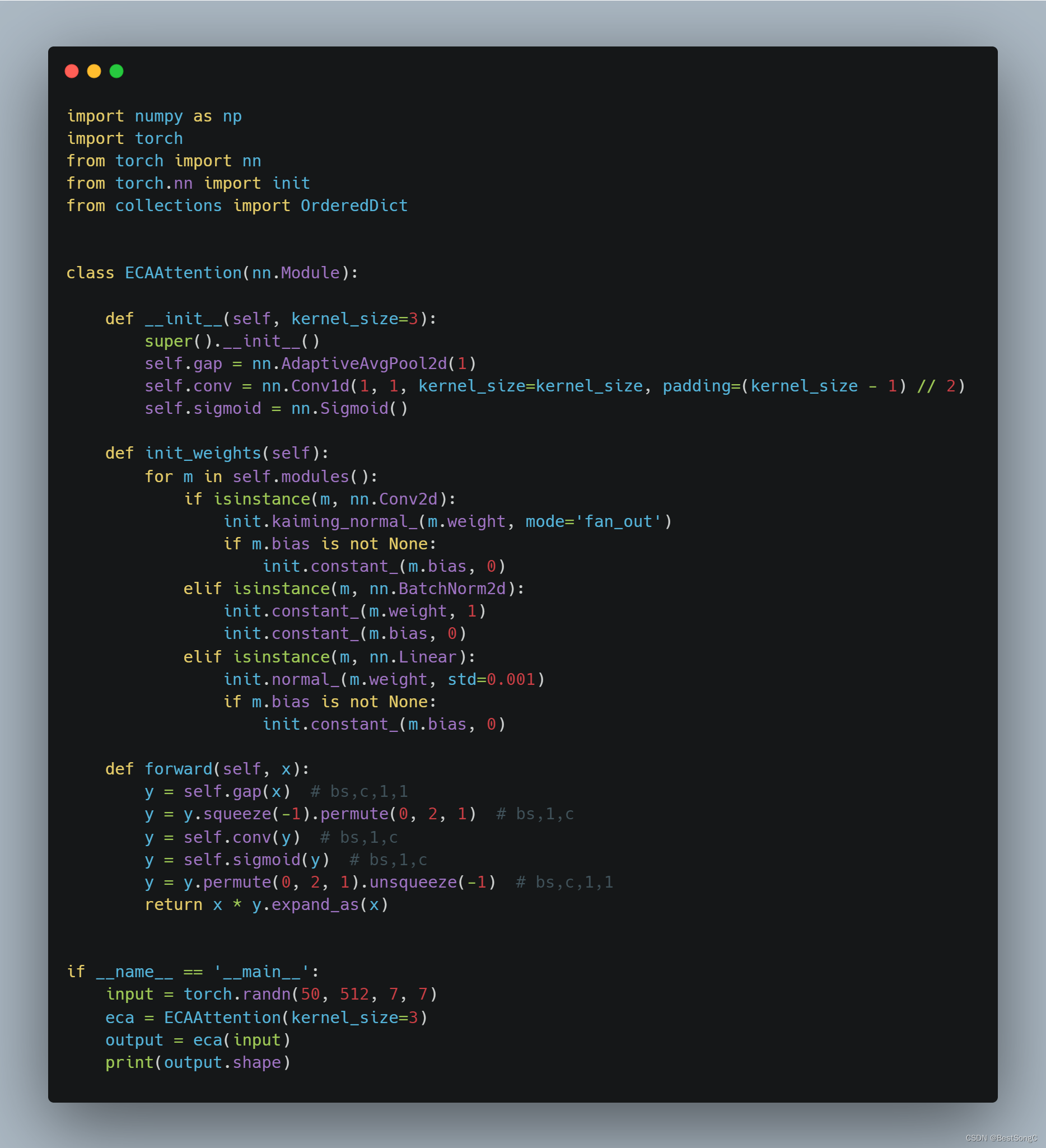

ECA-Attention代码实现

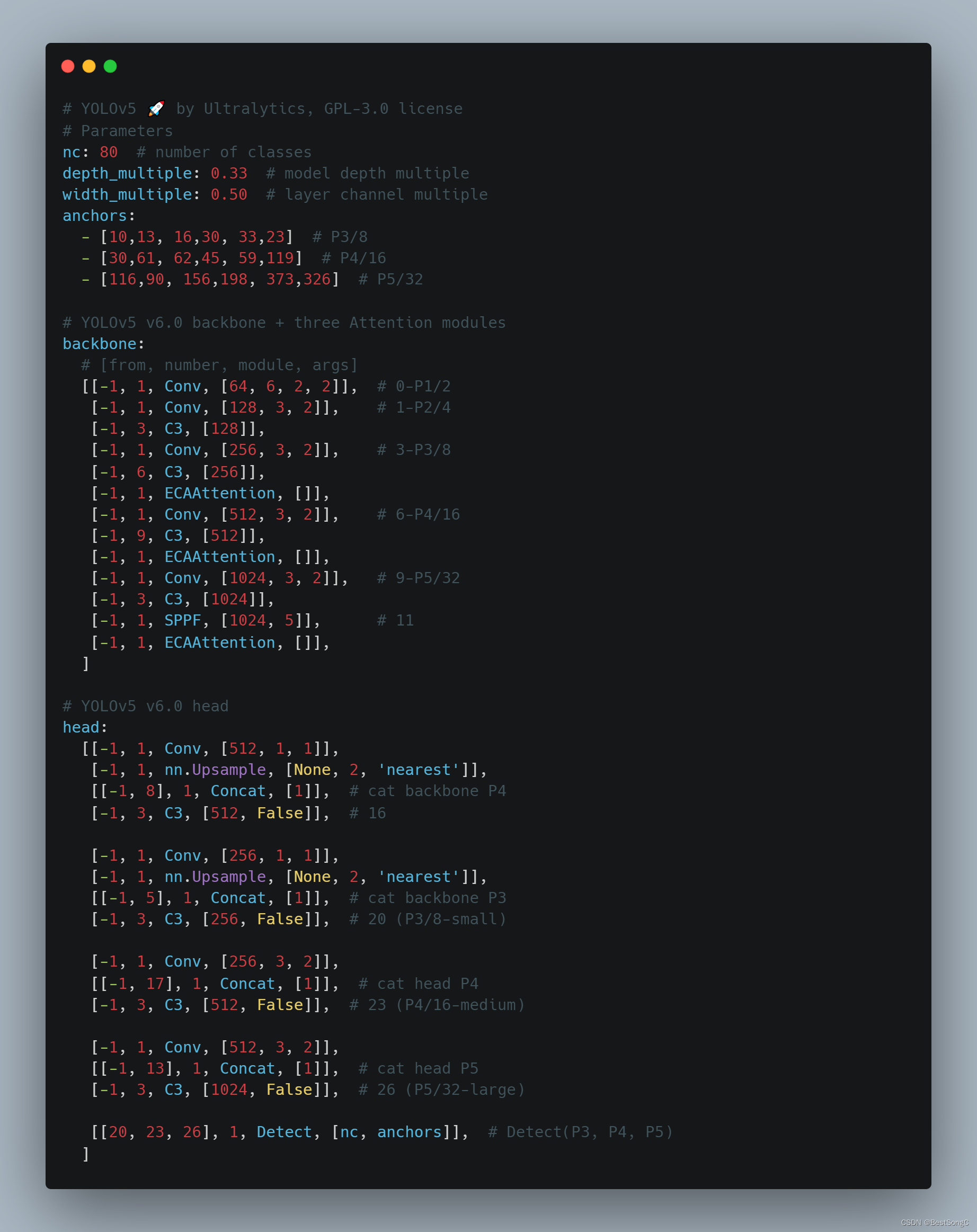

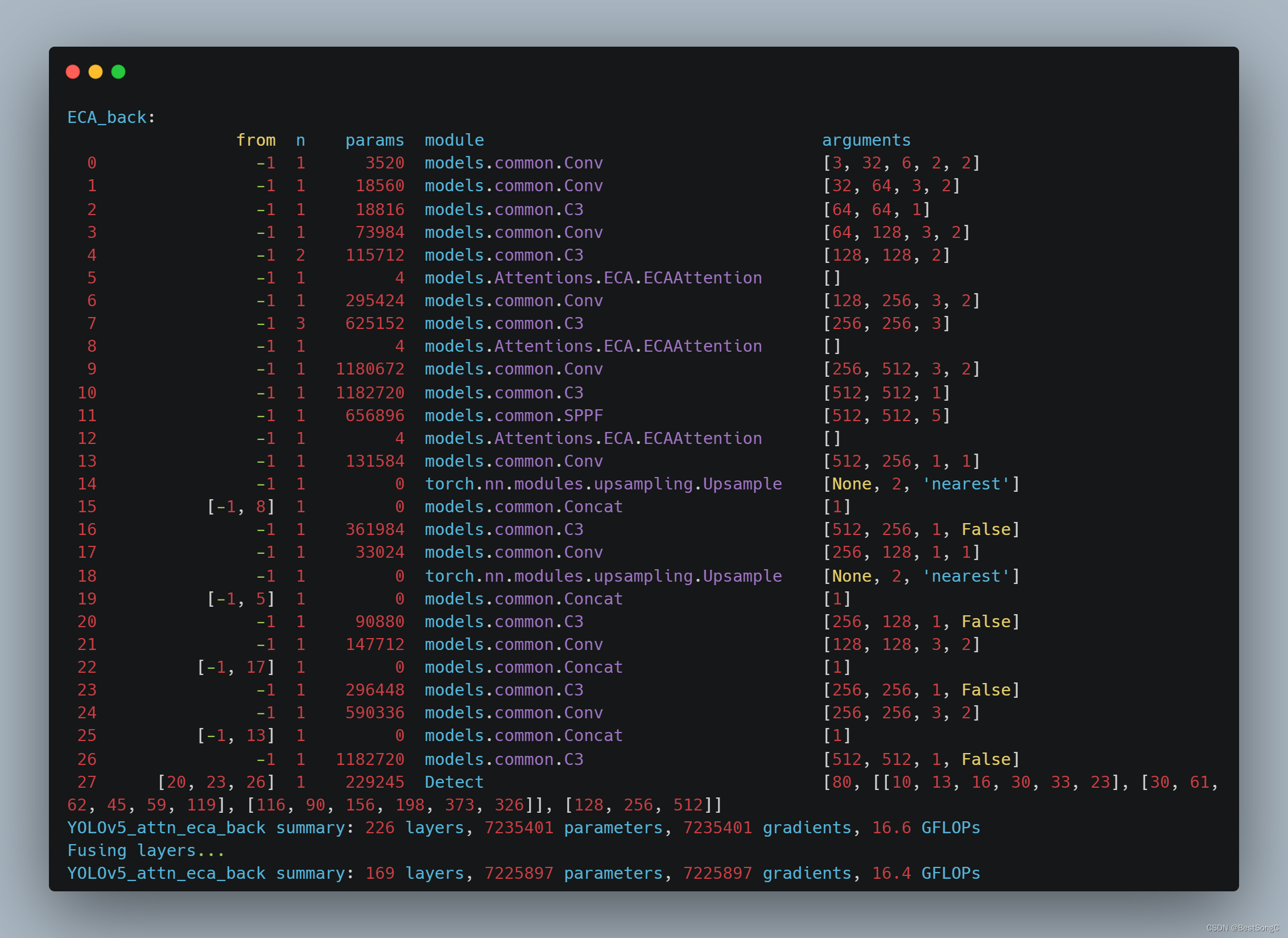

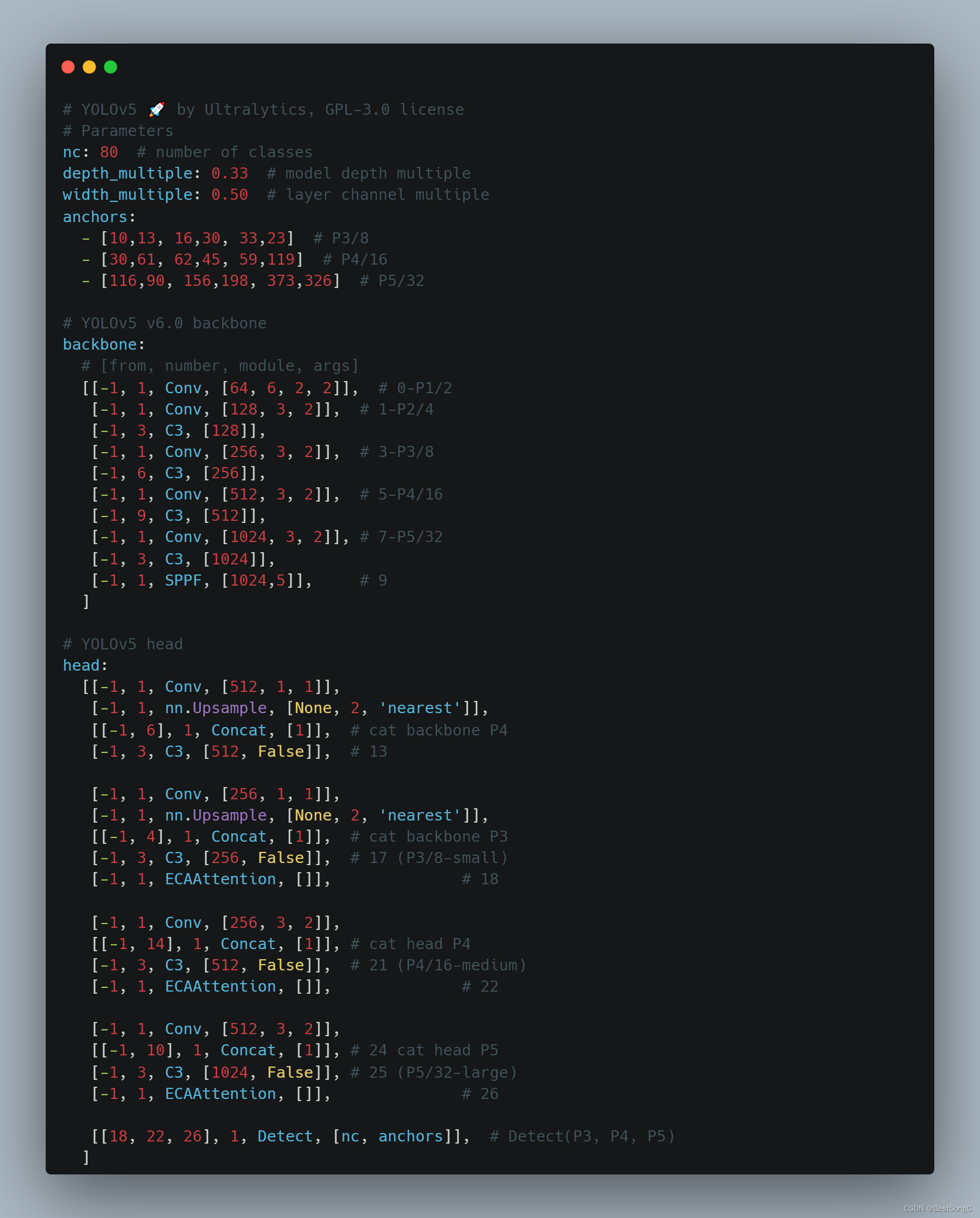

总ECA-Attention + YOLOv5

(1)在YOLOv5的Backbone模块中嵌套ECA-Attention

(2)在YOLOv5的Neck模块中嵌套ECA-Attention

ECANet优势

- 计算效率:ECA-Net相对于一些其他复杂的注意力模型,如SE-Net和CBAM,具有更高的计算效率。它引入通道注意力机制,但只需要较少的参数和计算资源。

- 性能提升:通过增强对不同通道的关注度,ECA-Net能够显著提高卷积神经网络的性能,尤其是在大规模图像分类任务中。

- 通用性:ECA-Net并不仅限于图像分类。它可以用于各种计算机视觉任务,包括目标检测、图像分割、姿态估计等。

- 鲁棒性:ECA-Net的通道注意力机制有助于网络对不同尺度和角度的图像特征保持鲁棒性。

ECANet应用领域

- 图像分类:ECA-Net已经在大规模图像分类任务中取得了卓越的成绩。它有助于提高模型的准确性,使得图像分类更加精确。

- 目标检测:在目标检测任务中,ECA-Net可以用于改善特征提取,从而提高检测性能。它有助于定位和识别目标。

- 图像分割:ECA-Net可以用于改进图像分割任务,使分割结果更加准确,并有助于提高语义分割的性能。

- 姿态估计:在人体姿态估计任务中,ECA-Net可以帮助网络更好地理解不同关节之间的关系,提高姿态估计的准确性。

总结

ECA-Net的注意力模型结构设计提供了一种有效的方式,通过学习通道间的关联性来增强卷积神经网络对图像特征的建模能力。其计算效率和性能提升效果使其在计算机视觉领域受到广泛关注和应用。随着深度学习领域的不断发展,ECA-Net将继续在各种视觉任务中发挥重要作用,为图像处理和分析提供有力支持。欢迎大家关注本博主的微信公众号 BestSongC,后续更多的资源如模型改进、可视化界面等都会在此发布。

-

-

相关阅读:

OpenHarmony应用程序包整体说明

对比不同测量矩阵的重构概率

C语言开发过程中段错误处理方法之经典

Python学习笔记第二十三天(HTML格式的邮件)

如何使用lerna进行多包(package)管理

修改mysql数据的字符集

k8s - pod卷的使用 - pod镜像的升级与回滚 - 探针

了解 Oracle 中的主键和外键

信息学奥赛一本通:1412:二进制分类

前端面试题目(二十八)

- 原文地址:https://blog.csdn.net/sc1434404661/article/details/134320955