-

kubeadm安装k8s集群

一、环境部署

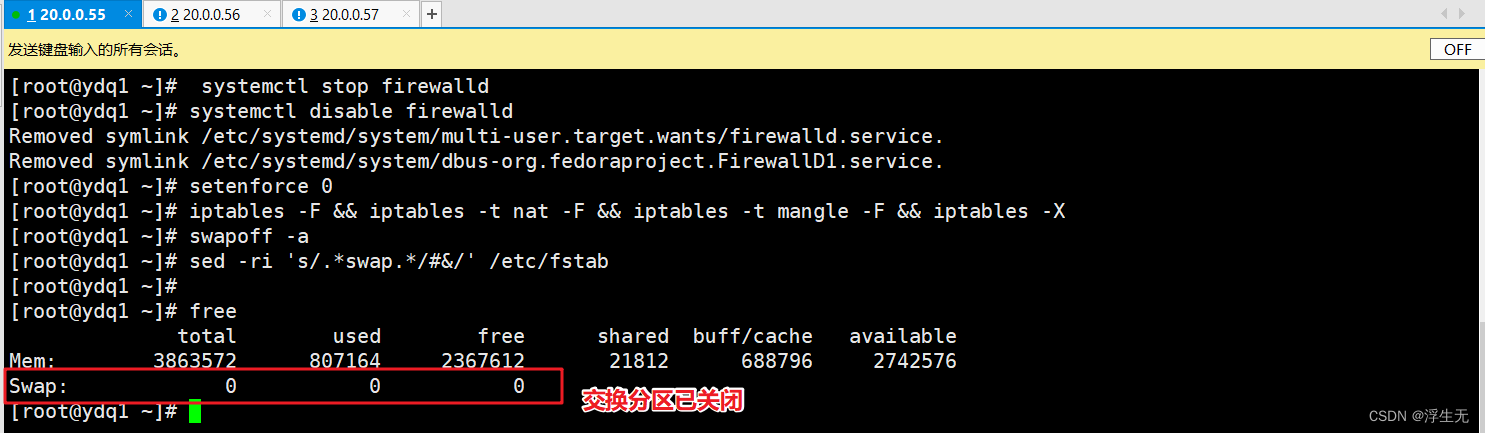

服务器类型 ip地址 master 20.0.0.55 node01 20.0.0.56 node02 20.0.0.57 1、关闭防火墙规则、关闭selinux、关闭swap交换分区

- #所有节点,关闭防火墙规则,关闭selinux,关闭swap交换

- systemctl stop firewalld

- systemctl disable firewalld

- setenforce 0

- iptables -F && iptables -t nat -F && iptables -t mangle -F && iptables -X

- swapoff -a #交换分区必须要关闭

- sed -ri 's/.*swap.*/#&/' /etc/fstab #永久关闭swap分区,&符号在sed命令中代表上次匹配的结果

- for i in $(ls /usr/lib/modules/$(uname -r)/kernel/net/netfilter/ipvs|grep -o "^[^.]*");do echo $i; /sbin/modinfo -F filename $i >/dev/null 2>&1 && /sbin/modprobe $i;done

- #加载ip_vs

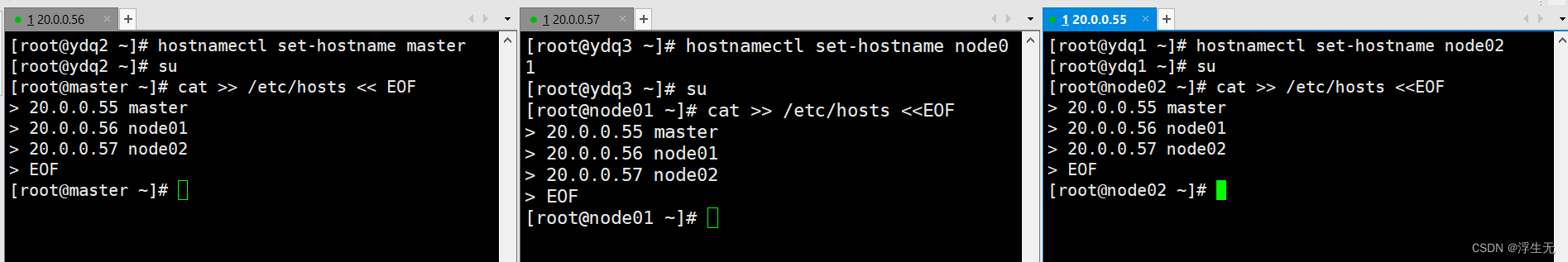

2、修改主机名、DNS解析

- vim /etc/hosts

- 20.0.0.55 master

- 20.0.0.56 node01

- 20.0.0.57 node02

- hostnamectl set-hostname master01

- hostnamectl set-hostname node01

- hostnamectl set-hostname node02

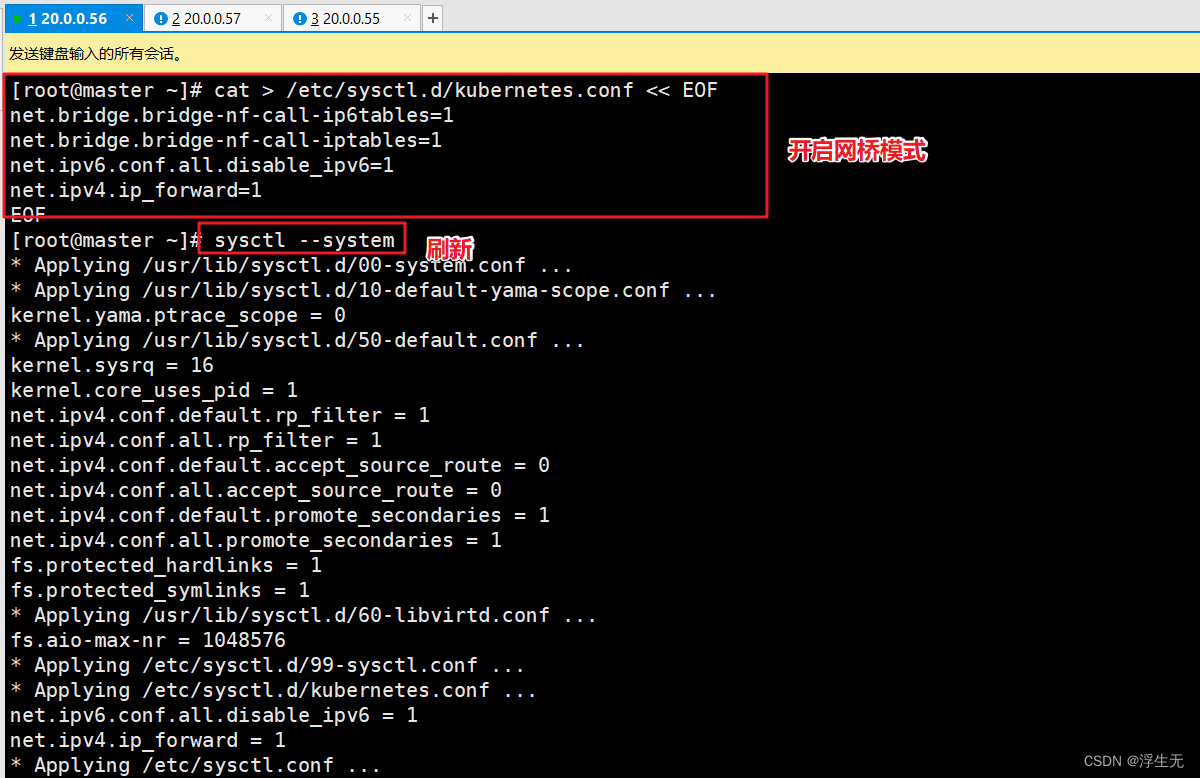

3、调整内核参数

- cat > /etc/sysctl.d/kubernetes.conf << EOF

- #开启网桥模式,可将网桥的流量传递给iptables链

- net.bridge.bridge-nf-call-ip6tables=1

- net.bridge.bridge-nf-call-iptables=1

- #关闭ipv6协议

- net.ipv6.conf.all.disable_ipv6=1

- net.ipv4.ip_forward=1

- EOF

- #加载参数

- sysctl --system

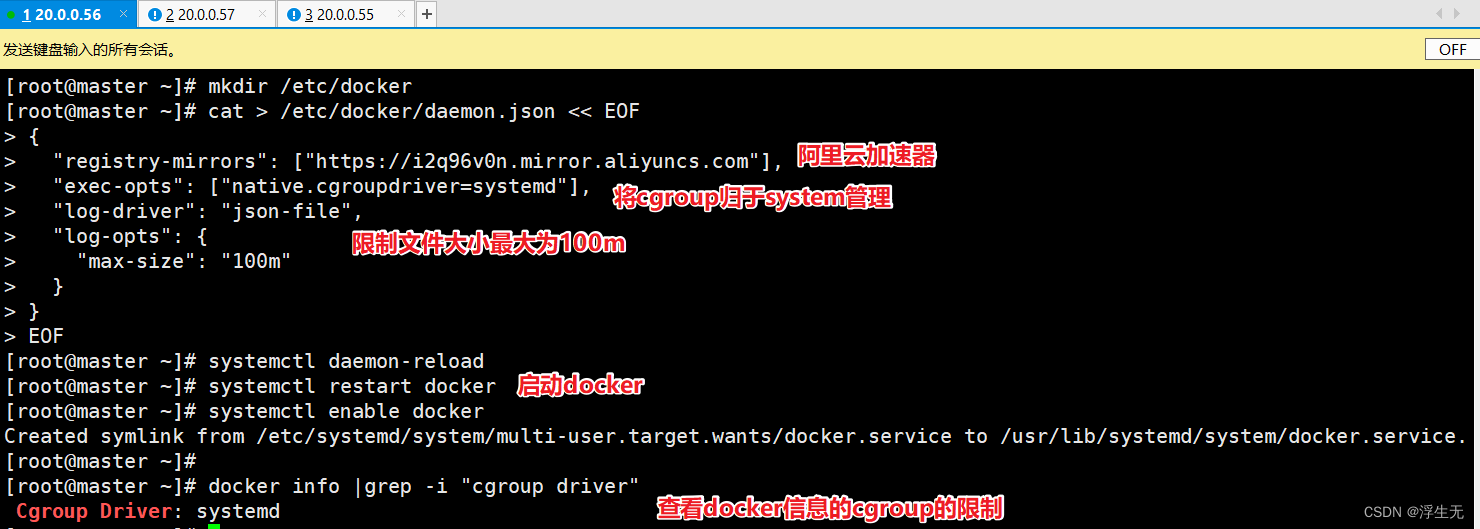

二、所有节点安装Docker

- yum install -y yum-utils device-mapper-persistent-data lvm2

- yum-config-manager --add-repo https://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo

- yum install -y docker-ce docker-ce-cli containerd.io

- mkdir /etc/docker

- cat > /etc/docker/daemon.json <<EOF

- {

- "registry-mirrors": ["https://6ijb8ubo.mirror.aliyuncs.com"],

- "exec-opts": ["native.cgroupdriver=systemd"],

- "log-driver": "json-file",

- "log-opts": {

- "max-size": "100m"

- }

- }

- EOF

- #使用Systemd管理的Cgroup来进行资源控制与管理,因为相对Cgroupfs而言,Systemd限制CPU、内存等资源更加简单和成熟稳定。

- #日志使用json-file格式类型存储,大小为100M,保存在/var/log/containers目录下,方便ELK等日志系统收集和管理日志。

- systemctl daemon-reload

- systemctl restart docker.service

- systemctl enable docker.service

- docker info | grep "Cgroup Driver"

- Cgroup Driver: systemd

三、安装k8s集群

1、所有节点配置K8S源,安装kubeadm、kubelet和kubectl

- -------------------- 所有节点安装kubeadm,kubelet和kubectl --------------------

- //定义kubernetes源

- cat > /etc/yum.repos.d/kubernetes.repo << EOF

- [kubernetes]

- name=Kubernetes

- baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64

- enabled=1

- gpgcheck=0

- repo_gpgcheck=0

- gpgkey=https://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg https://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg

- EOF

- yum install -y kubelet-1.20.11 kubeadm-1.20.11 kubectl-1.20.11

- //开机自启kubelet

- systemctl enable kubelet.service

2、部署K8S集群

master节点操作

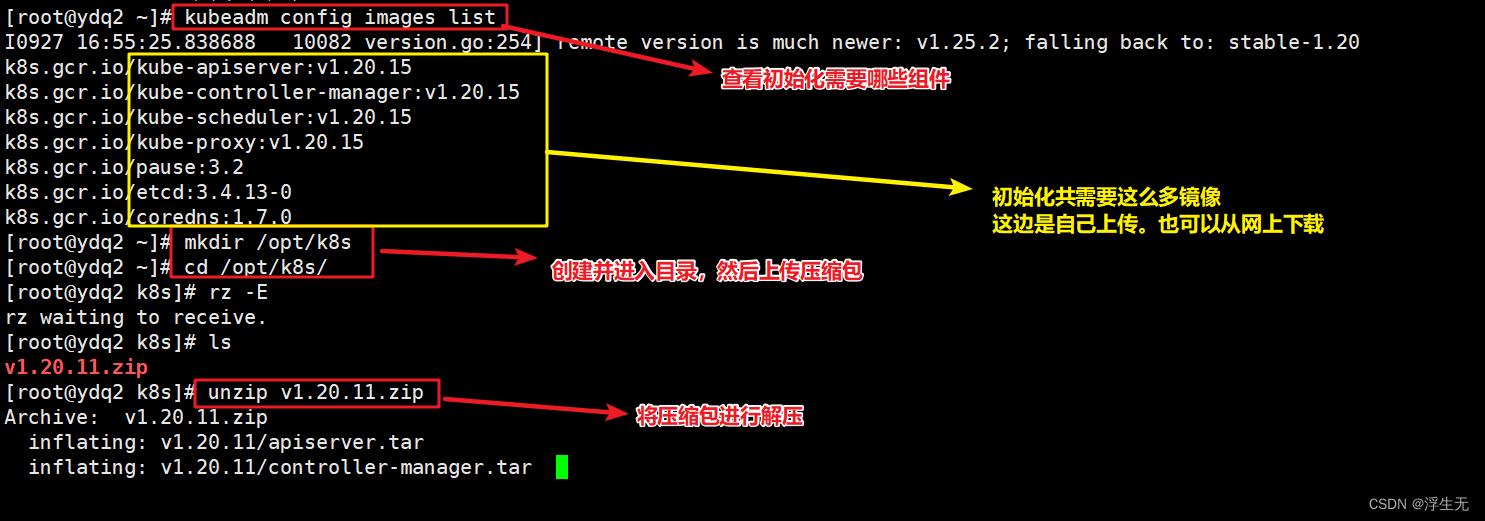

- kubeadm config images list

- #查看初始化需要的镜像

- mkdir /opt/k8s/

- cd /opt/k8s/

- #上传v1.20.11.zip压缩包

- unzip v1.20.11.zip -d /opt/k8s

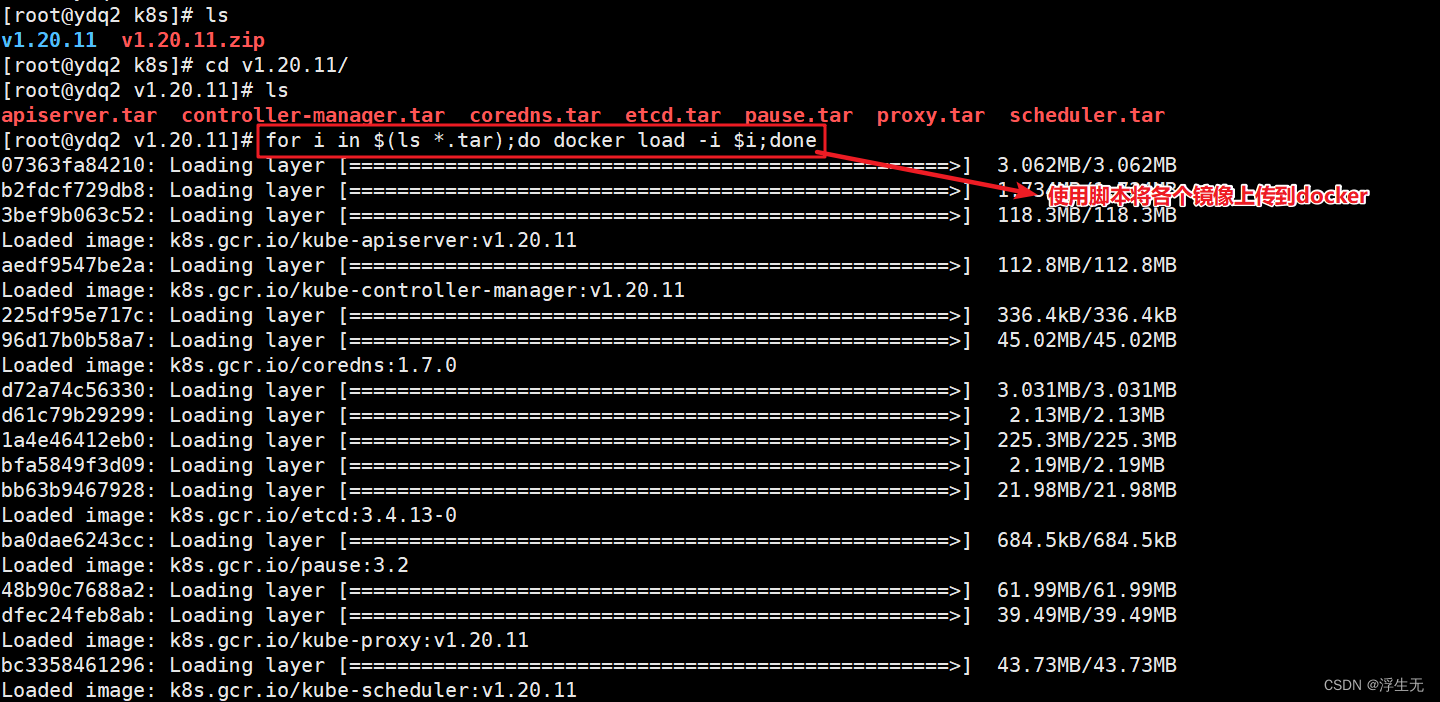

- cd /opt/k8s/v1.20.11

- for i in $(ls *.tar);do docker load -i $i;done

- #使用for循环,将上传的镜像导入到docker中

- scp -r /opt/k8s root@node01:/opt

- scp -r /opt/k8s root@node02:/opt

- #复制镜像和脚本到node节点,并在node节点上执行脚本加载镜像文件。(上面的for循环)

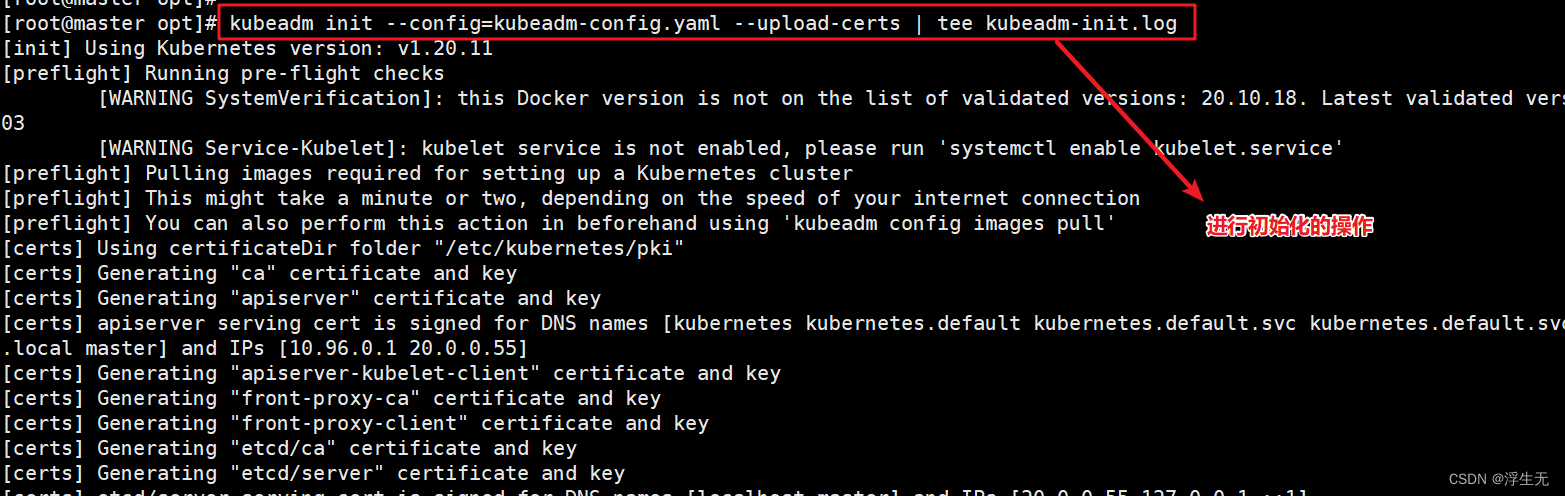

3.1 初始化操作(master节点操作)

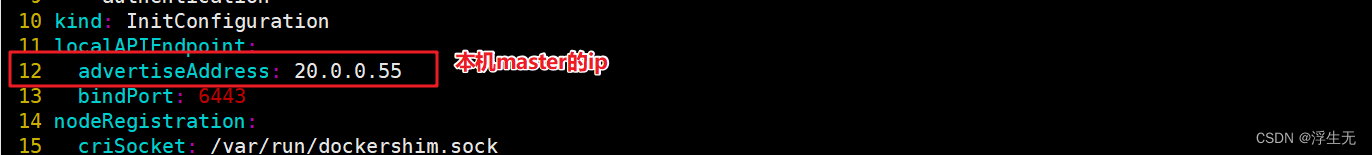

- kubeadm config print init-defaults > /opt/kubeadm-config.yaml

- #打印配置文件重定向到指定文件中

- vim /opt/kubeadm-config.yaml

- 11 localAPIEndpoint:

- 12 advertiseAddress: 20.0.0.55 #指定master节点的IP地址

- 13 bindPort: 6443

- ......

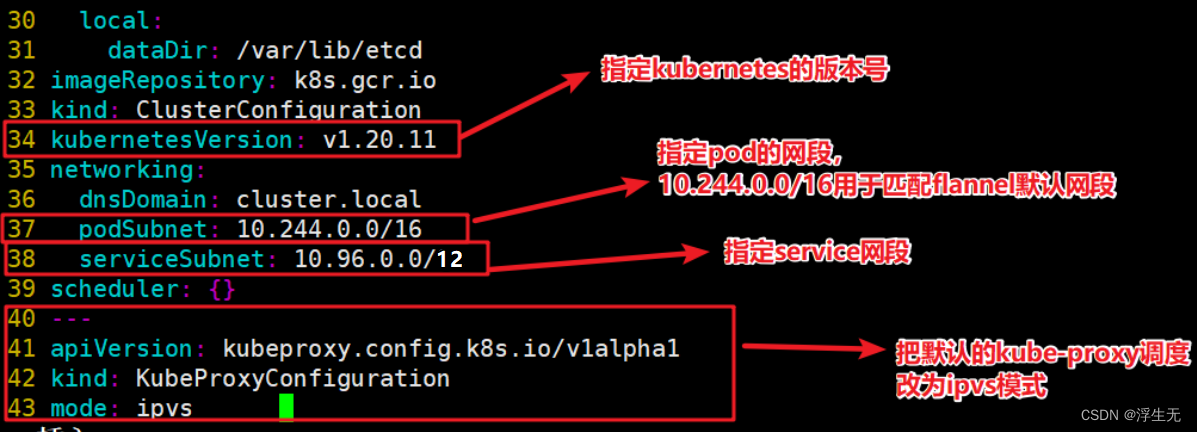

- 34 kubernetesVersion: v1.20.11 #指定kubernetes版本号

- 35 networking:

- 36 dnsDomain: cluster.local

- 37 podSubnet: "10.244.0.0/16" #指定pod网段,10.244.0.0/16用于匹配flannel默认网段

- 38 serviceSubnet: 10.96.0.0/12 #指定service网段

- 39 scheduler: {}

- #末尾再添加以下内容

- ---

- apiVersion: kubeproxy.config.k8s.io/v1alpha1

- kind: KubeProxyConfiguration

- mode: ipvs #把默认的kube-proxy调度方式改为ipvs模式

- =============================================================

- cd /opt

- kubeadm init --config=kubeadm-config.yaml --upload-certs | tee kubeadm-init.log

- #--upload-certs参数可以在后续执行加入节点时自动分发证书文件

- #tee kubeadm-init.log 用以输出日志

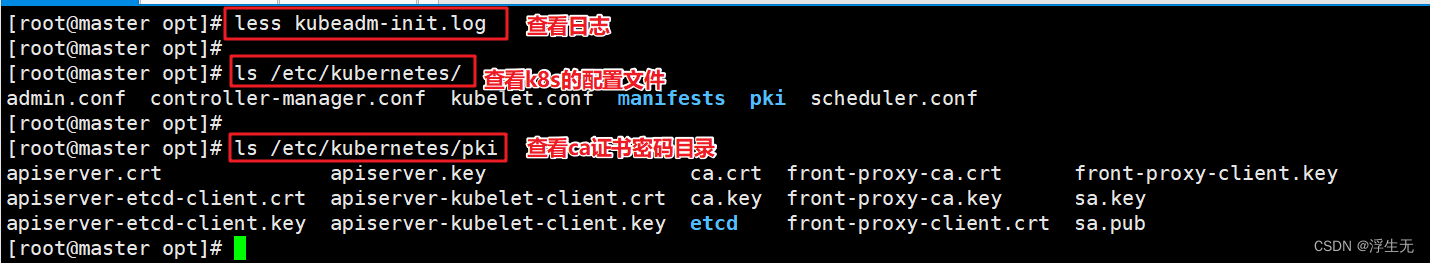

- less kubeadm-init.log

- #查看kubeadm-init.log日志

- ls /etc/kubernetes/

- #查看kubernetes配置文件目录

- ls /etc/kubernetes/pki

- #查看存放ca等证书密码的目录

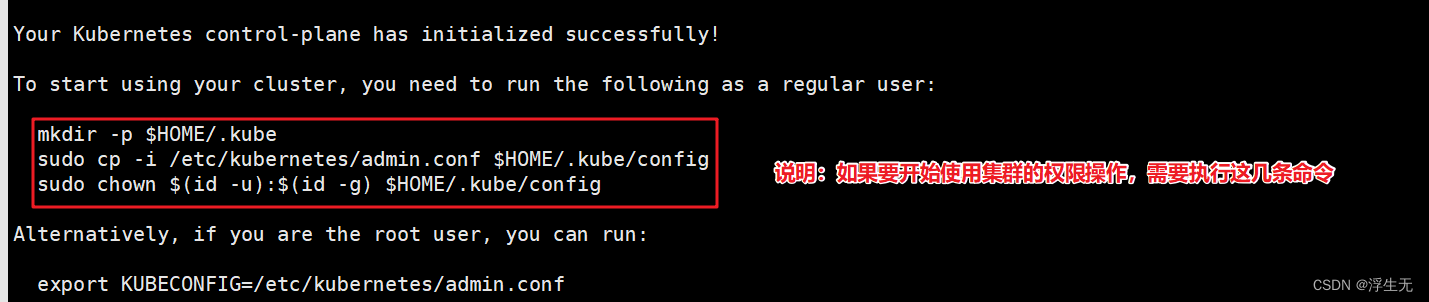

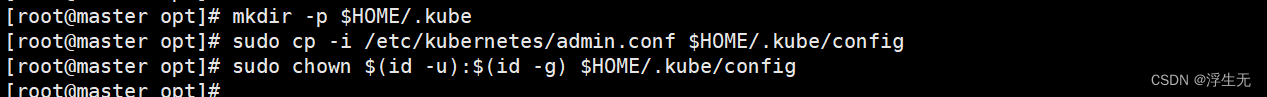

3.2 设置kubectl命令(master节点操作)

kubectl 需经由API server 认证及授权后方能执行相关的管理操作,kubeadm部署的集群为其生成了一个具有管理权限的认证配置文件 :/etc/kubernets/admin.conf ,它可有kubectl通过默认的 “ $HOME/.kube/config” 的路径进行加载。

执行以下命令可以使用kubectl管理工具

- mkdir -p $HOME/.kube

- sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

- sudo chown $(id -u):$(id -g) $HOME/.kube/config

- #授权操作,不然无法使用kubectl命令

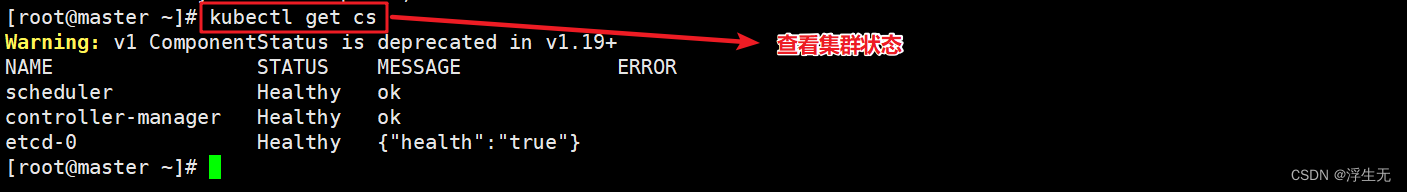

- kubectl get cs

- #查看集群健康状态

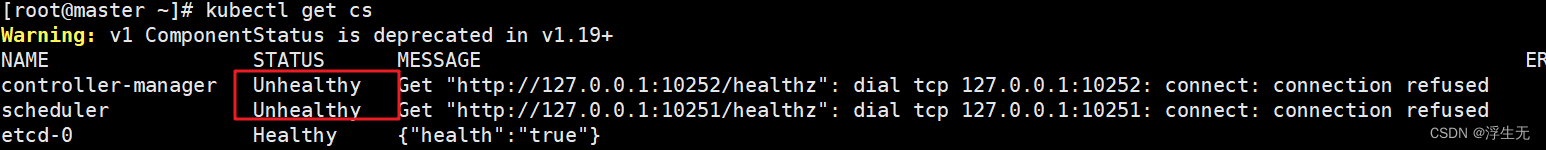

如果 kubectl get cs 发现集群不健康,更改以下两个文件

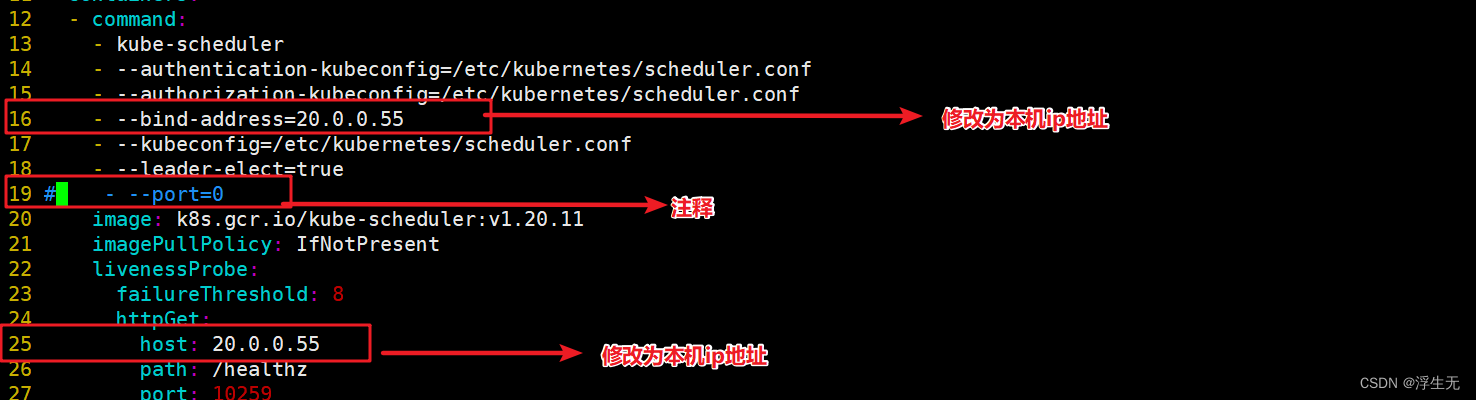

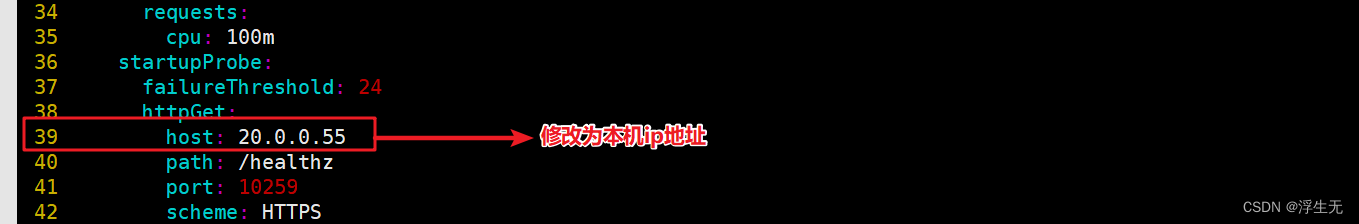

如果 kubectl get cs 发现集群不健康,更改以下两个文件- vim /etc/kubernetes/manifests/kube-scheduler.yaml

- vim /etc/kubernetes/manifests/kube-controller-manager.yaml

- # 修改如下内容

- 把--bind-address=127.0.0.1变成--bind-address=20.0.0.55 #修改成k8s的控制节点master01的ip

- 把httpGet:字段下的hosts由127.0.0.1变成20.0.0.55(有两处)

- #- --port=0 # 搜索port=0,把这一行注释掉

- systemctl restart kubelet

- #重启服务

- kubectl get cs

- #查看集群节点信息

controllers-manager.yaml 文件同上

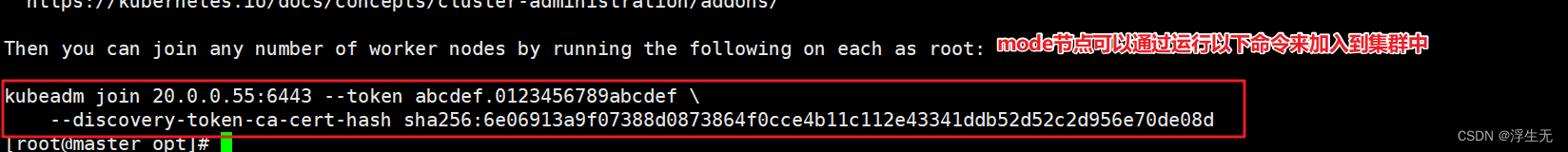

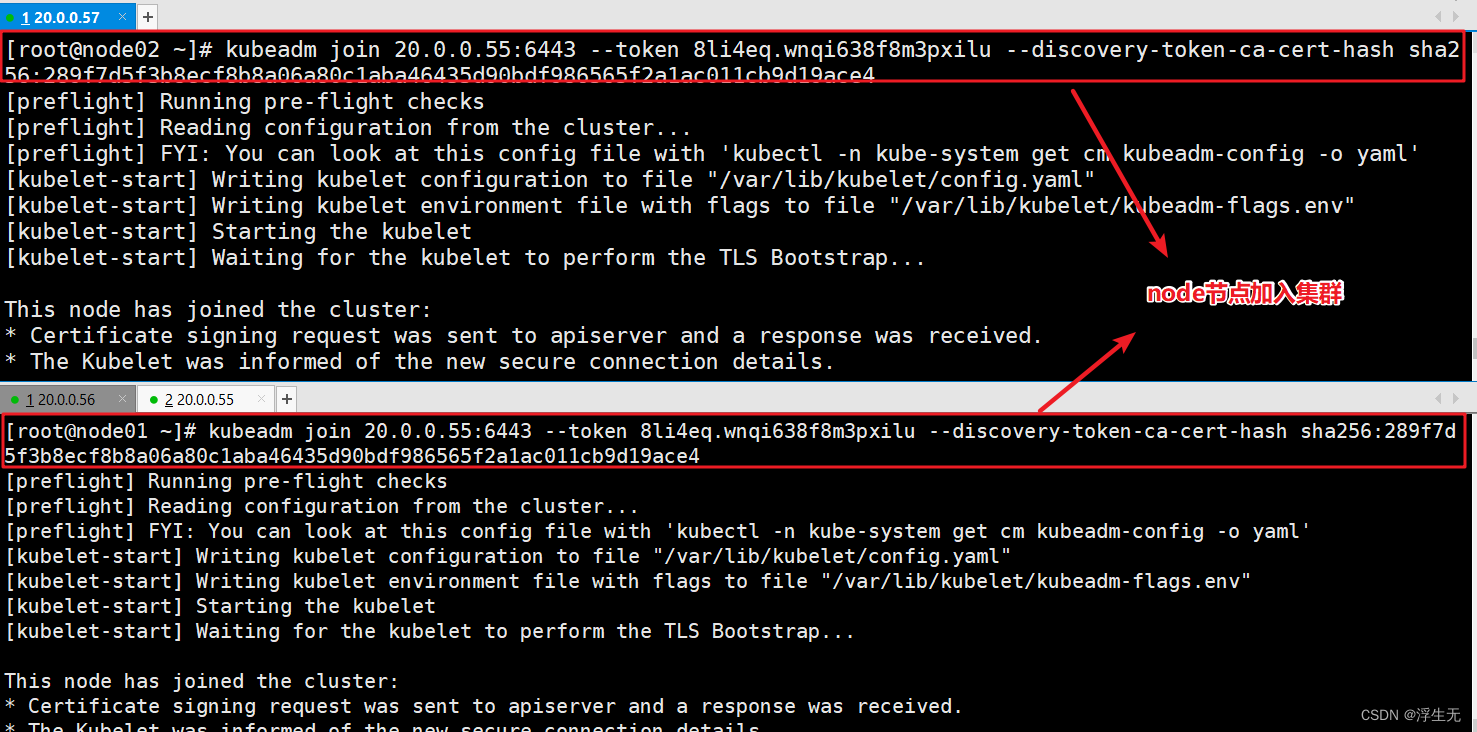

4、node节点加入k8s集群

node01和node02上面都执行

- kubeadm join 20.0.0.55:6443 --token abcdef.0123456789abcdef \

- --discovery-token-ca-cert-hash sha256:6e06913a9f07388d0873864f0cce4b11c112e43341ddb52d52c2d956e70de08d

- #将前面创建好的token令牌,再两台node节点上执行,加入到集群中

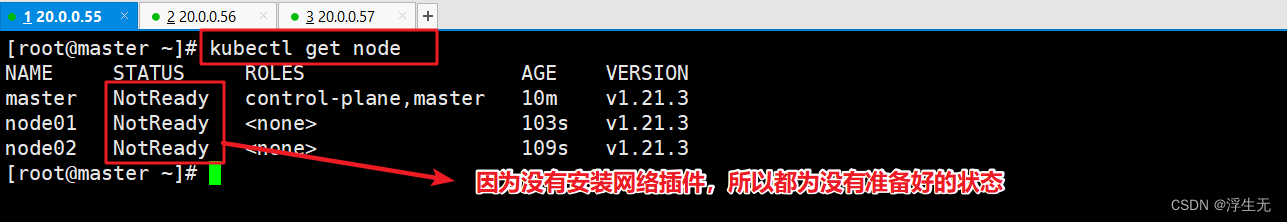

master节点获取k8s集群信息

四、master节点安装部署pod网络插件(flannel)

- //所有节点部署网络插件flannel

- 方法一:

- //所有节点上传flannel镜像 flannel.tar 到 /opt 目录,master节点上传 kube-flannel.yml 文件

- cd /opt

- docker load < flannel.tar

- //在 master 节点创建 flannel 资源

- kubectl apply -f kube-flannel.yml

- 方法二:

- kubectl apply -f https://raw.githubusercontent.com/coreos/flannel/master/Documentation/kube-flannel.yml

- kubectl apply -f https://github.com/flannel-io/flannel/releases/latest/download/kube-flannel.yml

- //在 node 节点上执行 kubeadm join 命令加入群集

- kubeadm join 192.168.10.19:6443 --token rc0kfs.a1sfe3gl4dvopck5 \

- --discovery-token-ca-cert-hash sha256:864fe553c812df2af262b406b707db68b0fd450dc08b34efb73dd5a4771d37a2

- //在master节点查看节点状态

- kubectl get nodes

- kubectl get pods -n kube-system

- NAME READY STATUS RESTARTS AGE

- coredns-bccdc95cf-c9w6l 1/1 Running 0 71m

- coredns-bccdc95cf-nql5j 1/1 Running 0 71m

- etcd-master 1/1 Running 0 71m

- kube-apiserver-master 1/1 Running 0 70m

- kube-controller-manager-master 1/1 Running 0 70m

- kube-flannel-ds-amd64-kfhwf 1/1 Running 0 2m53s

- kube-flannel-ds-amd64-qkdfh 1/1 Running 0 46m

- kube-flannel-ds-amd64-vffxv 1/1 Running 0 2m56s

- kube-proxy-558p8 1/1 Running 0 2m53s

- kube-proxy-nwd7g 1/1 Running 0 2m56s

- kube-proxy-qpz8t 1/1 Running 0 71m

- kube-scheduler-master 1/1 Running 0 70m

-

相关阅读:

int类的前置++和后置++的实现

JavaCV的摄像头实战之八:人脸检测

[附源码]计算机毕业设计JAVAjsp美容院业务管理系统

15经验模态分解及其改进程序,EMD,EEMD, CEEMDAN,三合一程序,已调试完成,替换自己数据可直接跑。

【数据结构】顺序表

【数据结构C/C++】单向链表的增删改查

【无标题】

无往不利,最大利益

【C++ Primer 】第十二章 TextQuery 文本查询程序

带你畅游 Kubernetes 调度器

- 原文地址:https://blog.csdn.net/weixin_42054864/article/details/134080613