-

语言模型编码中/英文句子格式详解

前言

最近一直在学习多模态大模型相关内容,特别是图像CV与语言LLM模型融合方法,如llama-1.5、blip、meta-transformer、glm等大模型。其语言模型的中文和英文句子如何编码成计算机识别符号,使我困惑。我查阅资料,也发现很少有博客全面说明。为此,我以该博客记录其整过过程,并附有对应代码供读者参考。

处理语言模型需要将英文或中文等字符表示成模型能识别的符号,为此不同模型会按照某些方法表示,但不同模型转计算机能识别思路是一致的。

一、Bert的vocab.txt内容查看

来源tokenization.py文件内容。

PRETRAINED_VOCAB_ARCHIVE_MAP = { 'bert-base-uncased': "https://s3.amazonaws.com/models.huggingface.co/bert/bert-base-uncased-vocab.txt", 'bert-large-uncased': "https://s3.amazonaws.com/models.huggingface.co/bert/bert-large-uncased-vocab.txt", 'bert-base-cased': "https://s3.amazonaws.com/models.huggingface.co/bert/bert-base-cased-vocab.txt", 'bert-large-cased': "https://s3.amazonaws.com/models.huggingface.co/bert/bert-large-cased-vocab.txt", 'bert-base-multilingual-uncased': "https://s3.amazonaws.com/models.huggingface.co/bert/bert-base-multilingual-uncased-vocab.txt", 'bert-base-multilingual-cased': "https://s3.amazonaws.com/models.huggingface.co/bert/bert-base-multilingual-cased-vocab.txt", 'bert-base-chinese': "https://s3.amazonaws.com/models.huggingface.co/bert/bert-base-chinese-vocab.txt", }- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

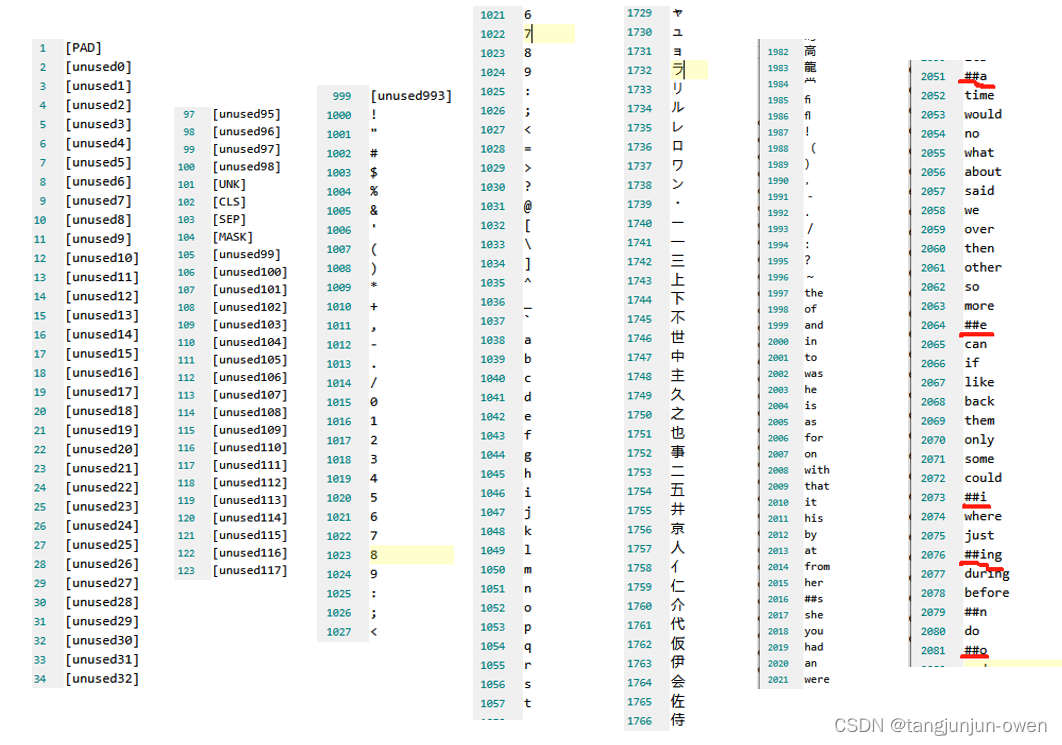

vocab.txt内容:

上图是我截取vocab.txt的内容,基本很多有的符号/数字/运算符/中文/字母/单词等均在该txt文件夹中。二、BERT模型转换方法(vocab.txt)

加入有2句话,分别为text01与text02(如下),他们会转换vocab.txt中已有的单词形式。其中需要留意:

’##符号连接长单词在vocab.txt部件方式,如embeddings表示为['em','##bed','##ding','s']。同时,vocab.txt不存在单词部件会化成最小组件,单个字母(vocab.txt最小部件是字母)。

代码如下:from pytorch_pretrained_bert import BertTokenizer tokenizer = BertTokenizer.from_pretrained('../voccab.txt') text01 = "Here is the sentence I want embeddings for." text02 = "wish for world peace." marked_text = "[CLS] " + text01 + " [SEP] " + text02 + " [SEP]" print('marked_text = ', marked_text) tokenized_text- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

-

相关阅读:

spring cloud tencent:基于polaris手把手搭建微服务框架(附带源码)(二)

vscode离线安装ssh插件(本机和服务器都离线)

MySQL 8.0 架构 之 通用查询日志(General Query Log)

WPF优秀组件推荐之FreeSpire

Mybatis学习笔记2

[附源码]JAVA毕业设计考研信息共享平台的设计与实现(系统+LW)

R语言使用plot函数可视化数据散点图,使用font.axis参数指定坐标轴标签的字体类型为粗体斜体字体(bold italic)

入门力扣自学笔记193 C++ (题目编号:1668)

maven环境变量,安装源,本地仓库配置

中国人民大学与加拿大女王大学金融硕士——人生下半场,用实力为自己“撑腰”

- 原文地址:https://blog.csdn.net/weixin_38252409/article/details/133789735