-

手部关键点检测1:手部关键点(手部姿势估计)数据集(含下载链接)

手部关键点检测1:手部关键点(手部姿势估计)数据集(含下载链接)

目录

手部关键点检测1:手部关键点(手部姿势估计)数据集(含下载链接)

5. 手部关键点检测(Python/C++/Android)

1. 前言

项目《手部关键点检测(手部姿势估计)》使用YOLOv5模型实现手部检测,使用HRNet,LiteHRNet和Mobilenet-v2模型实现手部关键点检测。本篇是项目《手部关键点检测(手部姿势估计)》系列文章数据集说明。项目收集了三个手部检测数据集和三个手部关键点数据集:

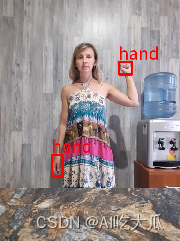

- 手部检测数据集(Hand Detection Dataset)共收集了三个:Hand-voc1,Hand-voc2和Hand-voc3,总共60000+张图片;标注格式统一转换为VOC数据格式,标注名称为hand,可用于深度学习手部目标检测模型算法开发

- 手部关键点数据集(Hand Keypoints Dataset,Hand Pose Estimation共收集了三个:分别为HandPose-v1,HandPose-v2和HandPose-v3,总共80000+张图片,标注了手部21个关键点,可用于深度学习手部姿态检测模型算法开发。

【尊重原则,转载请注明出处】 https://blog.csdn.net/guyuealian/article/details/133277630

Android手部关键点检测(手部姿势估计)APP Demo体验:https://download.csdn.net/download/guyuealian/88418582

更多项目《手部关键点检测(手部姿势估计)》系列文章请参考:

- 手部关键点检测1:手部关键点(手部姿势估计)数据集(含下载链接)https://blog.csdn.net/guyuealian/article/details/133277630

- 手部关键点检测2:YOLOv5实现手部检测(含训练代码和数据集)https://blog.csdn.net/guyuealian/article/details/133279222

- 手部关键点检测3:Pytorch实现手部关键点检测(手部姿势估计)含训练代码和数据集https://blog.csdn.net/guyuealian/article/details/133277726

- 手部关键点检测4:Android实现手部关键点检测(手部姿势估计)含源码 可实时检测https://blog.csdn.net/guyuealian/article/details/133931698

- 手部关键点检测5:C++实现手部关键点检测(手部姿势估计)含源码 可实时检测https://blog.csdn.net/guyuealian/article/details/133277748

2. 手部检测数据集:

项目已经收集了三个手部检测数据集(Hand Detection Dataset):Hand-voc1,Hand-voc2和Hand-voc3,总共60000+张图片

(1)Hand-voc1

Hand-voc1手部检测数据集,该数据来源于国外开源数据集,大部分数据是室内摄像头摆拍的手部数据,不包含人体部分,每张图只含有一只手,分为两个子集:训练集(Train)和测试集(Test);其中训练集(Train)总数超过30000张图片,测试集(Test)总数2560张;图片已经使用labelme标注了手部区域目标框box,标注名称为hand,标注格式统一转换为VOC数据格式,可直接用于深度学习目标检测模型训练。

(2)Hand-voc2

Hand-voc2手部检测数据集,该数据来源于国内开源数据集,包含人体部分和多人的情况,每张图含有一只或者多只手,比较符合家庭书桌读写场景的业务数据集,数据集目前只收集了980张图片;图片已经使用labelme标注了手部区域目标框box,标注名称为hand,标注格式统一转换为VOC数据格式,可直接用于深度学习目标检测模型训练。

(3)Hand-voc3Hand-voc3手部检测数据集来源于国外HaGRID手势识别数据集;原始HaGRID数据集十分庞大,约有55万张图片,包含了18种常见的通用手势;Hand-voc3数据集是从HaGRID数据集中,每种手势随机抽取2000张图片,总共包含18x2000=36000张图片数据;标注格式统一转换为VOC数据格式,标注名称为hand,可直接用于深度学习目标检测模型训练。

关于HaGRID数据集请参考文章:HaGRID手势识别数据集使用说明和下载

(4)手部目标框可视化效果

需要pip安装pybaseutils工具包,然后使用parser_voc显示手部目标框的绘图效果

pip install pybaseutils

- import os

- from pybaseutils.dataloader import parser_voc

- if __name__ == "__main__":

- # 修改为自己数据集的路径

- filename = "/path/to/dataset/Hand-voc3/train.txt"

- class_name = ['hand']

- dataset = parser_voc.VOCDataset(filename=filename,

- data_root=None,

- anno_dir=None,

- image_dir=None,

- class_name=class_name,

- transform=None,

- use_rgb=False,

- check=False,

- shuffle=False)

- print("have num:{}".format(len(dataset)))

- class_name = dataset.class_name

- for i in range(len(dataset)):

- data = dataset.__getitem__(i)

- image, targets, image_id = data["image"], data["target"], data["image_id"]

- print(image_id)

- bboxes, labels = targets[:, 0:4], targets[:, 4:5]

- parser_voc.show_target_image(image, bboxes, labels, normal=False, transpose=False,

- class_name=class_name, use_rgb=False, thickness=3, fontScale=1.2)

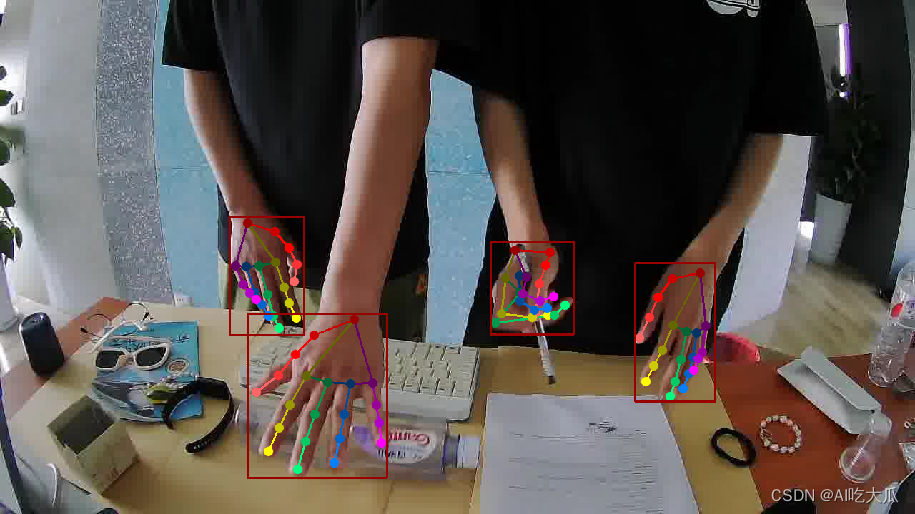

3. 手部关键点数据集

项目已经收集了三个手部关键点(手部姿势估计 Hand Pose)数据集,分别为HandPose-v1,HandPose-v2和HandPose-v3,总共80000+张图片; 这三个数据都标注了手部21个关键点,下图是手部关键点示意图:

(1)HandPose-v1

HandPose-v1手部关键点数据集,是在Hand-voc1手部检测的数据集上,标注了手部21个关键点,制作的手部关键点数据集,不包含人体部分,每张图只含有一只手,分为两个子集:训练集(Train)和测试集(Test);其中训练集(Train)总数超过30000张图片,测试集(Test)总数2560张;图片已经标注了手部区域目标框box,标注名称为hand,同时也标注了手部21个关键点,标注格式统一转换为COCO数据格式,可直接用于深度学习手部关键点检测模型训练。

(2)HandPose-v2

HandPose-v2手部关键点数据集,是在Hand-voc2手部检测的数据集上,标注了手部21个关键点,制作的手部关键点数据集;包含人体部分和多人的情况,每张图含有一只或者多只手,比较符合家庭书桌读写场景的业务数据集,数据集目前只收集了980张图片;图片已经标注了手部区域目标框box,标注名称为hand,同时也标注了手部21个关键点,标注格式统一转换为COCO数据格式,可直接用于深度学习手部关键点检测模型训练。

(3)HandPose-v3

HandPose-v3手部关键点数据集,原始图片主要来源于网上收集的手部图片数据集,数据比较杂,每张图只截取保留了手部的区域图像,总共49000张图片;图片已经标注了手部区域目标框box,标注名称为hand,同时也标注了手部21个关键点,标注格式统一转换为COCO数据格式,可直接用于深度学习手部关键点检测模型训练。

(4)手部关键点可视化效果

需要pip安装pybaseutils工具包,然后使用parser_coco_kps显示手部关键点的绘图效果

pip install pybaseutils

- import os

- from pybaseutils.dataloader import parser_coco_kps

- if __name__ == "__main__":

- # 修改为自己数据集json文件路径

- anno_file = "/path/to/dataset/HandPose-v3/train/train_anno.json"

- class_name = []

- dataset = parser_coco_kps.CocoKeypoints(anno_file, image_dir="", class_name=class_name,shuffle=False)

- bones = dataset.bones

- for i in range(len(dataset)):

- data = dataset.__getitem__(i)

- image, boxes, labels, keypoints = data['image'], data["boxes"], data["label"], data["keypoints"]

- print("i={},image_id={}".format(i, data["image_id"]))

- parser_coco_kps.show_target_image(image, keypoints, boxes, colors=bones["colors"],

- skeleton=bones["skeleton"],thickness=1)

4. 手部检测和手部关键点数据集下载

手部检测和手部关键点数据集下载地址:手部关键点检测1:手部关键点(手部姿势估计)数据集(含下载链接)

手部检测和手部关键点数据集包含内容:

-

手部检测数据集:包含Hand-voc1,Hand-voc2和Hand-voc3,总共60000+张图片;标注格式统一转换为VOC数据格式,标注名称为hand,可用于深度学习手部目标检测模型算法开发。

-

手部关键点数据集:包含HandPose-v1,HandPose-v2和HandPose-v3,总共80000+张图片;标注了手部区域目标框box,标注名称为hand,同时也标注了手部21个关键点,标注格式统一转换为COCO数据格式,可直接用于深度学习手部关键点检测模型训练。

5. 手部关键点检测(Python/C++/Android)

本项目基于Pytorch深度学习框架,实现手部关键点检测(手部姿势估计)模型,其中手部检测采用YOLOv5模型,手部关键点检测是基于开源的HRNet进行改进,构建了整套手部关键点检测的训练和测试流程;为了方便后续模型工程化和Android平台部署,项目支持轻量化模型LiteHRNet和Mobilenet模型训练和测试,并提供Python/C++/Android多个版本

- 手部关键点检测3:Pytorch实现手部关键点检测(手部姿势估计)含训练代码和数据集https://blog.csdn.net/guyuealian/article/details/133277726

- 手部关键点检测4:Android实现手部关键点检测(手部姿势估计)含源码 可实时检测https://blog.csdn.net/guyuealian/article/details/133277732

- 手部关键点检测5:C++实现手部关键点检测(手部姿势估计)含源码 可实时检测https://blog.csdn.net/guyuealian/article/details/133277748

Android手部关键点检测(手部姿势估计)APP Demo体验:https://download.csdn.net/download/guyuealian/88418582

-

相关阅读:

如何在3dMax中使用Python按类型选择对象?

Git分布式版本控制系统与github

蓝桥杯(3.5)

2024年【上海市安全员C3证】新版试题及上海市安全员C3证复审考试

如何本地部署开源AI知识库 FastGPT(新手教程)

这或许是全网最全时间序列特征工程构造的文章了

SPRINGBOOT03_自动配置原理入门、Lombok、dev-tools、快速初始化boot项目

postman如何做接口关联

Qt---文件系统

win11无法加载文件,因为在此系统上禁止运行脚本

- 原文地址:https://blog.csdn.net/guyuealian/article/details/133277630