-

机器学习-线性回归的各种操作代码

- import numpy as np

- import matplotlib.pyplot as plt

- import pandas as pd

- path = r"Salary_Data_Based_country_and_race.csv"#原始字符串

- df = pd.read_csv(path)#原始数据源,csv分隔符用逗号分

- df.dropna(axis=0, how='any', inplace=True) #数据有空的数据,无返回值(有问题的原因1有空数据,2学习率太大了)

- pd_data=df.drop(["Unnamed: 0","Gender","Education Level","Job Title","Country","Race"],axis=1)#以前直接drop列名

- pd_data

- import numpy as np

- orig_data=pd_data.values #得到数据的矩阵形式

- cols = orig_data.shape[1]#列,也就是特征数

- print(cols)

- xx=orig_data[:,:cols-1]#打印特征列,x,y分开,行得要,取到标签之前,索引从0开始,取,0,1,

- y=orig_data[:,cols-1:]#打印标签列

- yy = y.reshape((-1,1))#多少行都行,变为列向量

- print("xx",xx)

- print("yy",yy)#标签和特征值拆分

- #这里的y是个二维数组,千万注意

- #拆分数据集直接调用就行了,不是核心技术

- from sklearn.model_selection import train_test_split

- xx_train, xx_test, yy_train, yy_test = train_test_split(xx, yy, test_size=0.40, random_state=42)

- print("X_train=", xx_train)

- print("X_test=", xx_test)

- print("y_train=", yy_train)

- print("y_test=", yy_test)

- # 导入sklearn diabetes数据接口

- #加载数据集

- from sklearn.datasets import load_iris

- # 导入sklearn打乱数据函数

- from sklearn.utils import shuffle

- # 获取diabetes数据集

- iris = load_iris()

- # 获取输入和标签

- data, target = iris.data, iris.target#直接取

- # 打乱数据集

- X, y = shuffle(data, target, random_state=13)

- # 按照8/2划分训练集和测试集

- offset = int(X.shape[0] * 0.8)

- # 训练集

- X_train, y_train = X[:offset], y[:offset]

- # 测试集

- X_test, y_test = X[offset:], y[offset:]

- # 将训练集改为列向量的形式

- y_train = y_train.reshape((-1,1))#进行这个操作变成列向量,行向量就麻烦了

- # 将验证集改为列向量的形式

- y_test = y_test.reshape((-1,1))

- # 打印训练集和测试集维度

- print(y_train)

- print("X_train's shape: ", X_train.shape)

- print("X_test's shape: ", X_test.shape)

- print("y_train's shape: ", y_train.shape)

- print("y_test's shape: ", y_test.shape)

- ### 初始化模型参数

- def initialize_params(dims):

- '''

- 输入:

- dims:训练数据变量维度

- 输出:

- w:初始化权重参数值

- b:初始化偏差参数值

- '''

- # 初始化权重参数为零矩阵

- w = np.zeros((dims, 1))

- # 初始化偏差参数为零

- b = 1000

- return w, b

- ### 定义模型主体部分

- ### 包括线性回归公式、均方损失和参数偏导三部分

- def linear_loss(X, y, w, b):

- '''

- 输入:

- X:输入变量矩阵

- y:输出标签向量

- w:变量参数权重矩阵

- b:偏差项

- 输出:

- y_hat:线性模型预测输出

- loss:均方损失值

- dw:权重参数一阶偏导

- db:偏差项一阶偏导

- '''

- # 训练样本数量

- num_train = X.shape[0]

- # 训练特征数量

- num_feature = X.shape[1]

- # 线性回归预测输出

- y_hat = np.dot(X, w) + b

- # 计算预测输出与实际标签之间的均方损失

- loss = np.sum((y_hat-y)**2)/num_train

- # 基于均方损失对权重参数的一阶偏导数

- dw = np.dot(X.T, (y_hat-y)) /num_train

- # 基于均方损失对偏差项的一阶偏导数

- db = np.sum((y_hat-y)) /num_train

- return y_hat, loss, dw, db

- ### 定义线性回归模型训练过程

- def linear_train(X, y, learning_rate=0.01, epochs=10000):

- '''

- 输入:

- X:输入变量矩阵

- y:输出标签向量

- learning_rate:学习率

- epochs:训练迭代次数

- 输出:

- loss_his:每次迭代的均方损失

- params:优化后的参数字典

- grads:优化后的参数梯度字典

- '''

- # 记录训练损失的空列表

- loss_his = []

- # 初始化模型参数

- w, b = initialize_params(X.shape[1])

- # 迭代训练

- for i in range(1, epochs):

- # 计算当前迭代的预测值、损失和梯度

- y_hat, loss, dw, db = linear_loss(X, y, w, b)

- # 基于梯度下降的参数更新

- w += -learning_rate * dw

- b += -learning_rate * db

- # 记录当前迭代的损失

- loss_his.append(loss)

- # 每1000次迭代打印当前损失信息

- if i % 10000 == 0:

- print('epoch %d loss %f' % (i, loss))

- # 将当前迭代步优化后的参数保存到字典

- params = {

- 'w': w,

- 'b': b

- }

- # 将当前迭代步的梯度保存到字典

- grads = {

- 'dw': dw,

- 'db': db

- }

- return loss_his, params, grads

- # 线性回归模型训练

- loss_his, params, grads = linear_train(xx_train, yy_train, 0.0001, 200000)

- # 打印训练后得到模型参数

- print(params)

- ### 定义线性回归预测函数

- def predict(X, params):

- '''

- 输入:

- X:测试数据集

- params:模型训练参数

- 输出:

- y_pred:模型预测结果

- '''

- # 获取模型参数

- w = params['w']

- b = params['b']

- # 预测

- y_pred = np.dot(X, w) + b

- return y_pred

- # 基于测试集的预测

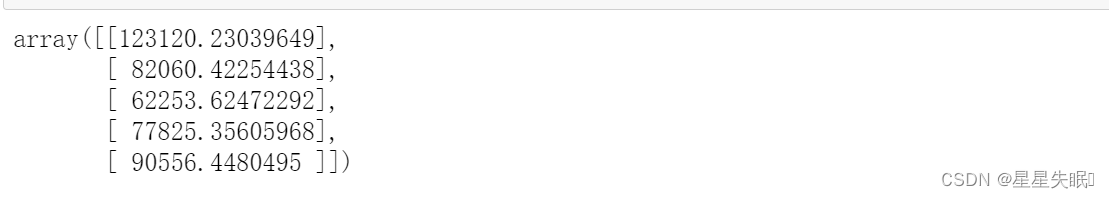

- y_pred = predict(xx_test, params)

- # 打印前五个预测值

- y_pred[:5]

-

相关阅读:

[附源码]SSM计算机毕业设计“拥抱爱心”公益网站管理系统JAVA

扩散模型 - Diffusion Model【李宏毅2023】学习笔记 数学原理篇

Maven常用命令与测试和打包项目

[论文评析]Density‑based weighting for imbalanced regression,Machine Learning,2021

Go 之 captcha 生成图像验证码

【操作系统】基础知识概述

abp(net core)+easyui+efcore实现仓储管理系统——供应商管理升级之上(六十三)

项目管理逻辑:日志\周报\月报, 一直要求写, 有用吗?

axios登录,登出接口的简单封装步骤详解!

寒冬之下终于进华为了

- 原文地址:https://blog.csdn.net/zn2021220822/article/details/133758851